Bert不完全手册9. 长文本建模 BigBird & Longformer & Reformer & Performer

- 2022 年 10 月 8 日

- 笔记

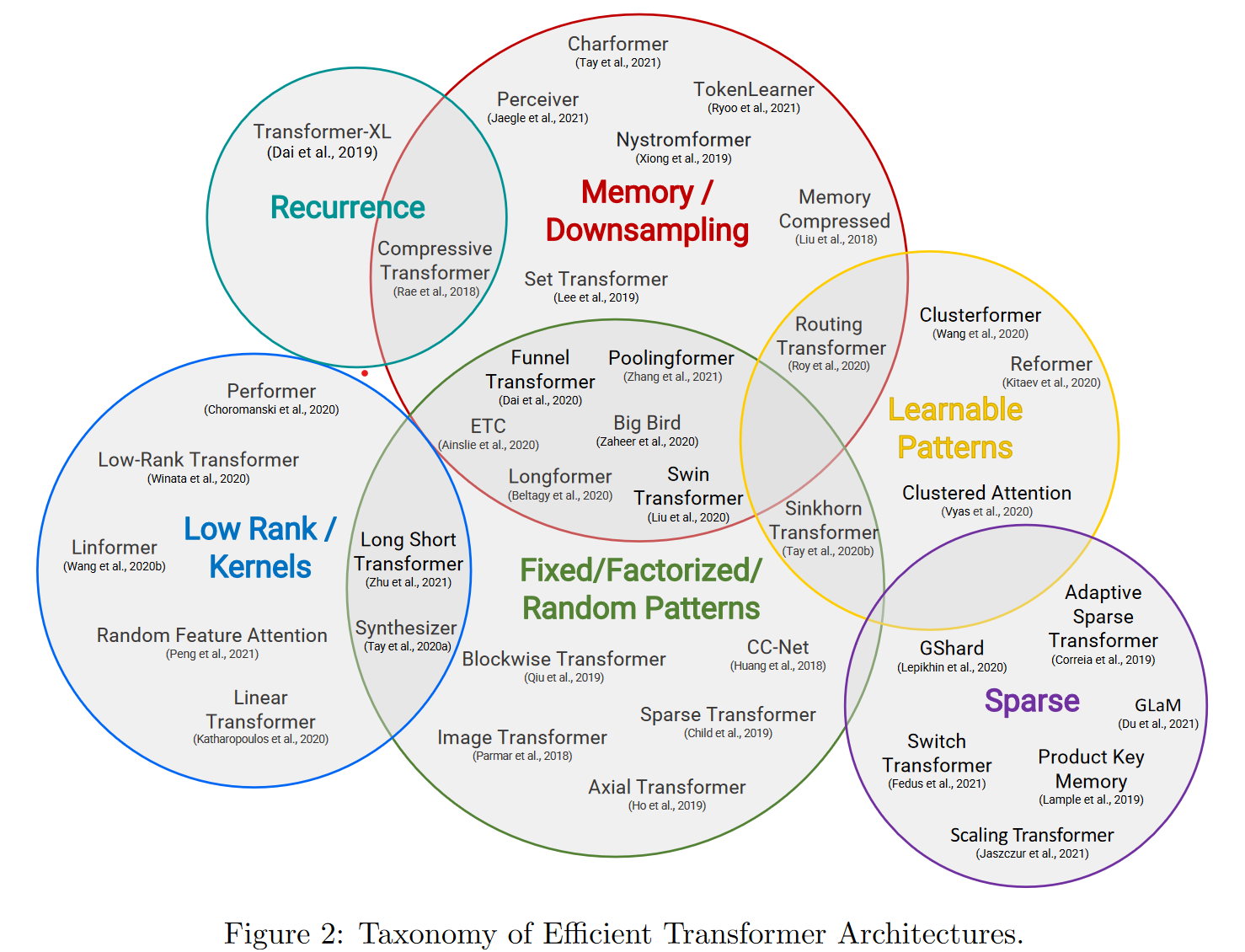

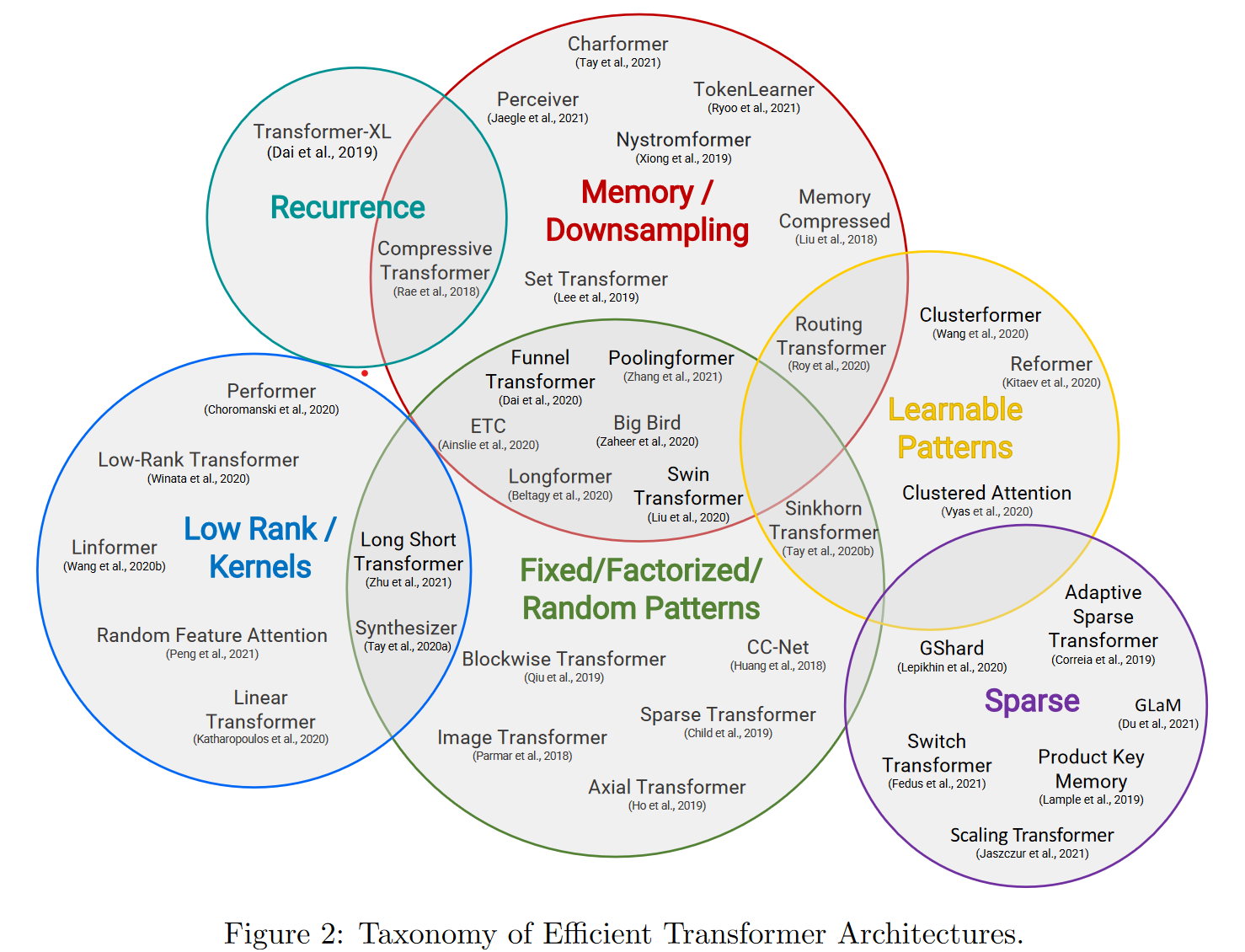

这一章我们来唠唠如何优化BERT对文本长度的限制。BERT使用的Transformer结构核心在于注意力机制强大的交互和 …

Continue Reading

这一章我们来唠唠如何优化BERT对文本长度的限制。BERT使用的Transformer结构核心在于注意力机制强大的交互和 …

Continue Reading

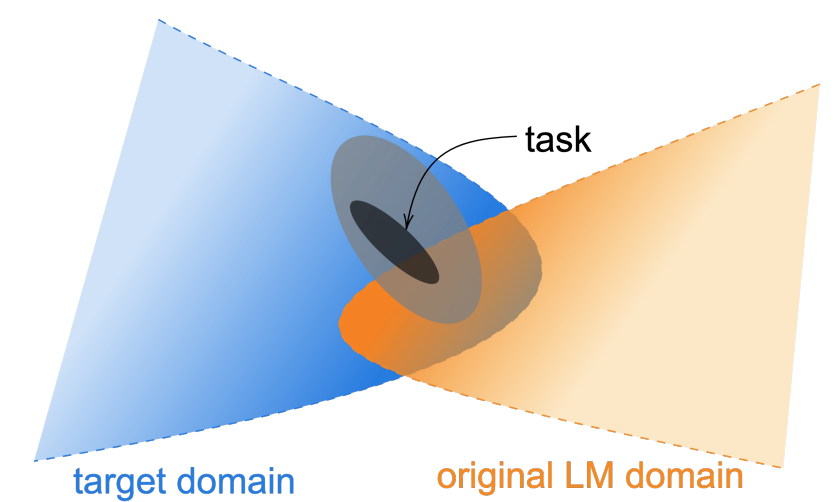

paper: Don’t stop Pretraining: Adapt Language Models t …

Continue Reading

借着ACL2022一篇知识增强Tutorial的东风,我们来聊聊如何在预训练模型中融入知识。Tutorial分别针对NL …

Continue Reading

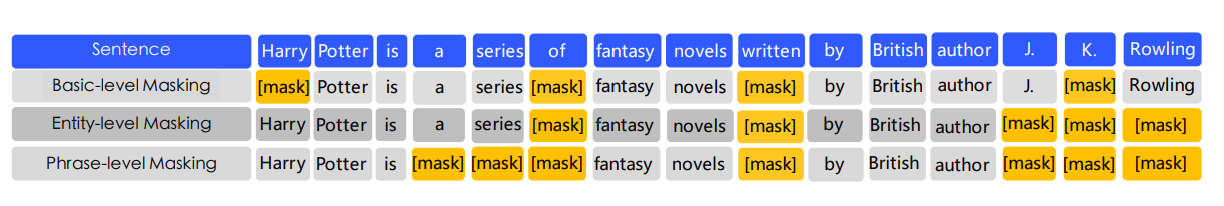

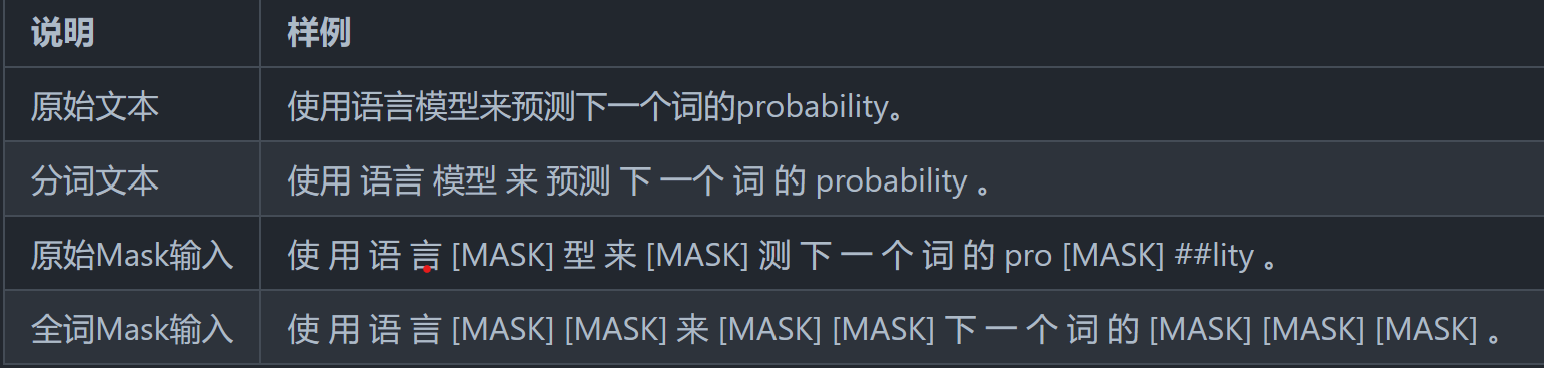

一章我们来聊聊在中文领域都有哪些预训练模型的改良方案。Bert-WWM,MacBert,ChineseBert主要从3个 …

Continue Reading

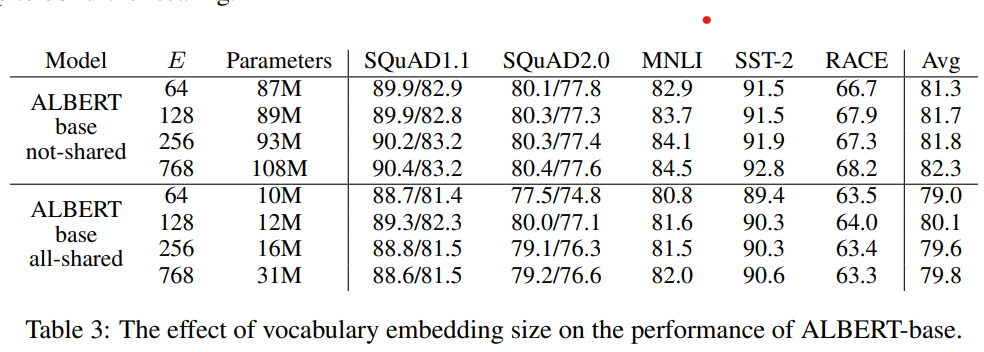

Albert是A Lite Bert的缩写,确实Albert通过词向量矩阵分解,以及transformer block的 …

Continue Reading

之前看过一条评论说Bert提出了很好的双向语言模型的预训练以及下游迁移的框架,但是它提出的各种训练方式槽点较多,或多或少 …

Continue Reading

Bert通过双向LM处理语言理解问题,GPT则通过单向LM解决生成问题,那如果既想拥有BERT的双向理解能力,又想做生成 …

Continue Reading

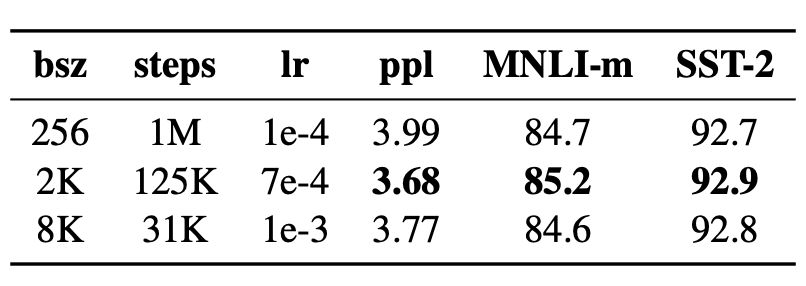

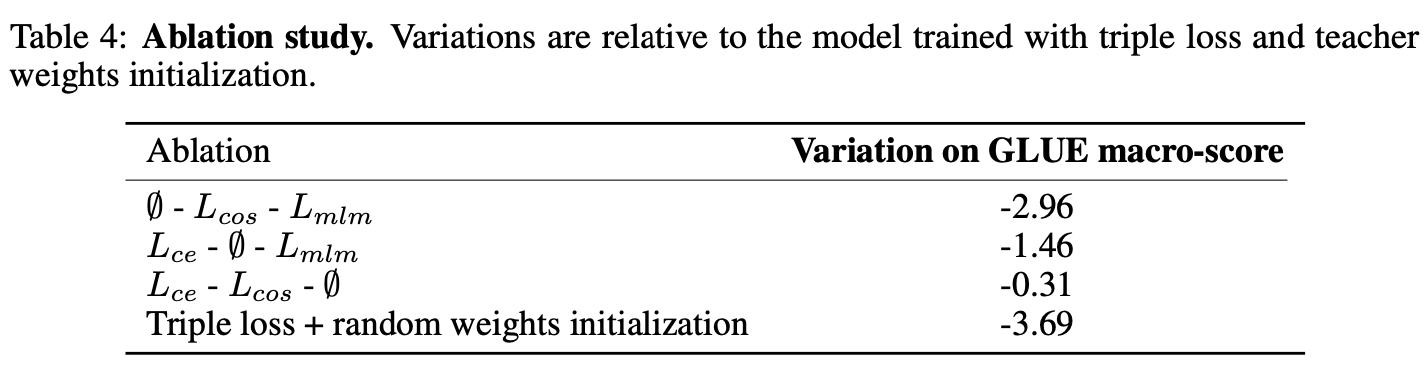

模型蒸馏的目标主要用于模型的线上部署,解决Bert太大,推理太慢的问题。因此用一个小模型去逼近大模型的效果,实现的方式一 …

Continue Reading

前言 上一章为大家介绍过深度学习的基础和多层感知机 MLP 的应用,本章开始将深入讲解卷积神经网络的实用场景。卷积神经网 …

Continue Reading

摘要:为了更深入理解千亿参数的盘古大模型,华为云社区采访到了华为云EI盘古团队高级研究员谢凌曦。谢博士以非常通俗的方式为 …

Continue Reading