论文阅读:Multi-task Learning for Multi-modal Emotion Recognition and Sentiment Analysis

- 2020 年 9 月 13 日

- 筆記

- Multi-Modal, Paper-Reading, 多模态

论文标题:Multi-task Learning for Multi-modal Emotion Recognition and Sentiment Analysis

论文链接://arxiv.org/abs/1905.05812

文章同时使用视觉、语音、和文本(语言)信息进行情感分析,通过增加视觉和语音信号,补足了一些无法通过文本来进行判断的情况,例如下图中,第一句话需要图像才能判断为负面情绪,第二句话同时语音和图像才能判断为负面情绪。

一、模型架构

模型整体思路

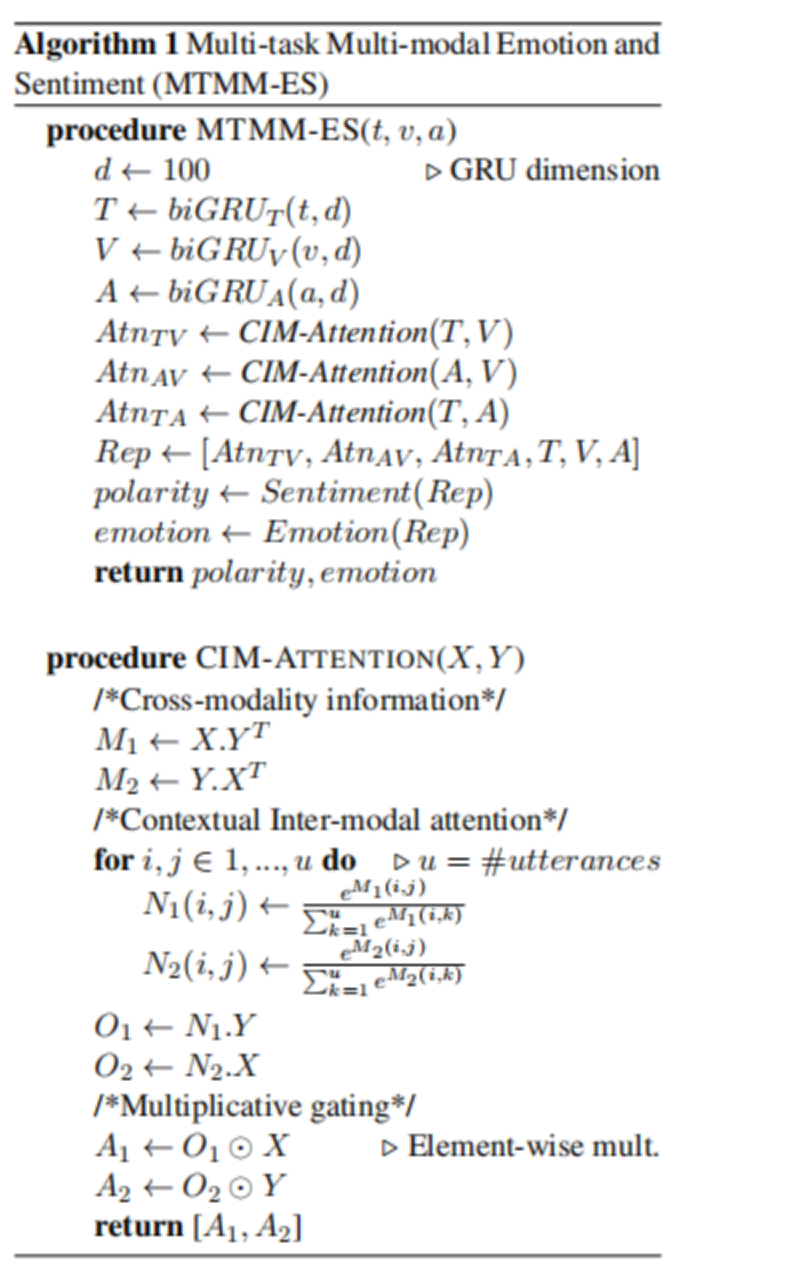

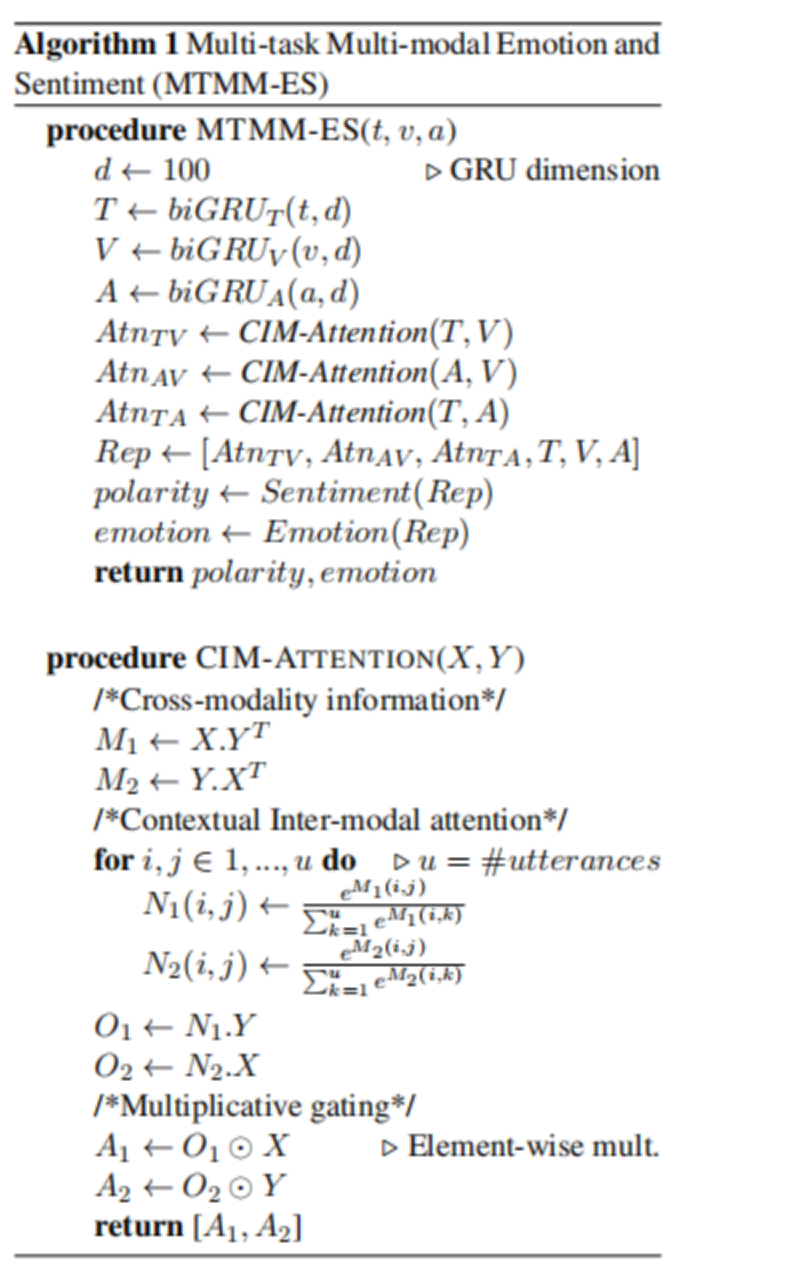

- 1.首先,每一个模态的信息都会通过一个bi-directional GRU ,双向GRU可以有效的表征单一模态内部的相互关系。

- 2.得到的表征 A V T 需要通过本文提出的CIM 注意力机制去获得俩俩模态之间的互注意力( AV , AT, VT ),通过这个步骤可以获取到对模型分类最重要的信息。

- 3.将获得的注意力和 单模态特征 A V T进行拼接,得到最终表征。

- 4.将表征链接最后的分类层,进行分类任务。

CIM注意力机制( Contextual Inter-modal (CIM) Attention

Framework )

本文主要的特色是提出了CIM注意力方法,来提取模态间的互注意力,筛选出关键的信息,思路如下:

- 1.通过两个表征矩阵互相乘积得到跨模态信息M1,M2(可以理解为,一个模态中,每一个维度的信息和另外一个模态的所有维度信息做点积操作,可以得到两个模态之间的关系表征,类似于通过外积进行模态融合的bilinear pooling 操作)

- 2.通过soft-attention得到注意力分布N1,N2,在通过与特征进行乘积得到最终的注意力表征信息O1和O2。 这里的N1[ i , j ] 表示的是第一个模态第 i 个特征 与 第二个模态 第 j 个特征相关性,值越大,说明这个特征跟另外一个特征的交互性越强,也就越重要,所以O1 和 O2 得到的就是对 互注意力 贡献最大的特征的维度信息

- 3.通过注意力表征O1,O2与特征相乘得到最终的注意力特征A1,A2,这里使用的是乘法过滤机制,用过注意力表征和特征相乘,得到最终的经过过滤的特征。

二、数据集 CMU-MOSEI

全称: CMU Multi-modal Opinion Sentiment and Emotion Intensity (CMU-MOSEI)

总共包含 3,229 个视频片段,总共有23,000个句子,来自于1,000 个 youtueb视频 。

其中Training Set:16216,Validation Set : 1835 Test Set : 4625

每个样本对应六个标签:anger, disgust, fear, happy, sad and surprise,具体统计如下图Table2 所示

文章中还测试了多标签分类任务,其中关于数据集多标签的统计入下图Table3 所示

三、结果

单模态下,语言模态效果最好,双模态下,语言+视觉 效果最好,总体而言三个模态效果最好,但是不明显。

多标签分类的效果整体上都领先于单标签分类

主要原因是多标签可以捕获更多的信息,来帮助模型进行判断

与已有模型对比也取得了很好的效果