物體的三維識別與6D位姿估計:PPF系列論文介紹(三)

- 2020 年 4 月 8 日

- 筆記

作者:仲夏夜之星Date:2020-04-08

文章“A Method for 6D Pose Estimation of Free-Form Rigid Objects Using Point Pair Features on Range Data” 2018年發表在《sensors》上,是近年來對PPF方法的進一步繼承與改進。

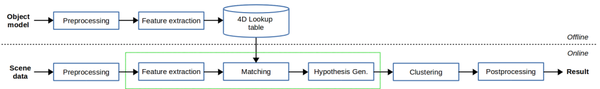

1.本文的思路

本文介紹的方法主要分為兩個階段即線下建模與線上匹配,在建模時,通過計算和保存所有可能的模型對及其相關的PPF來創建全局模型描述符。在匹配階段,通過使用PPF將場景對與存儲的模型對匹配來估計場景中的模型姿態。這一匹配過程由兩個不同的部分組成:(1)利用四維特徵找到對之間的對應關係;(2)將產生假設姿態的對應關係分組。

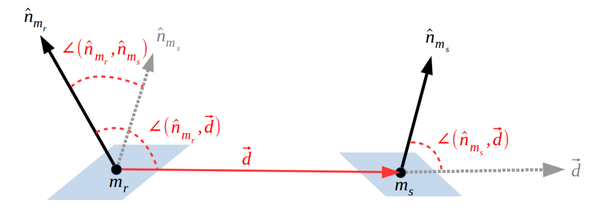

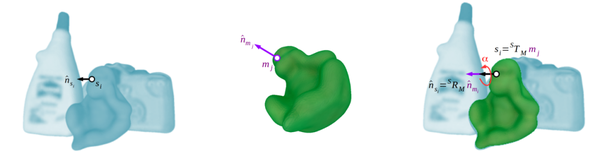

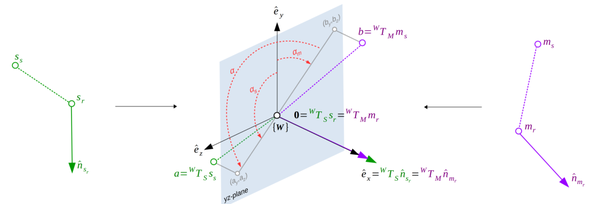

模型點對(mr,ms)定義的點對特徵

2.本文內容

(1)模型的前處理

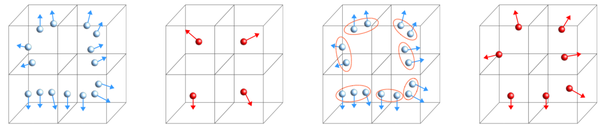

前處理包括法向估計和對點雲的下取樣。其中法向估計問題,本文建議使用兩個不同的變體來表示每個階段的輸入數據表示。對於離線階段,使用重構或cad網格數據,通過平均每個頂點周圍三角形的法線平面來估計法線。對於在線階段,利用有組織的點雲數據,本文提出了一種基於一階Taylor展開的方法,包括對錶面深度差高於給定閾值的情況下的雙邊濾波器啟發解決方案。而對點雲下取樣方面,本文是基於一種新的利用表面資訊的體素網格下取樣方法和一個額外的非識別對的平均步驟。首先計算點雲數據的體素網格結構,對於每個體素單元,採用貪婪聚類方法對具有相似正態資訊的點進行分組,即法線之間的角度小於閾值。然後,對於每個聚類組,我們平均定向點,有效地合併相似點,同時保持判別數據。與原始方法一樣,體素大小設置為,定義相對於模型大小的值,然而,在本文方法中,參數對演算法性能的影響顯著降低,轉向了一種更魯棒的參數無關方法。

(2)特徵提取

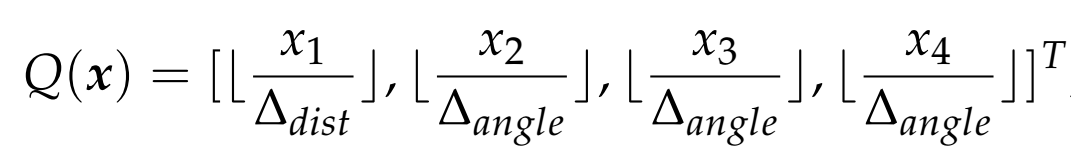

在離線階段,得到模型包圍盒,並將模型直徑估計為包圍盒的對角線長度,對於給定的ppf,使用方程(1)中定義的量化函數來獲得四維數組:

(1)

其中量化步驟設置為0.05dm,固定為,這些值被設置為識別率和速度之間的權衡。這樣,哈希表的尺寸得定義為,在預處理後,對於每個模型點對,得到量化的ppf索引,並將參考點和計算的保存到哈希表對應的單元格中。

在線階段,對於每個參考點,將計算所有可能的點對,並使用四維查找表與對象模型進行匹配,其中每五個點中只有一個(按輸入順序)將用作參考點,其餘點將用作第二點,為了提高匹配部分的效率並且避免考慮比模型直徑更遠的點對,對於每個場景參考點,我們建議使用一個有效的kd-tree結構來獲得模型直徑內的第二個點。

(3)線上匹配

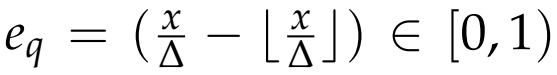

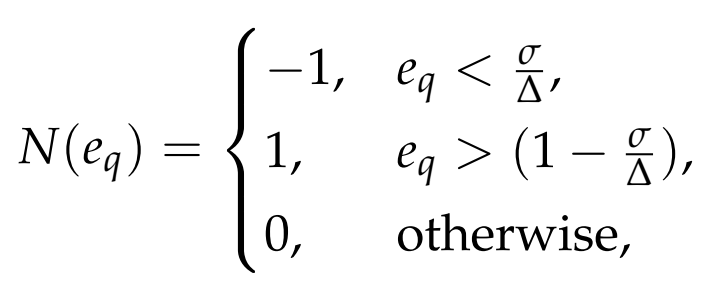

本文提出了一個更有效的解決方案,只檢查保持量化步驟大小的16個鄰域中最大一個,如圖7d所示。考慮到相似點對之間的差異主要是由感測器雜訊產生的,可以合理地假設這種雜訊遵循一個正態分布,其特徵是一個相對較小的標準差,即小於量化步驟,基於這一假設,我們檢查量化誤差方程

,以確定哪些鄰域更有可能受到雜訊的影響。這個過程是由方程(2)中表示的分段函數為每個維度定義的:

(2)

其中-1表示左鄰域可能受到影響,1表示右鄰域可能受到影響,0表示沒有鄰域可能受到影響。

在實驗中,我們將標準差值設置為量化步驟;然而,對於任何特定的雜訊模型,都可以使用其他值,該方法可以訪問單個哈希表單元格的最佳情況和訪問16個單元格的最壞情況。

(4)位姿假設

在假設生成過程中,所有一致的點對應被分組在一起,生成一個候選姿態。詳細地說,對於每個獲得的場景模型點對,在二維投票表中投票一個LC組合。這樣,哈希表的每個位置都表示一個LC,定義了場景中的模型姿態候選,其值表示支援的數量,這表明姿態的可能性有多大。通過一個總大小為

的投票表定義的來量化LCα,在所有投票被投完後,哈希表的最高值表示最可能的LC,為這個場景參考點定義一個候選姿態。該文定義一個閾值,只考慮具有最小支援數的LC,如果哈希表的峰值低於這個數字,則姿態將被丟棄;否則,將生成具有相關分數的候選姿態。

(5)位姿聚類

為了將相似的姿態組合在一起,我們提出了一種分層完全鏈接聚類方法。這種聚類方法強制要求每個聚類的所有元素組合基於兩個主要閾值,即距離和旋轉,在實驗中,我們根據候選位姿的投票決定對位姿進行排序,並為每個位姿創建一個集群。然後,按順序檢查所有集群,當條件保持其元素的所有組合時,兩個集群被連接在一起。這樣,最有可能的集群將首先合併,減少相互排斥組合的影響。

(6)後處理

由於攝像機視圖自遮擋在場景中的模型點產生的偏差和對象模型相對於場景的可能對齊誤差,我們將上述位姿通過ICP演算法進一步進行細化匹配,得到最優位姿。

3.實驗結果

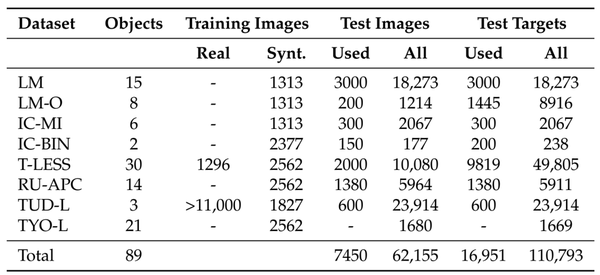

(1)BOP基準數據集

(2)不同方法之間的性能比較

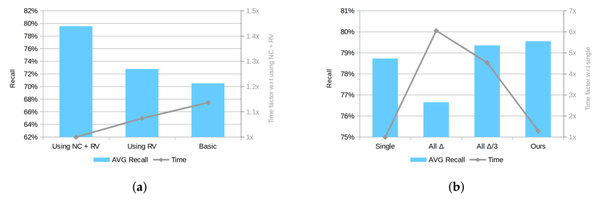

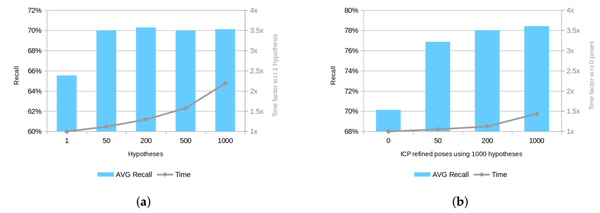

(3)使用不同的後處理參數進行性能比較

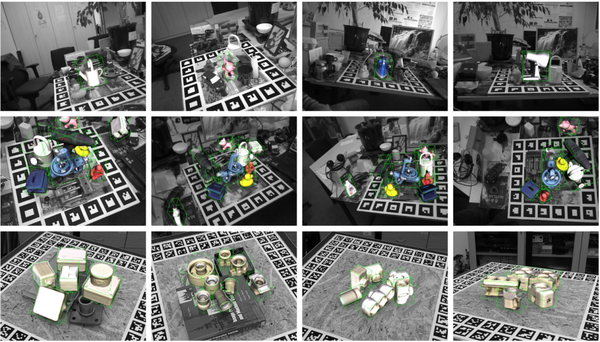

(4)所提出的方法對BOP基準數據集的場景的影響。場景RGB數據以灰色顯示, 對象模型以顏色和綠色包圍框內顯示。

4.參考文獻

[1] Drost, B.; Ulrich, M.; Navab, N.; Ilic, S. Model globally, match locally: Efficient and robust 3D object recognition. In Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, San Francisco, CA, USA, 13–18 June 2010; pp. 998–1005.[2] Vidal, J.; Lin, C.; Martí, R. 6D pose estimation using an improved method based on point pair features.In Proceedings of the 2018 4th International Conference on Control, Automation and Robotics (ICCAR),Auckland, New Zealand, 20–23 April 2018; pp. 405–409.