剖析虛幻渲染體系(17)- 實時光線追蹤

- 17.1 本篇概述

- 17.2 光線追蹤基礎

- 17.3 光線追蹤技術

- 17.4 圖形API和GPU

- 17.5 UE光線追蹤

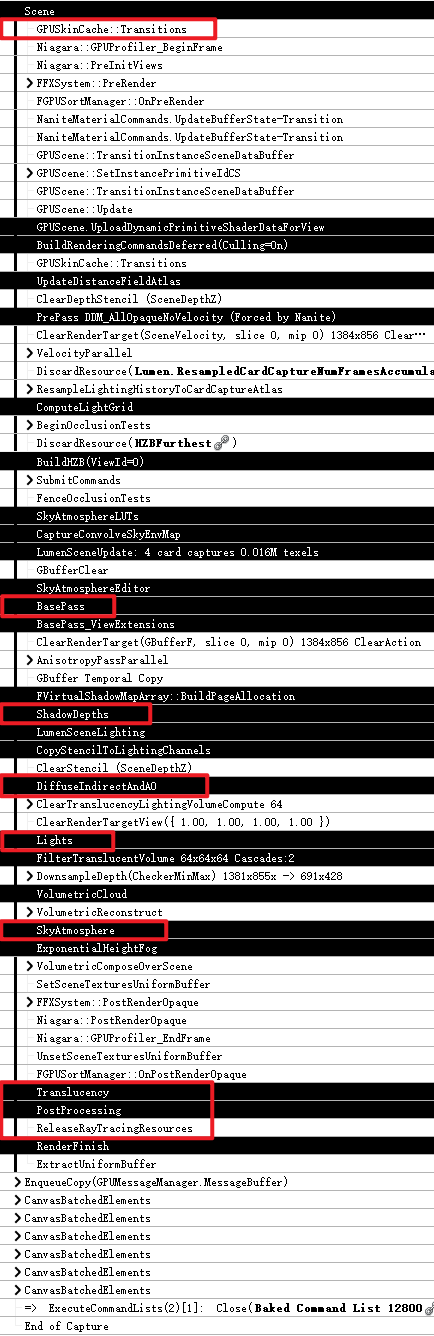

- 17.6 UE光線追蹤源碼分析

- 17.7 本篇總結

- 特別說明

- 參考文獻

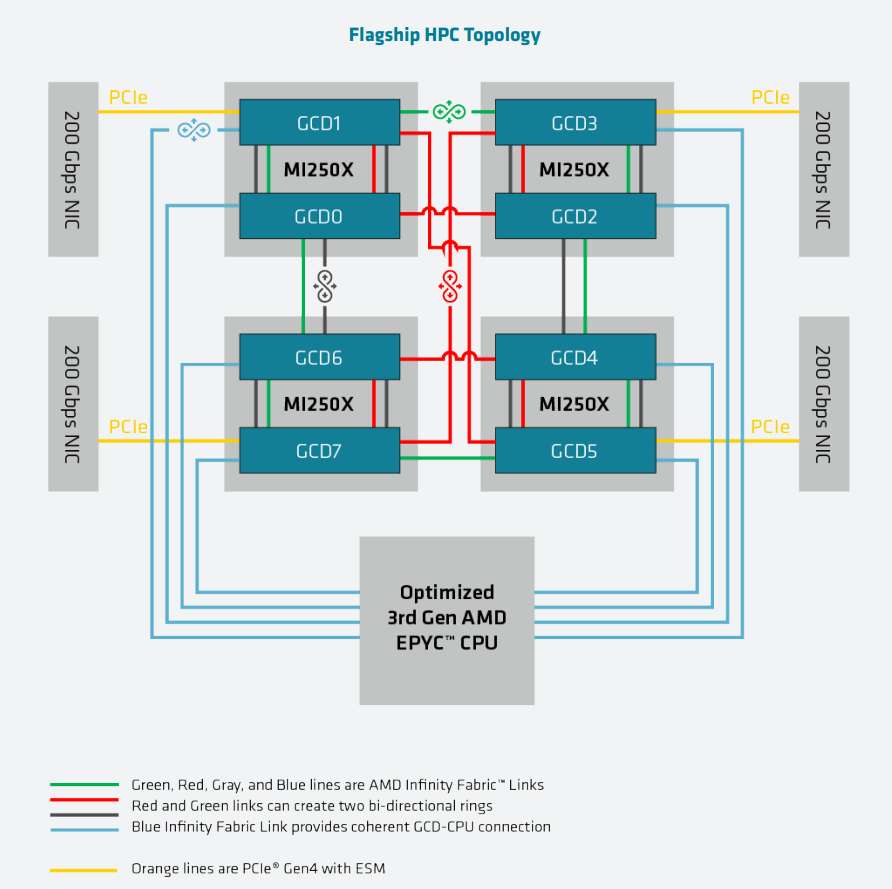

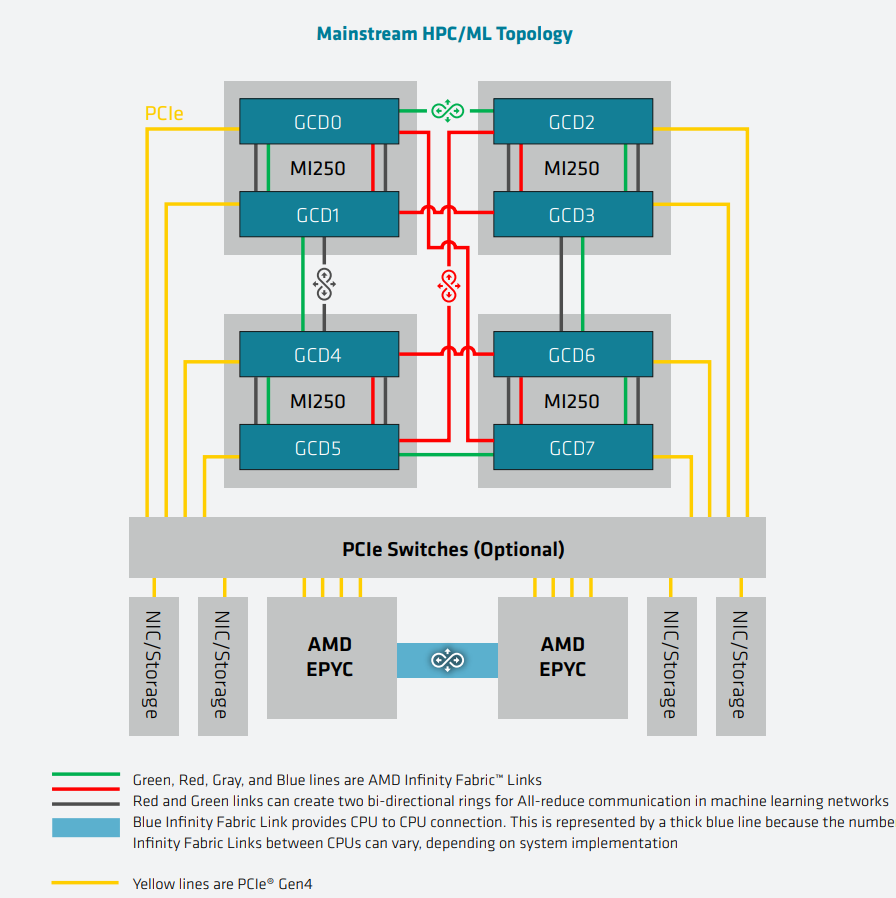

17.1 本篇概述

17.1.1 本篇內容

UE的光線追蹤一直是童鞋們呼籲比較高的一篇,雖然多年前部落客已經在探究光線追蹤技術及UE4的實現闡述過,但內容較基礎和片面。那麼,此篇就針對UE的實時光線追蹤進行更加系統、全面、深入地分析。本篇主要闡述UE的以下內容:

- 光線追蹤的基本概念、技術。

- 光線追蹤的實現方案。

- 光線追蹤的優化、降噪技術。

- 光線追蹤涉及的圖形API、GPU結構。

- 光線追蹤的UE實現。

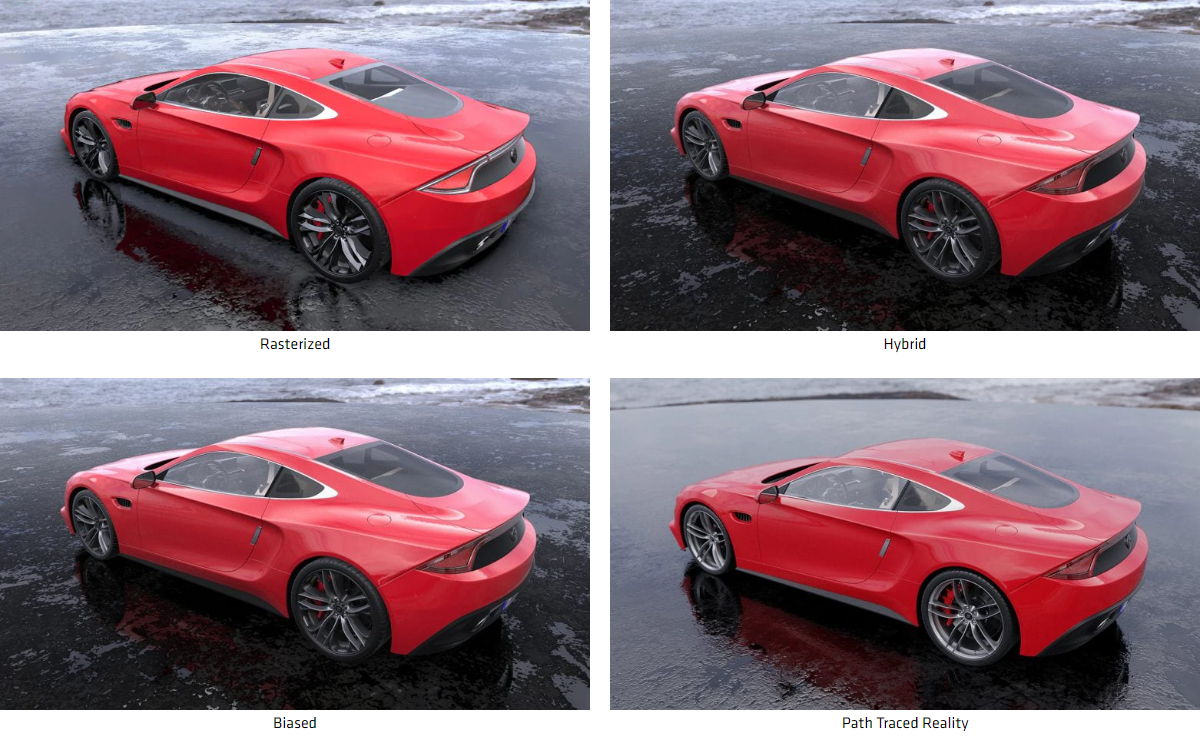

與傳統的掃描線或光柵化渲染方式不同,光線追蹤(Ray tracing)是三維電腦圖形學中的特殊渲染演算法,追蹤從攝像機發出的光線而不是光源發出的光線,通過這樣一項技術生成編排好的場景的數學模型顯現出來。

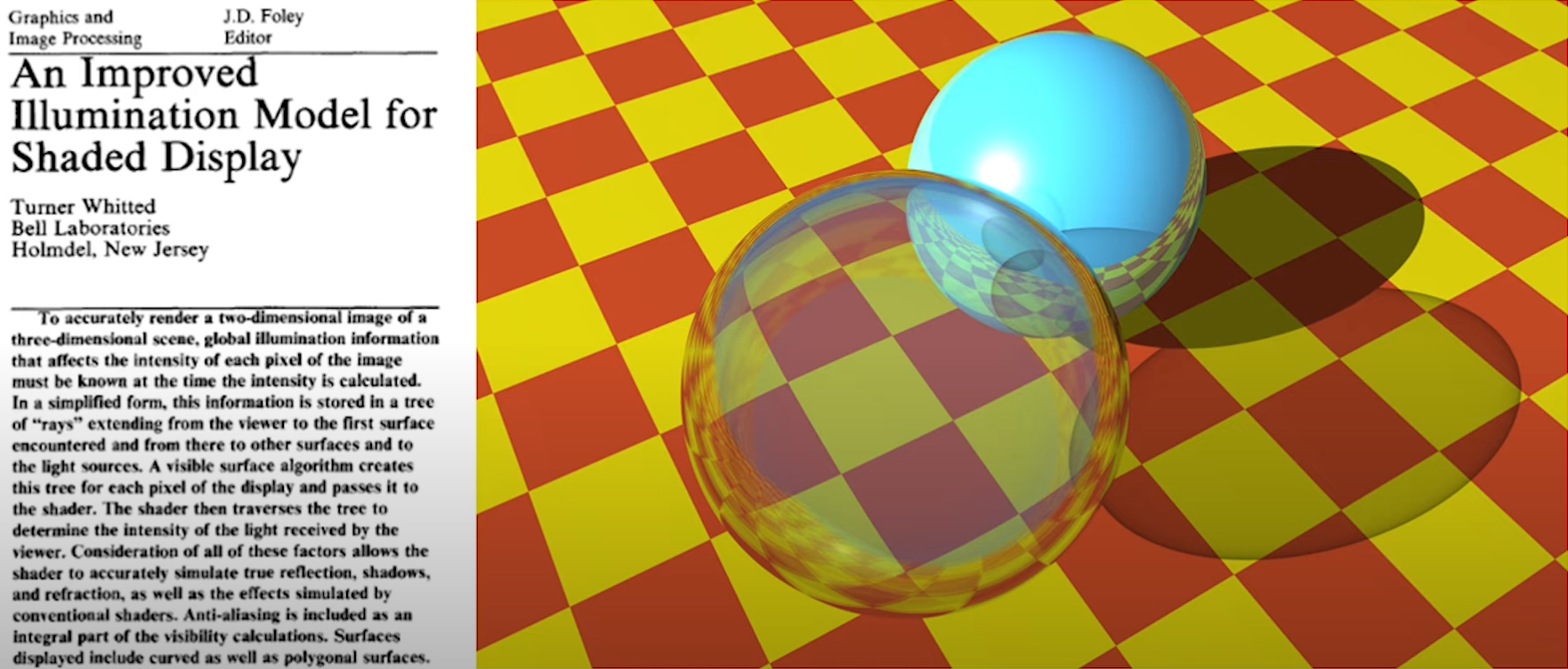

利用光線追蹤技術渲染出的照片級畫面。

與傳統方法的掃描線技術相比,這種方法有更好的光學效果,例如對於反射與折射有更準確的模擬效果,並且效率非常高,所以當追求高品質的效果時經常使用這種方法。

在物理學中,光線追跡可以用來計算光束在介質中傳播的情況。在介質中傳播時,光束可能會被介質吸收,改變傳播方向或者射出介質表面等。我們通過計算理想化的窄光束(光線)通過介質中的情形來解決這種複雜的情況。

在實際應用中,可以將各種電磁波或者微小粒子看成理想化的窄波束(即光線),基於這種假設,人們利用光線追跡來計算光線在介質中傳播的情況。光線追跡方法首先計算一條光線在被介質吸收,或者改變方向前,光線在介質中傳播的距離,方向以及到達的新位置,然後從這個新的位置產生出一條新的光線,使用同樣的處理方法,最終計算出一個完整的光線在介質中傳播的路徑。

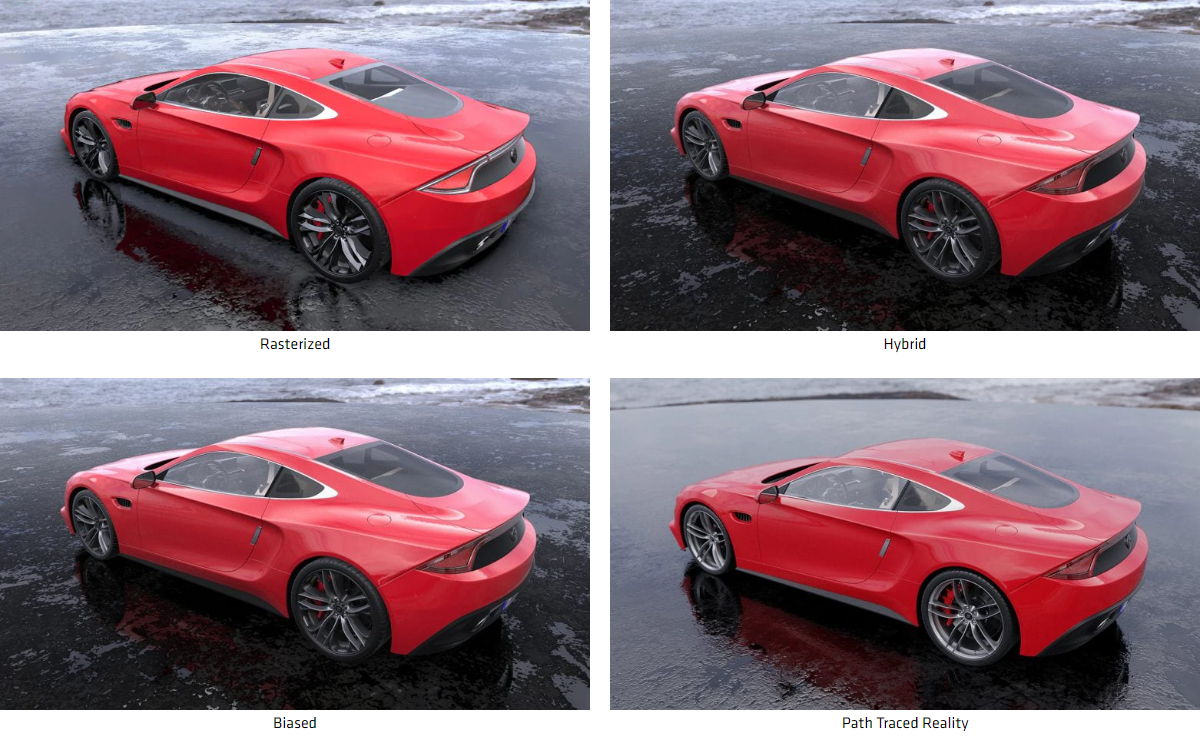

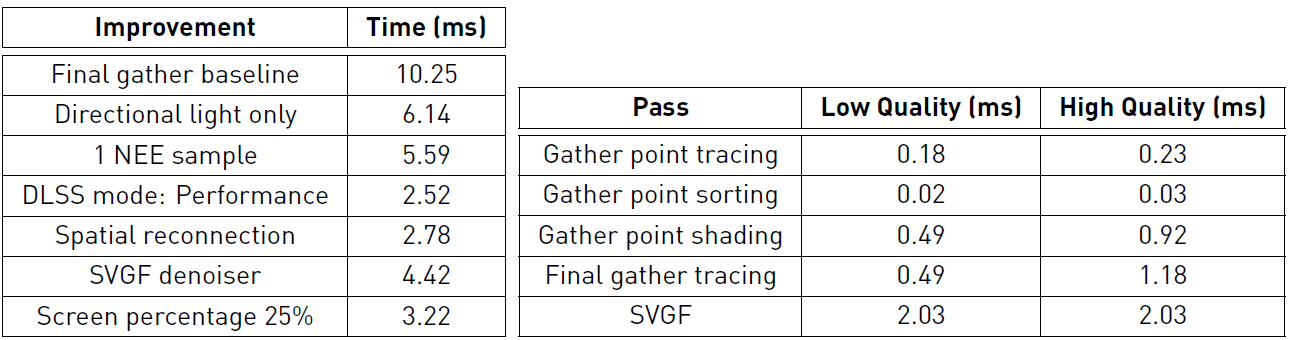

17.1.2 光線追蹤和光柵化

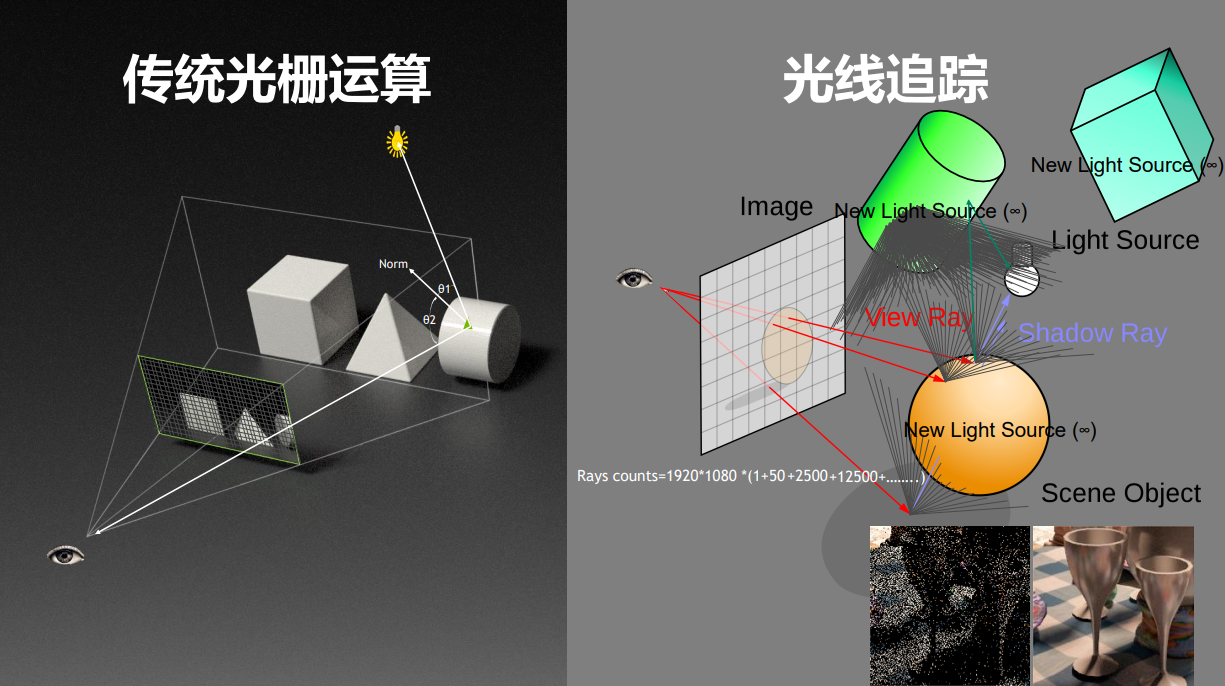

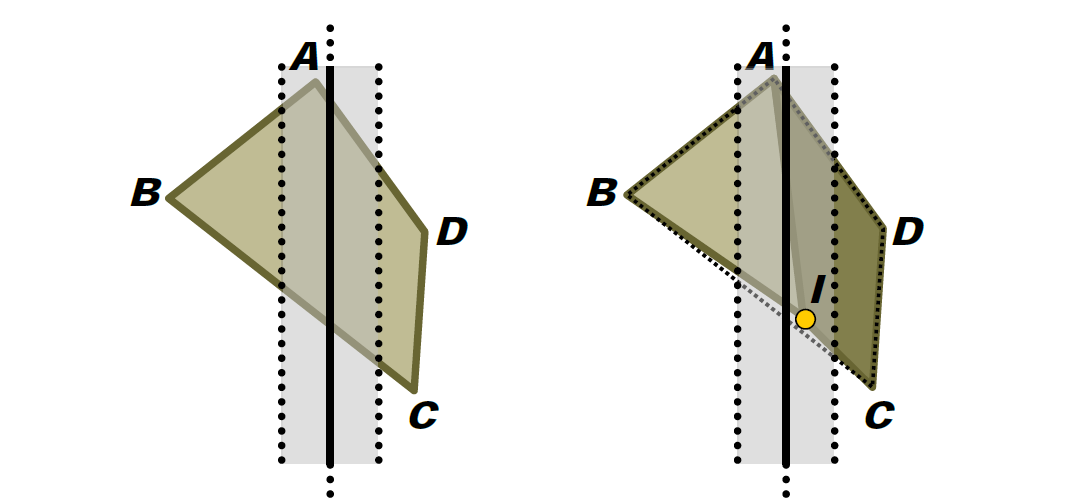

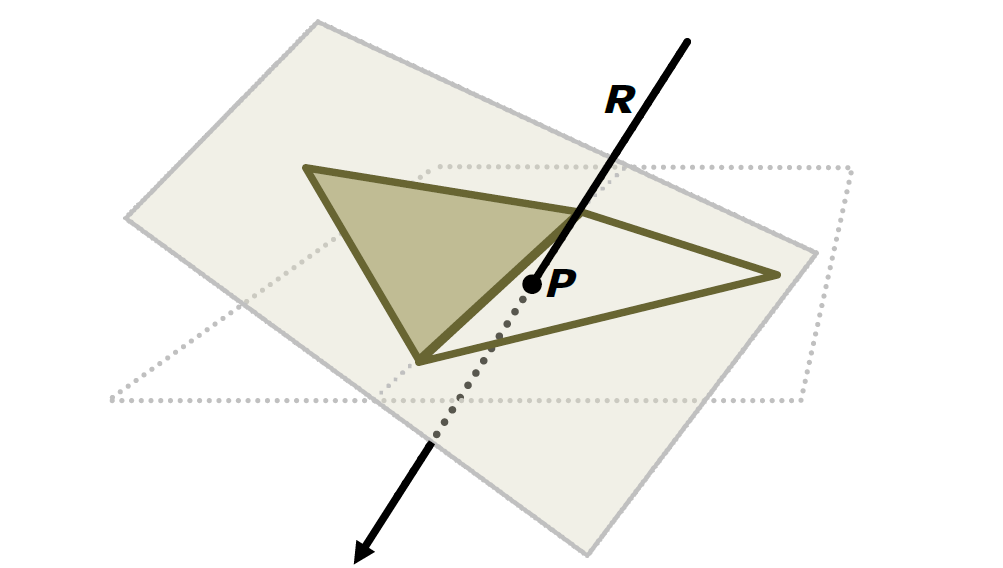

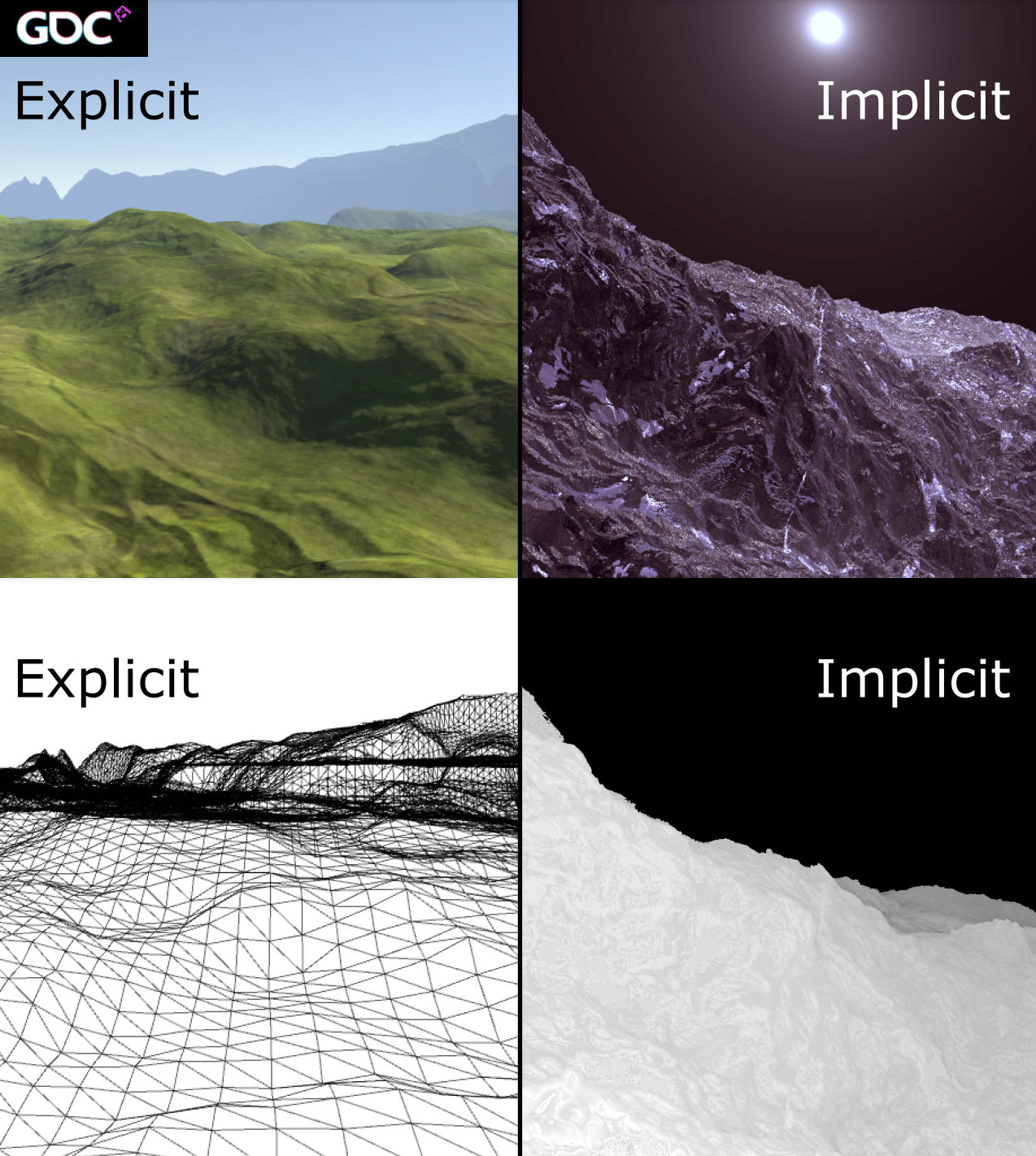

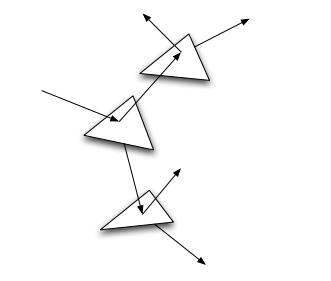

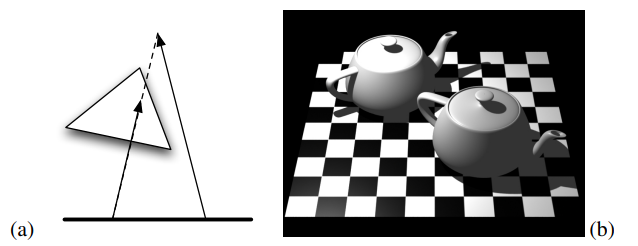

光柵化渲染管線(Raster pipeline)是傳統的渲染管線流程,是以一個三角形為單元,將三角形變成像素的過程(下圖左),在目前影像API和顯示卡硬體有著廣泛的支援和應用。

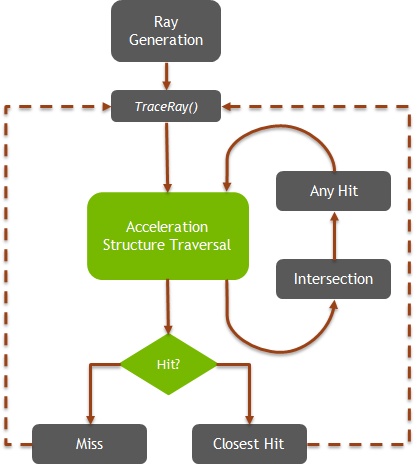

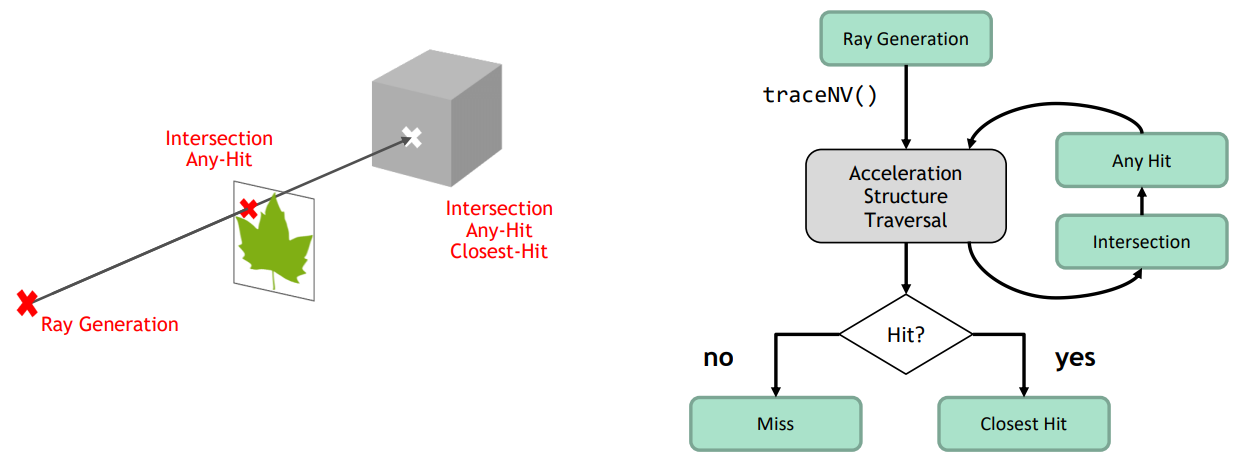

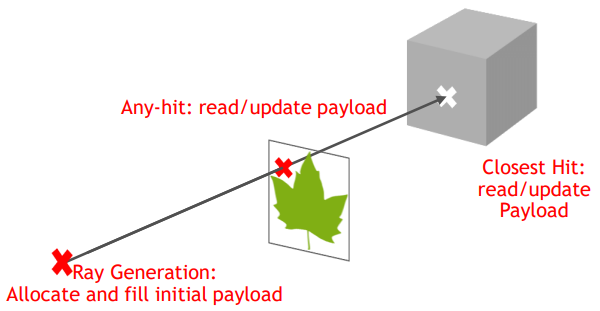

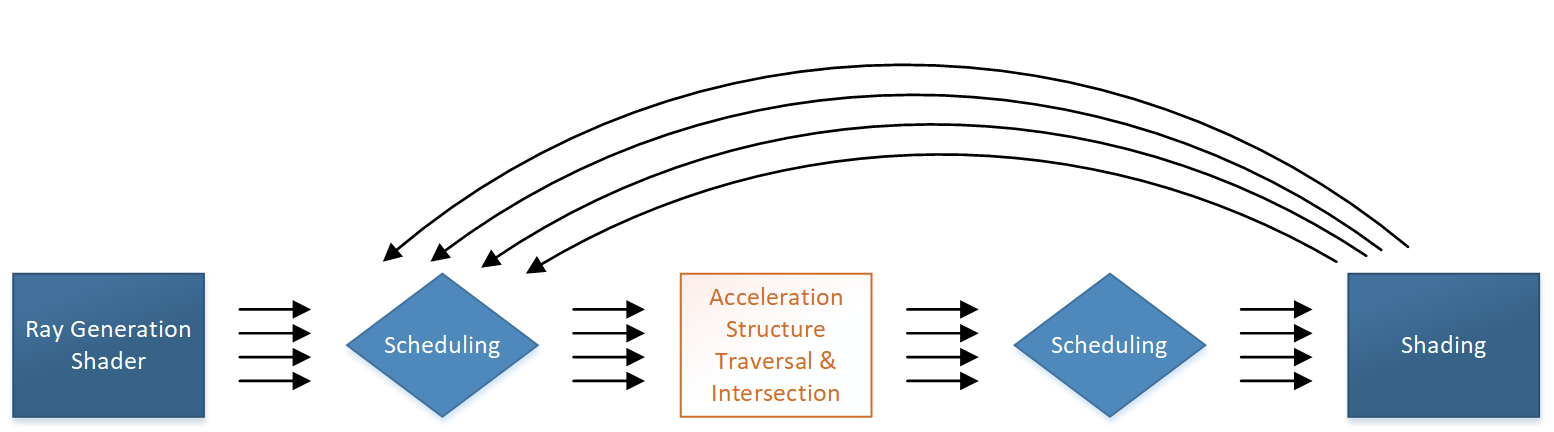

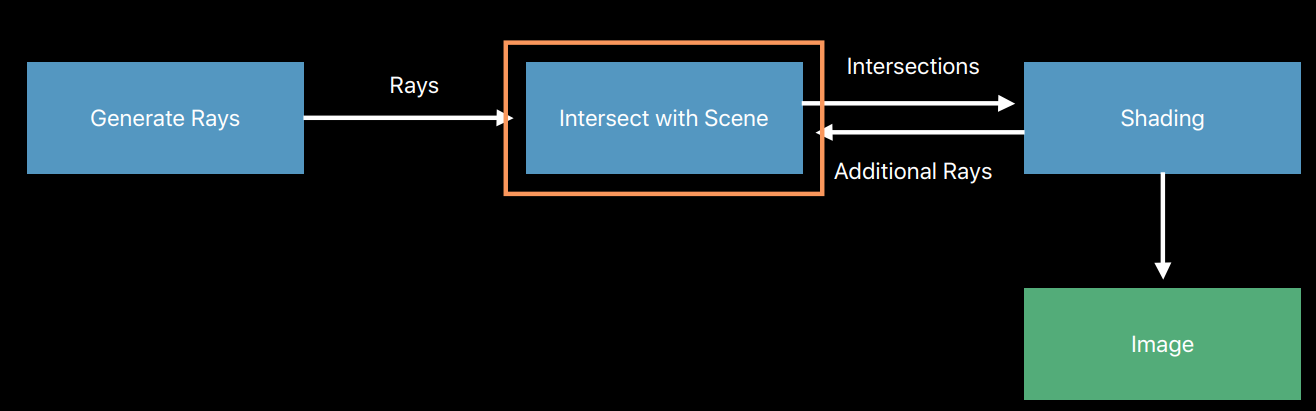

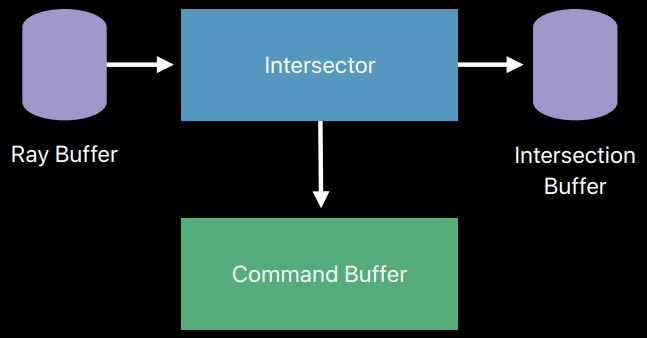

光線追蹤渲染管線(Ray tracing pipeline)則是以一根光線為單元,描述光線與物體的求交和求交後計算的過程(下圖右)。和光柵化線性管線不同的是,光線追蹤的管線是可以通過遞歸調用來衍生出另一根光線,並且執行另一個管線實例。

更詳細的對比表:

| 關鍵概念 | 光柵化 | 光線追蹤 |

|---|---|---|

| 基本問題 | 幾何體覆蓋了哪些像素? | 什麼物體對光線可見? |

| 關鍵操作 | 測試像素是否在三角形內 | 光線-三角形相交測試 |

| 如何流化工作 | 流化三角形(每個測試像素) | 流化光線(每條測試交點) |

| 低效率 | 每個像素對多個三角形著色(過繪製) | 每條光線對多個三角形相交測試 |

| 加速結構 | (層級)Z-Buffering | 層次包圍盒(BVH) |

| 劣勢 | 非一致性查詢難以實現 | 遍歷記憶體非常不一致 |

17.1.3 光線追蹤簡史

光線追蹤渲染技術從自然界中的光線簡化、光線投射演算法、光線追蹤演算法等一步步演變而來。

-

光線投射演算法(1968年)

由Arthur Appel提出用於渲染的光線投射演算法。光線投射的基礎就是從眼睛投射光線到物體上的每個點,查找阻擋光線的最近物體,也就是將影像當作一個屏風,每個點就是屏風上的一個正方形。

根據材質的特性以及場景中的光線效果,這個演算法可以確定物體的濃淡效果。其中一個簡單假設就是如果表面面向光線,那麼這個表面就會被照亮而不會處於陰影中。

光線投射超出掃描線渲染的一個重要優點是它能夠很容易地處理非平面的表面以及實體,如圓錐和球體等。如果一個數學表面與光線相交,那麼就可以用光線投射進行渲染。複雜的物體可以用實體造型技術構建,並且可以很容易地進行渲染。

-

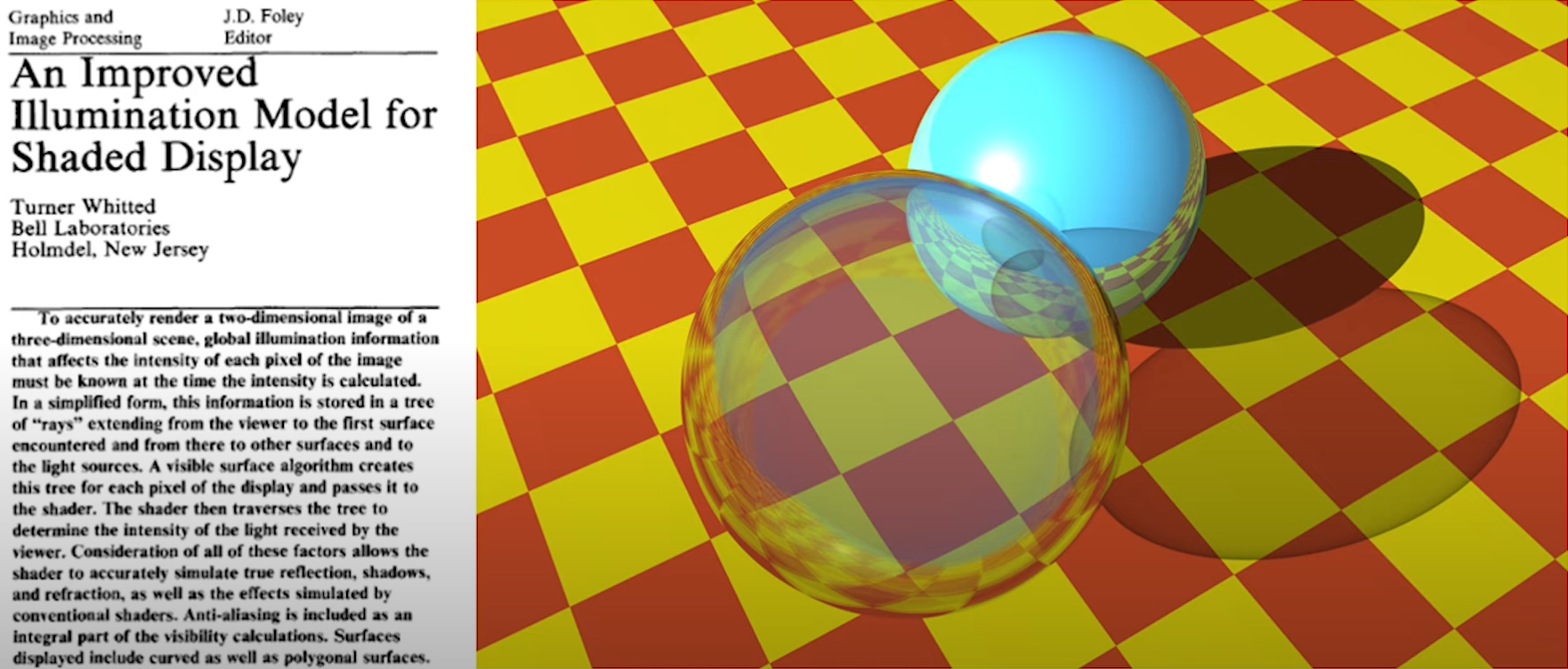

經典光線追蹤演算法(1980年)

最先由Turner Whitted於 1979 年做出的突破性嘗試。以前的演算法從眼睛到場景投射光線,但是並不追蹤這些光線。而光線追蹤演算法則追蹤這些光線,並且每次與物體表面相交時,計算一次所有光源的貢獻量。

-

Cook隨機(分布)光線追蹤(1984年)

允許陰影光線到達區域燈光上的隨機點,允許鏡面光線在理想反射周圍受到鏡面擾動,在幀中的某個時間捕捉運動模糊。

-

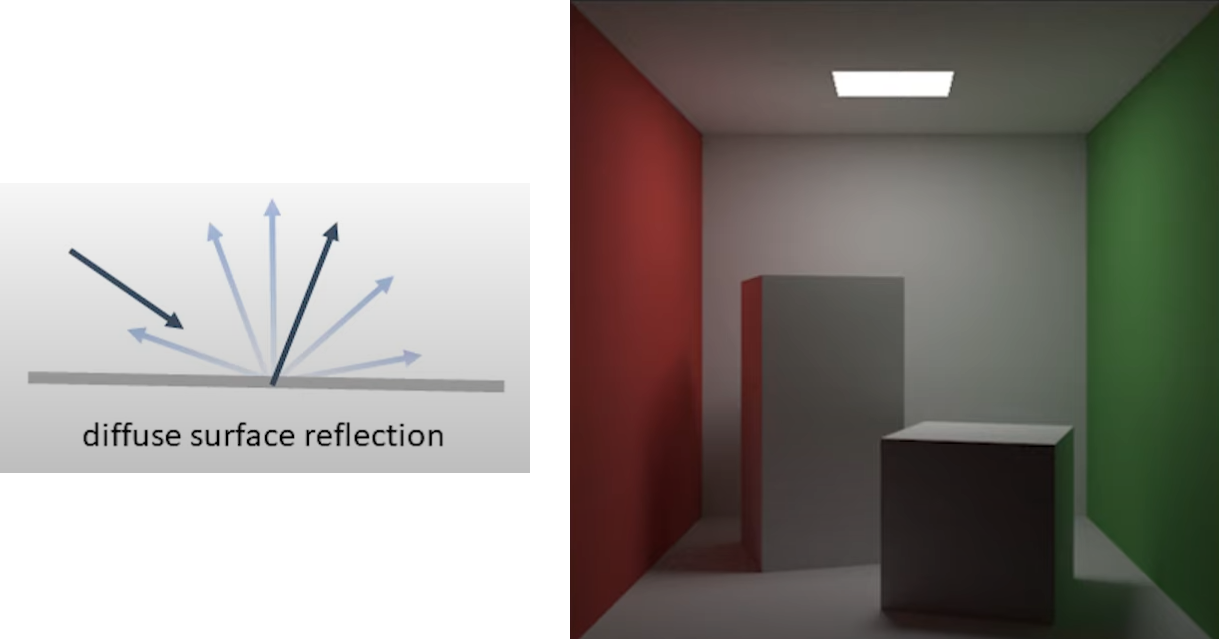

Kajiya風格漫反射互反射(1986年)

路徑追蹤:拍攝每條光線並沿一系列互反射進行追蹤,提出渲染方程,保證在極限下給出正確答案。

-

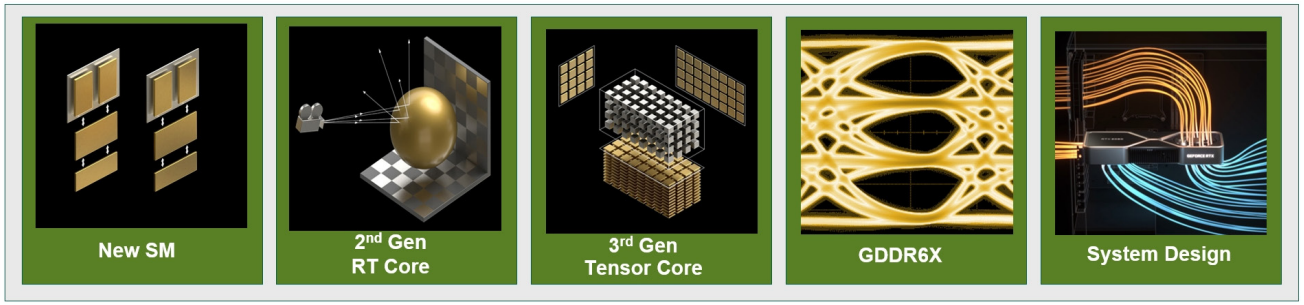

光線追蹤API及硬體集成(2018年)

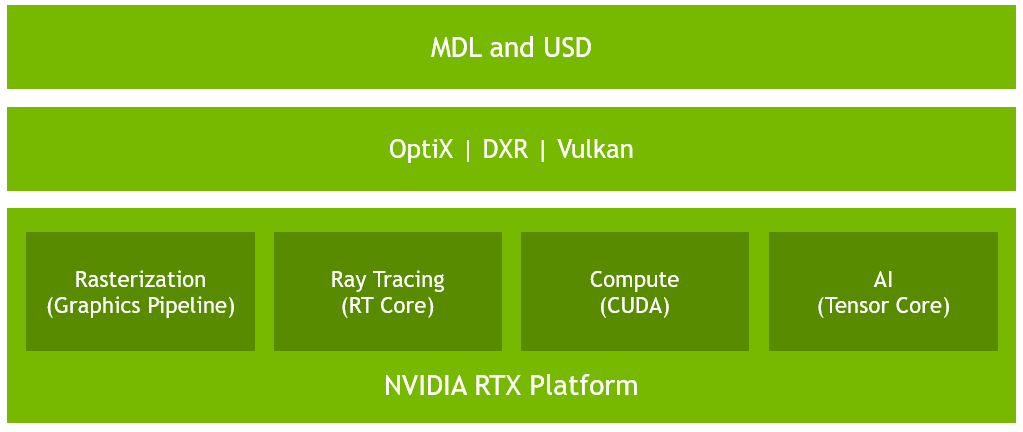

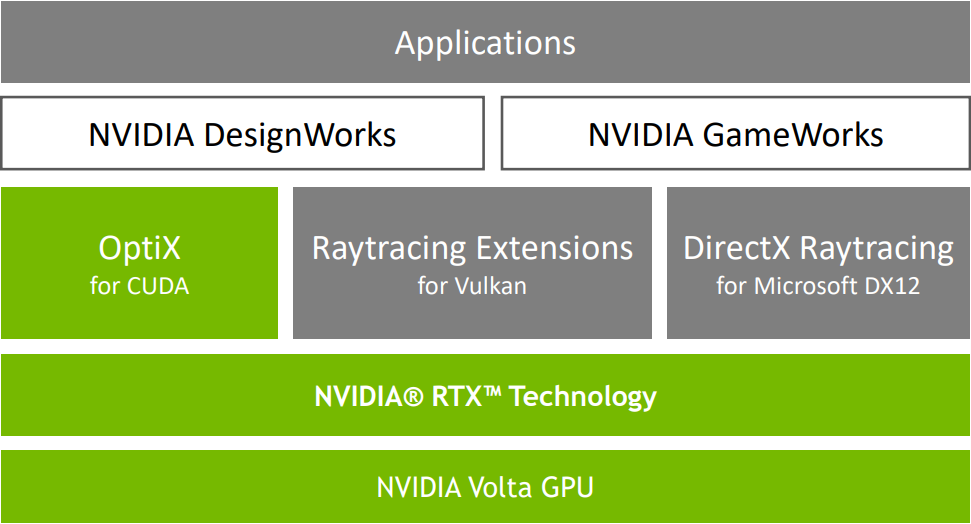

在早些年,NV就聯合Microsoft共同打造基於硬體的新一代光線追蹤渲染API及硬體。在2018年,他們共同發布了RTX(Ray tracing X)標準。Direct X 12支援了RTX,而NV的RTX系列顯示卡支援了RTX技術,從而宣告光線追蹤實時化的到來。

NV RTX演示影片截圖。

-

UE4集成光線追蹤(2019年)

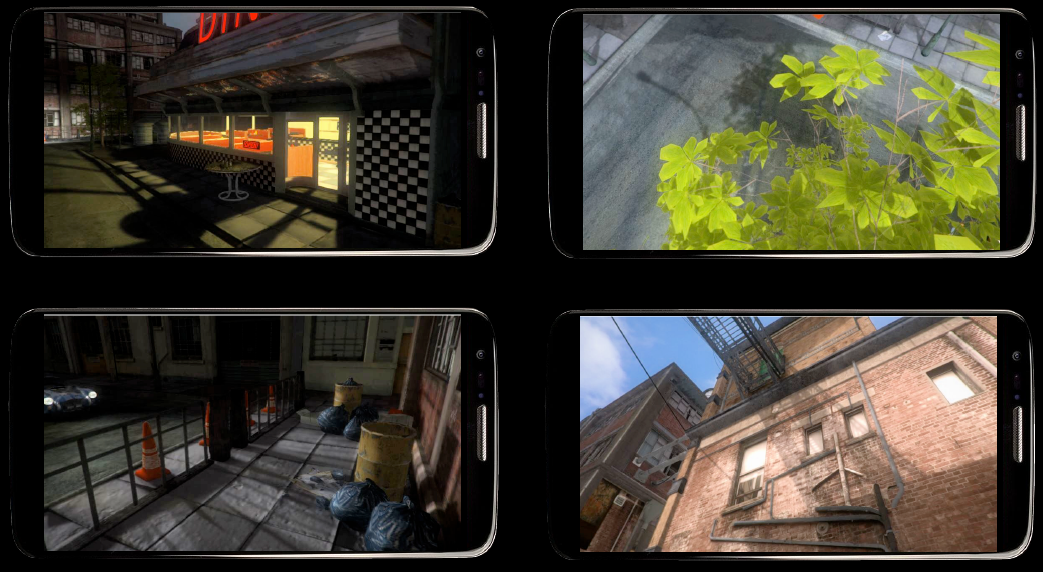

UE於2019年4月發布了4.22版本,該版本最耀眼的新特性無疑是支援了光線追蹤技術,將助力廣大啟用UE的個人或團隊更加有效地渲染出照片級的畫面。

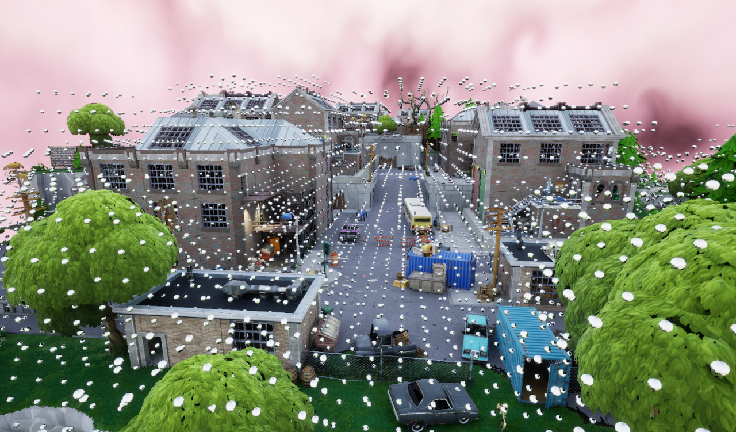

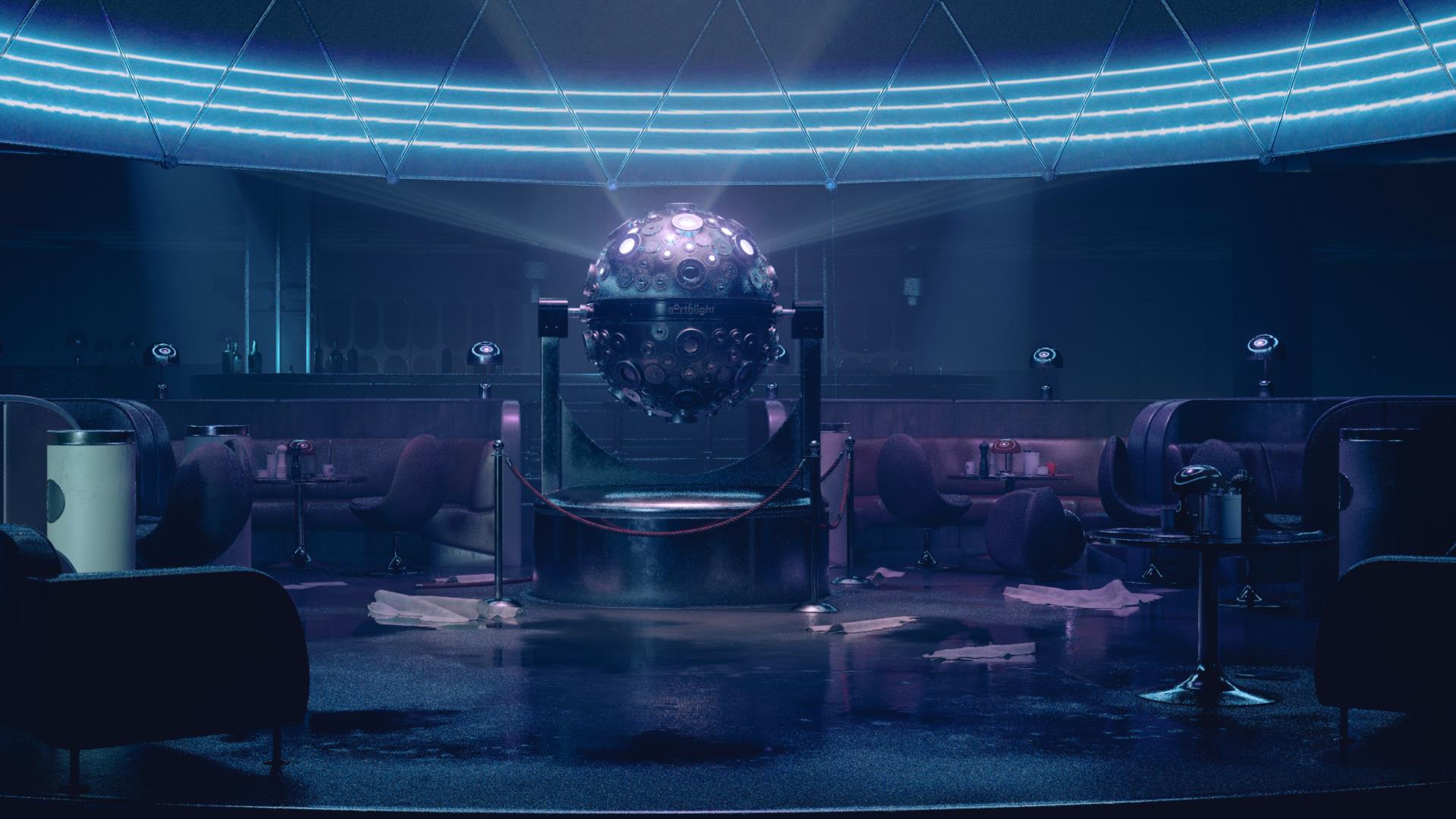

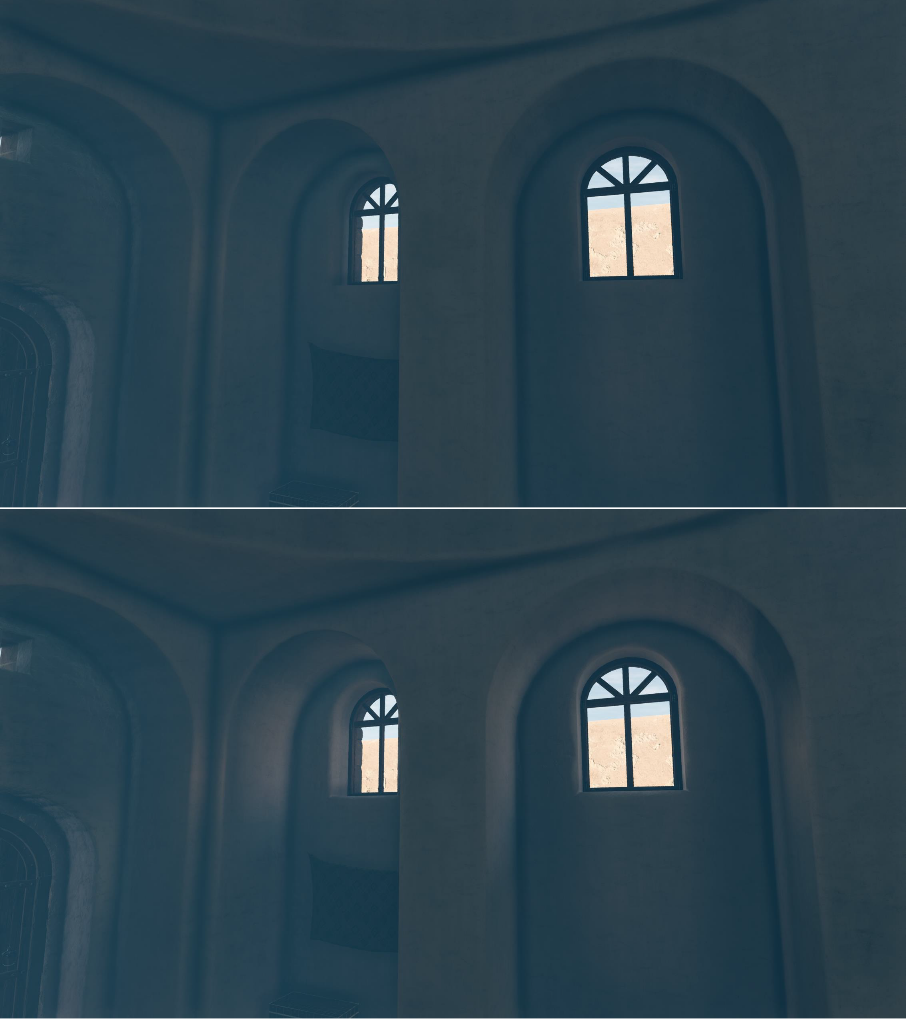

利用UE的光線追蹤技術渲染出的逼真畫面。

- UE5 Lumen集成硬體光線追蹤(2021年)

UE5的核心技術之一便是Lumen,實現了實時可信的全局光照效果,它支援軟體光線追蹤和硬體光線追蹤兩種模式。

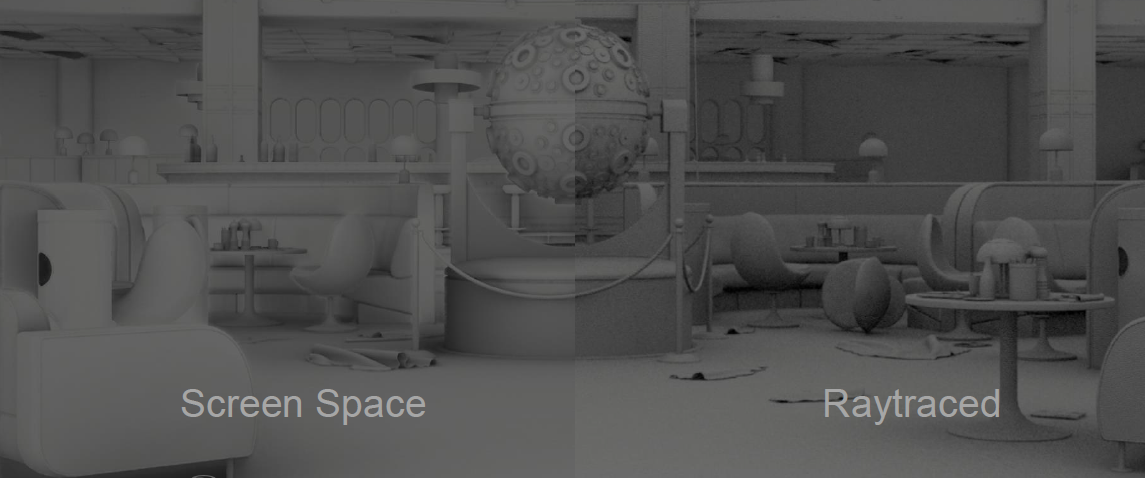

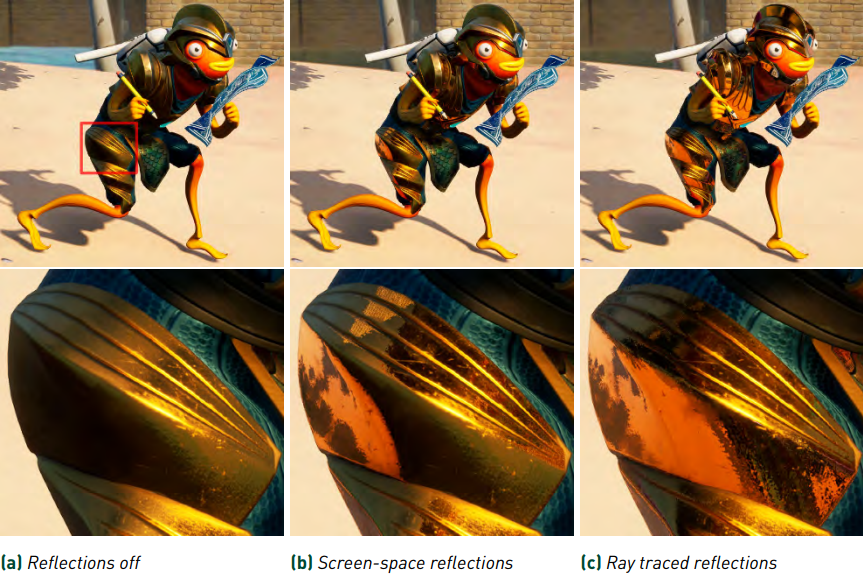

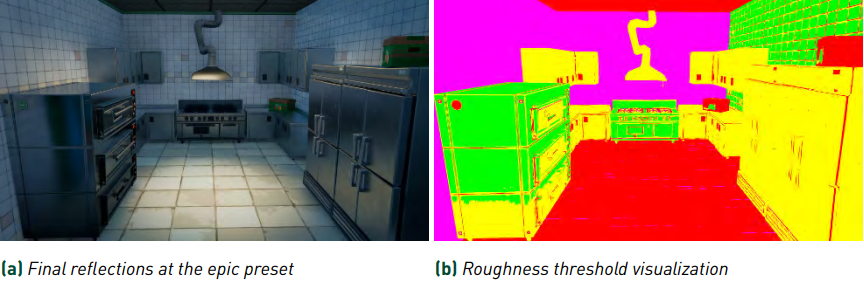

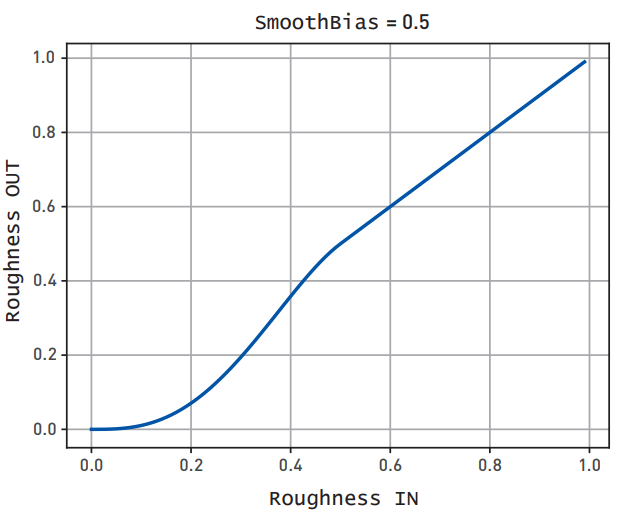

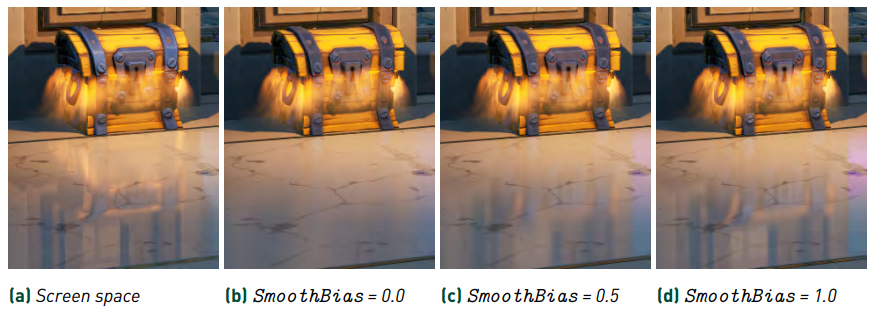

UE的SSR(左)和光線追蹤反射(右)對比圖。

UE5的遠場的大規模GI效果。它支援硬體光線追蹤模式。

17.2 光線追蹤基礎

17.2.1 數學基礎

已知原點\(\vec{o}\)和方向\(\vec{d}\),則射線是半無限的直線:

\]

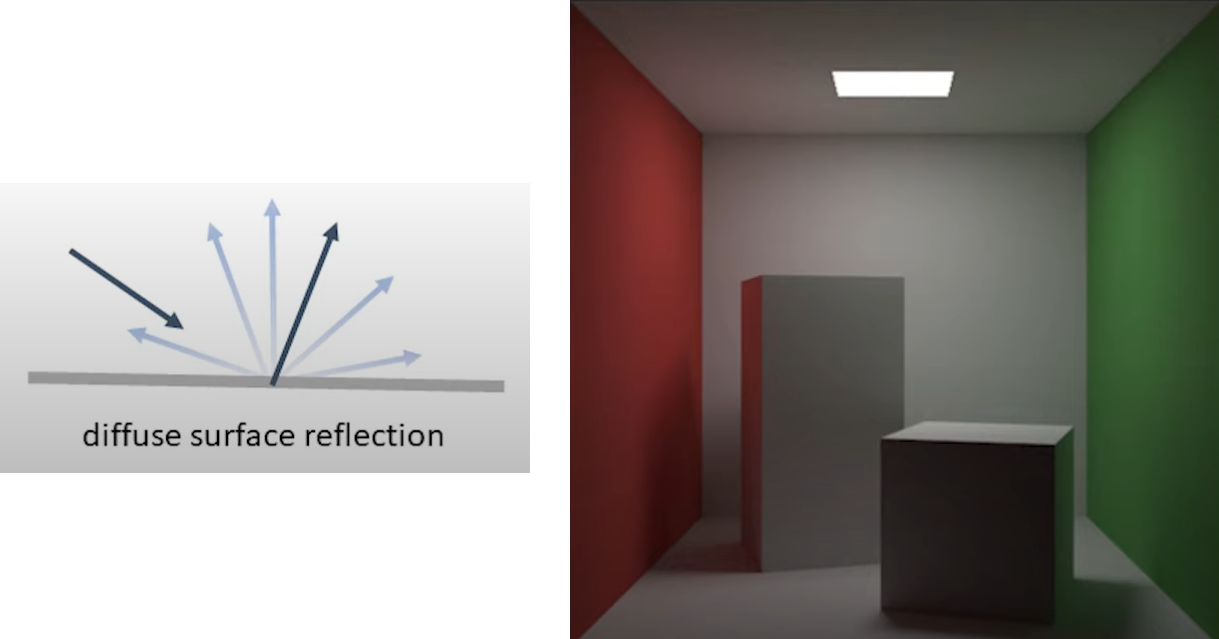

已經有3個頂點\(\vec{a}\)、\(\vec{b}\)、\(\vec{c}\),它們可以組成一個三角形,該三角形的法線可通過叉乘計算而得:

\]

射線和三角形的交點必須沿著射線,並且必須在三角形的平面內,因此必須滿足:\((\vec{p}-\vec{a})\cdot\vec{n} = 0\),結合射線公式,可計算出\(t\)值:

\]

以上公式需要處理一種特殊的情況,那就是\(\vec{d}\cdot\vec{n}=0\),即射線平行三角形的平面。如果計算的\(t\)值是負數,說明不在三角形內,可以拒絕該點。

給定任意的距離\(t\),可以很方便地通過射線的公式計算得到射線和三角形平面的交點。接下來,我們必須檢查該點是在三角形內還是在三角形外,可以通過計算質心坐標\((u, v)\)來實現這一點。質心坐標定義為:

\]

對應的圖例如下:

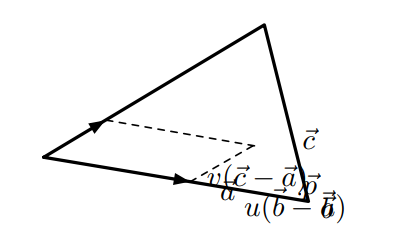

對於四邊形(雙線性面片),質心坐標更加複雜:

\]

對應圖例:

以上是針對四個頂點位於同一個平面的情況,但實際上,它們可能不在同一個平面,會產生兩個平面。

由兩個三角形近似的四邊形。

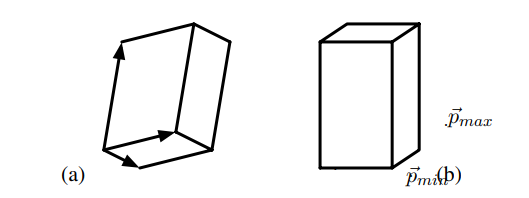

包圍盒(bounding box)對於加速複雜場景的光線追蹤非常有用。一般盒子由一個頂點和三個向量定義(下圖)。直接的相交測試將測試六個面中的每個面是否相交。通過僅需要測試面向射線原點的三個面,可以實現更快的測試。

(a)具有一般方向的盒;(b) 軸對齊盒。

軸對齊的盒子可以更有效地進行交叉測試。軸對齊盒由xy、xz和yz平面中的每個平面中的兩個矩形組成。軸對齊盒由其最小和最大頂點\(\vec{p}_{min}\)和\(\vec{p}_{max}\)定義,如上圖(b)所示。我們可以將盒子視為三塊無限大空間板的交點。Smits描述了一種非常有效的射線交叉測試,利用IEEE浮點約定優雅而有效地處理0的除法,從而簡化了程式碼。

如果盒用作邊界盒,我們不需要知道最近的交點和法線,我們只需要知道光線是否與盒相交。

二次曲面(Quadrics)由圓盤、球體、圓柱體、圓錐體、橢球體、拋物面和雙曲面組成。

圓盤由其中心\(\vec{c}\)、法線\(\vec{n}\)和半徑\(r\)定義。尋找射線-圓盤交點與射線-三角形交點測試非常相似。我們首先計算射線-平面交點\(\vec{p}\),並檢查距離\(\vec{t}\)是否為正且小於之前的最近交點,如果\((\vec{p}-\vec{c})^2\le r^2\),則交點在圓盤上。圓盤在實際渲染中被大量使用,例如用於渲染粒子系統。

球體由其中心\(\vec{c}\)和半徑\(r\)定義。如果存在交點,則交點必須位於射線的某個位置,並且必須位於球體的表面上。為了找到交點,我們將射線方程代進球體方程\((\vec{p}-\vec{c})^2 = r^2\):

0 &=(\vec{p}-\vec{c})^{2}-r^{2} \\

&=\vec{p}^{2}-2(\vec{p} \cdot \vec{c})+\vec{c}^{2}-r^{2} \\

&=(\vec{o}+t \vec{d})^{2}-2(\vec{o}+t \vec{d}) \cdot \vec{c}+\vec{c}^{2}-r^{2} \\

&=\vec{o}^{2}+2 t(\vec{o} \cdot \vec{d})+t^{2} \vec{d}^{2}-2(\vec{o} \cdot \vec{c})-2 t(\vec{d} \cdot \vec{c})+\vec{c}^{2}-r^{2} \\

&=\vec{d}^{2} t^{2}+2 \vec{d} \cdot(\vec{o}-\vec{c}) t+(\vec{o}-\vec{c})^{2}-r^{2}

\end{aligned}

\]

\(t\)存在兩個解:\(t_1 = \cfrac{-B+D}{2A}\)和\(t_2 = \cfrac{-B-D}{2A}\),其中\(A = \vec{d}^2,B=2\vec{d}\cdot(\vec{o}-\vec{c}),C=(\vec{o}-\vec{c})^2-r^2,D=\sqrt{B^2-4AC}\)。對於判別式\(D\),存在3種情況:

- 如果\(D\)為負,則不存在(實)解,並且光線不會擊中球體。

- 如果\(D\)為零,則光線與球體相切,並且只有一個交點。

- 如果\(D\)為正,則存在兩個交點,最近的交點是具有最小非負值t的交點。

給定交點距離\(t\),我們可以計算出交點\(\vec{p}\),交點上的法線是\(\vec{n} = \vec{p} – \vec{c}\)。

還有其它形式的二次曲面,本文就不再解析,有興趣的同學可以自行尋找資料。

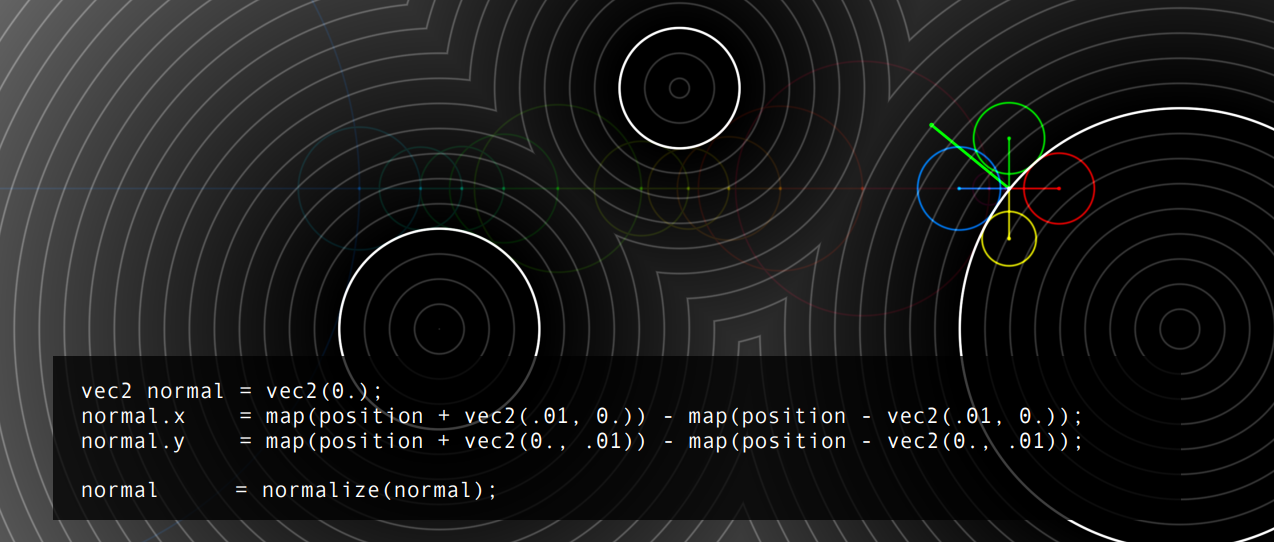

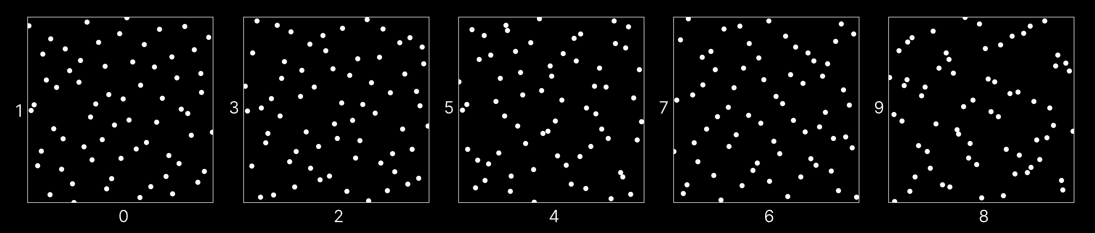

隱式曲面(Implicit surface)由函數\(f\)定義:曲面是點\(\vec{p}\)的集合,其中函數的值為0,\(f(\vec{p})=0\)。因此,為了找到射線-曲面交點,我們必須確定沿射線的(最近的)點\(\vec{p})\),其中\(f(\vec{p})\)為0:

\]

它可以使用例如Newton-Raphson迭代或其他迭代方法來完成,Sherstyuk描述了一種有效的演算法。交點處的曲面法線由該點處函數的梯度給出:

\]

還有NURBS曲面、細分曲面、位移曲面、盒體等,本文不再詳述。

光線微分(Ray differential)儘管是光線的基本屬性,但用於光線追蹤還是相對較新的,對於包括紋理過濾和曲面細分在內的許多應用程式都很有用。光線微分描述了光線與其真實或虛擬「相鄰」光線之間的差異。如下圖所示,微分給出了每條射線所代表的光束大小的指示。

光線和光束。

Igehy的光線微分方法追蹤光線傳播、鏡面反射和折射時的光線微分。曲面交點處的曲率決定了在鏡面反射和折射後光線差及其相關光束的變化。例如,如果光線擊中高度彎曲的凸面,鏡面反射光線將具有較大的差異(表示高度發散的相鄰光線)。

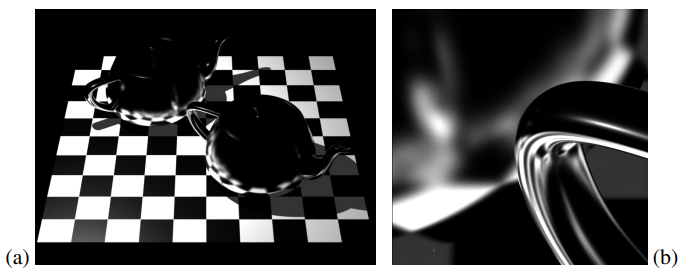

下圖顯示了光線追蹤的鏡面反射。在左影像中,不計算光線微分,並且紋理濾波器寬度為零,因此產生鋸齒瑕疵。在右圖中,光線微分用於確定適當的紋理過濾器大小。為了清楚地顯示差異,影像的解析度非常低(200×200像素),每個像素僅拍攝一條反射光線,並關閉像素濾波。

反射:(a)不使用光線微分,(b) 使用。

Suykens和Willems將光線微分推廣到光澤和漫反射。對於漫反射或環境遮擋的分布光線追蹤,光線微分對應於半球的一部分。從同一點追蹤的光線越多,對端半球部分越小。如果半球分數(fraction)非常小,曲率相關微分(如鏡面反射)將佔主導地位。

17.2.2 浮點數

浮點數的實數必須近似,包含浮點數(Floating-point number)、定點數(Fixed-point number,亦即整數)、有理數(Rational number,齊次表示)。IEEE-754單精度的數據布局是:1位符號、8位指數(偏置)、23位分數(帶隱藏位的24位尾數),其圖例如下:

其表示的數值公式是:

\]

這是一種標準化格式,IEEE-754可表示的數字如下表:

| 序號 | 指數(Exponent) | 分數(Fraction) | 符號(Sign) | 值 |

|---|---|---|---|---|

| 1 | \(0 < e < 255\) | \(V = (-1)^s \ \times\ (1.f)\ \times\ 2^{e-127}\) | ||

| 2 | \(e = 0\) | \(f = 0\) | \(s = 0\) | \(V = 0\) |

| 3 | \(e = 0\) | \(f = 0\) | \(s = 1\) | \(V = -0\) |

| 4 | \(e = 0\) | \(f ≠ 0\) | \(V = (-1)^s \ \times\ (0.f)\ \times\ 2^{e-126}\) | |

| 5 | \(e = 255\) | \(f = 0\) | \(s = 0\) | \(V = +Inf\) |

| 6 | \(e = 255\) | \(f = 0\) | \(s = 1\) | \(V = -Inf\) |

| 7 | \(e = 255\) | \(f ≠ 0\) | \(V = NaN\) |

上表補充以下幾點說明:

- 注意序號1和4的區別。序號1表達的是普通的浮點值,而序號4表達的是兩個特殊的值:當\(s=0\)時,值是\((0.f)\ \times\ 2^{-126}\);當\(s=1\)時,值是\(-(0.f)\ \times\ 2^{-126}\)。

- 序號2和3值是相等的,但符號不一樣。

- 序號5、6、7代表的值分別是正無窮、負無窮、非法值(空值)。例如:

- 如果\(a>0\),則\(a/0=+Inf\)。

- 如果\(a<0\),則\(a/0=–Inf\)。

- \(0/0=Inf – Inf=±Inf·0=NaN\)。

涉及\(NaN\)、\(Inf\)的運算稱為無窮算術(Infinity Arithmetic,IA)。IA是魯棒性錯誤的潛在來源!\(+Inf\)和\(–Inf\)比較是正常的,但\(NaN\)比較卻無法預料:

-

NaN != NaN是true! -

涉及NaN的所有其他比較都是

false! -

下面兩個表達式不等價:

if (a > b) X(); else Y(); if (a <= b) Y(); else X();

但IA也提供了一個很好的功能,允許不必測試除零操作,從內循環(inner loop)中刪除測試分支,對SIMD程式碼有用。(儘管同樣的方法通常也適用於非IEEE CPU。)

IEEE-754的特殊表達方式,導致了不規則數字線——即距離零越遠,間距越大,指數k+1的數字範圍的間距是指數k的兩倍,從一個指數到另一個指數的等同於多個可表示數。(下圖)

不規則間距的後果:

- \(–1020 + (1020 + 1) = 0\)

- \((–1020 + 1020 ) + 1 = 1\)

因此,會導致非結合律:\((a+b)+c \ne a+ (b+c)\),錯誤層出不窮!所有離散表示都有不可表示的點:

在浮點運算中,由於間距不規則,行為會根據位置而變化!

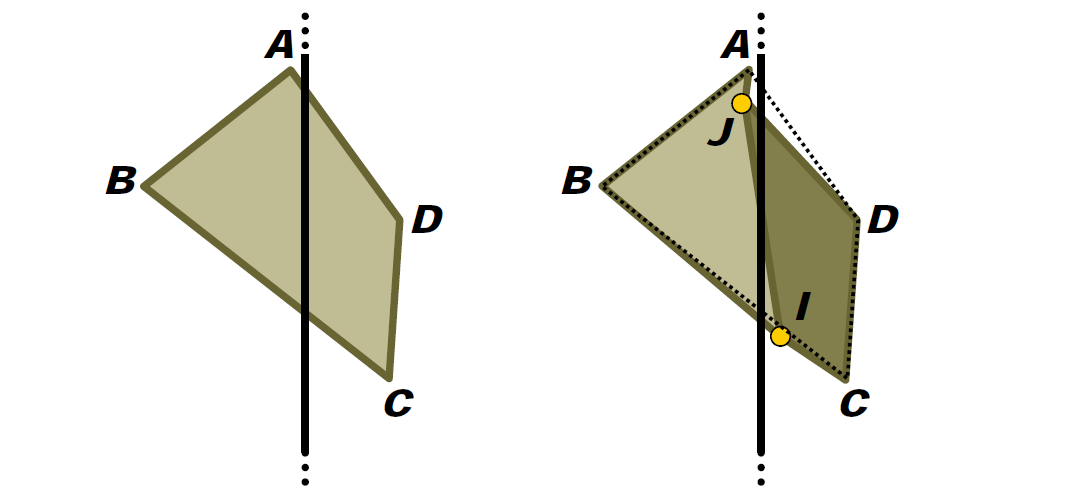

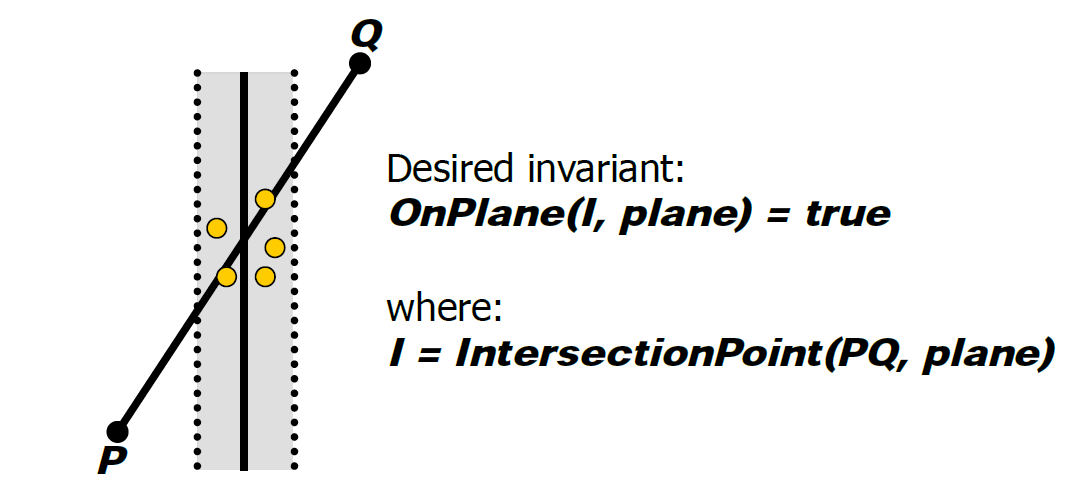

例如,Sutherland-Hodgman裁剪演算法(多邊形分割的演算法之一):

進入浮點錯誤:

ABCD相對於平面拆分:

當然,可以用厚平面來解決:

厚平面也有助於限制錯誤:

ABCD相對於厚平面拆分:

順序不一致導致的裂紋:

另一個示例是BSP樹魯棒性,存在以下方面的穩健性問題:

-

插入圖元。

-

查詢(碰撞檢測)。

-

同樣的問題也適用於:

- 所有空間分區方案!

- (k-d樹、網格、八叉樹、四叉樹…)。

實現穩健性的方法:保守插入圖元,考慮查詢和插入錯誤,然後可以忽略查詢問題。

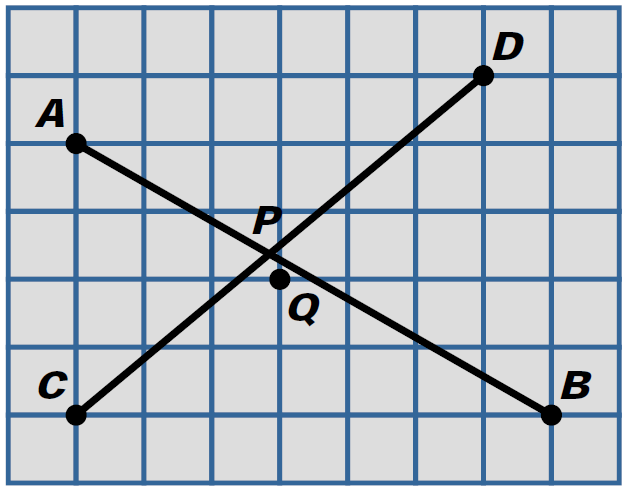

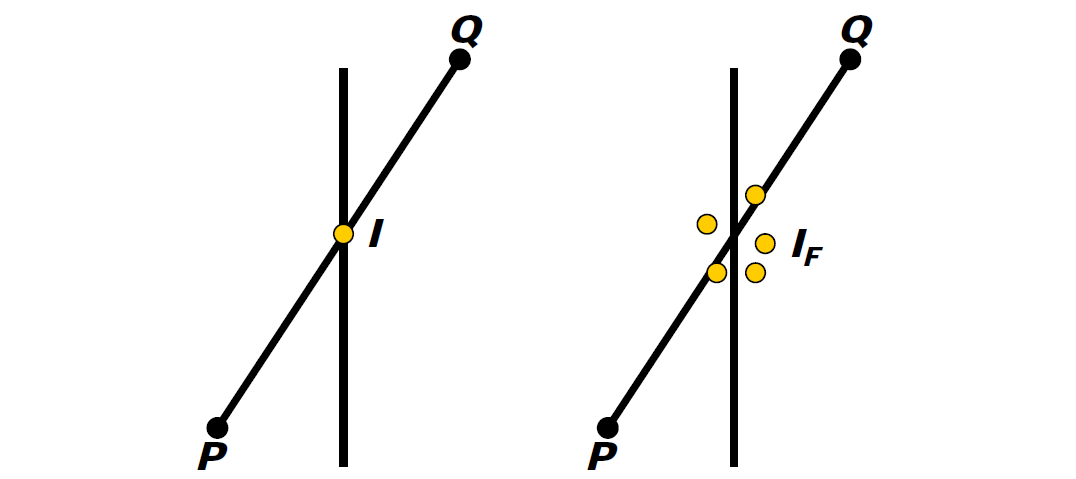

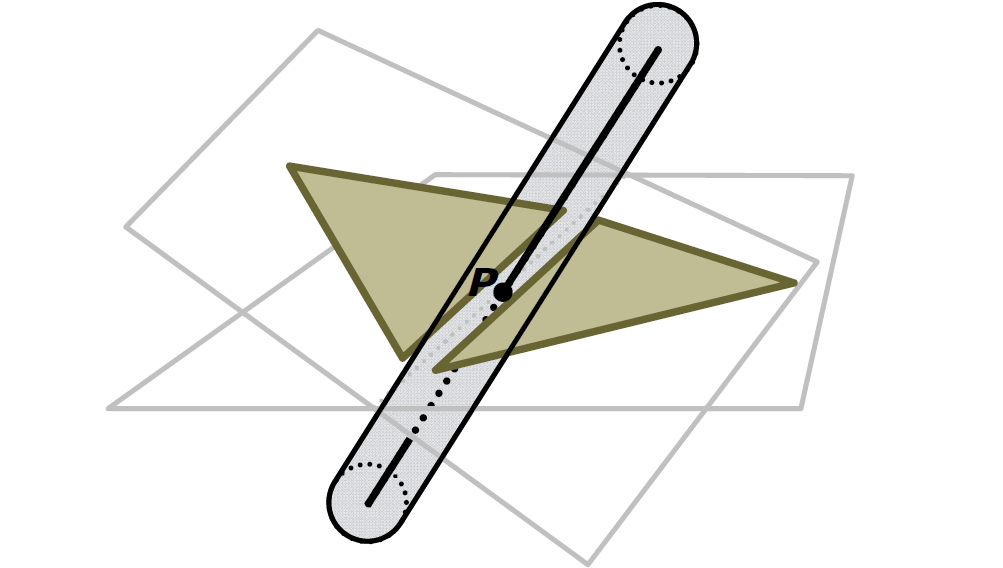

浮點值誤差的示例還有射線和三角形的檢測。常用方法:計算光線R與三角形T平面的交點P,測試P是否位於T的邊界內。然而,這是非魯棒性的!以下圖舉例:

R與一個平面相交:

R與另一平面相交:

穩健測試必須共享共享的邊緣AB的計算,直接在3D中執行測試,過程如下:

- R可表示為:\(R(t)=O + t\bold d\)。

- 然後,\(\bold d \cdot (OA \times OB)\)的符號表示AB的左邊還是右邊。

- 如果R在所有邊的左側,則R與CCW(反時針)三角形相交。

- 然後才計算P。

仍然存在錯誤,但可控。胖(fat)射線測試也很魯棒!

實現魯棒性的方法有:

- 正確公差(tolerance,也叫容差)的使用。

- 計算的共享。

- 胖(fat)圖元的使用。

公差比較包含以下幾種方式:

-

絕對公差。比較兩個浮點值是否相等:

if (Abs(x –y) <= EPSILON) (...)幾乎從未正確使用過!

EPSILON應該是什麼?通常使用任意小的數字!下一個可表示數的增量步長:十進位 十六進位 下一個可表示數 10.0 0x41200000 x + 0.000001 100.0 0x42C80000 x + 0.000008 1000.0 0x447A0000 x + 0.000061 10000.0 0x461C4000 x + 0.000977 100000.0 0x47C35000 x + 0.007813 1000000.0 0x49742400 x + 0.0625 10000000.0 0x4B189680 x + 1.0 上表可知,數值越大,所需的

EPSILON越大,對於之前我們常見的取EPSILON為0.001(或其它若干個0)的做法顯然是有問題的!例如Möller Trumbore射線和三角形的測試程式碼:#define EPSILON 0.000001 #define DOT(v1,v2) (v1[0]*v2[0] + v1[1]*v2[1] + v1[2]*v2[2]) (...) // if determinant is near zero, ray lies in plane of triangle det = DOT(edge1, pvec); (...) if (det > -EPSILON && det < EPSILON) // Abs(det) < EPSILON return 0;改用雙精度書寫,在不改變

EPSILON的情況下改變為float?DOT({10,10,10},{10,10,10})破壞測試! -

相對公差。比較兩個浮點值是否相等:

if (Abs(x–y) <= EPSILON * Max(Abs(x), Abs(y)) (...)EPSILON按輸入幅值縮放,但是考慮

Abs(x)<1.0、Abs(y)<1.0。 -

組合公差。比較兩個浮點值是否相等:

if (Abs(x –y) <= EPSILON * Max(1.0f, Abs(x), Abs(y)) (...)用

Abs(x)≤1.0、Abs(y)≤1.0進行絕對值測試,否則進行相對測試! -

整數測試。

警告:英特爾內部使用80位格式,除非另有說明。錯誤取決於生成的程式碼,在調試和發布時給出不同的結果。

接下來介紹精確算術(Exact arithmetic,半精確同樣)。

整數算術是精確的,只要沒有溢出(overflow),在+、–、和*下是封閉的,但對/不是,通常可以通過叉乘(cross multiplication)刪除除法。示例:C如何投影到AB上?

用浮點和整數的運算如下:

// float

float t = Dot(AC, AB) / Dot(AB, AB);

if (t >= 0.0f && t <= 1.0f)

... /* do something */

// integer

int tnum = Dot(AC, AB), tdenom = Dot(AB, AB);

if (tnum >= 0 && tnum <= tdenom)

... /* do something */

測試(Test)是布爾值,可以精確計算。構造(Construction)是非布爾型,無法精確執行。測試通常表示為行列式,例如:

u_{x} & u_{y} & u_{z} \\

v_{x} & v_{y} & v_{z} \\

w_{x} & w_{y} & w_{z}

\end{array}\right| \geq 0 \Leftrightarrow \mathbf{u} \cdot(\mathbf{v} \times \mathbf{w}) \geq 0

\]

使用擴展精度演算法(EPA)進行估算,EPA開銷昂貴,通過「浮點過濾器」限制EPA的使用,常用的濾波器是區間計算(Interval arithmetic)。區間計算的樣例:x = [1,3] = { x ∈R | 1 ≤ x ≤ 3 },其規則如下:

- [a,b] + [c,d] = [a+c, b+d]

- [a,b] – [c,d] = [a–d, b–c]

- [a,b] * [c,d] = [min(ac, ad, bc, bd), max(ac, ad, bc, bd)]

- [a,b] / [c,d] = [a, b] * [1/d, 1/c] for 0 ∉ [c, d]

區間計算的間隔必須向上/向下四捨五入到最接近的機器表示數,是可靠的計算。

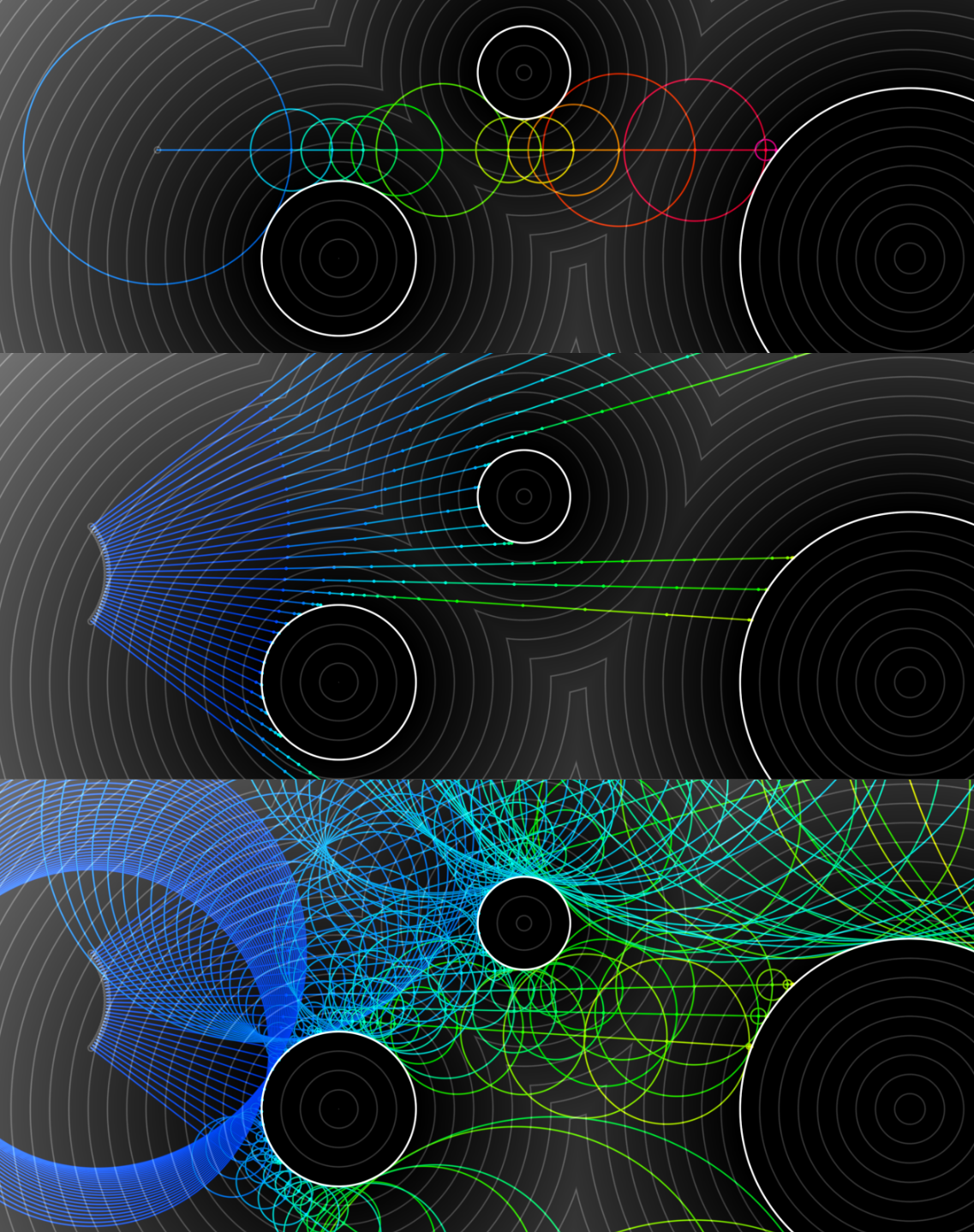

17.2.3 隱式函數

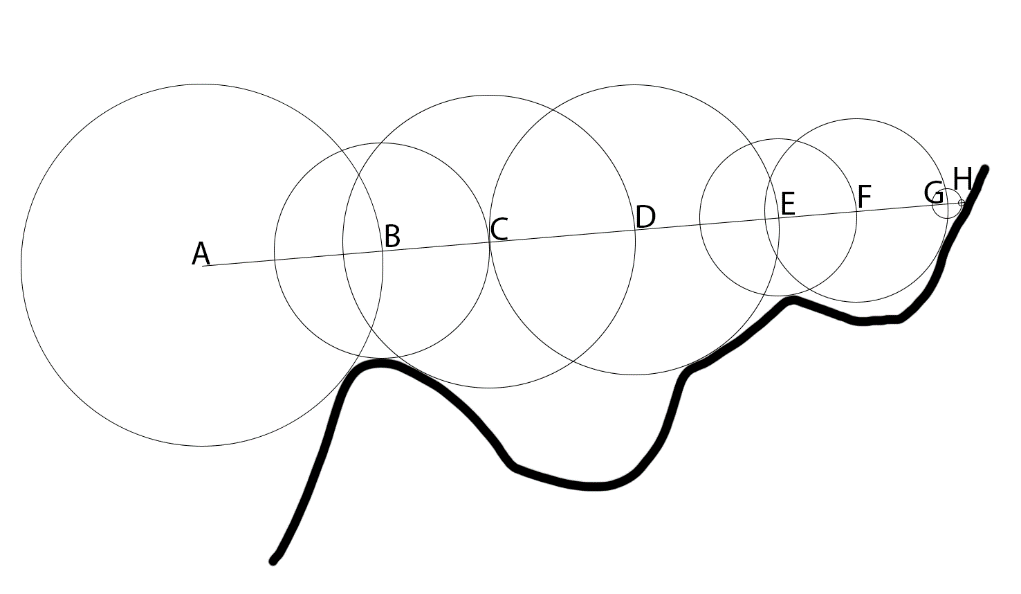

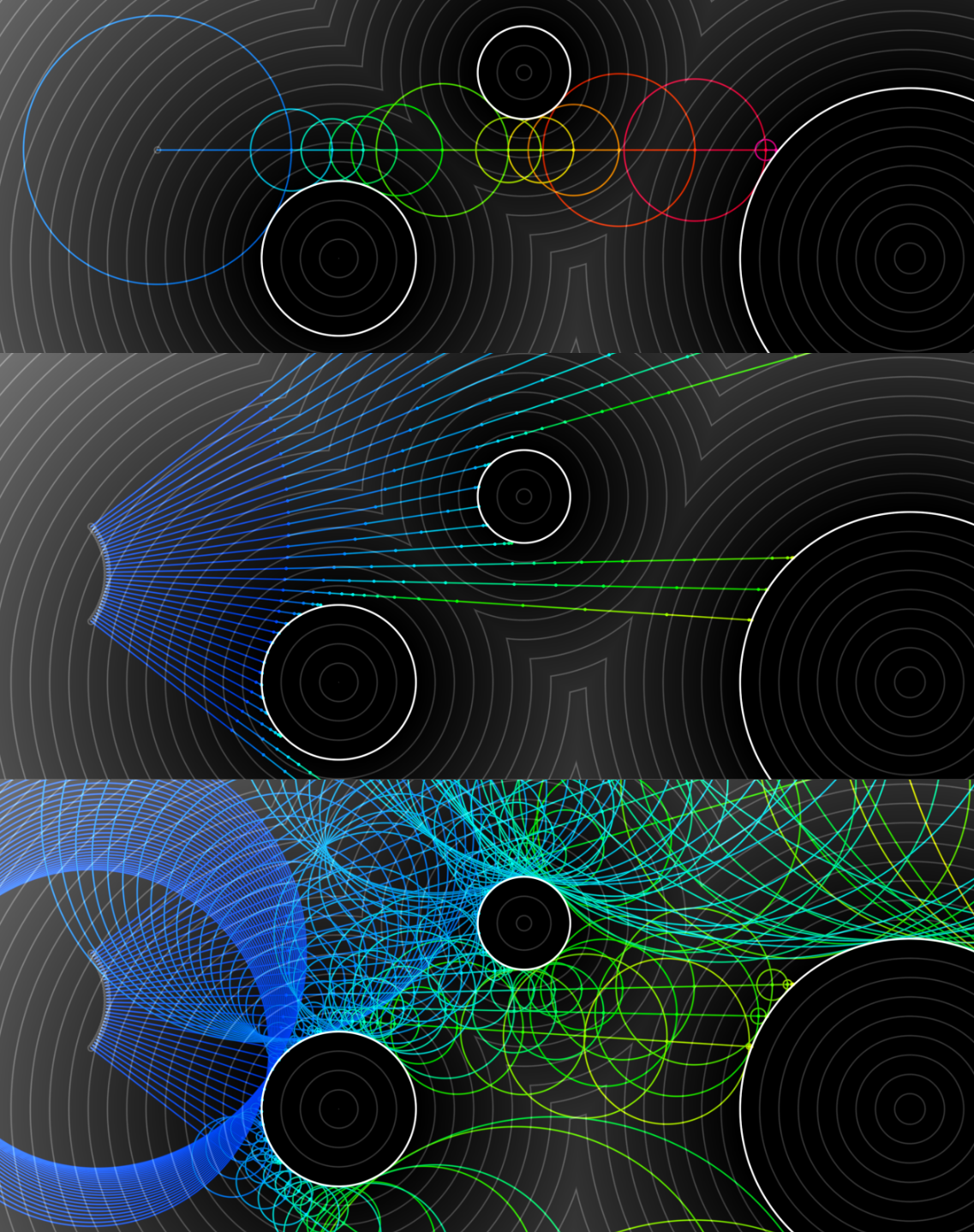

球體追蹤是光線追蹤的諸多形式的其中一種,是隱式函數的理想選擇,不是光柵化或體素的替代品。很低效,但是很簡單,並且非常靈活。球體追蹤只需要4步:

-

構建視圖。

只需要兩個三角形和UV坐標。相關的程式碼如下:

vec2 screen_coordinates = gl_FragCoord.xy; screen_coordinates /= resolution; screen_coordinates = screen_coordinates - .5; screen_coordinates *= resolution/min(resolution.x, resolution.y); float field_of_view = 1.5; vec3 direction = vec3(screen_coordinates, field_of_view); direction = normalize(direction); -

追蹤光線。

追蹤的步驟和射線步長如下所示:

對應的程式碼:

vec2 origin = vec2(0.0); vec2 position = origin; float surface_threshold = 0.001; for(int i=0; i<128; i++) { float distance_to_surface = map(position); if(distance_to_surface < surface_threshold) break; position += direction * distance_to_surface; } float distance_to_scene = distance(origin, position); -

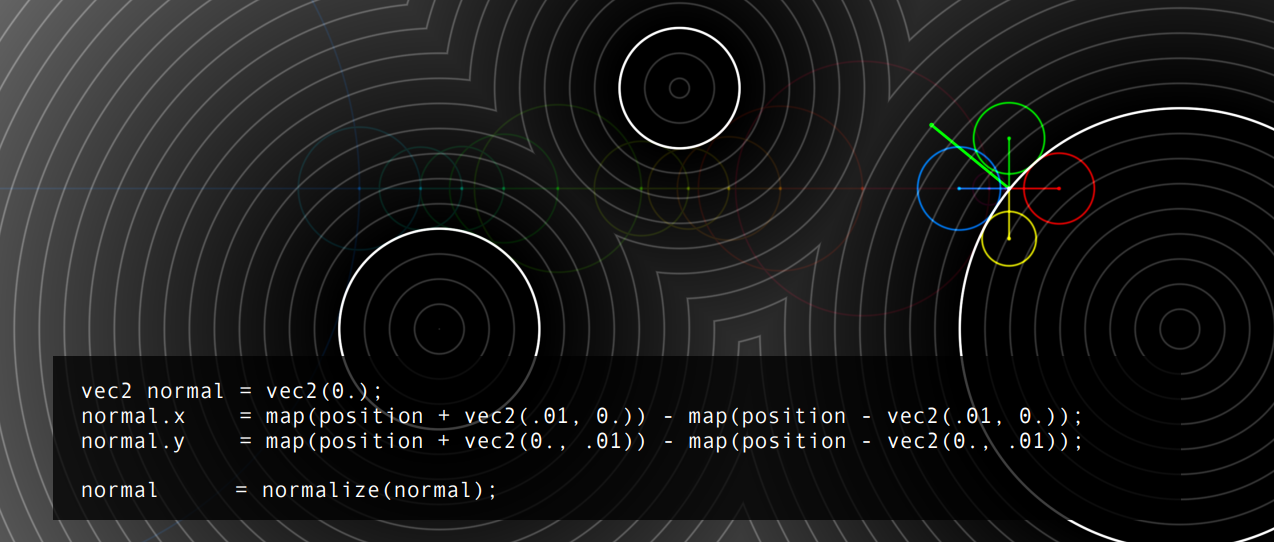

確定曲面的朝向。

在光線末端附近取樣,比較它們的偏導數,通過除以畢達哥拉斯定理的結果進行歸一化:

獲得了表面的法線:

法線可以從場中的任何位置取樣,而不僅僅是表面:

-

添加燈光。

增加光源的程式碼和效果如下:

通過以上幾個步驟,就可以實現複雜而有趣的場景(來自shadertoy):

顯式數據作為獨立值存儲在存儲器中,如網格頂點、紋理像素等…從存儲器中讀取數據。隱式數據的程式碼是數據,一切都是程式性的,通過計算訪問數據。

通過簡單的加減乘除和mod、min、max、noise等操作可以實現複雜、自然的模型:

關於距離和噪音,有一些事情需要注意。大多數情況下,需要很多步驟才能找到物體表面,這也是個問題。追蹤正弦曲線時,空間不是線性的。Mod和雜訊操作同樣如此(下圖)。

雜訊還會引起渲染瑕疵:

有人說你應該不惜一切代價避免雜訊,因為它會破壞渲染,其他人則不同意,下面是非雜訊和添加雜訊的場景對比:

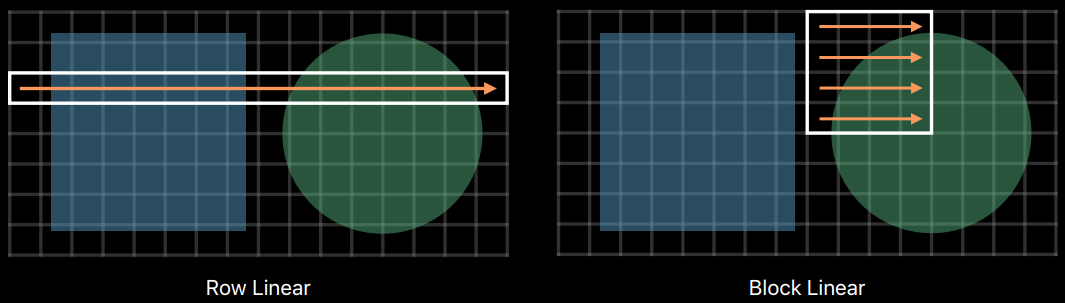

17.2.4 取樣方式

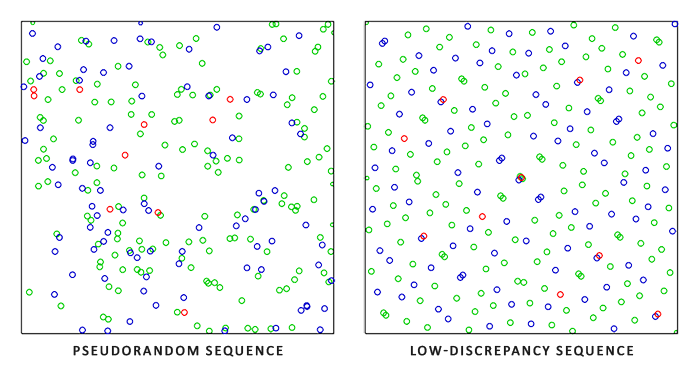

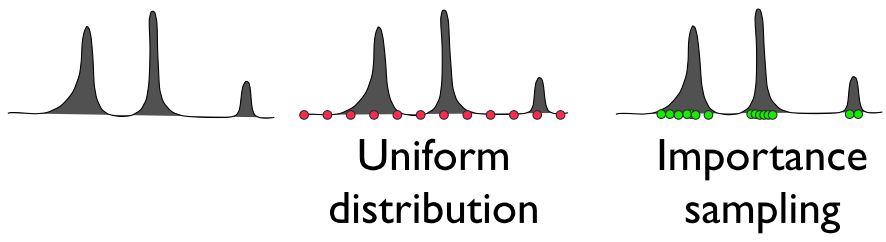

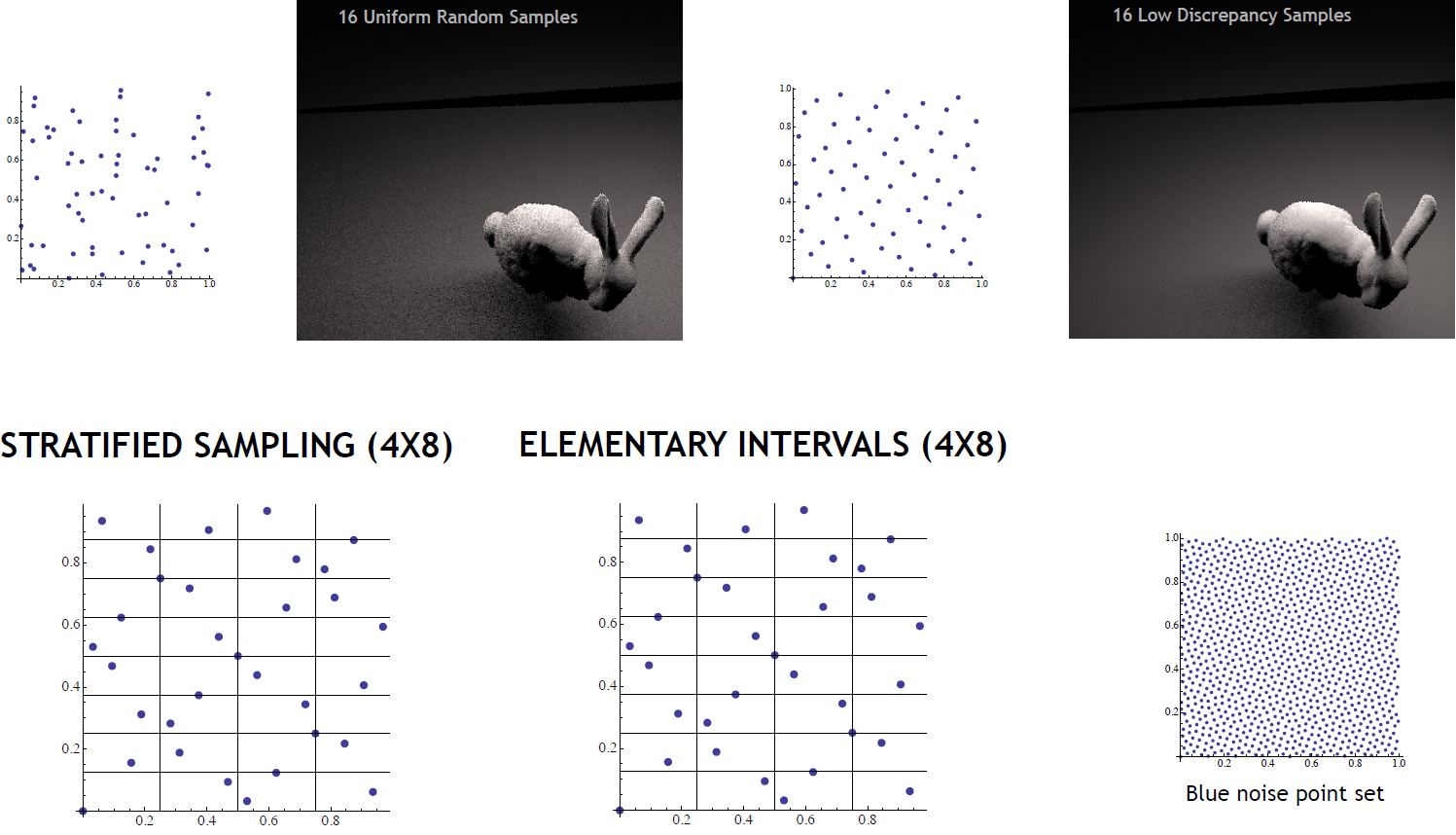

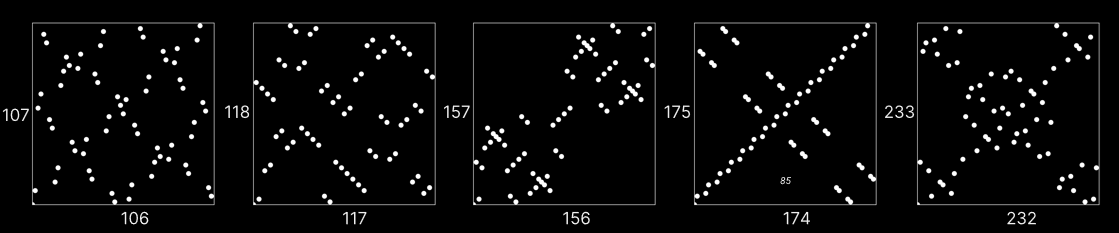

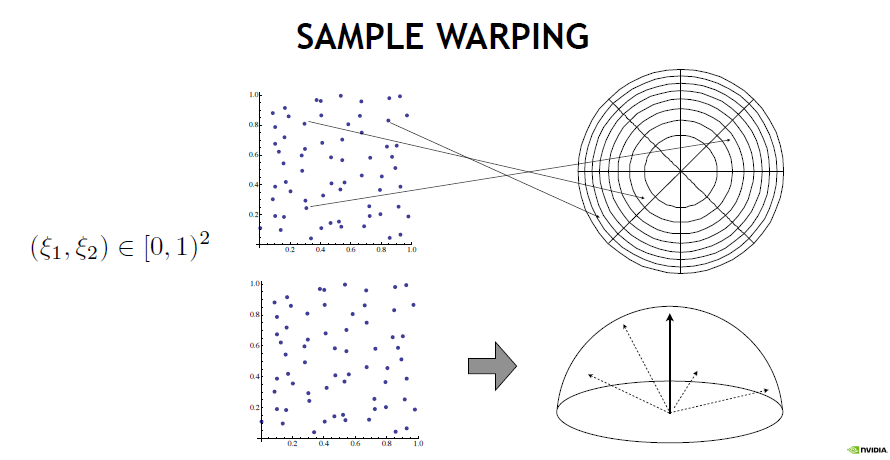

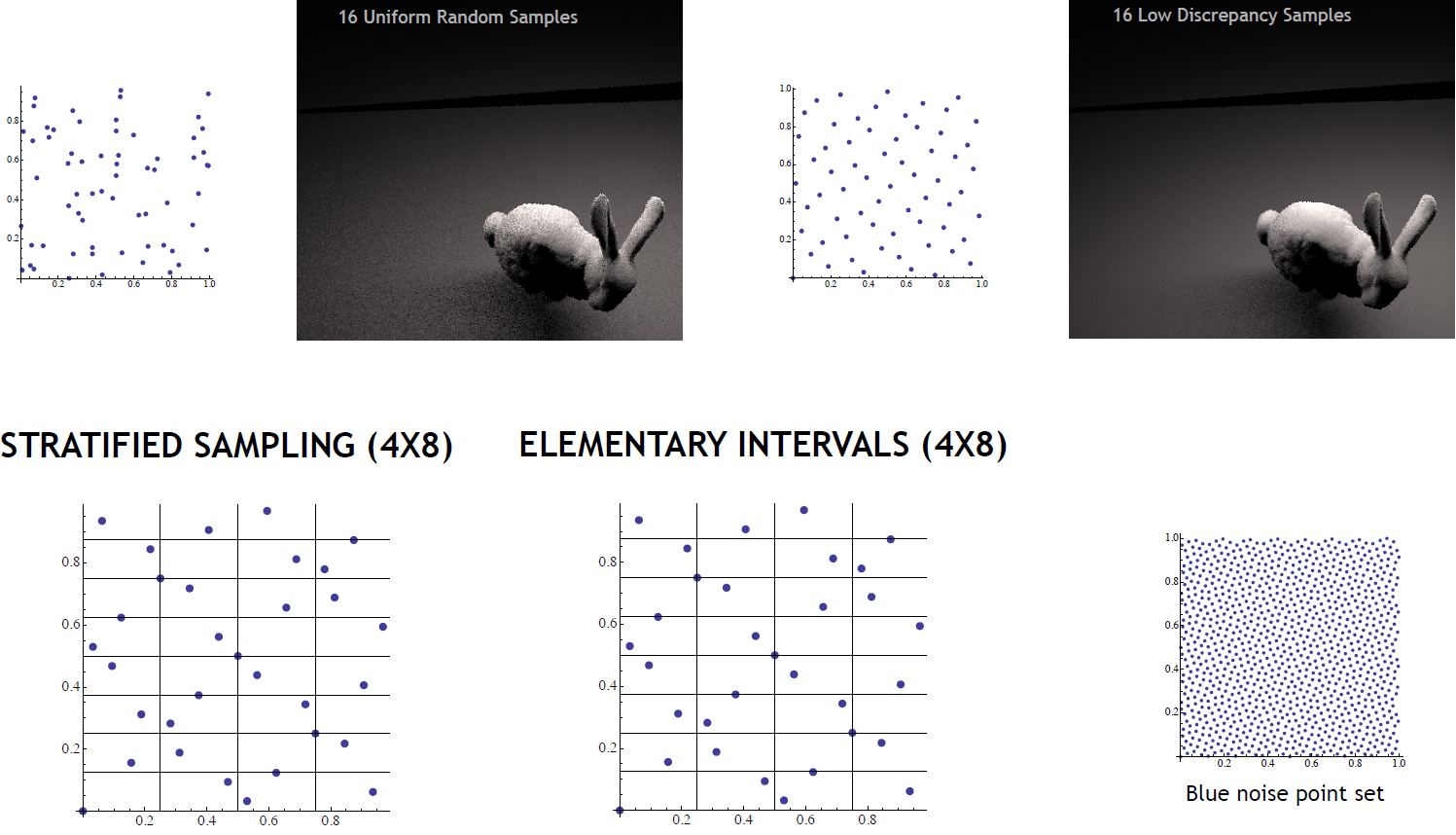

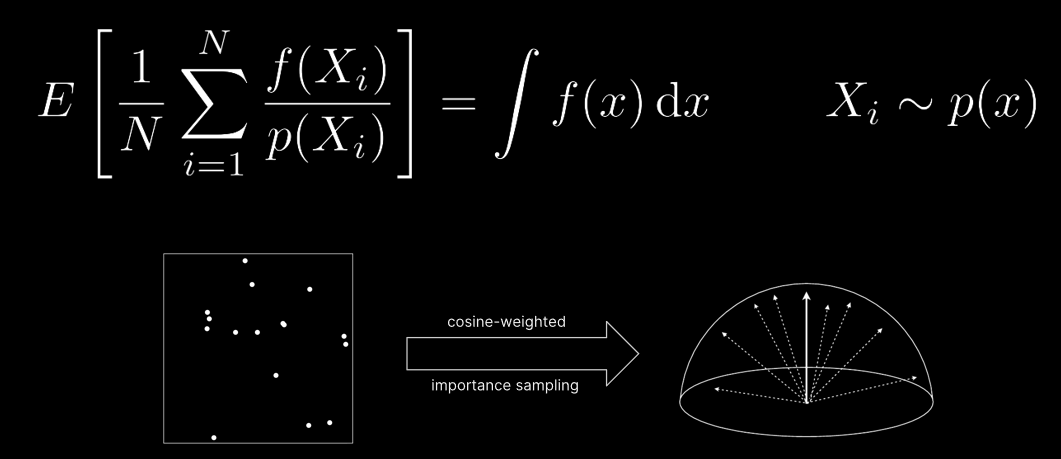

在圖形學中,取樣是個有意思卻蘊含著豐富的技術,包含了各式各樣的方式。在光線追蹤中,常見的取樣有均勻、隨機、低差異序列、重要性等方式。

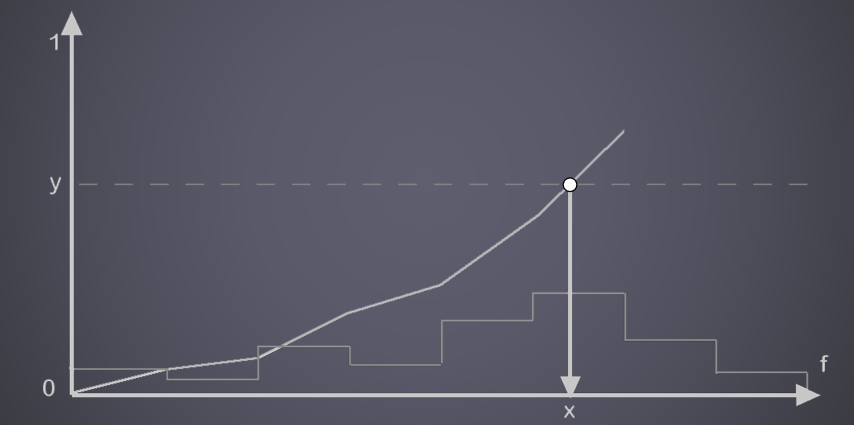

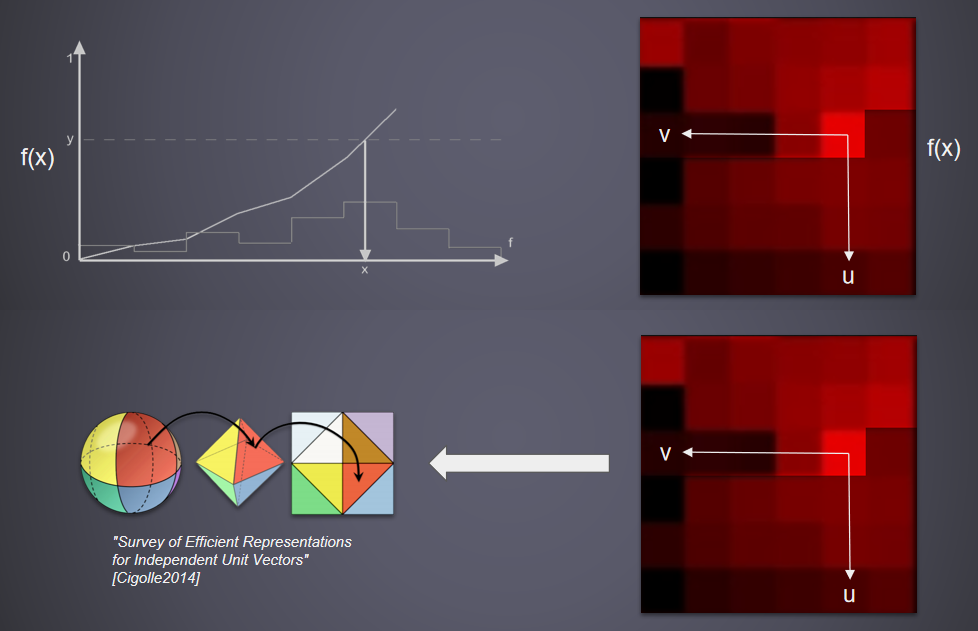

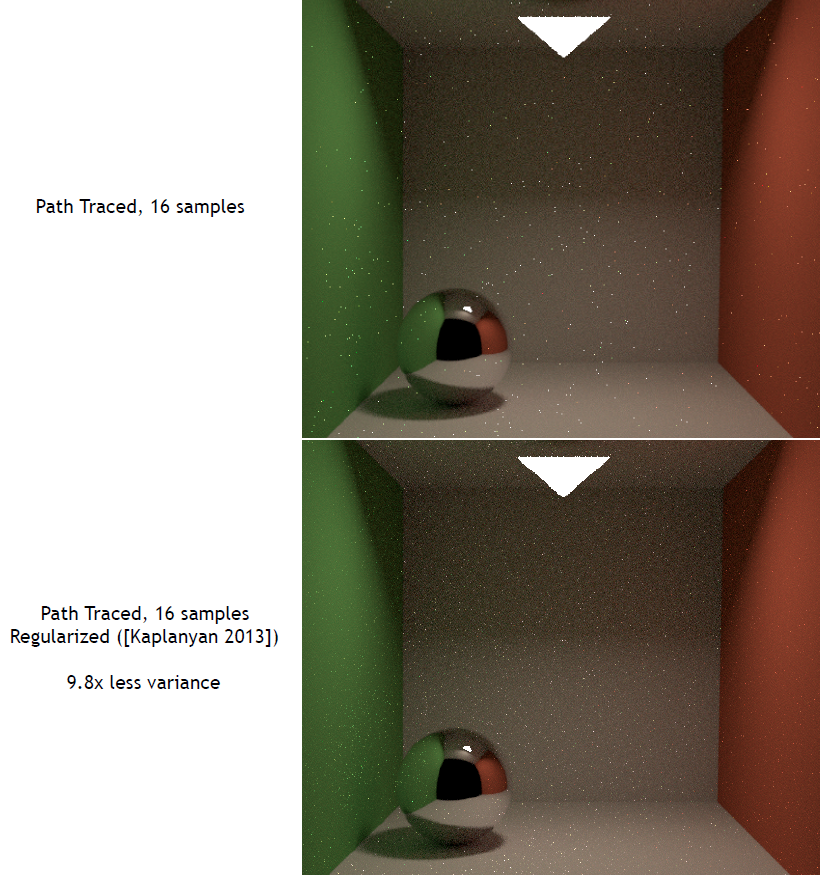

均勻取樣(Uniform Sampling)是不區分光源重要性的平均化取樣,生成的光線樣本在各個方向上概率都相同,並不會對燈光特殊對待,偏差與實際值通常會很大。蒙特卡洛取樣(Monte Carlo Sampling)著重考慮了光源方向的取樣,能突出光源對像素的貢獻量,但會造成光源貢獻量過度。重要性取樣(Importance Sampling)則加入概率密度函數pdf,通過縮小取樣結果,防止光源的貢獻量太大。

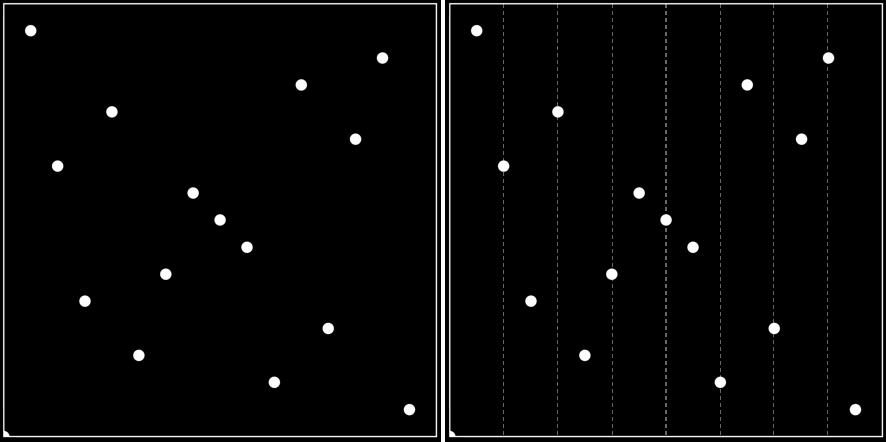

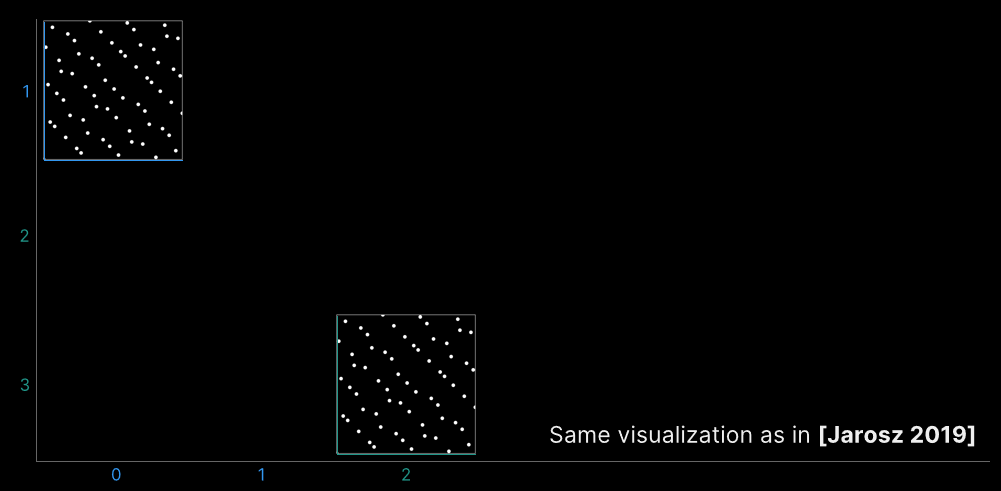

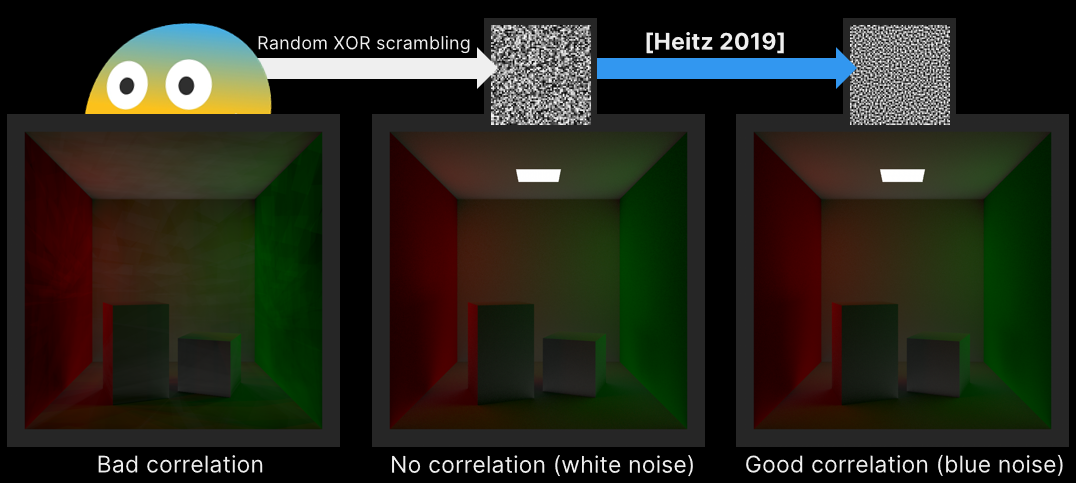

左:完全偽隨機序列生成的採用點;右:低差異序列生成的取樣點。可以看出右邊的更均勻。

蒙特卡洛取樣使用隨機樣本來數值計算該積分。重要性取樣的思想是嘗試生成與具有類似形狀的被積函數的概率密度函數(PDF)成比例的隨機樣本。

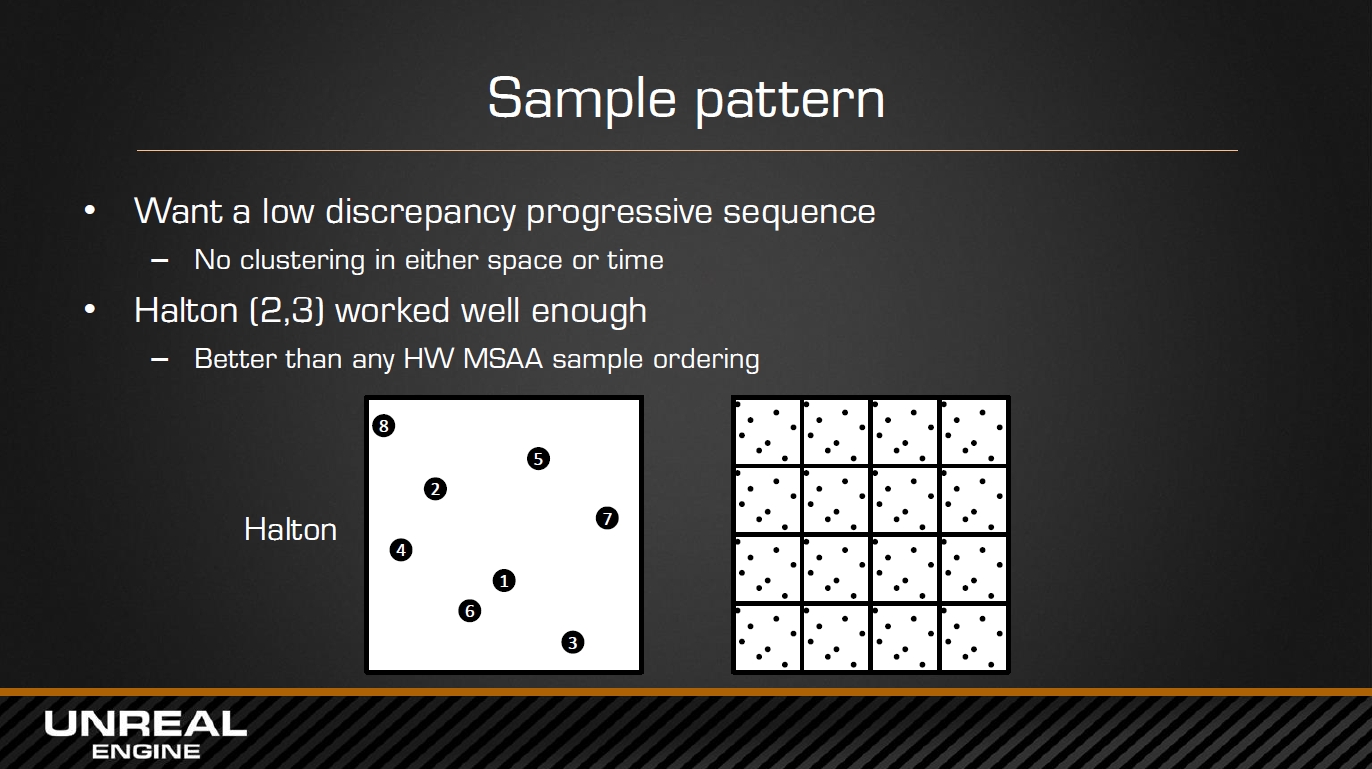

UE在實現TAA時採用了Halton、Sobal等序列:

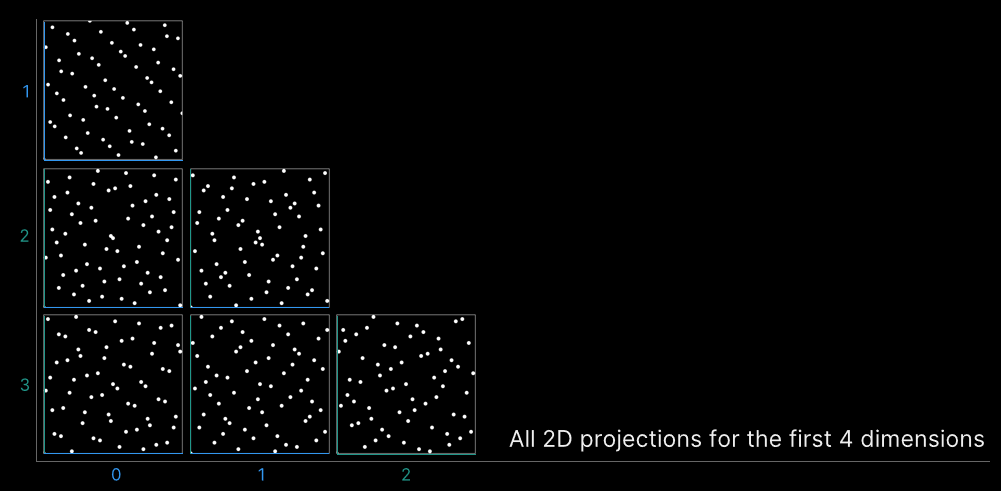

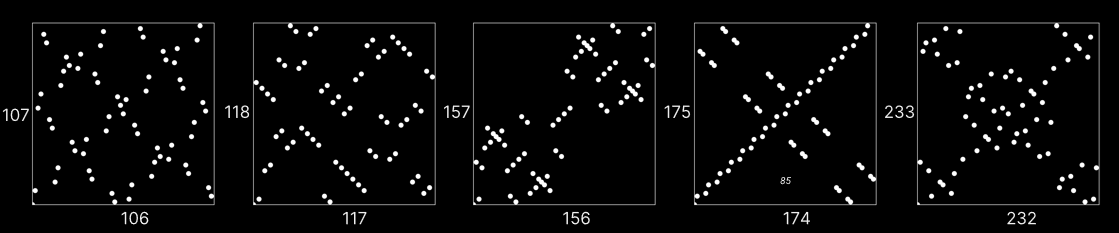

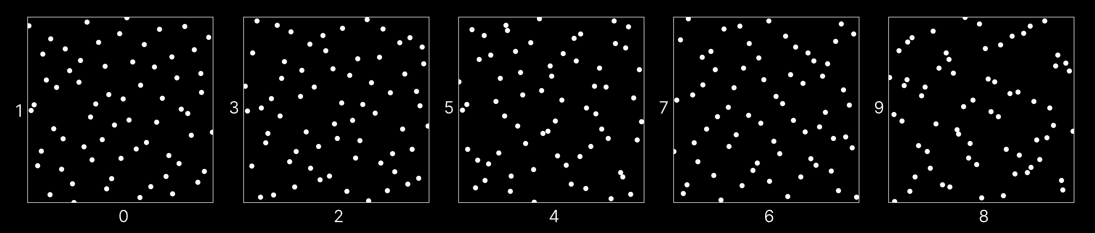

相比隨機取樣,Halton獲得的取樣序列更加均勻,且可以獲得沒有上限的樣本數(UE默認限制在8以內)。除此之外,還有Sobel、Niederreiter、Kronecker等低差異序列演算法,它們的比較如下圖:

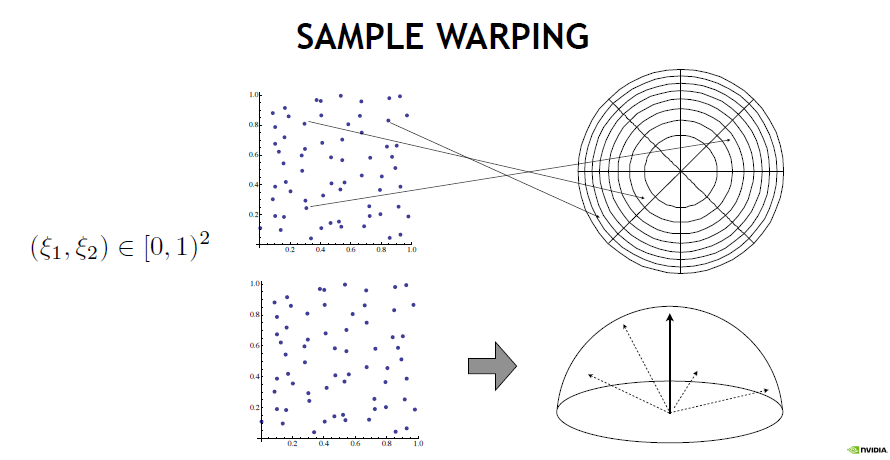

所有取樣技術都基於將隨機數從單位平方扭曲到其它域,再到半球、球體、球體周圍的圓錐體,再到圓盤。還可以根據BSDF的散射分布生成取樣,或選擇IBL光源的方向。有許許多多的取樣方式,但它們都是從0到1之間的值開始的,其中有一個很好的正交性:有「你開始的那些值是什麼」,然後有「你如何將它們扭曲到你想要取樣的東西的分布,以使用第二個蒙特卡羅估計」。

對應取樣方式,常用的有均勻、低差異序列、分層取樣、元素區間、藍噪點抖動等方式。低差異類似廣義分層,藍色噪點類似不同樣本之間的距離有多近。過程化模式可以使用任意數量的前綴,並且(某些)前綴分布均勻。

方差驅動的取樣——根據迄今為止採集的樣本,周期地估計每個像素的方差,在差異較大的地方多取樣,更好的做法是在方差/估計值較高的地方進行更多取樣,在色調映射等之後執行此操作。離線(品質驅動):一旦像素的方差足夠低,就停止處理它。實時(幀率驅動):在方差最大的地方採集更多樣本。計算樣本方差(樣本方差是對真實方差的估計):

float SampleVariance(float samples[], int n)

{

float sum = 0, sum_sq = 0;

for (int i=0; i<n; ++i)

{

sum += samples[i];

sum_sq += samples[i] * samples[i];

}

return sum_sq/(n*(n-1))) - sum*sum/((n-1)*n*n);

}

樣本方差只是一個估計值,大量的工作都是為了降噪,MC渲染自適應取樣和重建的最新進展。總體思路:在附近像素處加入樣本方差,可能根據輔助特徵(位置、法線等)的接近程度進行加權。高方差是個詛咒,一旦引入了一個高方差樣本,就會有大麻煩了,可以考慮對數據進行均勻取樣。

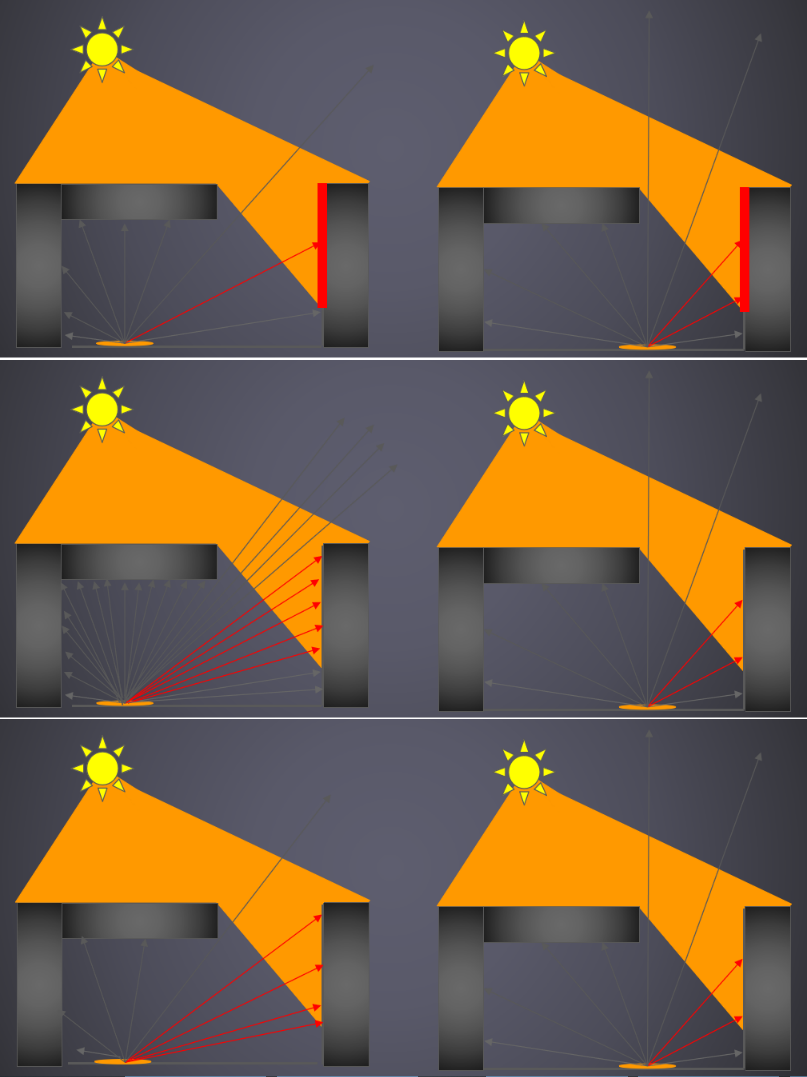

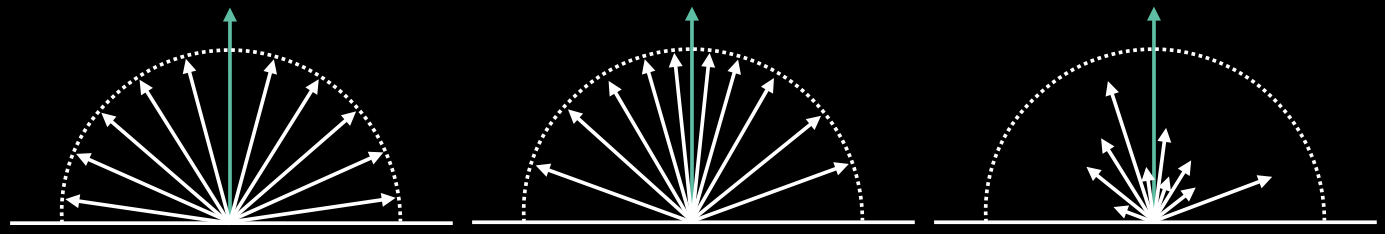

此外,對於不同粗糙度的表面,所需的光線數量和方向亦有所不同:

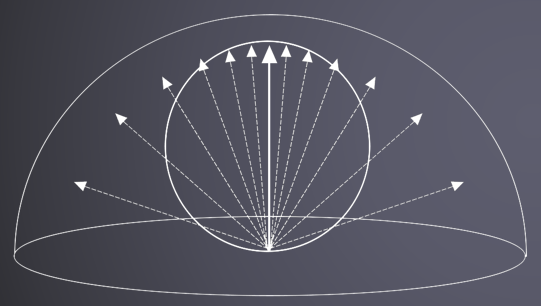

在計算陰影、AO等通道中,也使用了重要性取樣來生成光線,相同視覺品質需要的光線更少。重要性取樣過程中使用了半球、餘弦取樣、距離取樣:

從左到右:半球、半球+餘弦、半球+餘弦+距離。

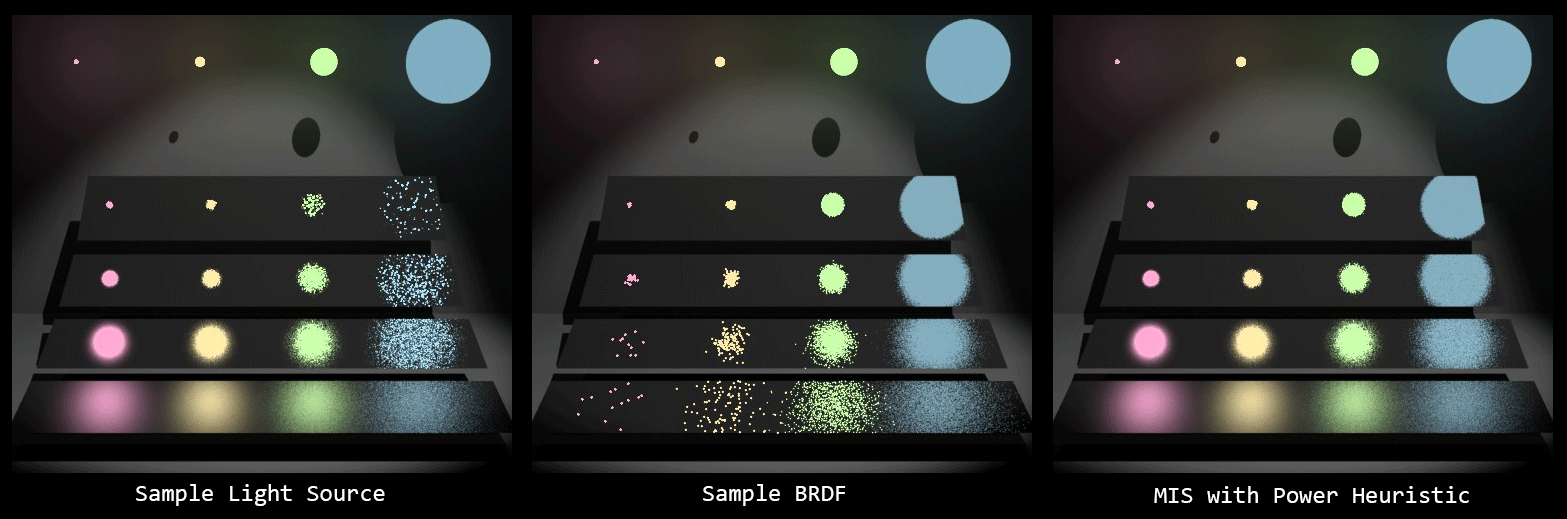

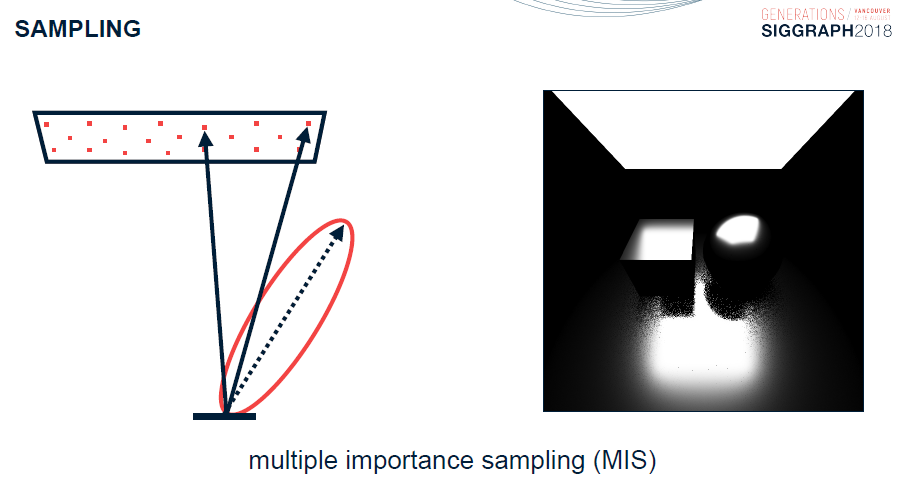

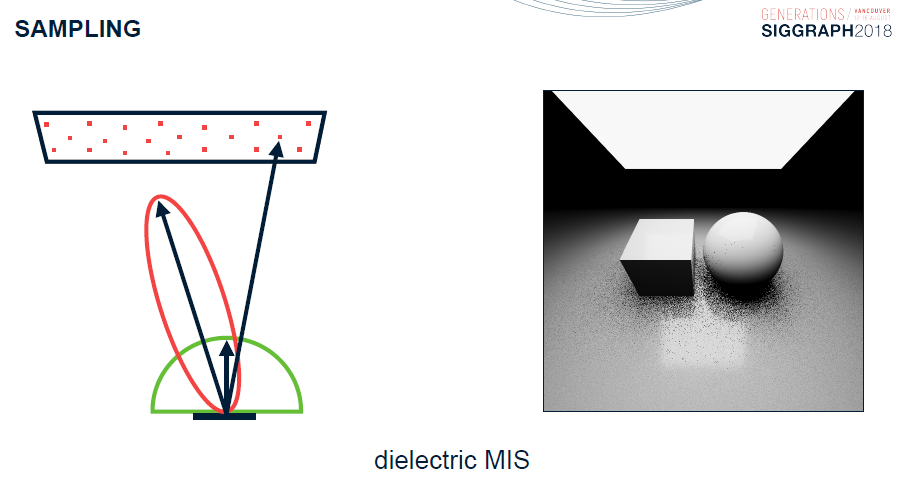

更進一步的,存在多重要性取樣(Multiple Important Sampling,MIS),以便同時考量光源、BRDF、PDF等因素的影響,對取樣的方向和位置等有所偏倚。

多重要性取樣公式:

\]

其中:\(n_k\)是從某個 PDF 中提取的樣本數\(p_k\),加權函數\(w_k\)採用可能生成樣本的所有不同方式,並且\(w_k\)可以通過冪啟發式計算:

\]

除了以上方式,還有方差、域扭曲、准隨機序列、低差異、分層等等取樣方式。准蒙特卡羅(QMC)的特點是確定性、低差異序列/集合(Halton、Hammersley、Larcher-Pillichshammer)比隨機的收斂速度更好,例如Sobol或(0-2)序列不需要知道樣本數量,奇妙的分層特性。

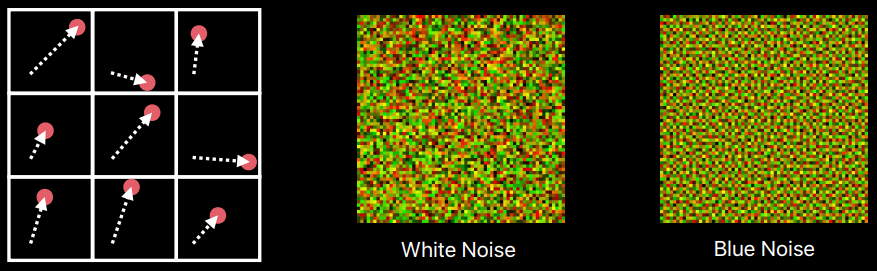

若是繼續拓廣之,可以以任意形狀任意數量的tap去取樣,如雙邊、藍雜訊、棋盤、星狀等,或者它們之間的結合:

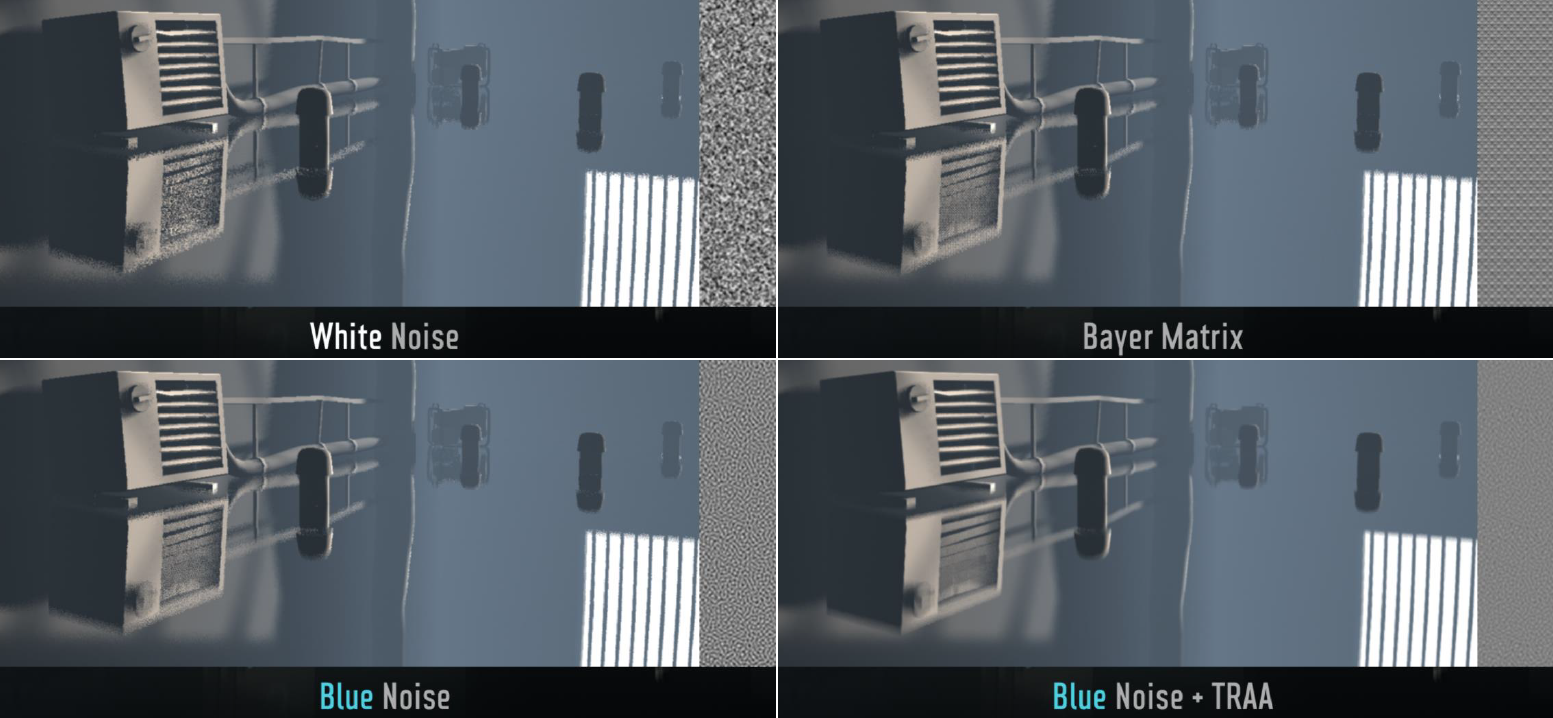

為了避免階梯式瑕疵,Inside使用了隨機取樣(藍色噪點 + TRAA)。

雙邊上取樣的其中一種模式。

更有甚者,可以通過旋轉、升至更高維度以獲得更多樣本和低噪點:

總之,目前存在諸多取樣方式,目的都是為了讓光線追蹤更快地收斂到準確結果,從而降低噪點,提升渲染性能。

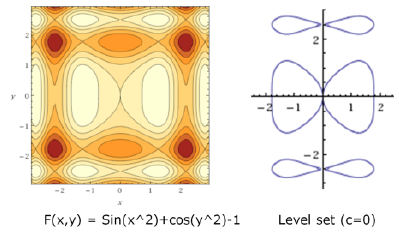

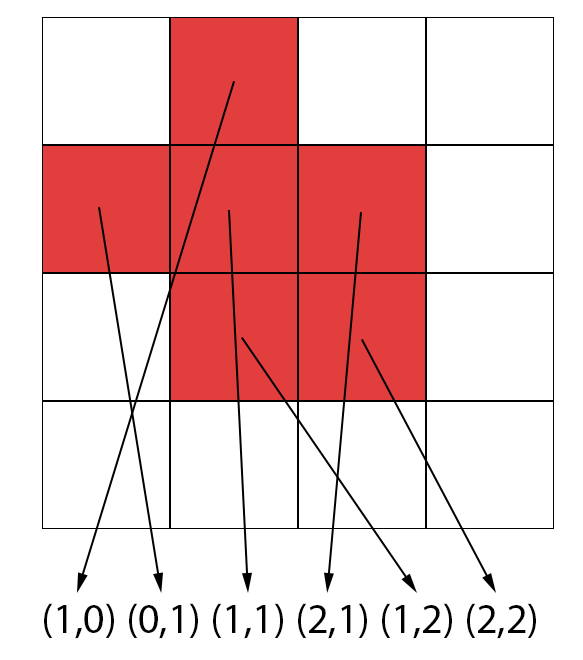

17.2.5 體素化

對於任意連續的函數\(f(x, y, z)\),隱式地將體積定義為\(f(x, y, z) > 0\),表面是\(f(x, y, z) = 0\)的水平集。

只需要一個連續的函數,任意的代數函數、有向距離場(CSG樹,在網格三線性取樣)、密度函數(在網格三線性取樣)。

使用密度(Density)要容易得多(局部更改),但在距離場上的一些有用操作(如放大、縮小體積、更高品質的漸變計算)上會失敗,可以將密度視為距離場,夾緊距離約為一個取樣單元格。

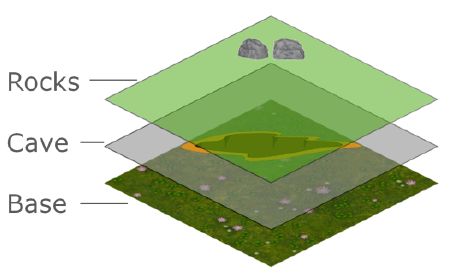

將隱式曲面或參數化網格體素化的過程:

1、在網格上取樣。

2、近似每個單元格中的表面。

3、確保表面與單元邊界對齊。

體素化的理想特徵是易於實現、局部獨立、平滑、自適應/適合LOD、最小化三角形條形、保留銳利和薄的特徵。

對於簡單的立方體,在每個網格單元的中心取樣\(f(x, y, z)\),在具有不同符號的單元格之間繪製一個面。

這種表達方式在體素化的理想特徵的優劣如下表:

| 易於實現 | 局部獨立 | 平滑 | 自適應LOD | 最小化三角形 | 銳利 | 薄 |

|---|---|---|---|---|---|---|

| ++ | + | – | – | + | – | – |

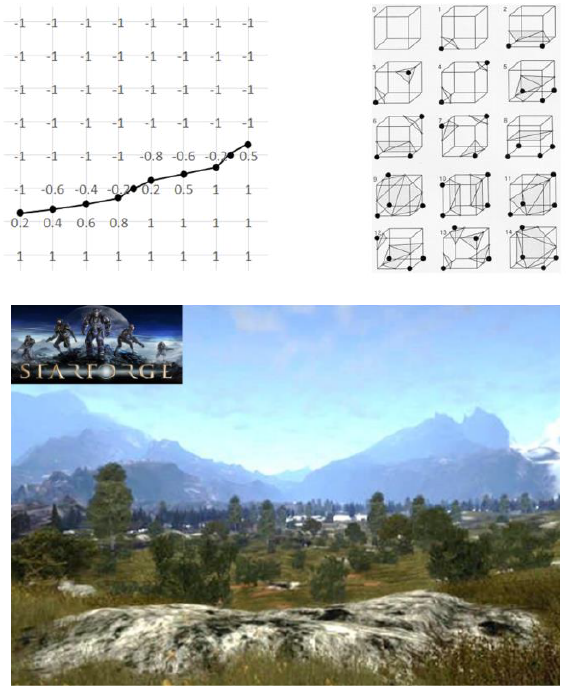

步進立方體(Maring Cube):在每個單元格的角落取樣\(f(x, y, z)\),在三角形拓撲中使用角的符號,沿著邊緣在插值的0點處定位頂點。

這種表達方式在體素化的理想特徵的優劣如下表:

| 易於實現 | 局部獨立 | 平滑 | 自適應LOD | 最小化三角形 | 銳利 | 薄 |

|---|---|---|---|---|---|---|

| + | + | + | – | – | – | – |

超體素(transvoxel)演算法:在每個單元格的角落取樣\(f(x, y, z)\),允許細分一次單元格的邊(以縫合相鄰的LOD級別),為三角形拓撲使用取樣點的符號,沿邊在插值的0點處定位頂點。

Transvoxel是一種允許行進立方體跨越不同LOD級別的方法。總共71種拓撲方式,用於處理任意邊組合的細分。

這種表達方式在體素化的理想特徵的優劣如下表:

| 易於實現 | 局部獨立 | 平滑 | 自適應LOD | 最小化三角形 | 銳利 | 薄 |

|---|---|---|---|---|---|---|

| + | + | + | + | – | – | – |

雙重輪廓(Dual Contour):在每個單元格的角落取樣\(f(x, y, z)\),在每個邊交叉點位置取樣\(f'(x, y, z)\),在輪廓上的每個單元格內找到一個理想點,連接相鄰單元格的兩點(支援多個LOD解析度)。

這種表達方式在體素化的理想特徵的優劣如下表:

| 易於實現 | 局部獨立 | 平滑 | 自適應LOD | 最小化三角形 | 銳利 | 薄 |

|---|---|---|---|---|---|---|

| – | – | + | + | + | + | ~ |

雙重行進立方體(Dual Marching Cube):在精細網格上取樣\(f(x, y, z)\),找出誤差最小的點(QEF),如果誤差 > $\varepsilon $,則在該點細分八叉樹。重複前面的步驟,直到索引的誤差 < \(\varepsilon\)。構造此八叉樹的拓撲對偶(topological dual),當成雙重輪廓曲面細分之。

這種表達方式在體素化的理想特徵的優劣如下表:

| 易於實現 | 局部獨立 | 平滑 | 自適應LOD | 最小化三角形 | 銳利 | 薄 |

|---|---|---|---|---|---|---|

| – | – | + | + | + | + | + |

立方體行進正方體(Cubical Marching Square):構建一個帶有誤差細分的八叉樹(類似於DMC),對於任何體素(在任何八叉樹級別):展開體素,分別觀察每一側;使用行進立方體創建曲線,如果出現誤差,則進行細分;將兩邊摺疊在一起,形成三角形。

| 易於實現 | 局部獨立 | 平滑 | 自適應LOD | 最小化三角形 | 銳利 | 薄 |

|---|---|---|---|---|---|---|

| – | + | + | + | + | + | + |

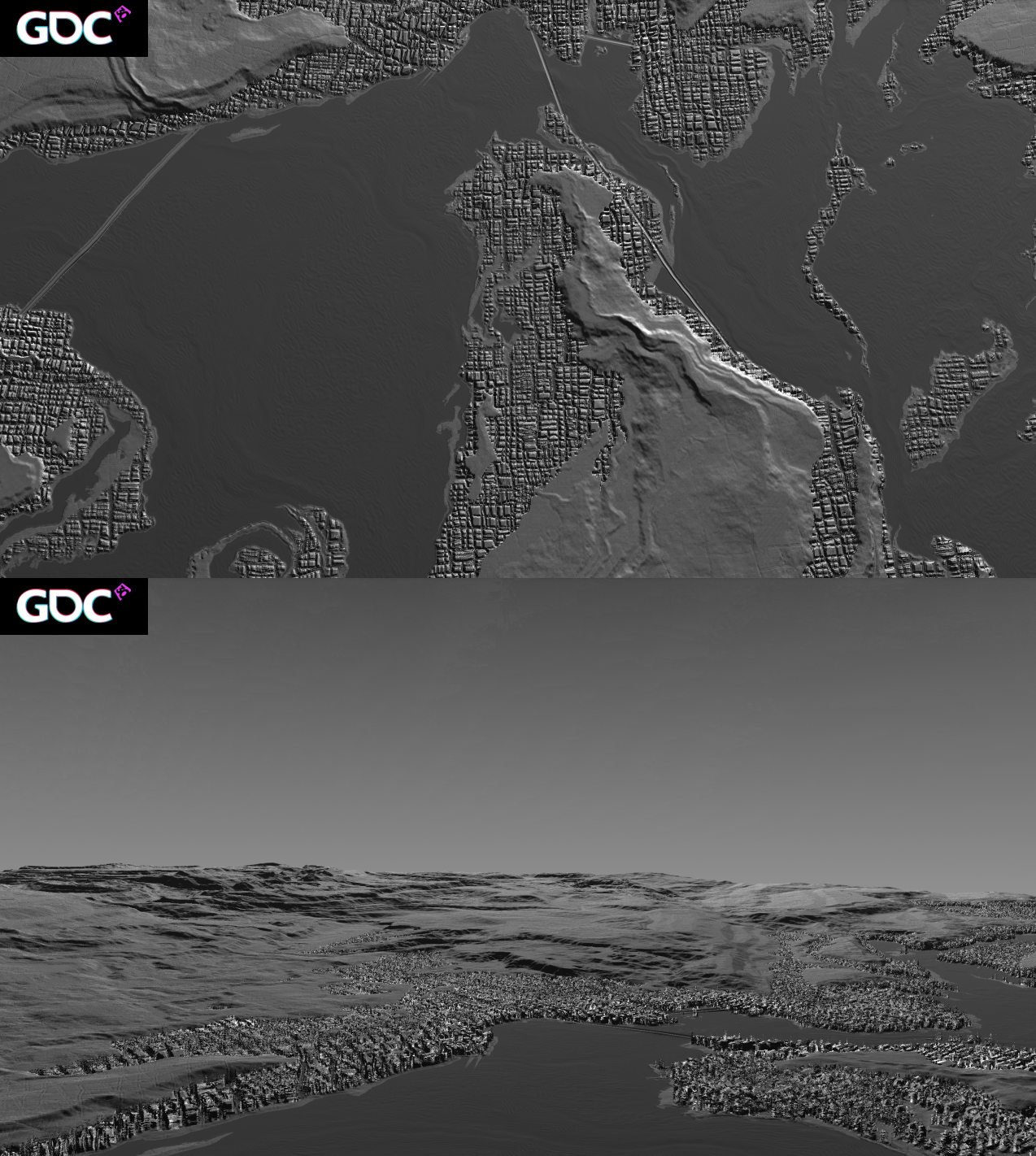

Windborne的體素化概覽:\(F(x, y, z)\) = 合成的、軸對齊的密度網格,每個塊(chunk)都有重疊的特徵列表,在計算時,使用布爾運算累積到塊。

組合時,每個特徵都是一個層,每一層要麼減去,要麼疊加,Alpha混合密度:\(\alpha_a + \alpha_b (1-\alpha_a)\)。

除了組合,還有減去、疊加、並集、輪廓指示器、網格密度(可用於動態光照,如光流、AO)、暴露參數、利用特徵等等操作或應用。

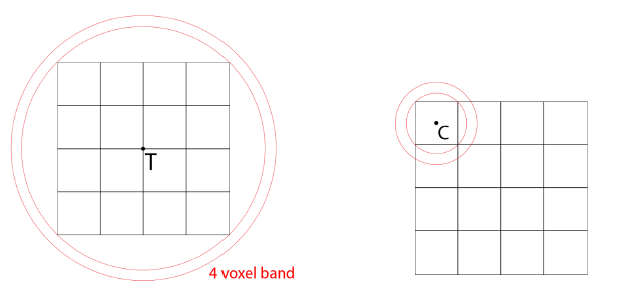

17.2.6 有向距離場

有向距離場(SDF)是函數SDF(P)到P處最近表面的有符號距離,有解析距離函數和體積紋理兩種形式。

- 解析距離函數流行於場景demo中,巨大的著色器,很多數學知識,沒有數據。

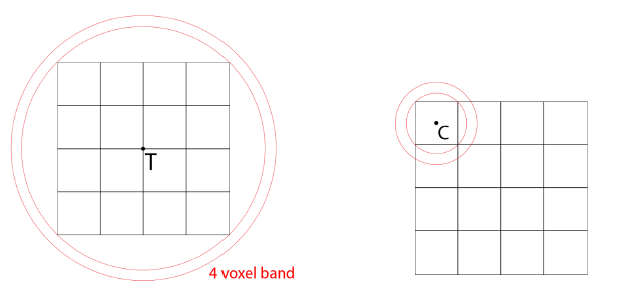

- 體積紋理存儲距離函數,使用三線性過濾。遊戲Claybook將體積紋理與mip貼圖結合使用,世界SDF的解析度=1024x1024x512,格式=8位有符號,大小=586 MB(5 mip級別),[-4,+4]體素的距離,256個值/8個體素,1/32體素精度,每mip級別最大步進(世界空間)翻倍。

Claybook在GPU上生成世界SDF的步驟:

-

生成SDF筆刷網格。64x64x32的dispatch,4x4x4的執行緒組。

- 在分塊中心T處取樣刷子體積。如果SDF>光柵分塊邊界+4個體素,則剔除。如果接受,原子添加+存儲到GSM。

- 通過GSM中的筆刷循環。細胞中心C處的樣本[i],如果接受,存儲到網格(線性),局部+全局原子壓縮。

-

生成調度坐標。64x64x32的調度,4x4x4的執行緒組。

- 讀取刷子網格單元。

- 如果不是空的:原子加法(L+G)得到寫索引,將單元格坐標寫入緩衝區。

-

生成Mip掩碼。4x調度(mips),4x4x4的執行緒組。

- 分組:載入1個更寬的體素網格L-1鄰域,下取樣1=0掩碼並存儲到GSM。

- 將掩碼放大1個體素(3x3x3)。

- 掩碼=0則寫入網格單元坐標。

-

在8x8x8的tile中生成0級(稀疏)。間接調度,8×8的執行緒組。

- 分組:讀取網格單元坐標(SV_GroupId)。

- 從網格讀取筆刷並存儲到GSM。

- 通過GSM中的筆刷循環,取樣[i],執行exp平滑最小/最大操作。

- 將體素寫入WorldSDF的級別0。

-

生成mips(稀疏)。4倍間接調度(mips),8×8的執行緒組。

- 分組:載入更寬的L-1鄰域的4個體素。2x2x2下取樣(平均值)並在GSM中存儲為123123,+-4體素帶變成+-2體素階(band)。

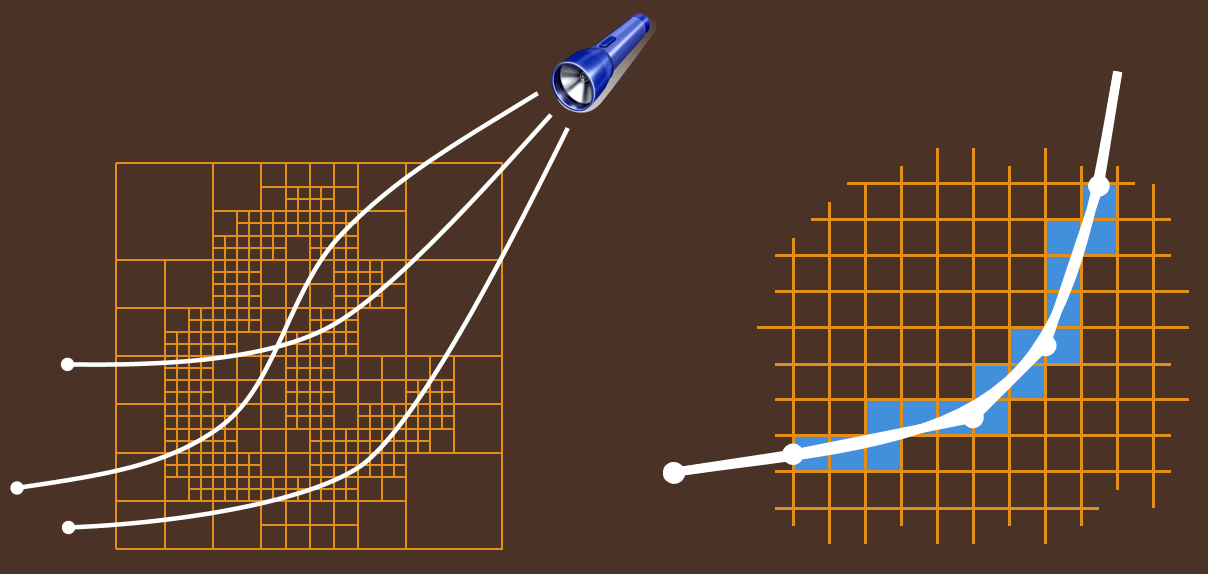

- 分組:在GSM中運行3步eikonal方程(下圖),擴展階:2個體素變成4個體素。

- 存儲8x8x8鄰域的中心。

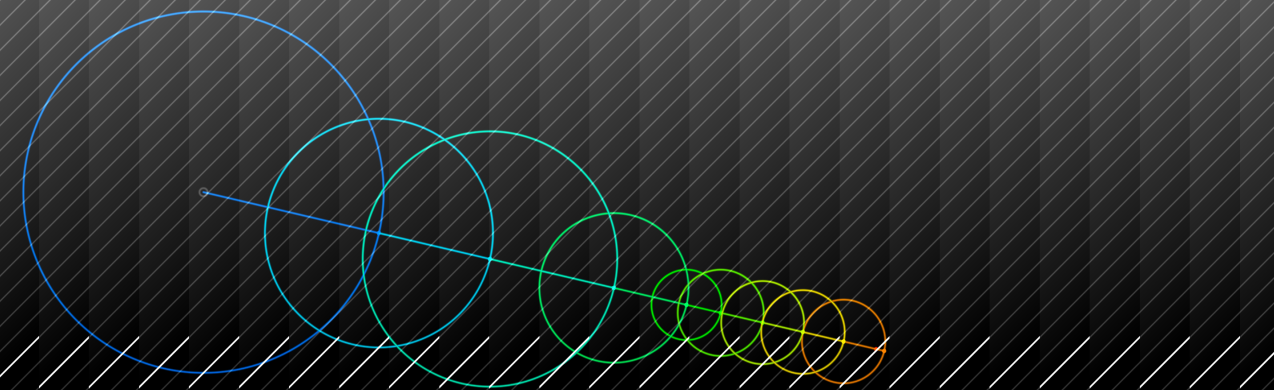

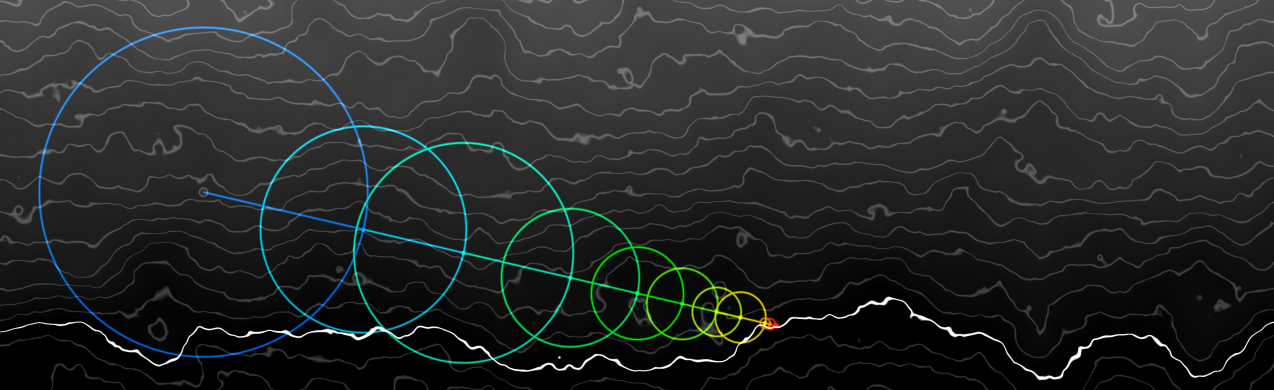

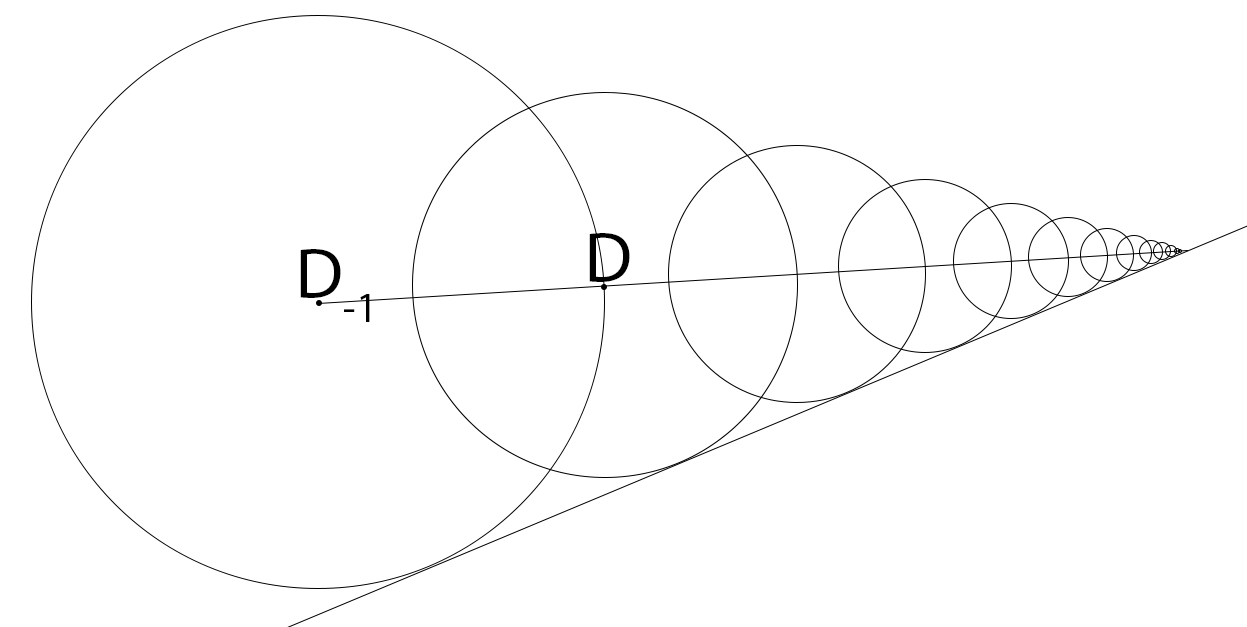

球體追蹤演算法:

- D = SDF(P)。

- P += ray * D。

- if (D < epsilon) break。

多層體紋理追蹤:

Loop

D = volume.SampleLevel(origin + ray*t, mip)

t += worldDistance(D, mip)

IF D == 1.0 -> mip += 2

IF D <= 0.25 -> mip -= 2; D -= halfVoxel

IF D < pixelConeWidth * t -> BREAK

// 如果曲面位於像素內邊界圓錐體內,則中斷,獲得完美的LOD!

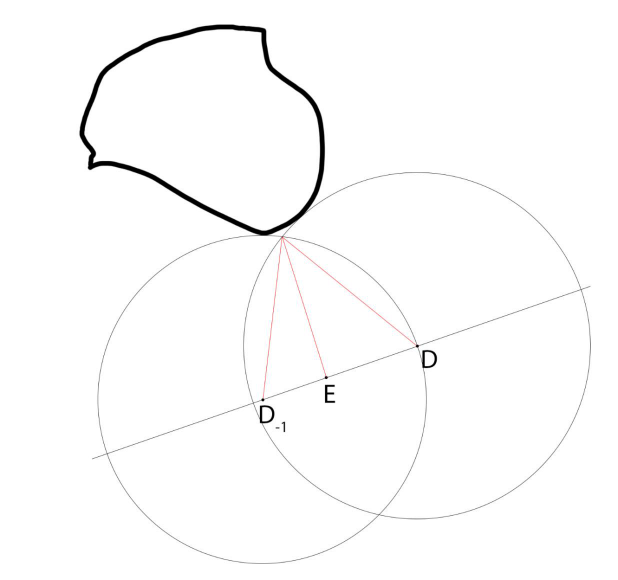

最後一步:球體追蹤需要無限步才能收斂,假設我們碰到一個*面,三線性過濾=分段線性曲面,幾何級數,使用最後兩個樣本,Step=D/(1−(D−D−1))Step=D/(1−(D−D−1))。

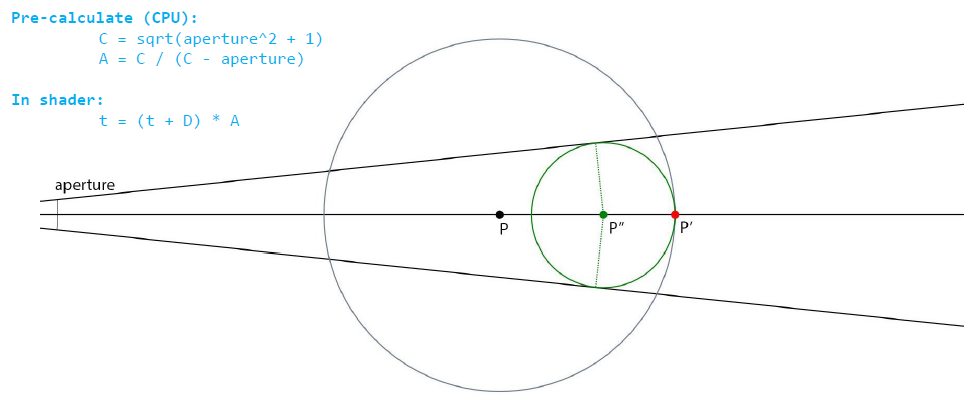

錐體追蹤解析解:

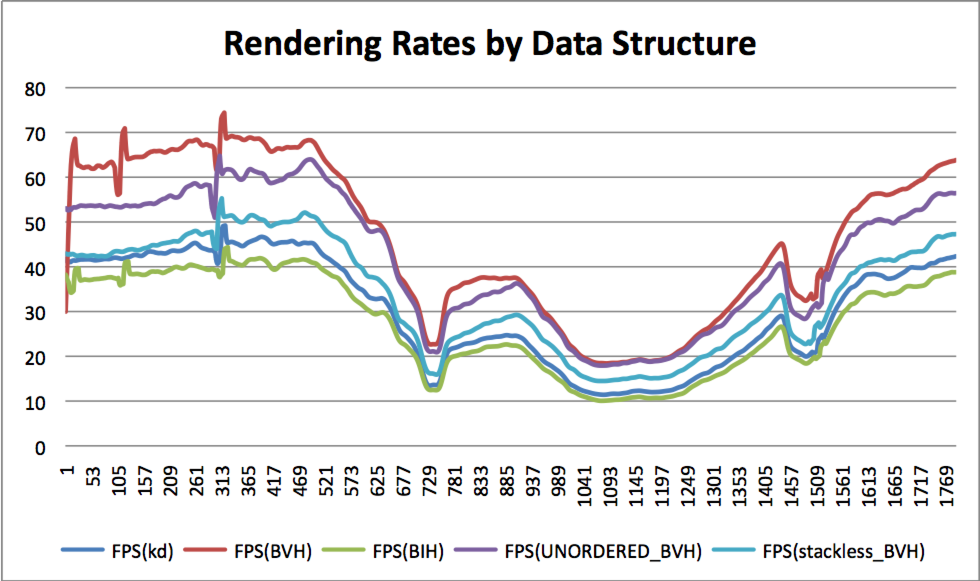

粗糙錐體追蹤Prepass:

錐形追蹤可以跳過大面積的空白空間,大幅縮短步長,體積取樣更多快取局部性。Mip映射改善快取的局部性,Log8數據縮放:100%、12.5%、1.6%、0.2%…測量(1080p渲染),訪問8MB數據(512MB),99.85%的快取命中率。存在的問題有過步進(Overstepping)、載入平衡等,它們有各自的緩解方案。

17.3 光線追蹤技術

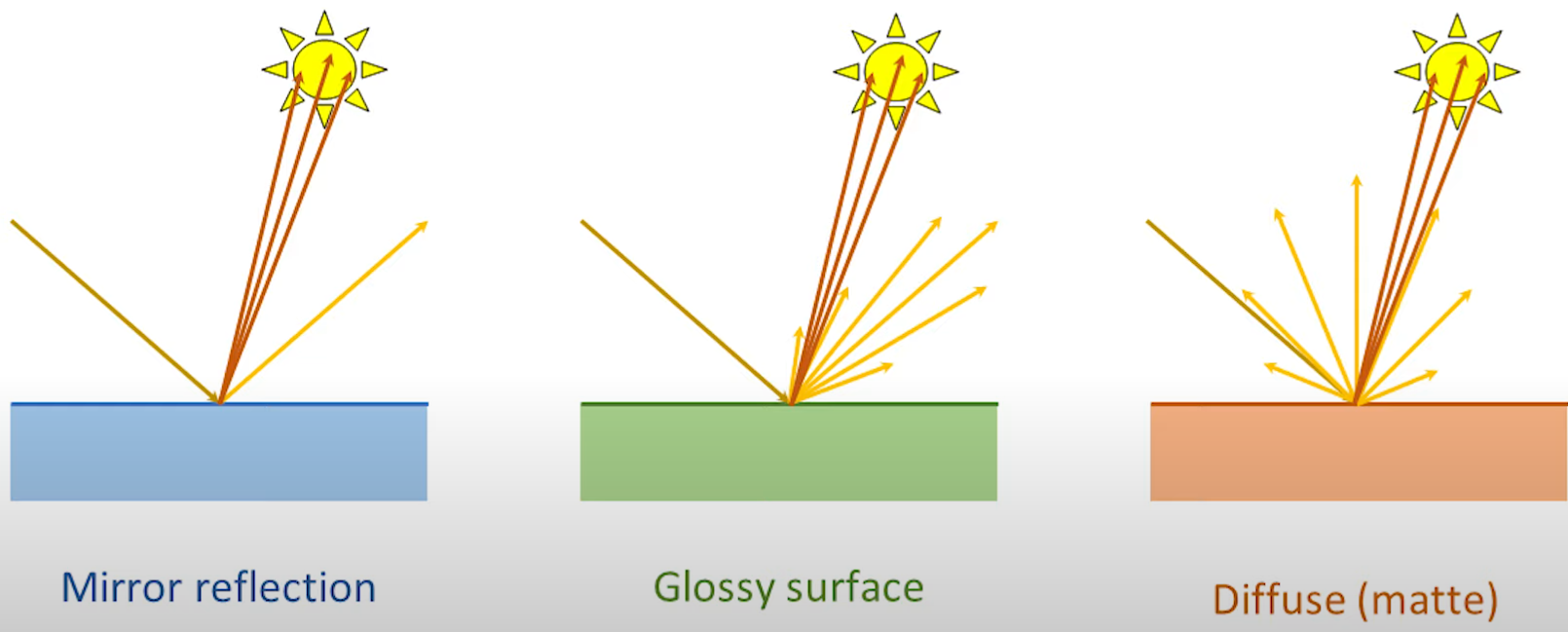

在幾何光學中,可以忽略光線的波動性而直接簡化成直線,從而研究光線的物理特性。同樣地,在電腦圖形學,也可以利用這一特點,以簡化光照著色過程。

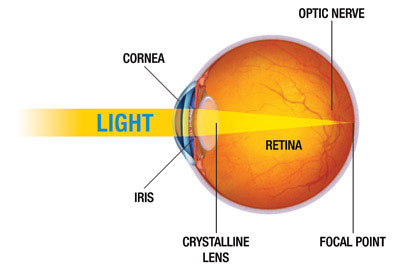

此外,人類的眼睛接收到的光照資訊是有限的像素,大多數人的眼睛在5億像素左右。人類接收到的影像資訊可以分拆成5億個像素,也就是說,可以分拆成5億條非常微小的光線,以相反的方式去逆向追蹤這些光線,就可以檢測出這些光線對應的場景物體的資訊(位置、朝向、表明材質、光照顏色和亮度等等)。

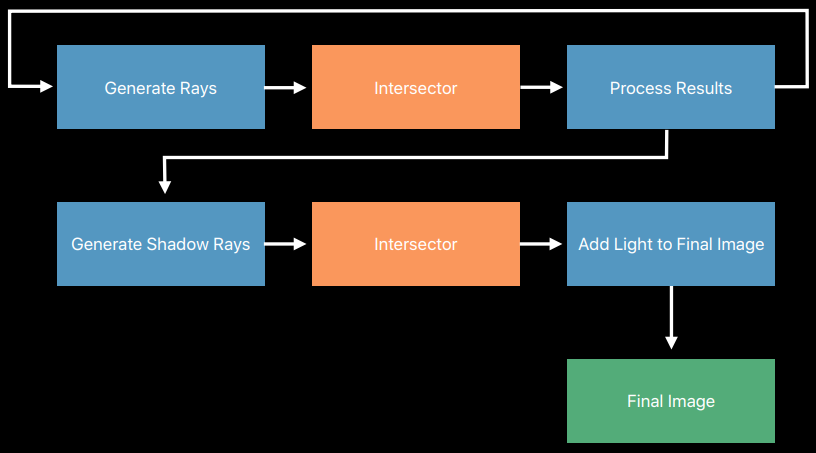

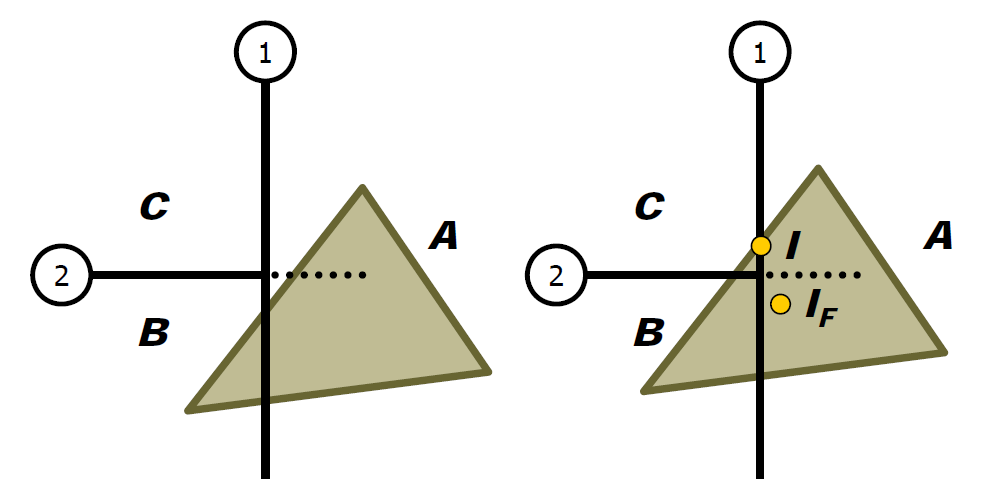

光線追蹤技術就是利用以上的物理原理衍生出來。將眼睛抽象成攝像機,視網膜抽象成顯示器幕,5億個像素簡化成螢幕像素,從攝像機位置與螢幕的每個像素連成一條射線,去追蹤這些射線與場景物體交點的光照資訊。當然,實際的光線追蹤演算法會更加複雜,光線追蹤的偽程式碼:

for each pixel do

compute ray for that pixel

for each object in scene do

if ray intersects object and intersection is nearest so far then

record intersection distance and object color

set pixel color to nearest object color (if any)

每個像素都會發出一條光線,該演算法計算出哪個物體首先被光線擊中,以及光線擊中物體的確切點。這個點被稱為第一個交點,演算法在這裡做了兩件事:

-

估計交點處的入射光。要估計入射光在第一個交點處的樣子,演算法需要考慮該光從何處反射或折射。

-

將入射光的資訊與被擊中物體的資訊相結合。關於每個對象的特定資訊很重要,因為對象並不都具有相同的屬性——它們以不同的方式吸收、反射和折射光:

- 不同的吸收方式導致物體具有不同的顏色(例如,葉子是綠色的,因為它吸收了除綠光以外的所有光)。

- 不同的反射率會導致一些物體發出鏡面反射,而其他物體會向各個方向散射光線。

- 不同的折射率導致某些物體(如水)比其他物體更扭曲光線。

通常,為了估計第一交叉點處的入射光,演算法必須將該光線追蹤蹤到第二交叉點(因為擊中物體的光可能已被另一物體反射),甚至更遠。有時發出的光線不會擊中任何東西,這就是第一種邊緣情況,我們可以通過測量光線傳播的距離來輕鬆覆蓋,這樣我們就可以對傳播太遠的光線進行額外的處理。第二種邊緣情況涵蓋了相反的情況:光線可能會反彈太多,從而減慢演算法速度,或者無限次,導致無限循環。該演算法追蹤光線在每一步後被追蹤的次數,並在一定次數的反射後終止。我們可以證明這樣做是合理的,因為現實世界中的每個物體都會吸收一些光,甚至是鏡子。這意味著光線每次被反射時都會失去能量(變得更弱),直到它變得太弱而無法察覺。因此,即使我們可以,追蹤光線任意次數也沒有意義。

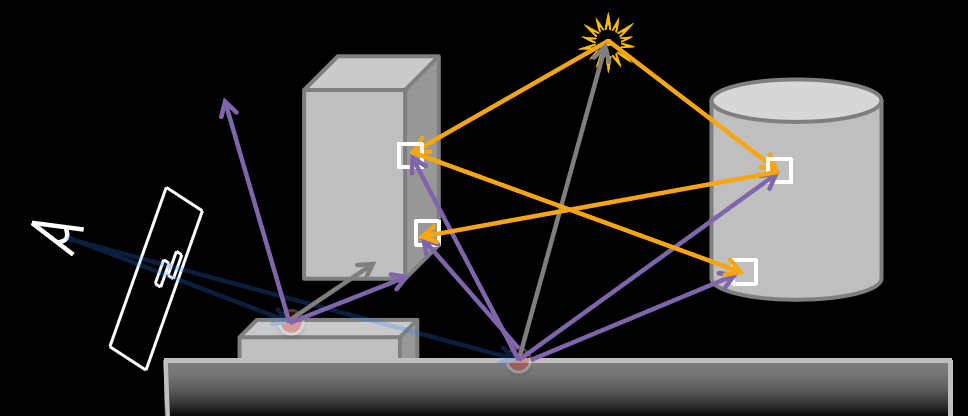

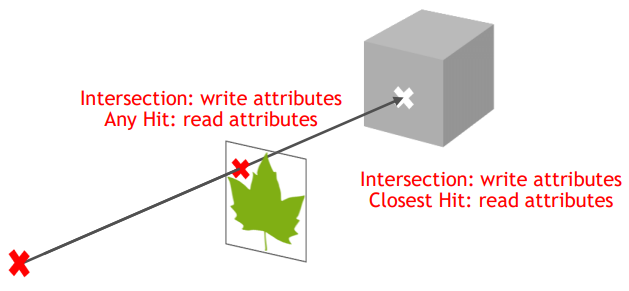

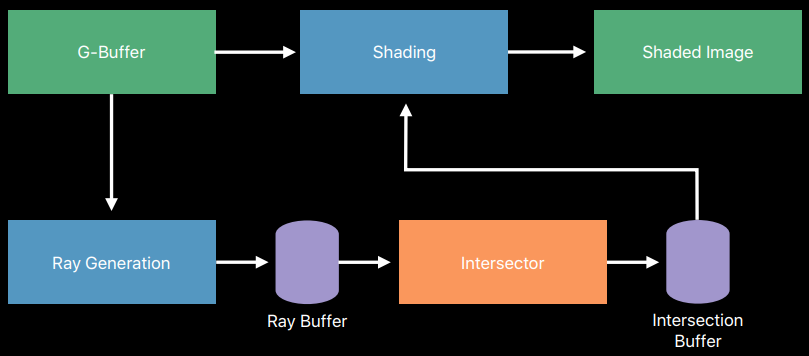

與傳統的光柵化渲染技術相比,光線追蹤的演算法過程還是比較明晰的。以視點為起點,向場景發射N條光線,然後根據碰撞點的材質進行BXDF、BRDF的運算,然後再進行漫反射、鏡面反射或者折射,如此遞歸循環直到光線逃離場景或者到達最大反射次數,最後對N條光線進行蒙特卡洛積分即可獲得結果。

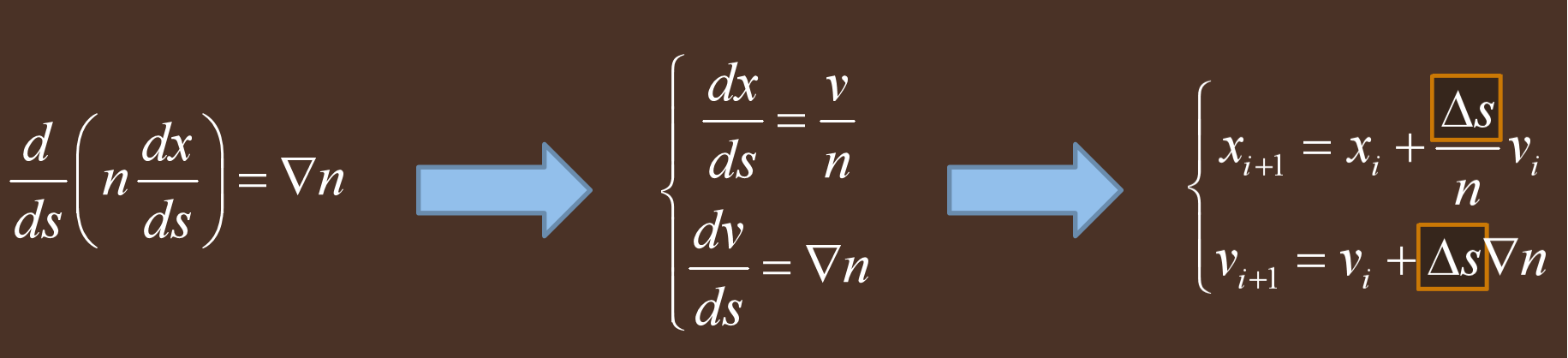

結合上圖,可以將光線追蹤的演算法過程抽象成以下偽程式碼:

遍歷螢幕的每個像素 {

創建從視點通過該像素的光線

初始化 最近T 為 無限大,最近物體 為 空值

遍歷場景中的每個物體 {

如果光線與物體相交 {

如果交點處的 t 比 最近T 小 {

設置 最近T 為交點的 t 值

設置 最近物體 為該物體

}

}

}

如果 最近物體 為 空值{

用背景色填充該像素

} 否則 {

對每個光源射出一條光線來檢測是否處在陰影中

如果表面是反射面,生成反射光,並遞歸

如果表面透明,生成折射光,並遞歸

使用 最近物體 和 最近T 來計算著色函數

以著色函數的結果填充該像素

}

}

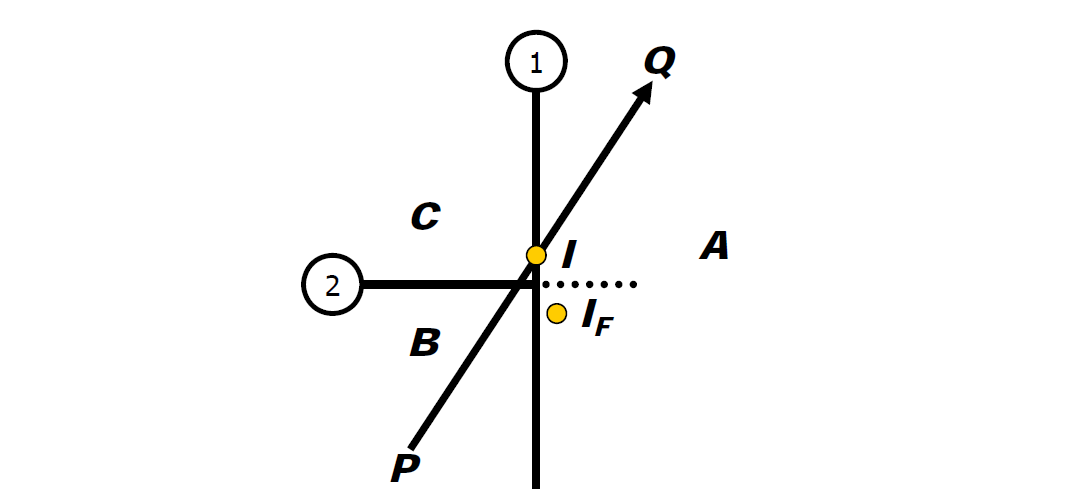

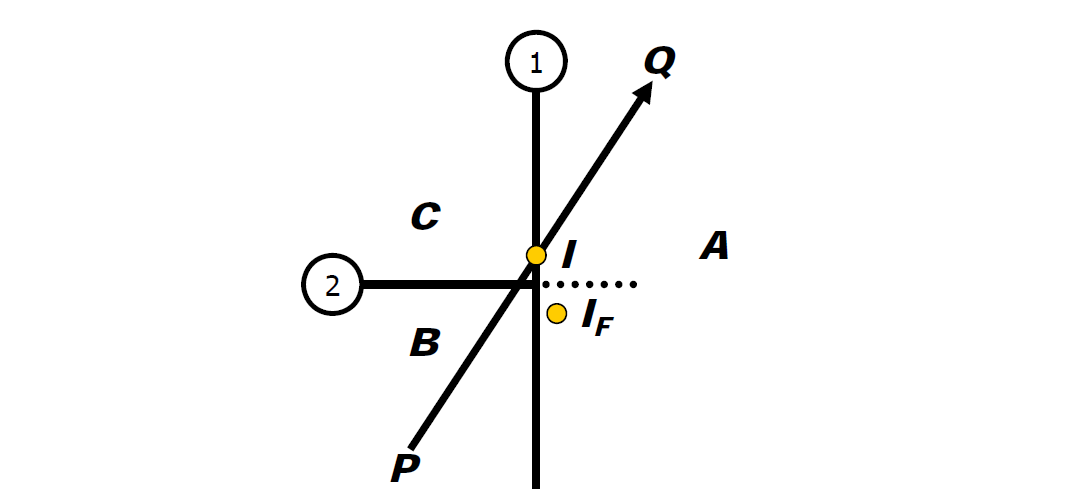

上述偽程式碼中涉及的著色函數可採用任意光照模型,可以是Lambert、Phong、Blinn-Phong、BRDF、BTDF、BSDF、BSSRDF等等。若是更近一步,用電腦語言形式的偽程式碼描述,則光線追蹤的計算過程如下:

-- 遍歷影像的所有像素

function traceImage (scene):

for each pixel (i,j) in image S = PointInPixel

P = CameraOrigin

d = (S - P) / || S – P||

I(i,j) = traceRay(scene, P, d)

end for

end function

-- 追蹤光線

function traceRay(scene, P, d):

(t, N, mtrl) ← scene.intersect (P, d)

Q ← ray (P, d) evaluated at t

I = shade(mtrl, scene, Q, N, d)

R = reflectDirection(N, -d)

I ← I + mtrl.kr ∗ traceRay(scene, Q, R) -- 遞歸追蹤反射光線

-- 區別進入介質的光和從介質出來的光

if ray is entering object then

n_i = index_of_air

n_t = mtrl.index

else n_i = mtrl.index

n_i = mtrl.index

n_t = index_of_air

end if

if (mtrl.k_t > 0 and notTIR (n_i, n_t, N, -d)) then

T = refractDirection (n_i, n_t, N, -d)

I ← I + mtrl.kt ∗ traceRay(scene, Q, T) -- 遞歸追蹤折射光線

end if

return I

end function

-- 計算所有光源對像素的貢獻量(包含陰影)

function shade(mtrl, scene, Q, N, d):

I ← mtrl.ke + mtrl. ka * scene->Ia

for each light source l do:

atten = l -> distanceAttenuation( Q ) * l -> shadowAttenuation( scene, Q )

I ← I + atten*(diffuse term + spec term)

end for

return I

end function

-- 此處只計算點光源的陰影,不適用其它類型光源的陰影

function PointLight::shadowAttenuation(scene, P)

d = (l.position - P).normalize()

(t, N, mtrl) ← scene.intersect(P, d)

Q ← ray(t)

if Q is before the light source then:

atten = 0

else

atten = 1

end if

return atten

end function

上述distanceAttenuation的介面中,通常還涉及到BRDF的光照積分,但是在實時渲染領域,要對每個相交點做一次積分是幾乎不可能的。於是可以引入蒙特卡洛積分和重要性取樣(可參看《由淺入深學習PBR的原理及實現》的章節5.4.2.1 蒙特卡洛(Monte Carlo)積分和重要性取樣(Importance sampling)),以局部取樣估算整體光照積分。

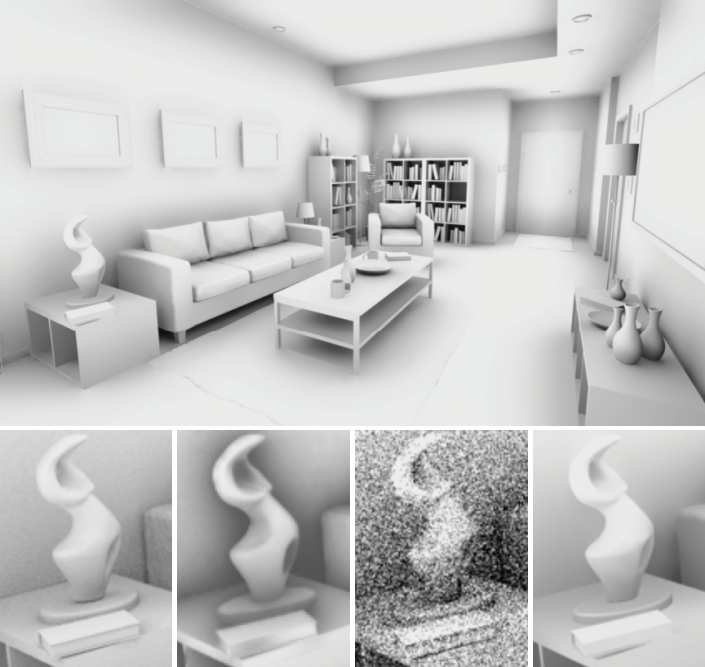

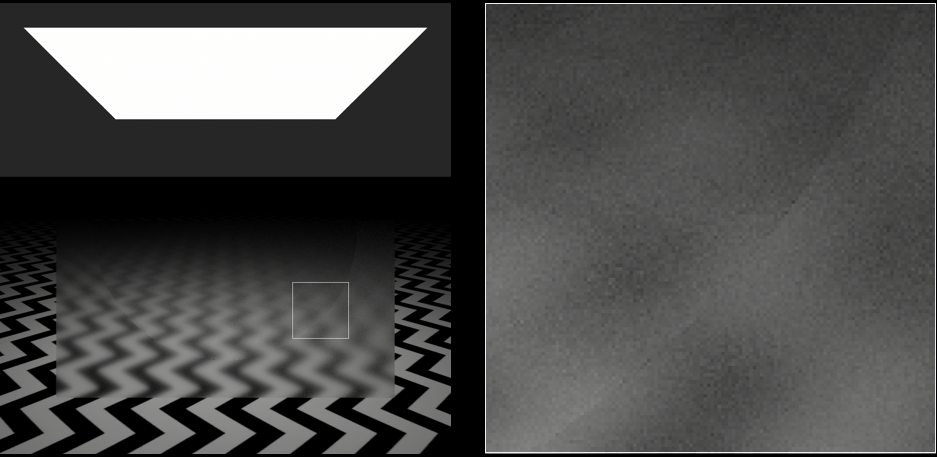

當然,引入這個方法,如果取樣數量不夠多,會造成光照貢獻量與實際值偏差依然會很大,形成噪點。隨著取樣數量的增加,局部估算越來越接近實際光照積分,噪點逐漸消失(下圖)。

從左到右分別對應的每個象素取樣為1、16、256、4096、65536。

在每個像素內部,可以使用偏移來生成追蹤像素,從而獲得更準確且帶抗鋸齒的渲染效果。

結合了蒙特卡羅積分和重要性取樣的光線追蹤技術,也被稱為路徑追蹤(Path tracing)。

17.3.1 光線追蹤方式

17.3.1.1 遞歸光線追蹤

當光線擊中具有鏡面反射或折射的表面時,計算那裡的顏色可能需要追蹤更多光線——分別稱為反射光線和折射光線。這些光線可能會擊中其他鏡面反射表面,導致更多光線被追蹤,由此有了術語——遞歸光線追蹤(Recursive ray tracing)。下圖顯示了反射光線的遞歸「樹」,這種技術也被稱為經典光線追蹤或惠特式光線追蹤,因為它是由特納·惠特於1980年引入的。

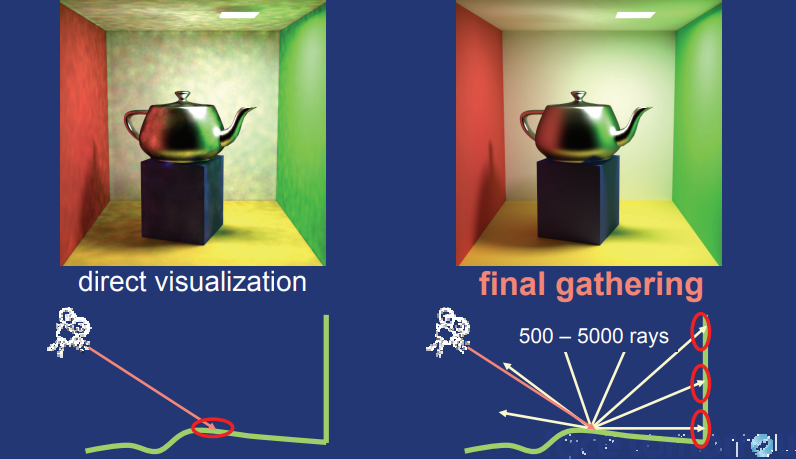

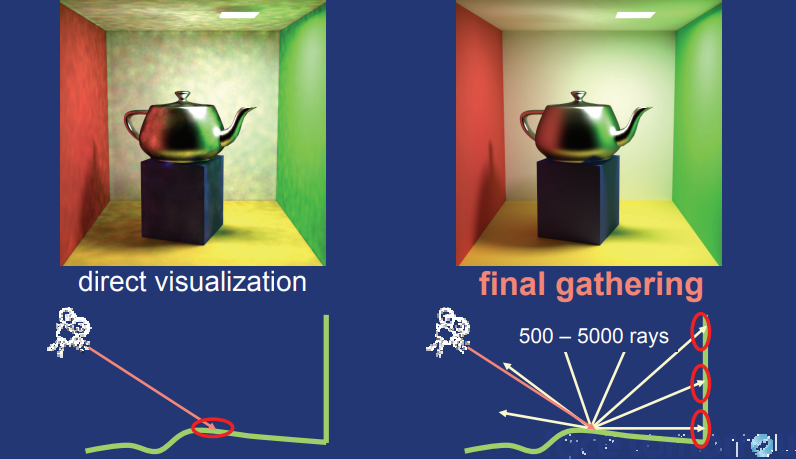

遞歸式的光線追蹤通常在最後階段需要一個最終收集(Final gathering)——從粗略的GI解決方案中讀取輻射度(Radiosity)或光子映射。

17.3.1.2 蒙特卡洛光線追蹤

蒙特卡洛光線追蹤(Monte Carlo ray tracing)也稱為隨機光線追蹤(Stochastic Ray Tracing),其中光線原點、方向或時間使用隨機數計算。蒙特卡羅射線追蹤通常分為兩類:分布光線追蹤(Distribution ray tracing)和路徑追蹤(Path tracing)。

分布光線追蹤從每個曲面點向取樣區域燈光、光澤和漫反射以及許多其他效果發射多條光線。下圖顯示了用於分布光線追蹤的反射和折射光線樹。如圖所示,分布光線追蹤在經過幾次反射後,光線數量易於爆炸;為了避免這種情況,通常在幾級反射後減少光線的數量。使用分布光線追蹤,很容易確保反射點處光線方向的良好分布,例如通過分層方向。

用於分布光線追蹤的反射和折射樹。

路徑追蹤是分布光線追蹤的一種變體,其中每個點僅發射一條反射和折射光線,避免了光線數量的爆炸,但簡單的實現會導致非常明顯噪點的影像。為了補償這一點,通過每個像素追蹤許多可見性光線。路徑追蹤的一個優點是,由於每個像素拍攝許多可見性光線,因此可以以很少的額外成本合併景深和運動模糊等相機效果。

另一方面,與分布光線追蹤相比,更難確保反射光線的良好分布(例如通過分層)。簡而言之,分布光線追蹤會在光線樹中向更深的位置發射最多光線,而路徑追蹤會發射最多可見性光線。

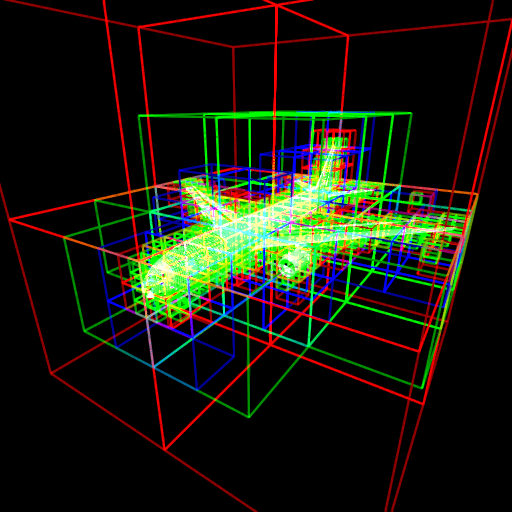

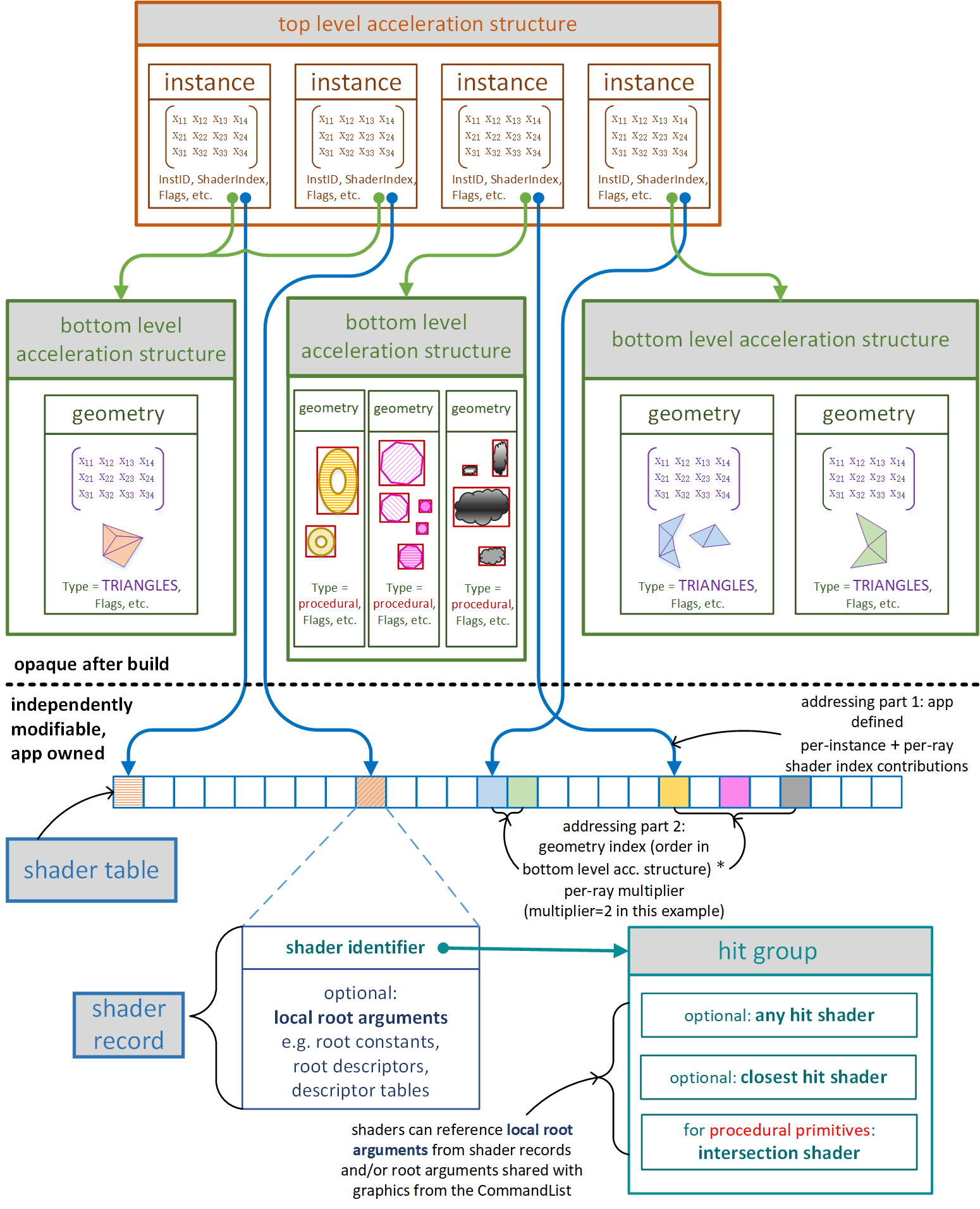

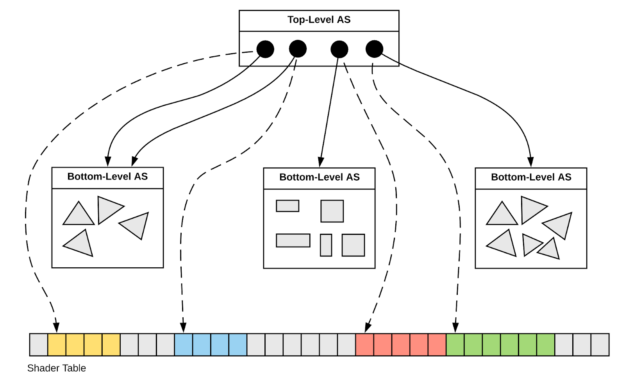

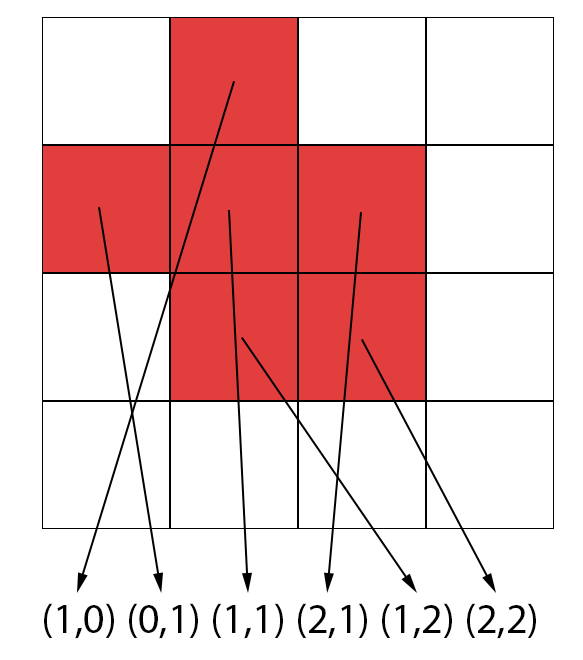

17.3.2 場景加速結構

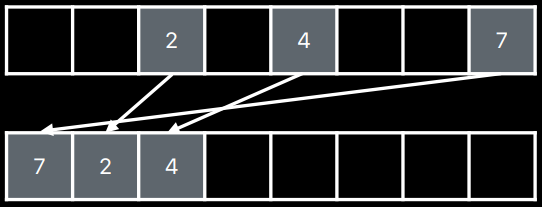

光線追蹤涉及的數據結構包含邊界體積層次結構(Bounding Volume Hierarchy,BVH)、無棧邊界體積層次結構(Stackless Bounding Volume Hierarchy,SBVH)、KD樹、邊界區間層次(Bounding Interval Hierarchy,BIH)等。

堆棧和無棧數據結構和記憶體布局對比圖。

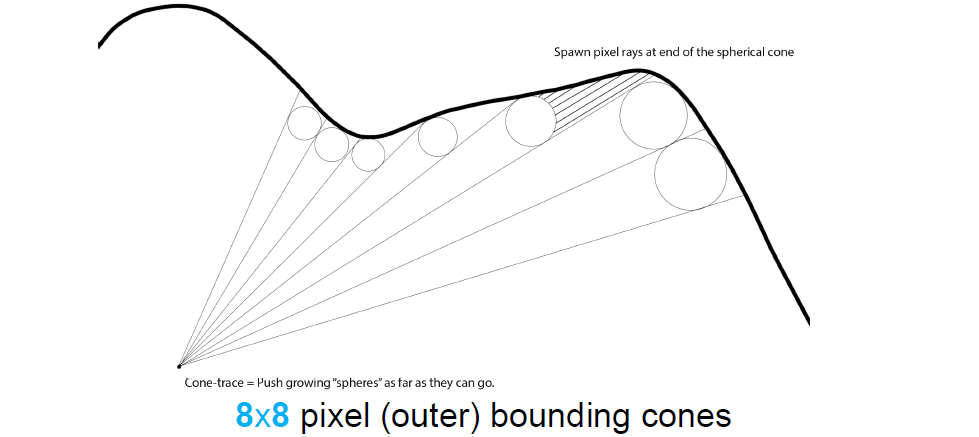

測試相同場景採用不同數據結構的時間曲線如下:

BVH優勢是可以矢量化測試,更好地處理空白空間,堆棧不是瓶頸。

17.3.2.1 BVH

對於複雜場景,測試每一個對象與每一條光線的交集將是毫無希望的低效。因此,我們將對象組織成一個層次結構,以便快速拒絕大部分對象。

加速度數據結構最重要的特徵是構造時間、記憶體使用和光線遍歷時間。根據應用,可能會對這些特性中的每一個給予不同的強調。對於影像序列的渲染(例如,用於互動式視覺化或用於電影的「快照」渲染),還需要選擇可以隨著增量幾何變化而有效更新的加速數據結構。

有一系列令人困惑的加速度數據結構:邊界體積層次結構、均勻網格、層次網格、BSP樹、kd樹、八叉樹、5D原點方向樹、邊界區間層次結構等。在這裡,我們將僅詳細描述一種加速度數據結構,即邊界體積層次。

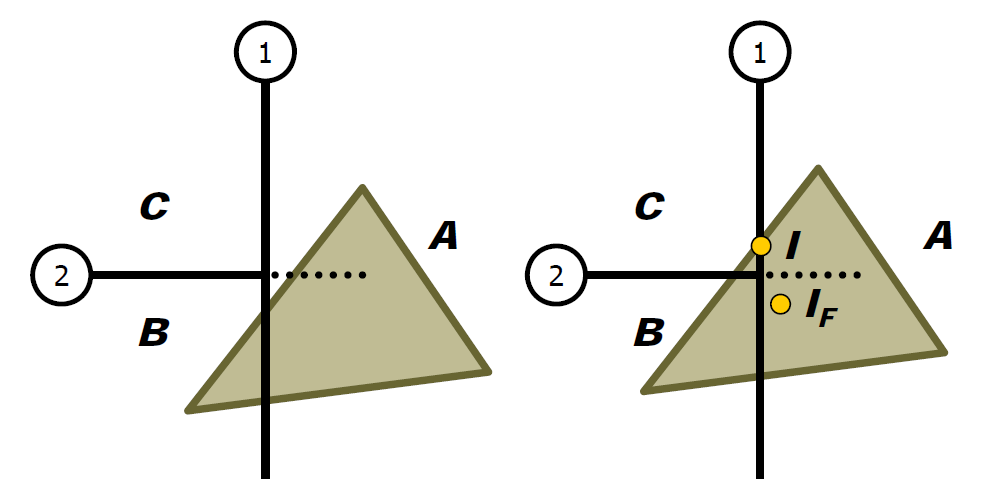

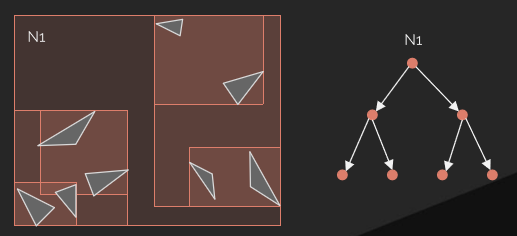

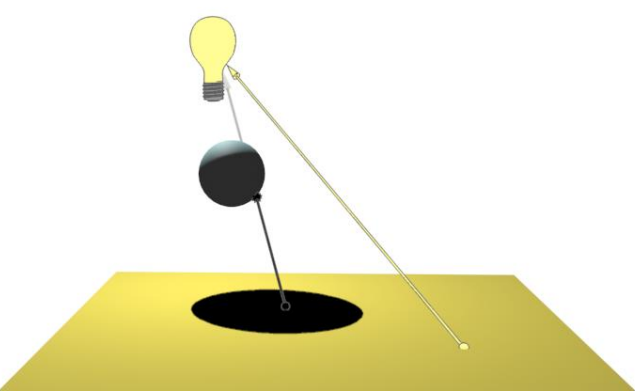

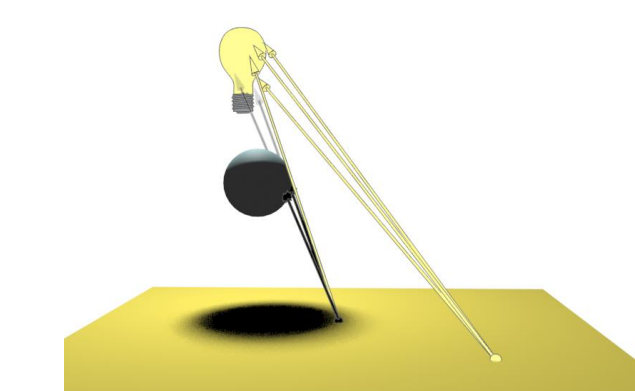

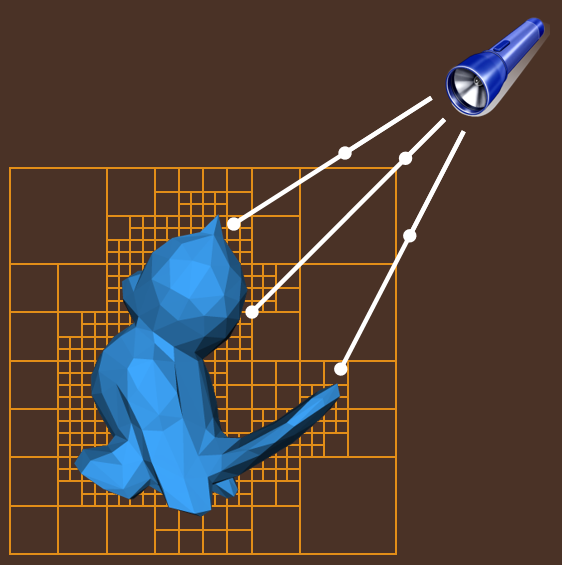

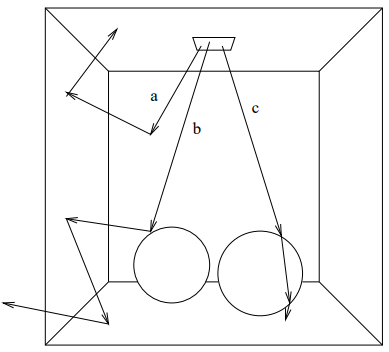

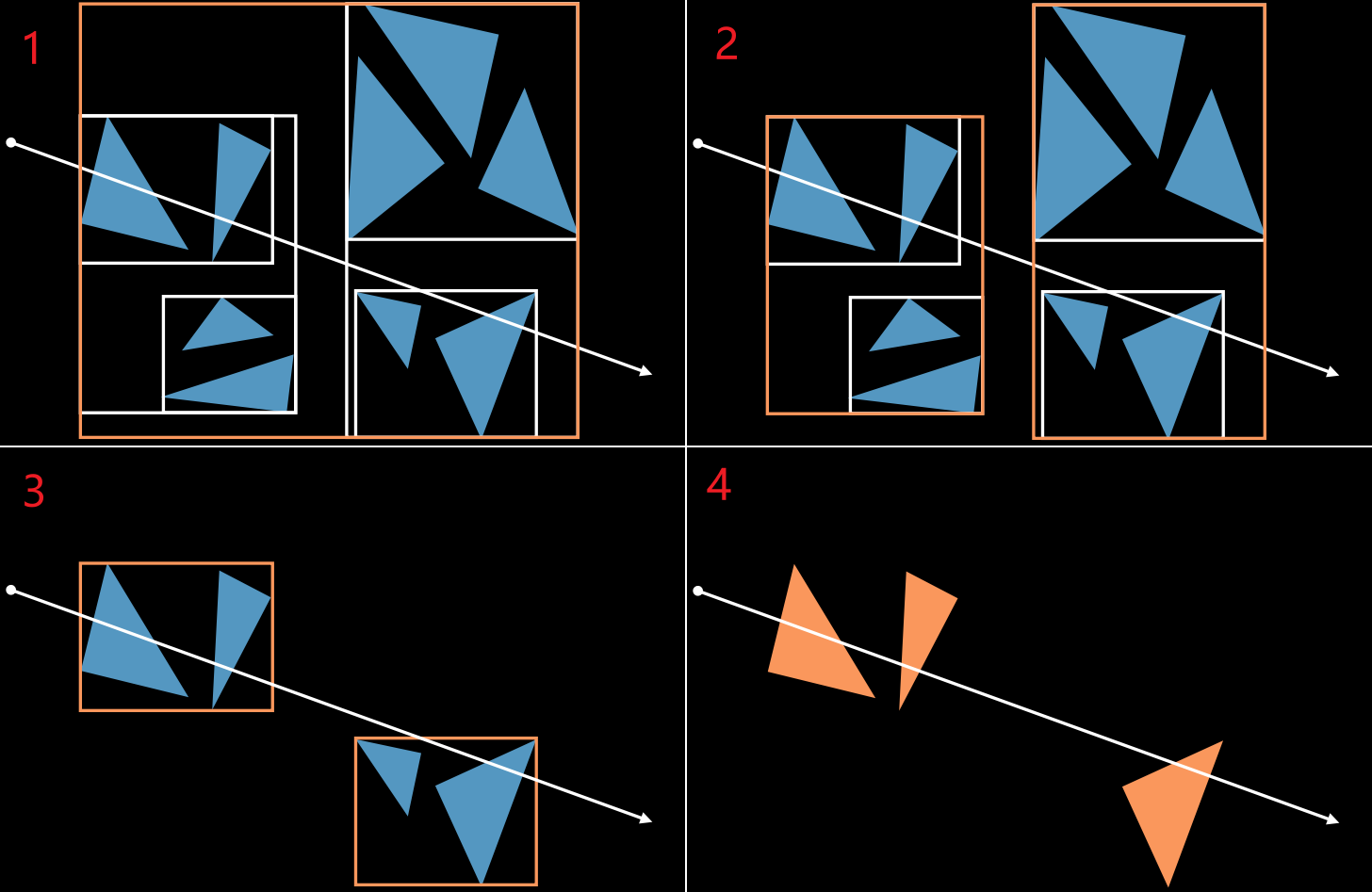

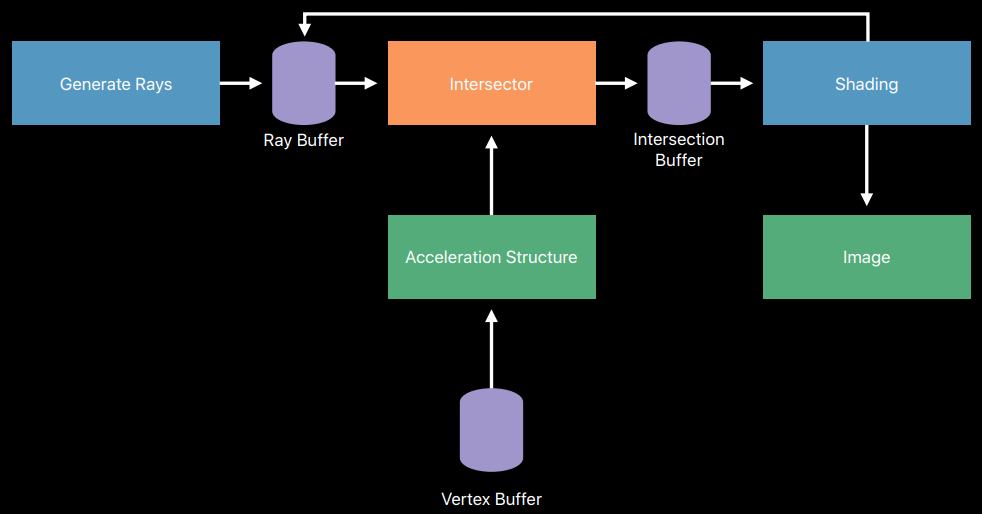

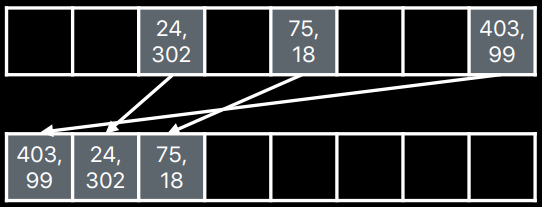

光線追蹤場景使用了大量的射線檢測,需要一種高效的場景加速結構。在實時光線追蹤中,使用最廣的的加速結構是層次包圍盒(Bounding volume hierarchy,BVH)。BVH將對象及其邊界體積組織成一棵樹,樹的根是包含整個場景的邊界體積,最常用的邊界體積是軸對齊框,因為這樣的框易於計算和組合。

BVH樹的示例。

例如,茶壺場景的BVH具有五層邊界框,頂層由整個場景的單個邊界框組成,下一層包含兩個茶壺和正方形的邊界框。每個茶壺由四部分組成:壺身、壺蓋、壺柄和壺嘴,每個零件都有一個邊界框,茶壺主體由八個貝塞爾面片組成,每個面片都有自己的邊界框。對於曲面細分的Bezier面片,每組四邊形可以有一個邊界框,用於有效的光線相交測試。

可以直接使用場景建模層次,如茶壺場景示例。另一種策略是分割幾何體,使每個部分的表面積近似相等。

當光線需要與場景中的對象進行交集測試時,第一步是檢查與整個場景的邊界框的交集。如果光線擊中邊界框,將測試子對象的邊界框,依此類推。當到達層次結構的某個葉時,必須對該葉表示的對象進行交集測試。

這些加速度數據結構中沒有一個始終比另一個更快。對於給定場景,哪一個是最佳的取決於場景特徵,以及重點是快速構建、快速更新、快速光線遍歷還是緊湊記憶體使用。

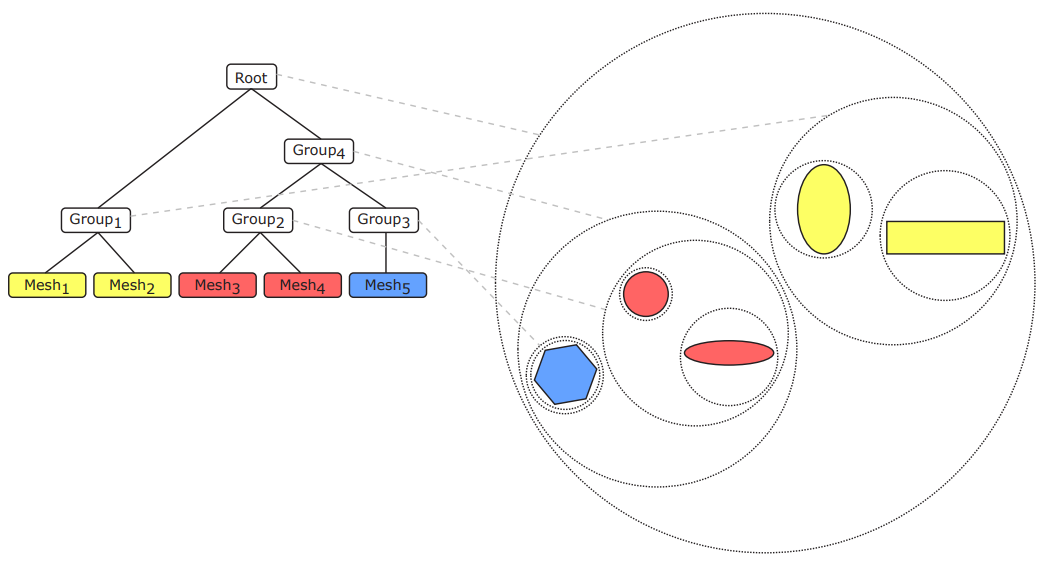

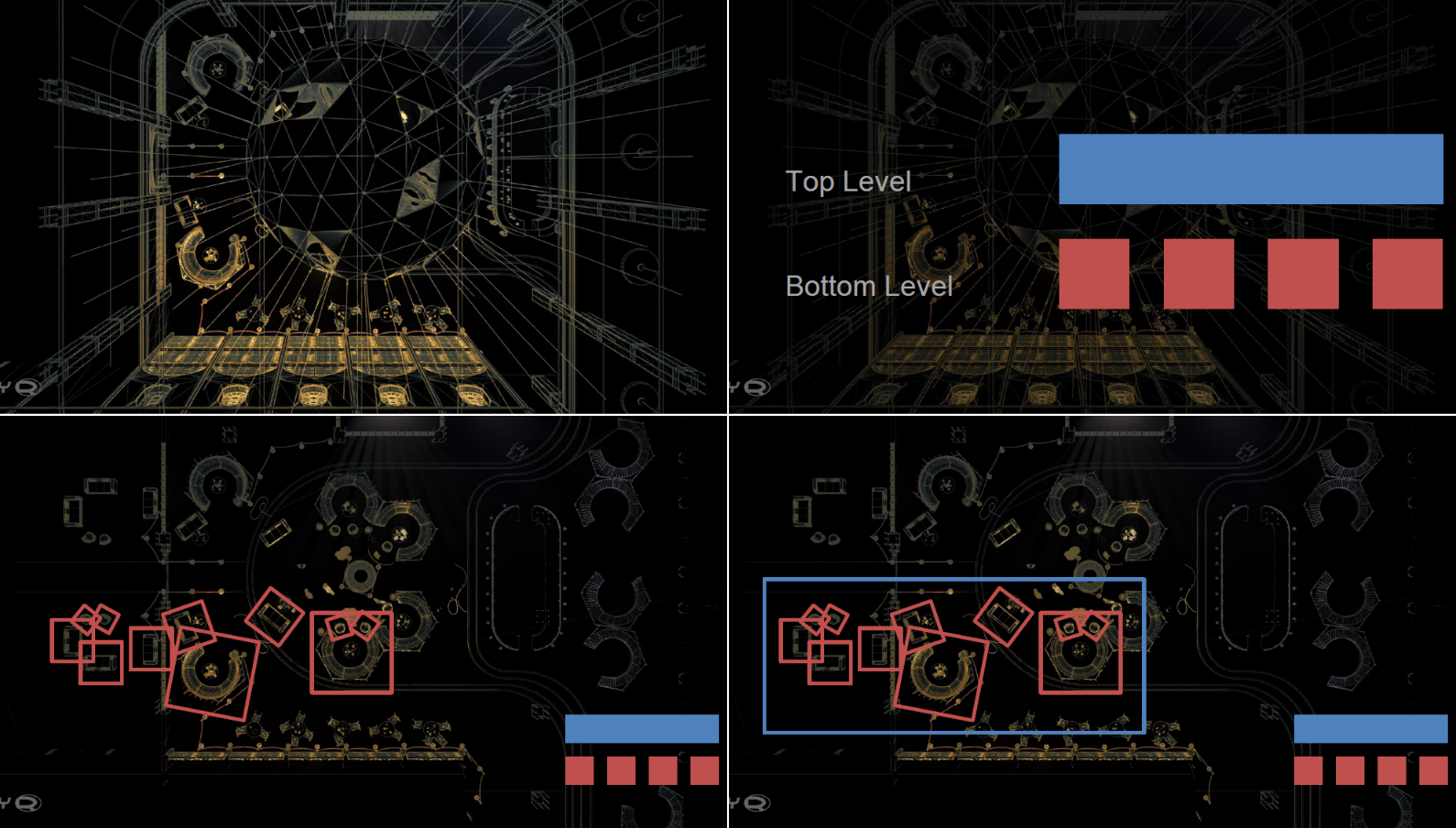

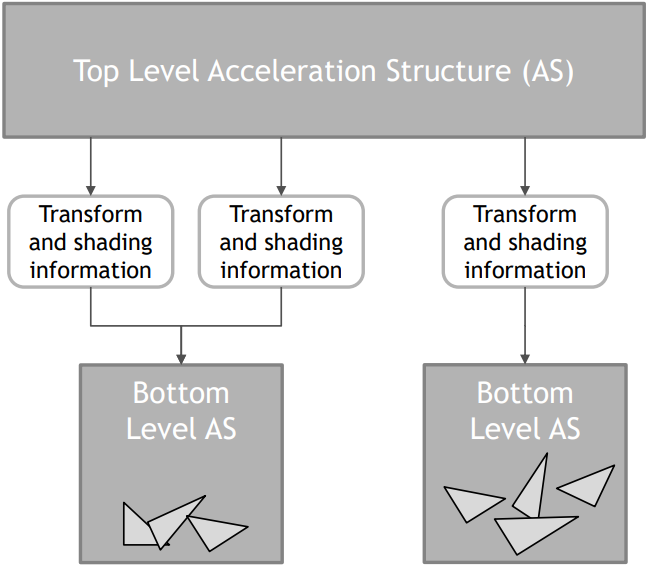

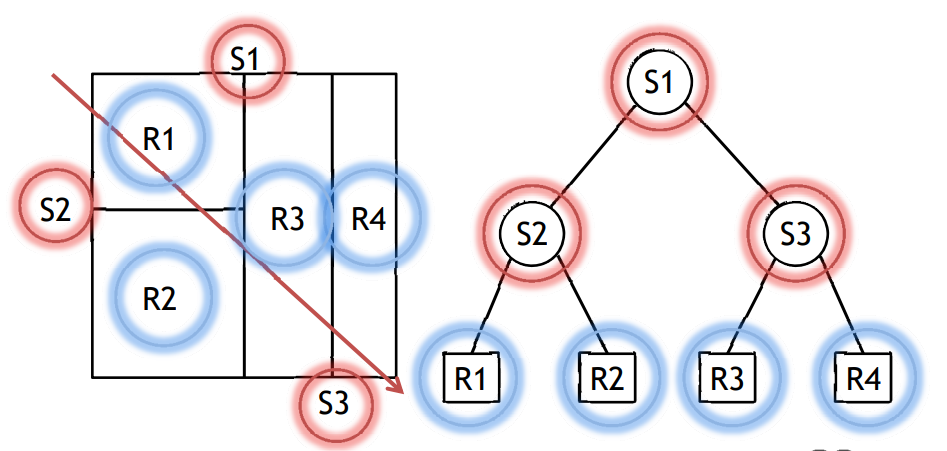

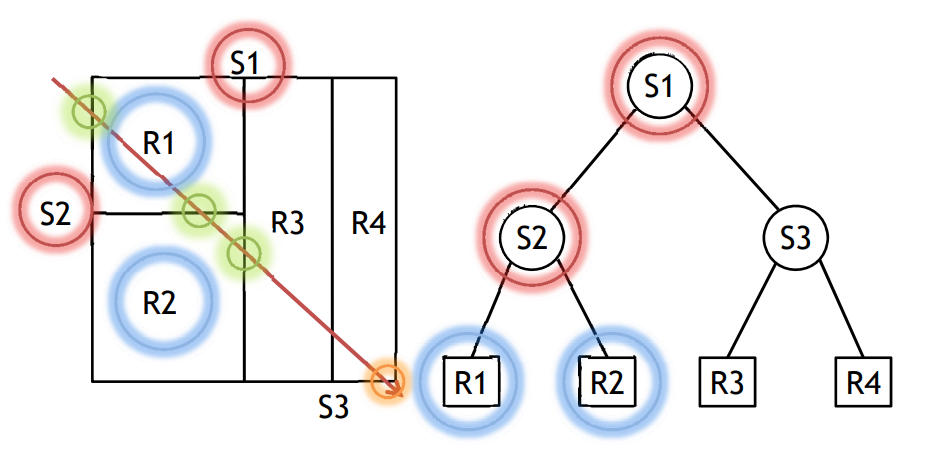

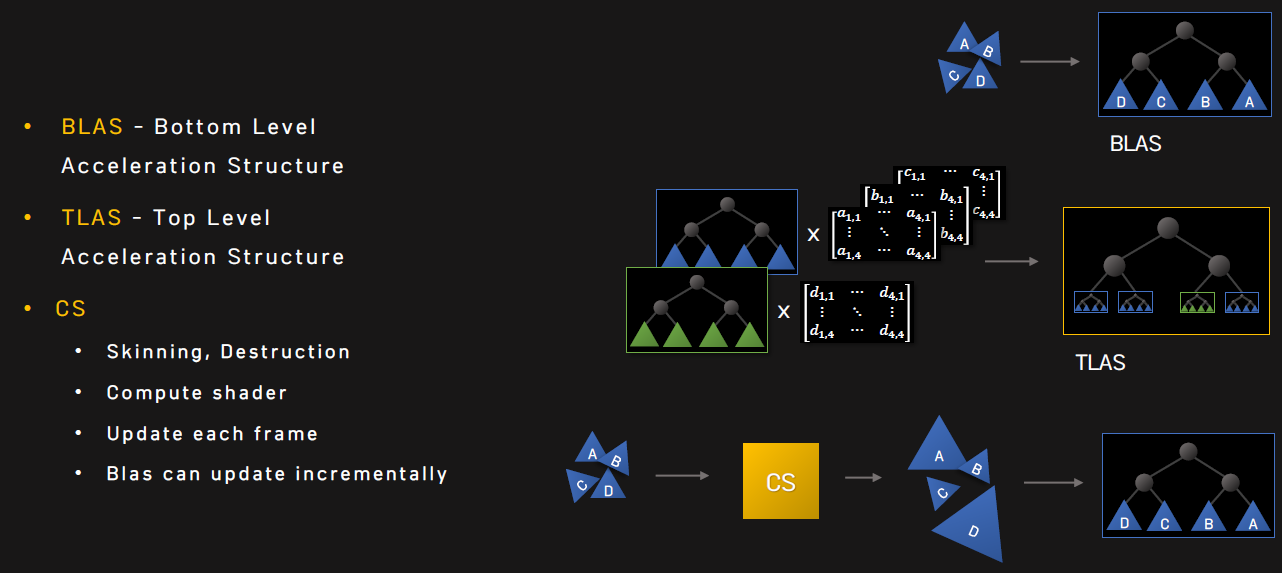

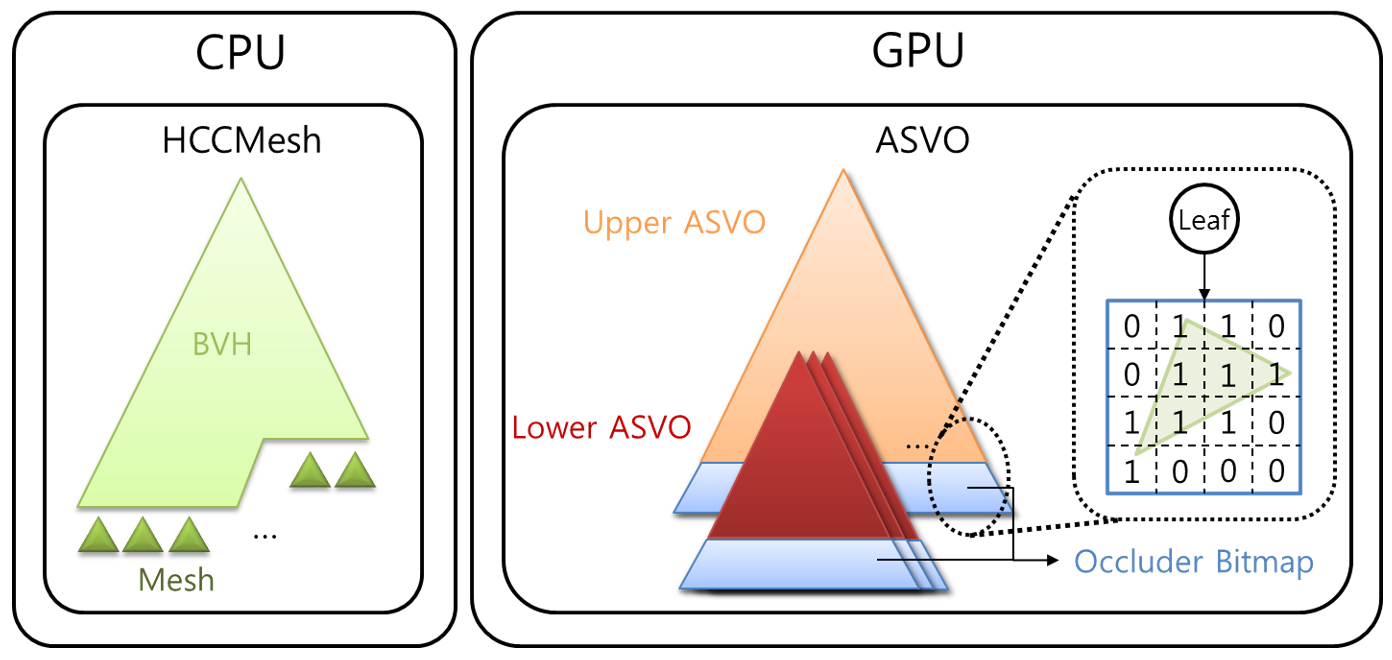

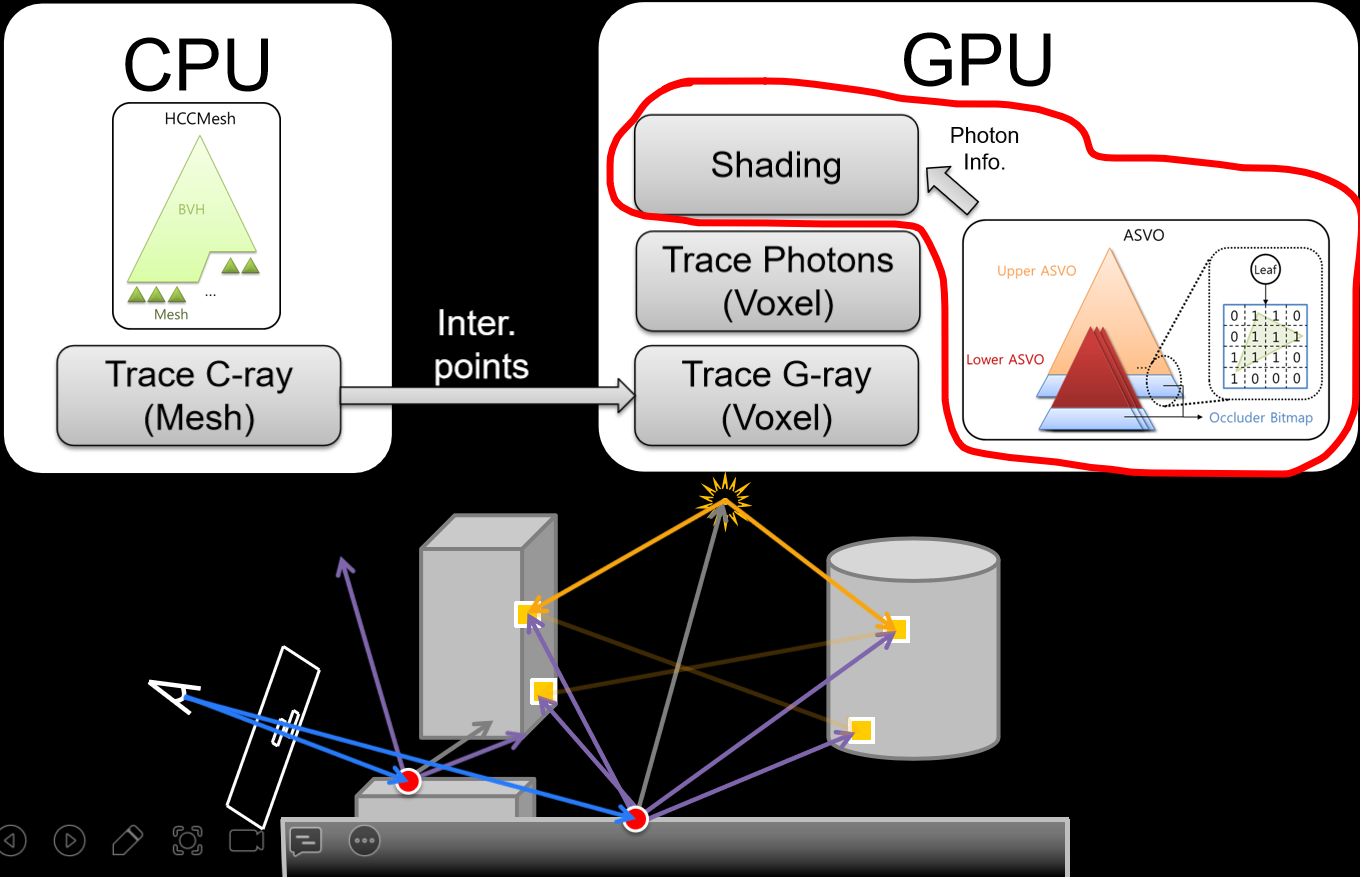

坦克世界在實現光線追蹤的部分特性(如軟陰影)時,分為CPU側和GPU側邏輯。其中CPU側包含兩級加速結構:

- BLAS(底層加速結構)BVH。適用於所有坦克模型,在網格載入期間構造一次並上傳到GPU,網格中的硬蒙皮部分拆分為多個靜態BVH,跳過軟蒙皮部分。

- TLAS(頂層加速結構)BVH。多執行緒,使用Intel Embree和Intel TBB,重建每幀並上傳到GPU。

TLAS BVH(左)和BLAS BVH(右)可視化。

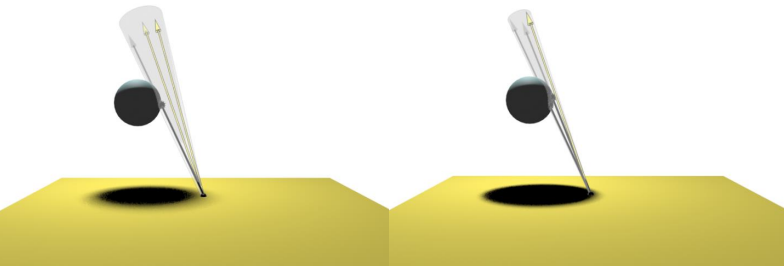

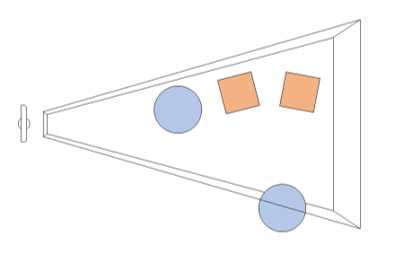

實時光線追蹤中的基於可見性的演算法和加速結構圖例如下:

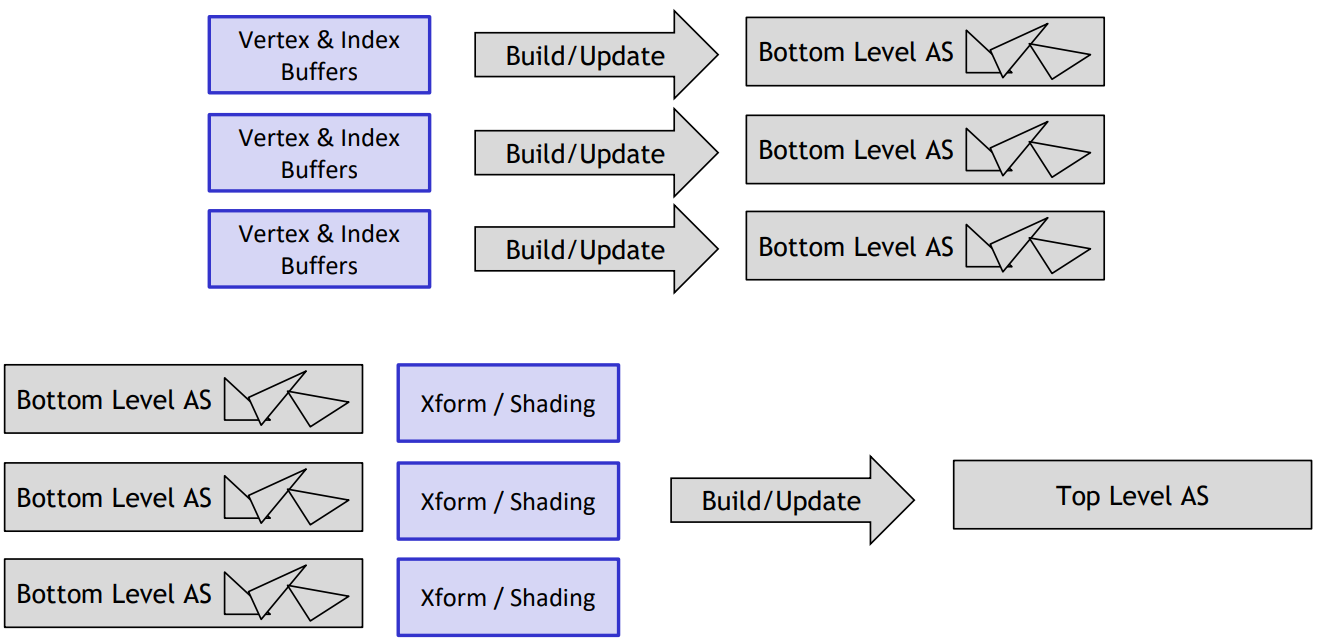

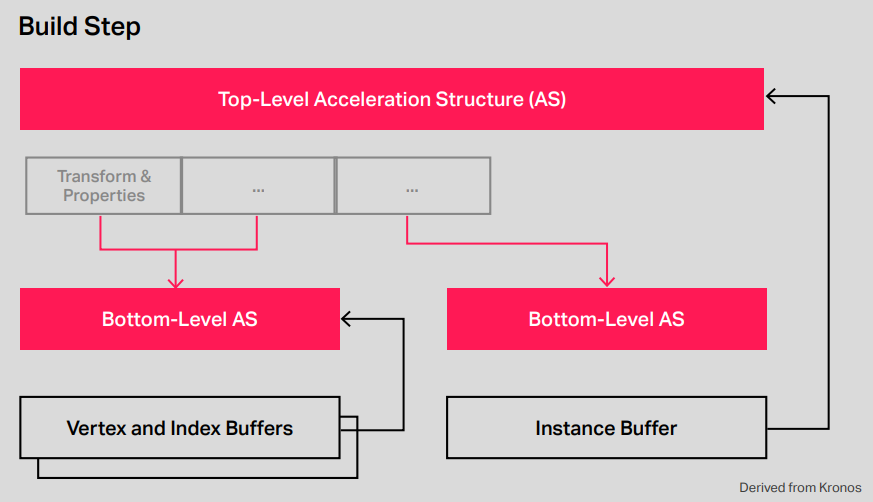

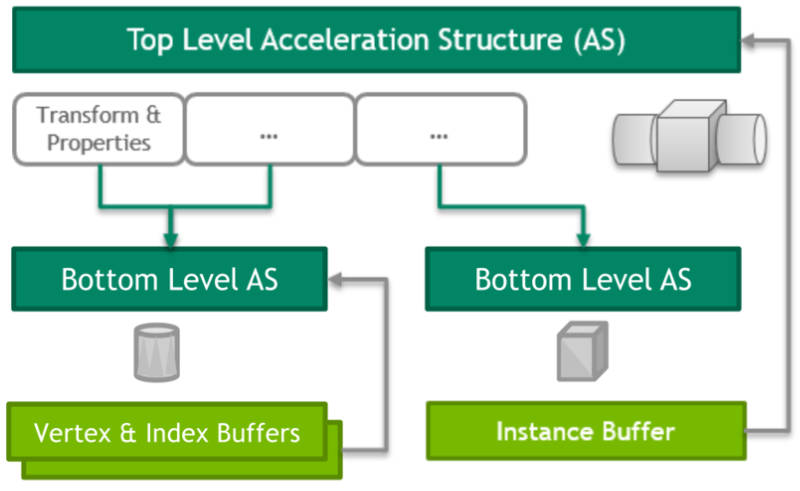

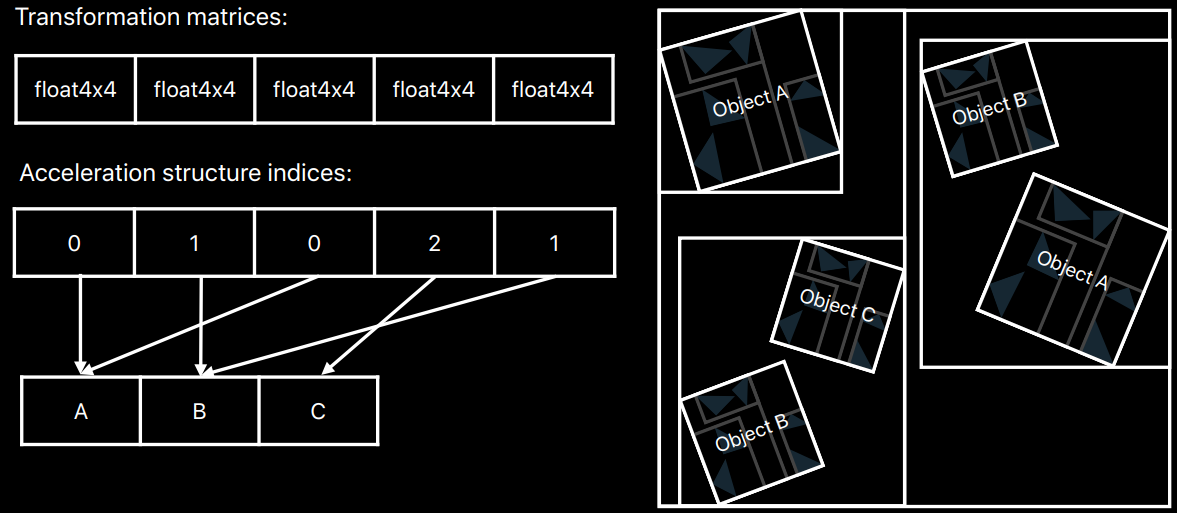

加速結構的雙層加速結構,不透明(實現定義的)數據結構,高效的構建和更新:

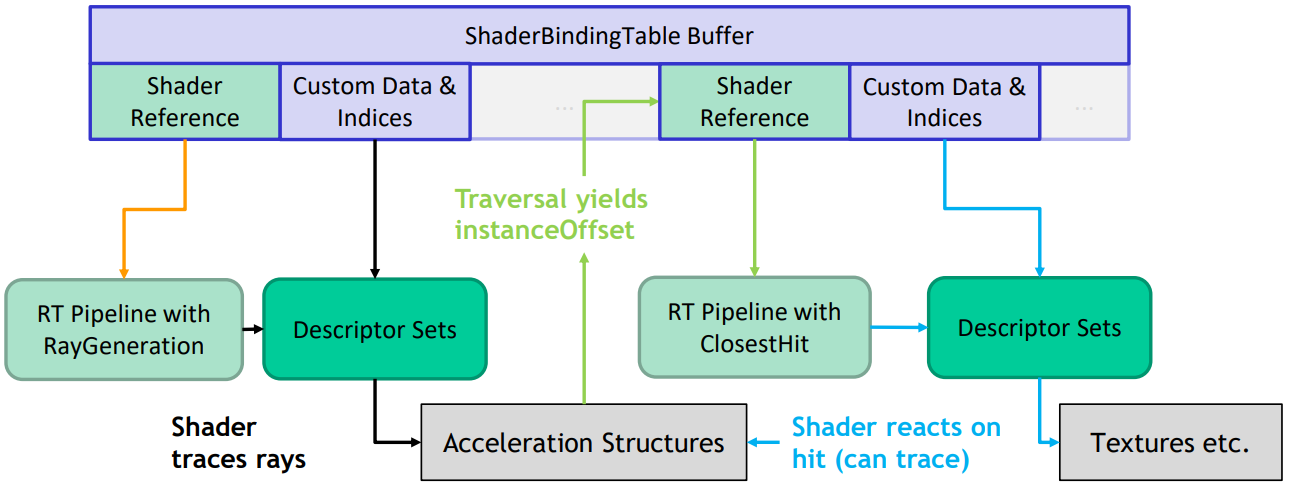

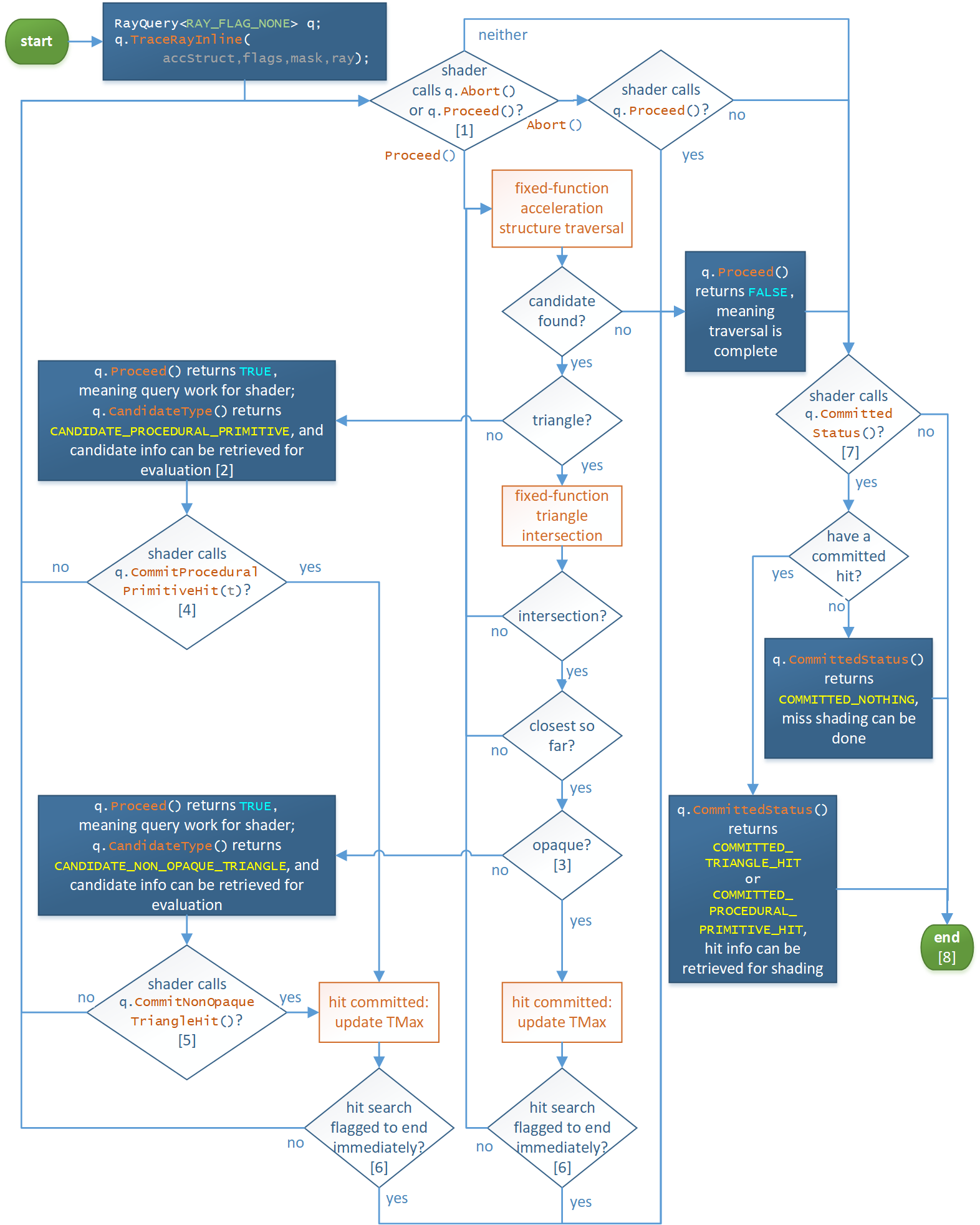

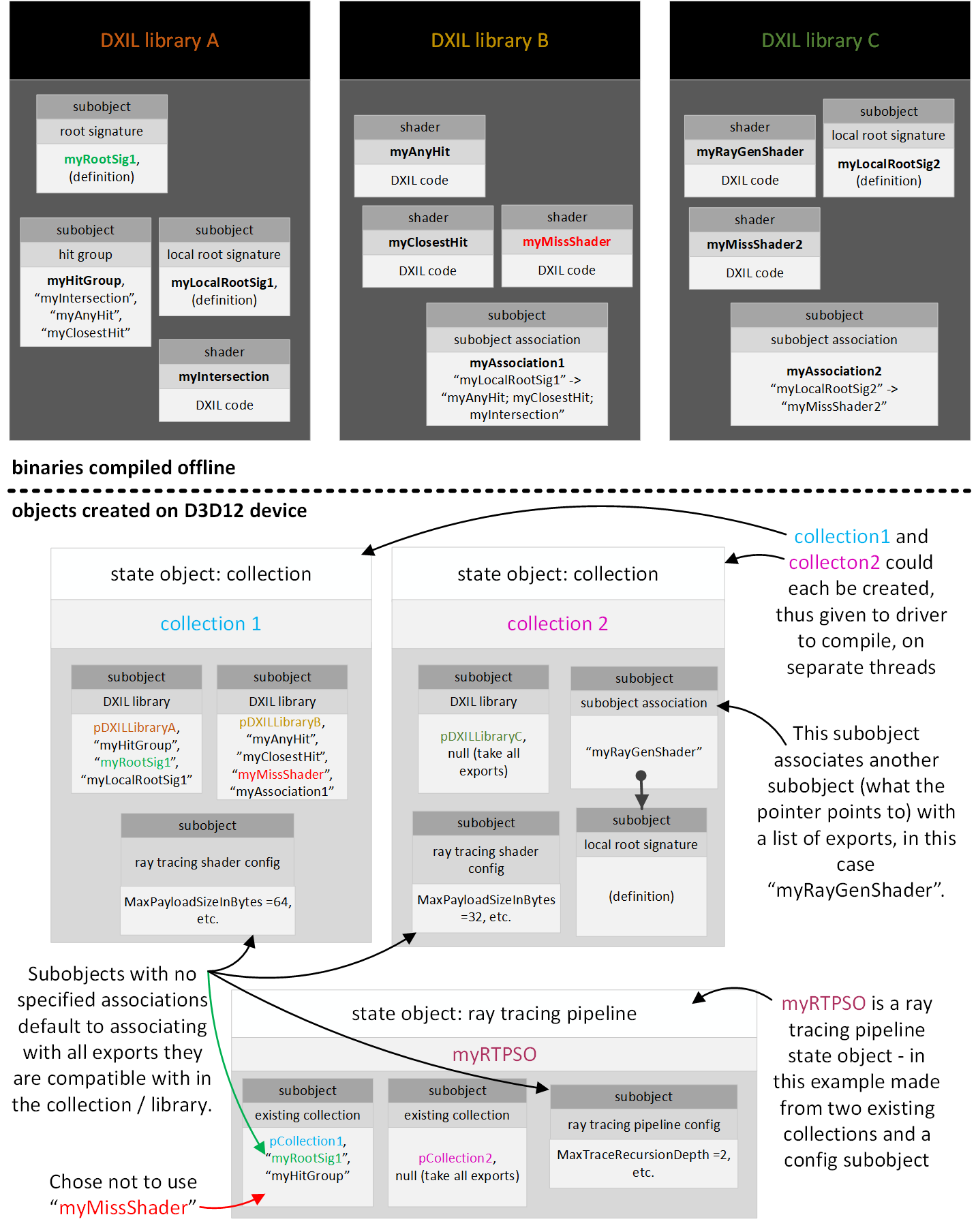

RTX構建、更新、使用加速結構示意圖:

17.3.2.2 KD-Tree

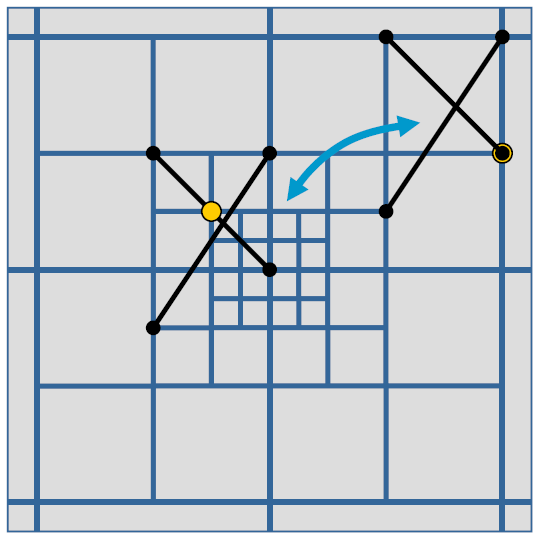

通過KD-Tree結構體可以避免棧遍歷,下圖是一個示例場景在拆分平面後構成的一個樹形結構:

遍歷時,通過樹形結構可以快速檢測到相交物體避免棧遍歷:

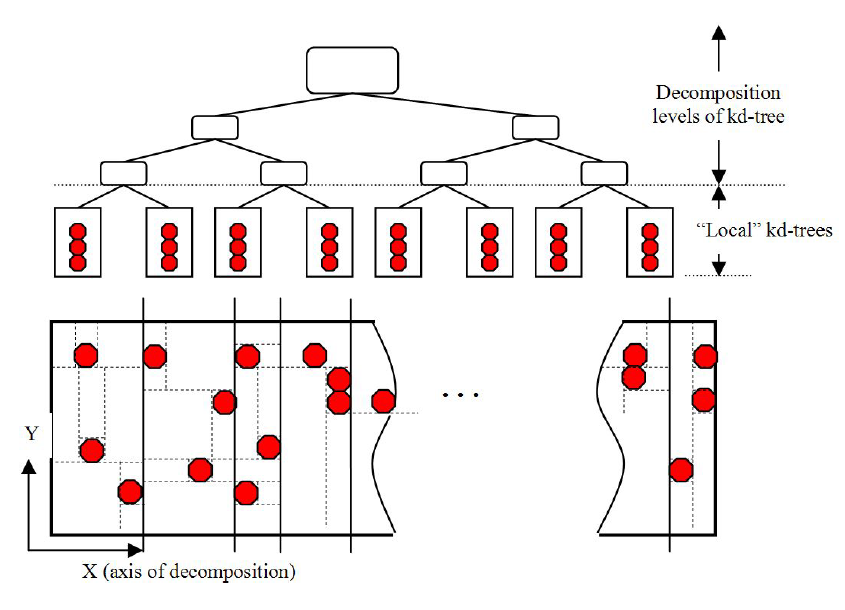

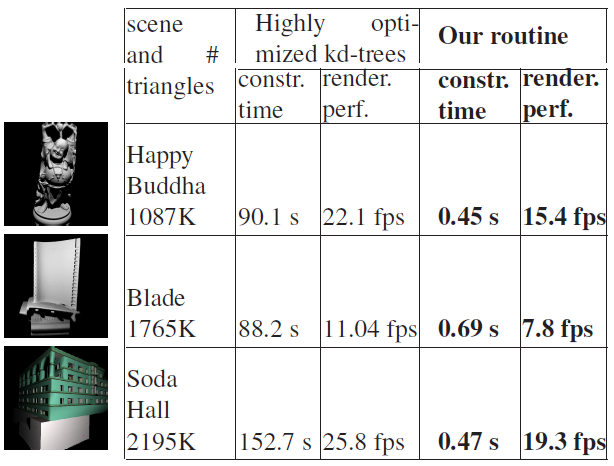

Highly Parallel Fast KD-tree Construction for Interactive Ray Tracing of Dynamic Scenes提出了一種高度並行、線性可伸縮的kd樹構造技術,用於動態幾何的光線追蹤。其使用與高性能演算法(如MLRTA或截頭體追蹤)兼容的傳統kd樹,提供了卓越的構建速度,為渲染階段保持了合理的kd樹品質。該演算法從每幀開始構建kd樹,因此不需要運動/變形或運動約束的先驗知識。對於具有200K動態三角形、1024×1024解析度和陰影和紋理的模型,實現了7-12fps的幾乎實時性能。

使用高品質的kd樹對於實現互動式光線追蹤性能至關重要。因此,目標是儘可能快地構建kd樹,以最小化其品質退化。典型的kd樹構造以自頂向下的方式進行,通過使用以下任務序列將當前節點遞歸地拆分為兩個子節點。

1、在某些位置生成分裂平面候選。

2、在每個位置使用SAH評估成本函數。

3、選擇最佳候選(成本最低),並將其拆分為兩個子節點。

4、跳過幾何圖形,將其分配給子節點。

5、遞歸重複。

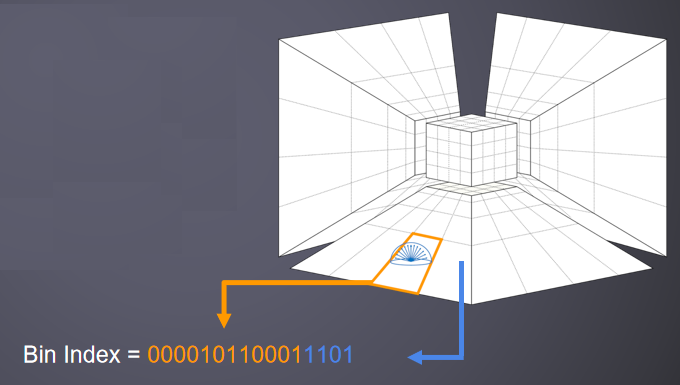

該文著眼於前三個階段。在快速估計SAH期間,使用三角形AABB作為三角形的代理。成本函數是分段線性的,因此只需要在位於當前節點內的AABB邊界處進行評估,這些位置也稱為拆分候選位置。

在第2個步驟,對於大量幾何圖元,由於其積分形式,成本函數可以在離散化設置中計算。為了克服演算法複雜性,使用概念上類似的技術,儘管此方法適用於大型和小型對象。不在每個容器中存儲對象引用,而是用一個對象計數器替換一個可變大小的列表(或數組)。構建這樣的結構需要對幾何體進行單一且廉價的通道,而不是排序。

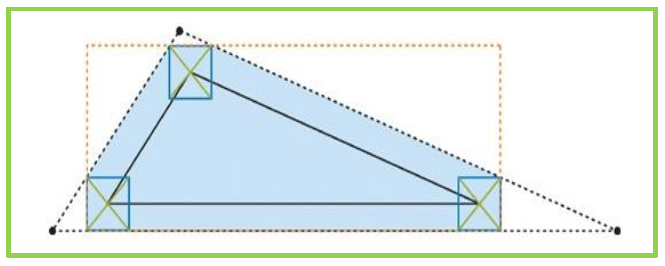

最初,針對點提出了裝箱演算法(鴿子洞排序、桶排序)。其思想是將1D間隔分割為給定數量的大小相等的容器,形成規則網格。對象所屬的bin索引可以直接從其位置計算。使用一個單一的線性傳遞幾何體,可以計算箱中的三角形數量,並更新箱的候選分割值(最接近箱邊界),如下圖所示。當一個三角形表示為一個點時,如果演算法在整個三角形範圍內工作,則更新該點所在的箱,或更新與該三角形重疊的每個箱。該數據隨後用於非常不精確的快速SAH近似。

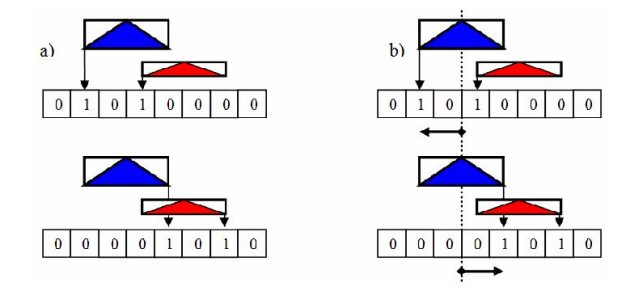

(a) 傳統的裝箱演算法;(b)使用該演算法評估SAH。

最小-最大裝箱演算法的思想是追蹤每個三角形AABB在兩組單獨的裝箱中的開始和結束位置(下圖)。每個箱子只是一個櫃檯,對於每個圖元的AABB,在第一個集合(AABB開始的地方)和第二個集合(AAABB結束的地方)中只更新一個bin。因此,完全消除了對容器總數的依賴。演算法的這一特性對於初始聚類任務至關重要,且使用最小-最大裝箱演算法估計SAH。

(a) 最小-最大裝箱演算法;(b)使用該演算法評估SAH。

該方法易於擴展到多執行緒並行構造kd樹,並行運行任務需要將整個任務劃分為分配給執行緒的較小部分(作業)。

一種簡單的方法是在每個步驟中利用數據並行性。事實上,當每個執行緒被賦予相等數量的圖元時,裝箱和幾何拆分過程完美地並行運行。記憶體管理也很簡單:每個執行緒都有自己的上述池集,適用於大量圖元。另一種方法是每個執行緒構建子樹,需要對幾何體進行某種初始分解。然而,迄今為止的初始分解是按順序進行的,實際上,這個階段也可使用並行解決方案。

最簡單的分解是在可用執行緒之間均勻分布圖元,如4個執行緒中的每個執行緒處理場景中1M個三角形中的250K個三角形。儘管具有良好的記憶體局部性,但這種幾何分解具有明顯的缺點,即不同執行緒構建的Kd樹將在空間上重疊,沒有已知的方法可以合併重疊的kd樹,而使用光線遍歷多個樹會導致渲染速度減慢。空間分割而不是幾何分割導致不重疊的kd樹很容易合併為一棵樹。常規的空間分區會導致負載平衡不良。因此,並行處理空間區域需要使用幾何分布資訊進行區域選擇。

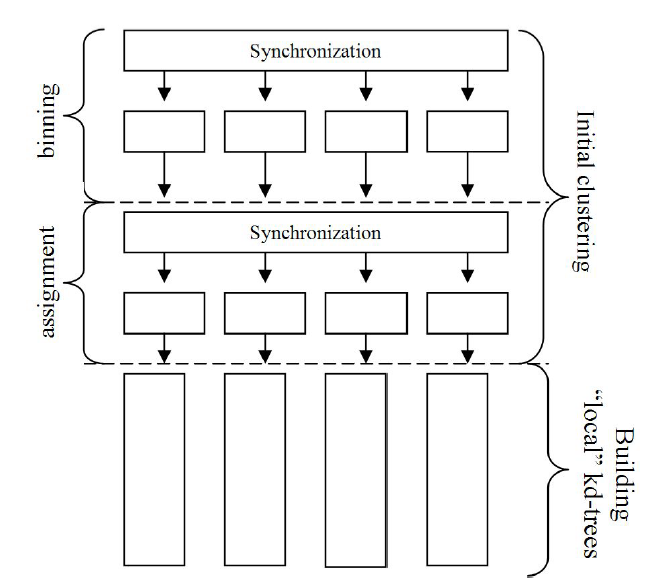

該文使用了混合併行化方案,對數據進行並行初始分解(聚類),以創建獨立處理的作業。

且使用了初始聚類平衡分解:

使用優化後的KD-Tree,在不同的場景的加速比如下圖:

由此可見,KD-Tree的構建實際大幅度提升,但渲染性能有所下降。

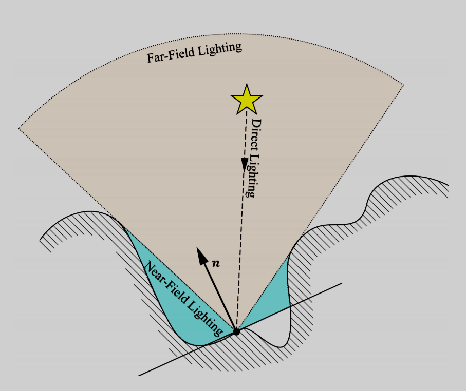

17.3.3 光線追蹤陰影

光線追蹤的第一個附加用途是陰影計算:我們可以通過追蹤從點到光源的光線來確定點是否處於陰影中。如果光線沿途擊中不透明對象,則該對象處於陰影中;如果沒有,它將照亮。當計算不透明陰影的光線對象交點時,我們只關心命中或不命中;不是交點和法線。對於點光源和聚光燈,我們追蹤曲面點和光源位置之間的光線。對於定向光源,我們沿著光的方向追蹤來自表面點的平行光線。

(a)陰影射線;(b)帶有光線追蹤陰影的茶壺。

如果對象是不透明的,任何命中都足以確定陰影。但是如果物體是半透明的(例如彩色玻璃),我們需要獲得點和光源之間所有相交表面的透射顏色,然後通過乘以每個顏色分量來合成透射顏色。

區域光源導致柔和陰影,完全陰影和完全照明之間的區域稱為半影。軟陰影可以通過向區域光源表面上的隨機點發射陰影光線來計算。下圖(a)顯示了從三個表面點到三角形區域光源的陰影光線,一些光線擊中物體;圖(b)顯示了熟悉的茶壺場景中的軟陰影。在該影像中,光源是球形的,軟陰影是通過分布光線追蹤計算的。

(a) 將光線投影到區域光源。(b) 有柔和陰影的茶壺。

在表面和光源之間發射光線:

- 如果光線擊中任何東西,則什麼都不做(區域被陰影和未照明)。

- 如果光線到達光線而沒有擊中任何物體,則照亮該像素。

不是為每個表面點發射一條光線,而是發射多條光線。每個光線的行為與硬陰影情況相同,平均每個像素的所有光線的結果:

- 如果所有光線都被遮擋,則表面完全被遮擋。

- 如果所有光線到達光源,則表面將完全照亮。

- 如果一些光線被遮擋,一些光線到達光線,則表面處於半影區域。

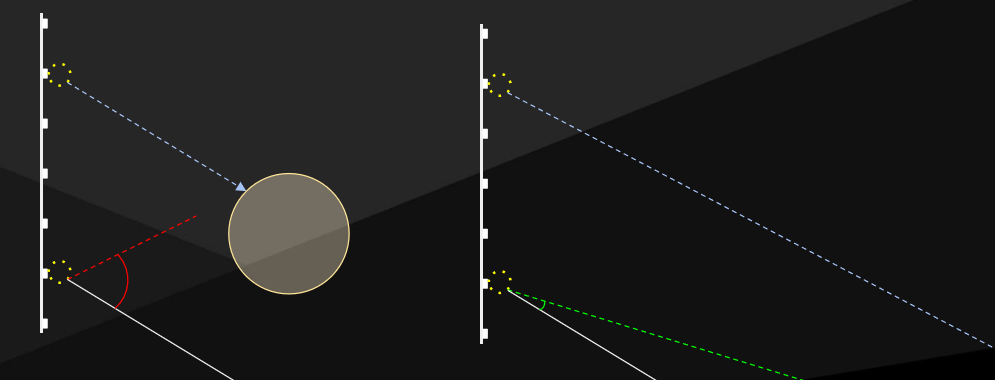

如果區域中的光源為燈光,則將光線分布在從表面可見的光源的橫截面上。要使用無限遠的平行光近似日光,請從表面選擇一個光線錐:為了表示完全晴朗的一天,圓錐體的立體角為零;為了表示多雲的日光,立體角變大。正在估計到達表面點的入射光,要獲得良好的估計,樣本應均勻覆蓋域。

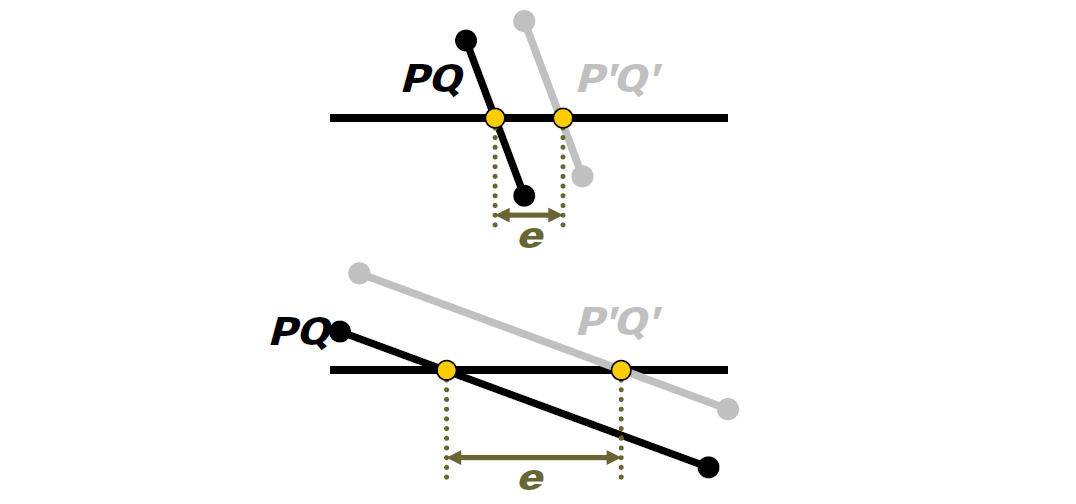

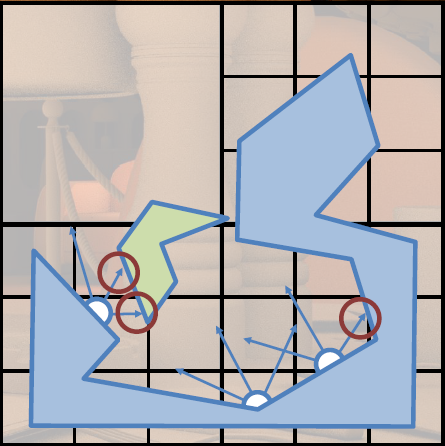

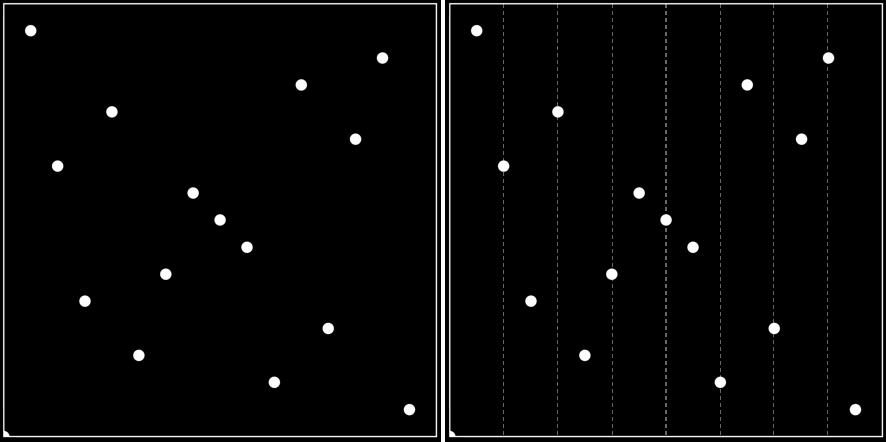

需要大量光線來精確取樣軟陰影,但此過程盡量保證GBuffer的連續性,避免多餘的光線。對於大多數影像,從一個像素到其相鄰像素,表面屬性變化很小。因此,從G緩衝區的一個像素髮送的光線很可能與從相鄰像素髮送的相同光線擊中同一對象。當然有一種方法可以利用這個事實來減少光線計數,但保持視覺精度?

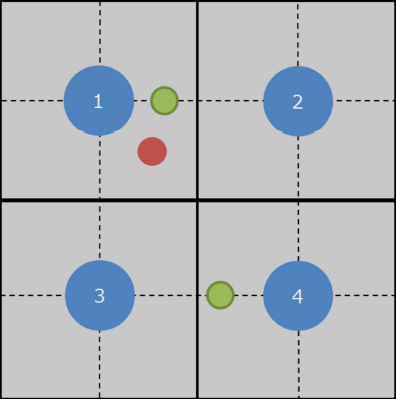

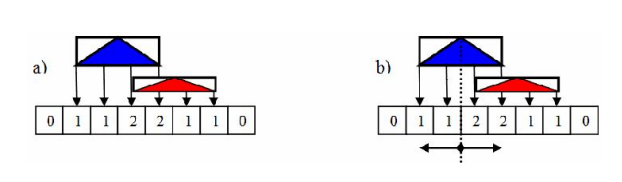

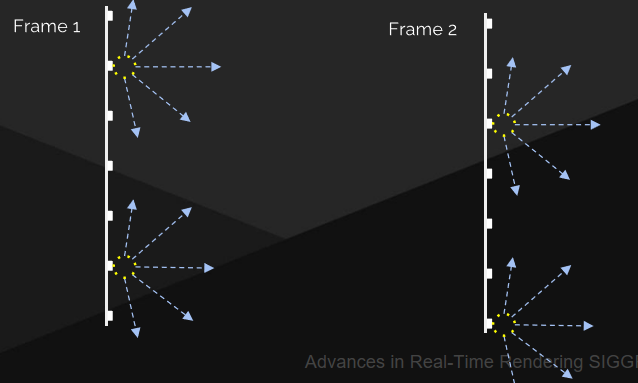

可以嘗試交錯取樣(Interleaved Sampling),以利用來自相鄰像素的陰影光線數據。在幀緩衝區上分塊\(N^2\)個光線方向的正方形2D數組,基於網格發射陰影光線,得到的影像具有臨界特性,即對於影像的任何NxN區域,表示整個$數組。因此,使用方框濾波器從影像中去除雜訊。每個輸出像素是N2個相鄰輸入像素的平均值,必須處理影像中的不連續性。

傳統的邊界體積層次結構可以跳過許多光線三角形命中測試,需要在GPU上重建層次結構,對於動態對象,樹遍曆本身就很慢。

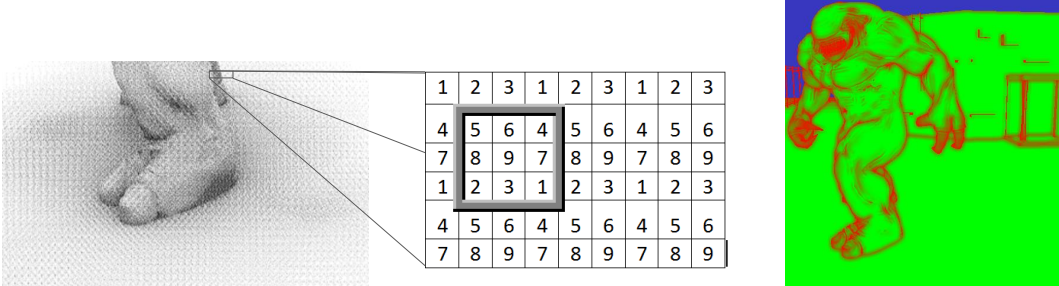

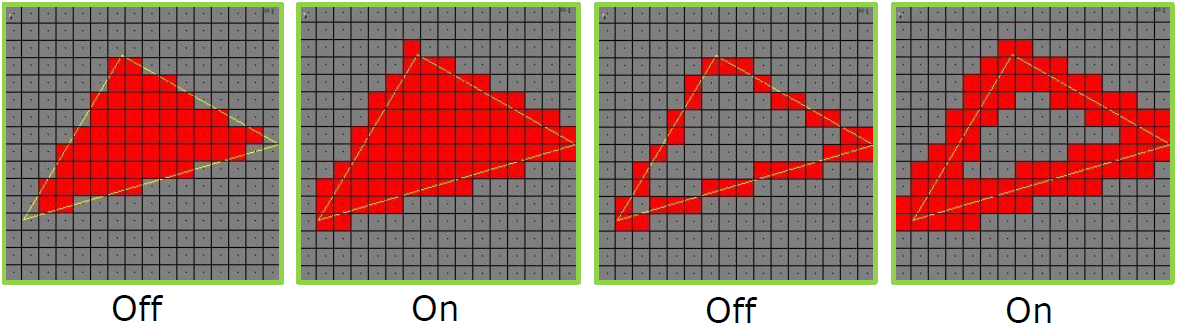

存儲用於光線跟追蹤的圖元,而無需構建邊界體積層次!對於陰影貼圖,存儲來自光源的深度,簡單而連貫的查找。同樣地存儲圖元,一個深層圖元圖,逐紋素存儲一組正面三角形。深度圖元圖繪製(N x N x d)包含3個資源:

- 圖元數量圖(Prim Count Map):紋理中有多少個三角形,使用一個原子來計算相交的三角形。

- 圖元索引圖(Prim index Map):圖元緩衝區中三角形的索引。

- 圖元緩衝區(Prim Buffer):後變換的三角形。

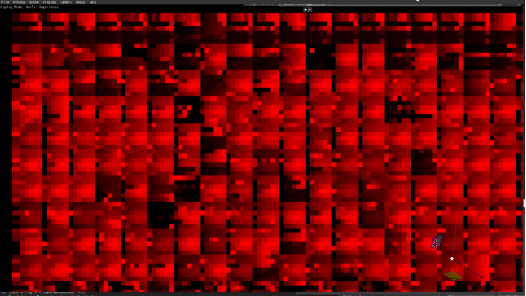

d夠大嗎?可視化佔用率——黑色表示空的,白色表示滿了,紅色則超出限制,對於一個已知的模型,很容易做到這一點。

GS向PS輸出3個頂點和SV_PrimitiveID:

[maxvertexcount(3)]

void Primitive_Map_GS( triangle GS_Input IN[3], uint uPrimID : SV_PrimitiveID, inout TriangleStream<PS_Input> Triangles )

{

PS_Input O;

[unroll]

for( int i = 0; i < 3; ++i )

{

O.f3PositionWS0 = IN[0].f3PositionWS; // 3 WS Vertices of Primitive

O.f3PositionWS1 = IN[1].f3PositionWS;

O.f3PositionWS2 = IN[2].f3PositionWS;

O.f4PositionCS = IN[i].f4PositionCS; // SV_Position

O.uPrimID = uPrimID; // SV_PrimitiveID

Triangles.Append( O );

}

Triangles.RestartStrip();

}

PS哈希了使用SV_PrimitiveID的繪製調用ID(著色器常量),以生成圖元的索引/地址。

float Primitive_Map_PS( PS_Input IN ) : SV_TARGET

{

// Hash draw call ID with primitive ID

uint PrimIndex = g_DrawCallOffset + IN.uPrimID;

// Write out the WS positions to prim buffer

g_PrimBuffer[PrimIndex].f3PositionWS0 = IN.f3PositionWS0;

g_PrimBuffer[PrimIndex].f3PositionWS1 = IN.f3PositionWS1;

g_PrimBuffer[PrimIndex].f3PositionWS2 = IN.f3PositionWS2;

// Increment current primitive counter uint CurrentIndexCounter;

InterlockedAdd( g_IndexCounterMap[uint2( IN.f4PositionCS.xy )], 1, CurrentIndexCounter );

// Write out the primitive index

g_IndexMap[uint3( IN.f4PositionCS.xy, CurrentIndexCounter)] = PrimIndex; return 0;

}

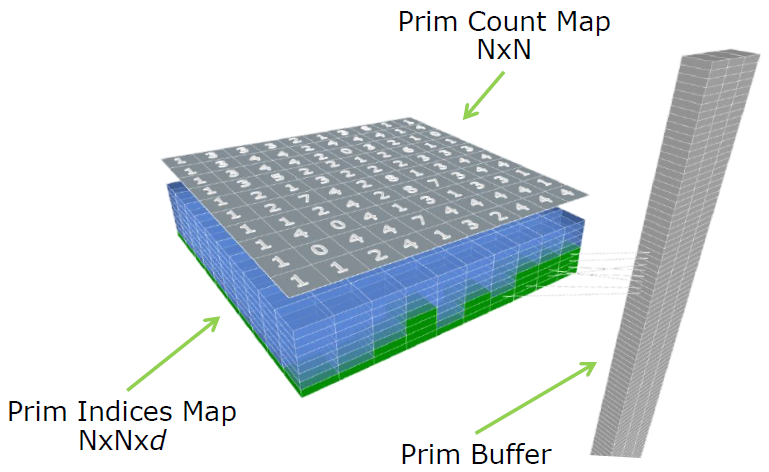

需要使用保守的光柵來捕捉所有與紋素接觸的圖元,可以在軟體或硬體中完成。硬體保守光柵化——光柵化三角形接觸的每個像素,在DirectX 12和11.3中啟用:D3D12_RASTERIZER_DESC、D3D11_RASTERIZER_DESC2。

軟體保守光柵化——使用GS在裁減空間中展開三角形,生成AABB以剪裁PS中的三角形,參見GPU Gems 2-第42章。

光線追蹤時,計算圖元坐標(與陰影貼圖一樣),遍歷圖元索引數組,對於每個索引,取一個三角形進行射線檢測。

float Ray_Test( float2 MapCoord, float3 f3Origin, float3 f3Dir, out float BlockerDistance )

{

uint uCounter = tIndexCounterMap.Load( int3( MapCoord, 0 ), int2( 0, 0 ) ).x;

[branch]

if( uCounter > 0 )

{

for( uint i = 0; i < uCounter; i++ )

{

uint uPrimIndex = tIndexMap.Load( int4( MapCoord, i, 0 ), int2( 0, 0 ) ).x;

float3 v0, v1, v2;

Load_Prim( uPrimIndex, v0, v1, v2 );

// See 「Fast, Minimum Storage Ray / Triangle Intersection「

// by Tomas Möller & Ben Trumbore

[branch]

if( Ray_Hit_Triangle( f3Origin, f3Dir, v0, v1, v2, BlockerDistance ) != 0.0f )

{

return 1.0f;

}

}

}

return 0.0f;

}

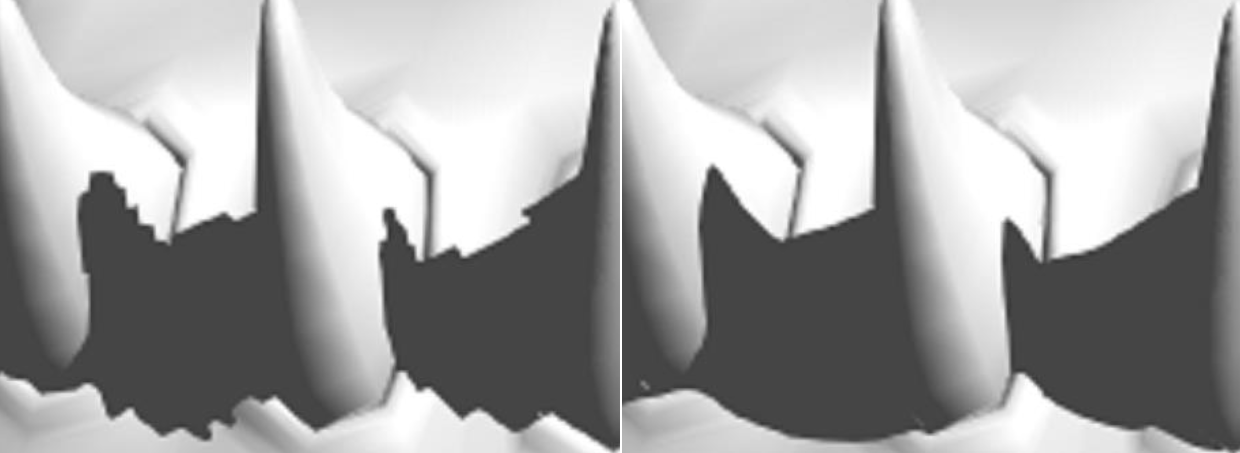

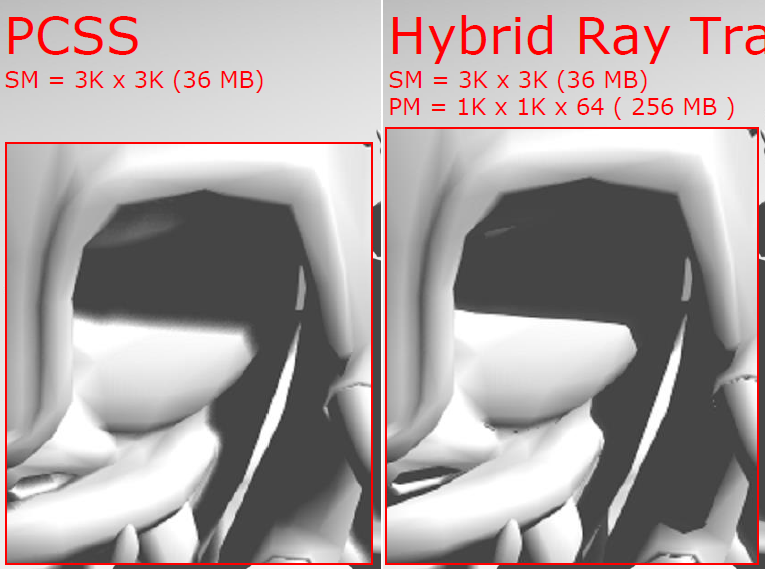

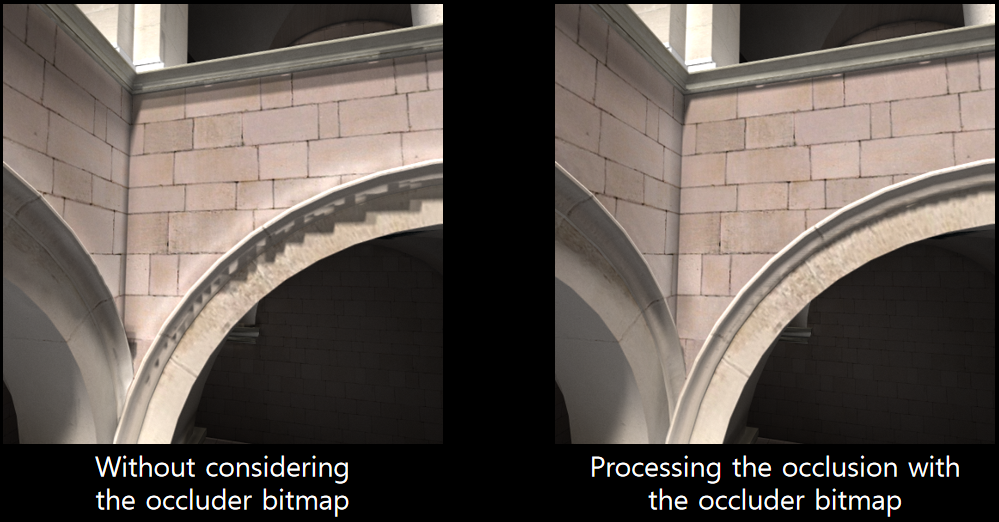

左:3k x 3k的陰影圖;右:3k x 3k的陰影圖 + 1K x 1K x 64的PM。

為了抗鋸齒,使用額外的光線可行嗎?開銷太大了!可使用簡單技巧——應用螢幕空間AA技術(如FXAA、MLAA等)。

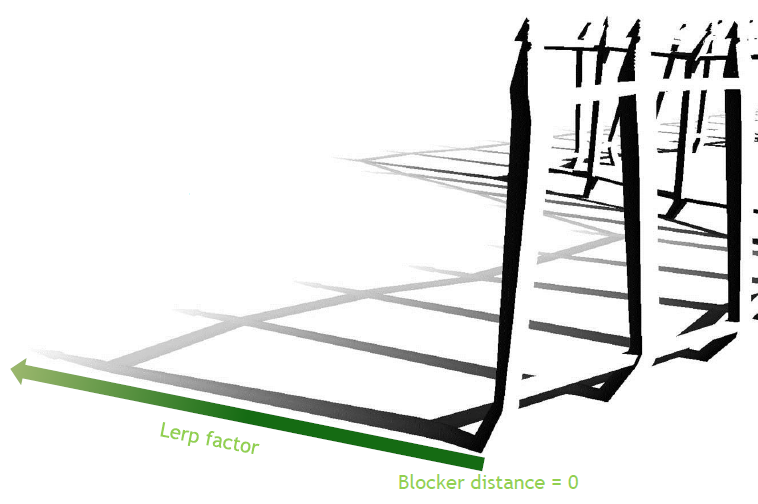

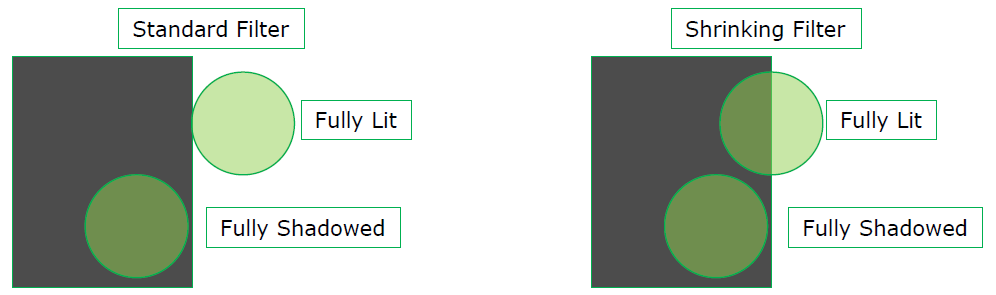

混合方法——將光線追蹤陰影與傳統的軟陰影相結合,使用先進的過濾技術,如CHS或PCS,使用阻擋體距離計算lerp係數,當阻擋體距離->0時,光線追蹤結果普遍存在。插值因子可視化:

L = saturate( BD / WSS * PHS )

L: Lerp factor

BD: Blocker distance (from ray origin)

WSS: World space scale – chosen based upon model

PHS: Desired percentage of hard shadow

FS = lerp( RTS, PCSS, L )

FS: Final shadow result

RTS: Ray traced shadow result (0 or 1)

PCSS: PCSS+ shadow result (0 to 1)

使用收縮半影過濾,否則,光線追蹤結果將無法完全包含軟陰影結果,將導致在兩個系統之間執行lerp時出現問題。

效果對比:

不同圖元複雜度的效果、消耗及性能如下:

目前僅限於單一光源,不能擴大到適用於整個場景,存儲將成為限制因素,但最適合最接近的模型:當前的焦點模型、最近級聯的內容。總之,解決傳統的陰影貼圖問題,AA光線追蹤硬陰影的性能非常好,混合陰影結合了這兩個世界的優點,無需重新編寫引擎,遊戲速度足夠快!

在2017年,坦克世界就已經通過各種優化手段在DirectX 11及以上的圖形平台實現了光線追蹤陰影。他們實現了實時光線追蹤物理正確的軟陰影,不需要硬體RT Core,使用了用於構建BVH的Intel Embree,使得坦克世界成為第一款在D3D11中使用實時RT陰影的遊戲。

坦克世界開啟(左)和關閉(右)光線追蹤軟陰影的對比圖。

在實現光線追蹤軟陰影時,分為CPU側和GPU側邏輯。其中CPU側包含兩級加速結構:

- BLAS(底層加速結構)BVH。適用於所有坦克模型,在網格載入期間構造一次並上傳到GPU,網格中的硬蒙皮部分拆分為多個靜態BVH,跳過軟蒙皮部分。

- TLAS(頂層加速結構)BVH。多執行緒,使用Intel Embree和Intel TBB,重建每幀並上傳到GPU。

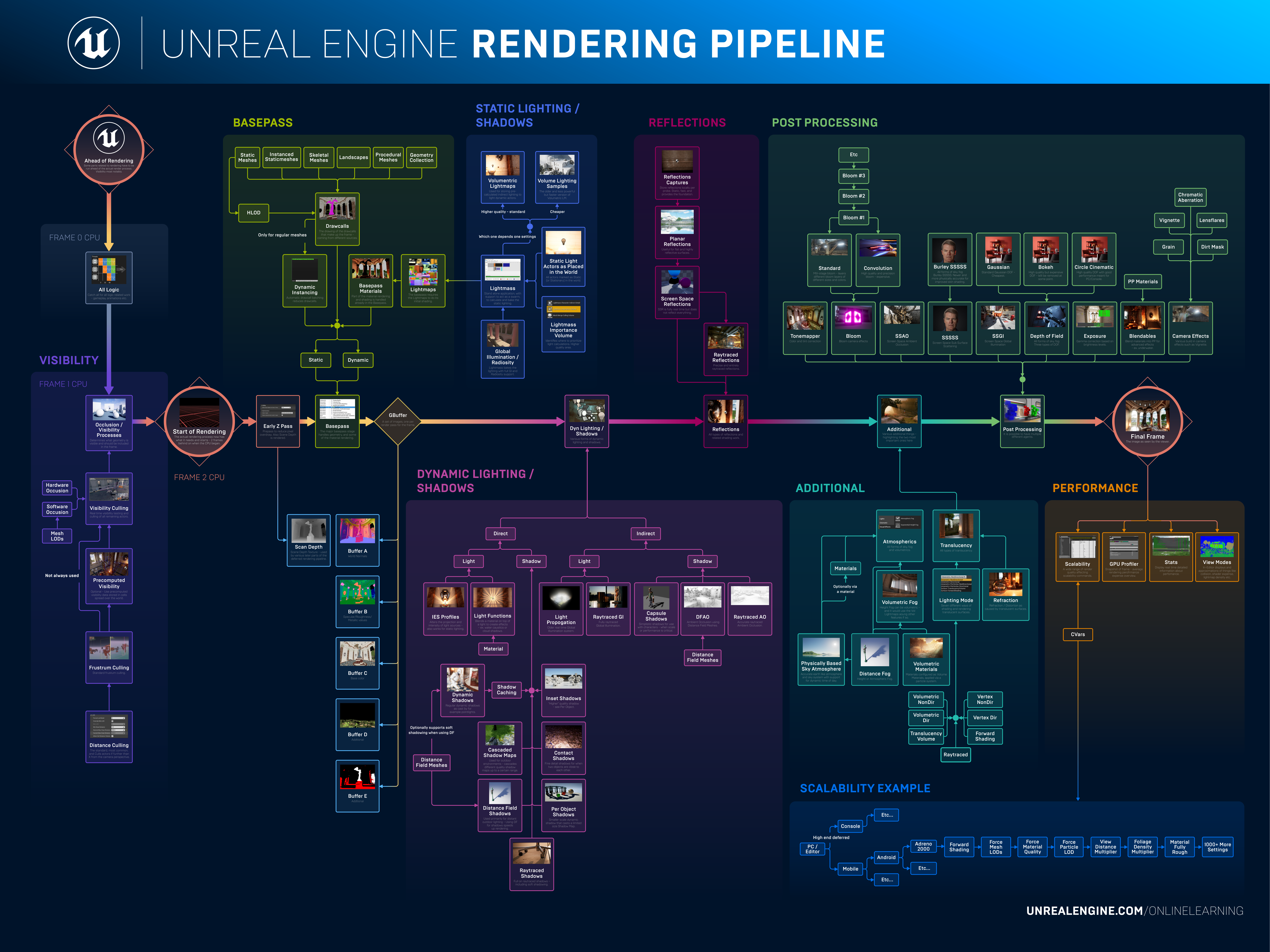

CPU BVH佔CPU幀時間的2.5%,使用TBB執行緒,SSE 4.2(比原始WoT內部BVH builder快5.5倍),每幀更新高達約5mb的GPU數據,高達72mb的靜態GPU數據。下圖是CPU側的各個階段消耗:

GPU側執行像素著色或計算著色:

- 基於均勻錐分布的時間射線抖動。

- BVH遍歷和射線三角形交點。

- 時間積累。

- 降噪器(基於SVGF)。

- 時間抗鋸齒(TAA)。

下圖是GPU側的各個階段消耗:

)

)

坦克世界對光線追蹤陰影進行了優化:RT陰影只能由坦克投射,不支援alpha測試的幾何體,BLAS使用LOD,每像素只發射1根射線。如果出現以下情形之一,則不追蹤光線的像素:

NdotL <= 0。- 如果像素已被陰影貼圖遮擋。

- 距離攝像機300米以上。

利用此法實現的實時光線追蹤陰影的性能參數如下:

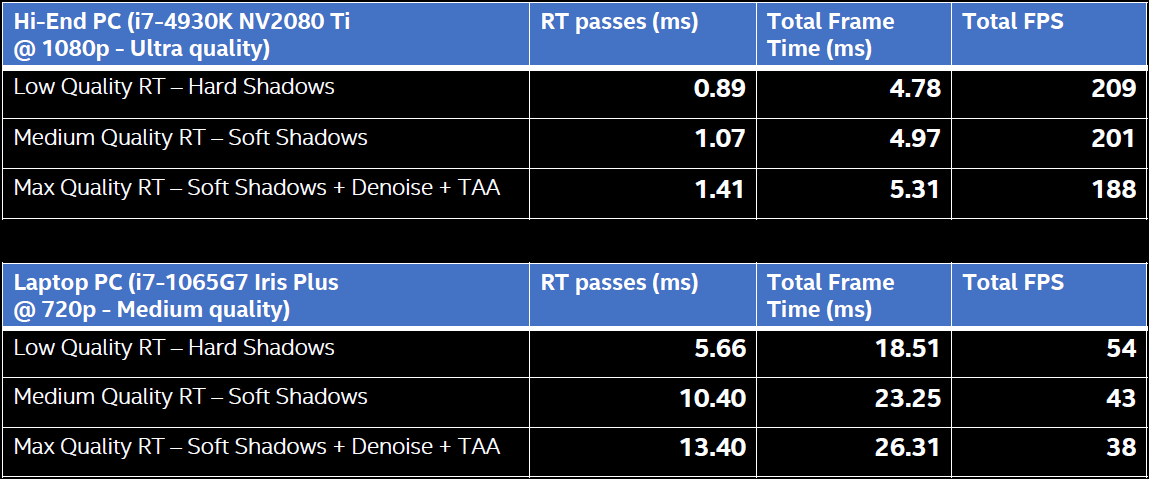

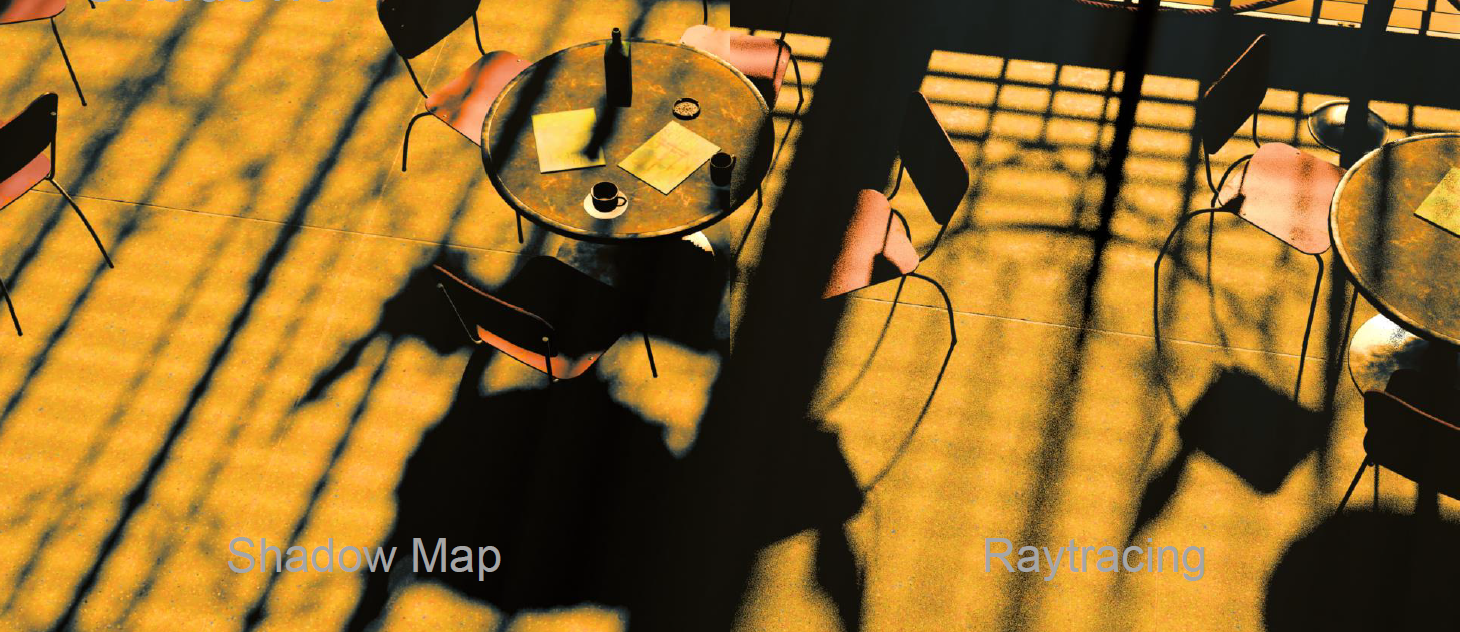

Northlight Engine實現的光線追蹤陰影和常規的Shadow Map陰影對比如下:

1080p上的每像素單根光線只耗費小於4ms,下圖是每像素單根光線的局部放大圖:

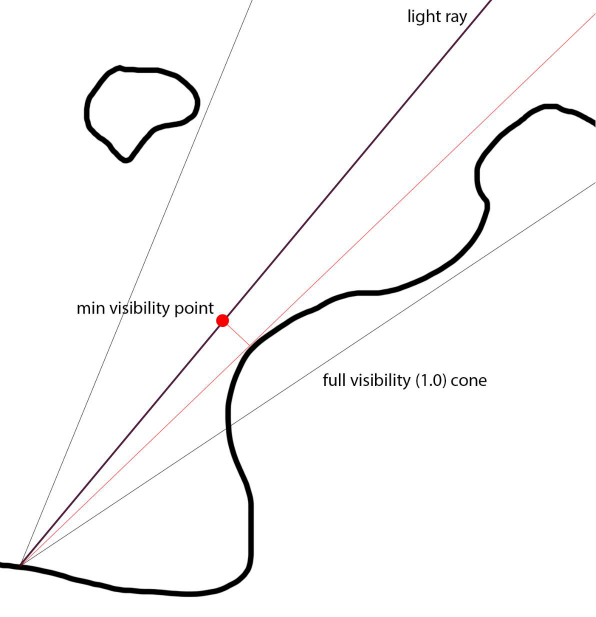

Claybook使用了軟陰影球體追蹤,用柔和的半影擴大陰影,沿光線步進SDF近似最大圓錐體覆蓋率,Demoscene圓錐體覆蓋近似:

c = min(c, light_size * SDF(P) / time);

並且對軟陰影進行了改進,即三角測量最近距離,Demoscene=單個樣本(最小),三角測量cur和prev樣本,更少條帶。抖動陰影光線,UE4時間累積,隱藏剩餘的帶狀瑕疵,較寬的內半影。

改進前後對比:

以往的LTC並不能處理遮擋的光照,但更真實的光影應該具備:

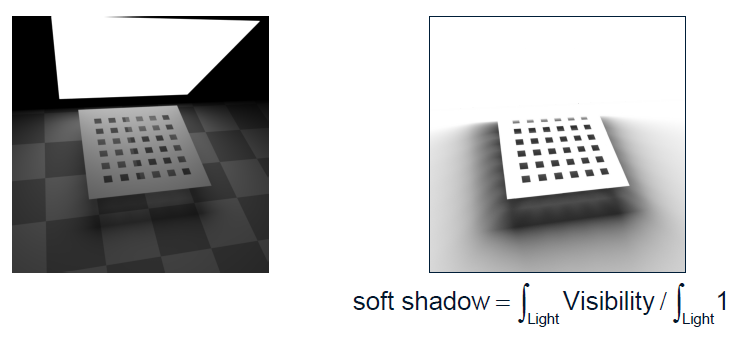

之前有文獻提出了僅光線追蹤的軟陰影,做法是平均可見性:

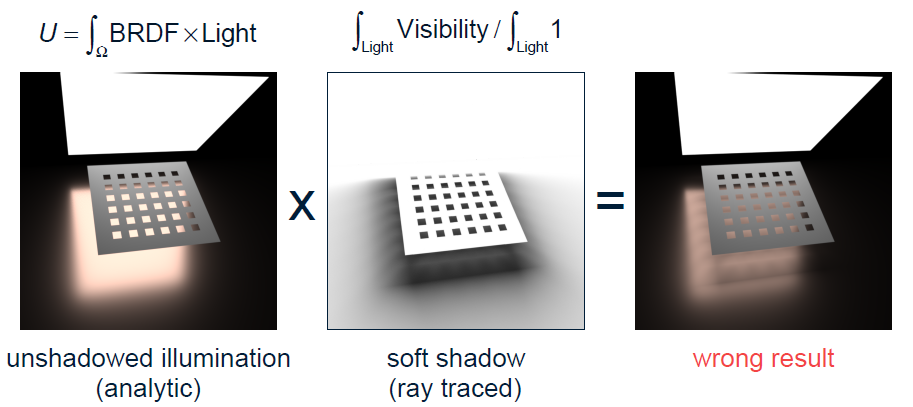

但如果使用BRDF獲得直接光,再乘以光線追蹤的平均可見性的軟陰影,將得到錯誤的結果:

正確的做法應該如下圖右邊所示:

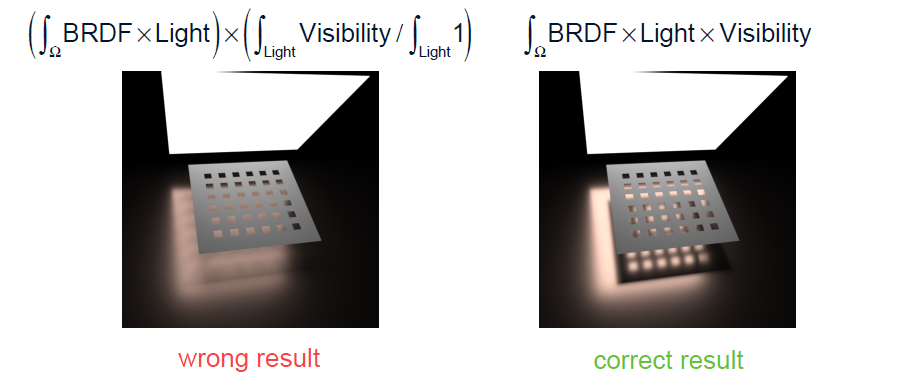

也可以採用隨機化的方式,但必須強制BRDF的所有項都是隨機化的:

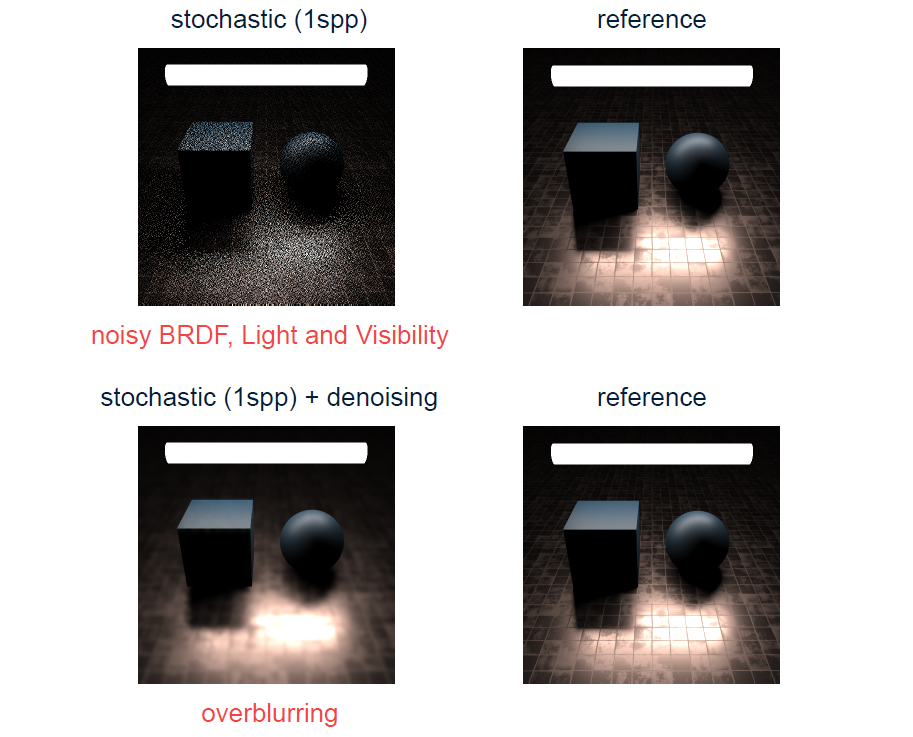

隨機化的結果是過多噪點和過於模糊:

所以僅光線追蹤的軟陰影和完全隨機化的兩種方案都將獲得錯誤或不良的結果。正確的軟陰影演算法應該如下所示:

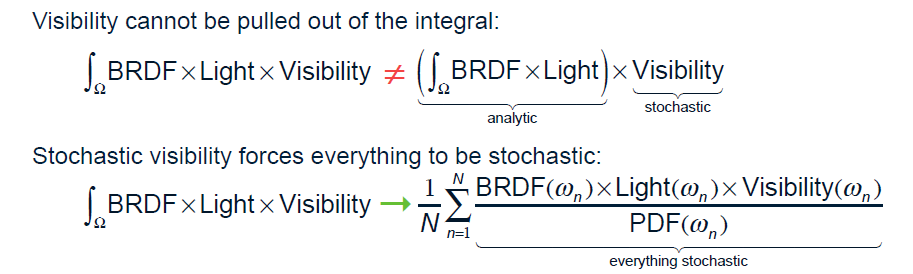

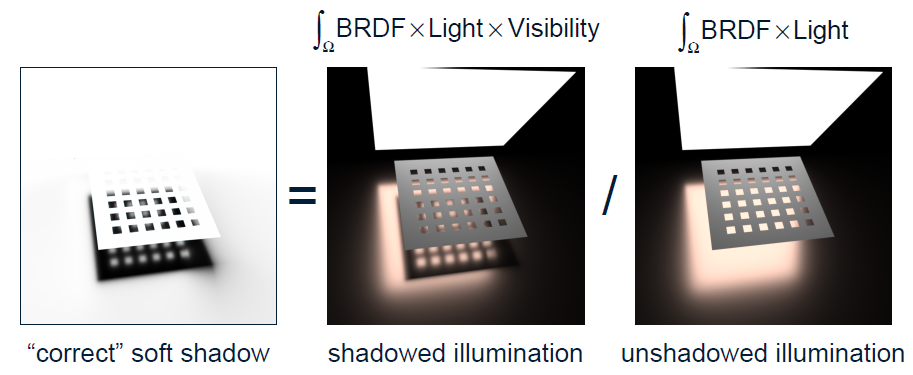

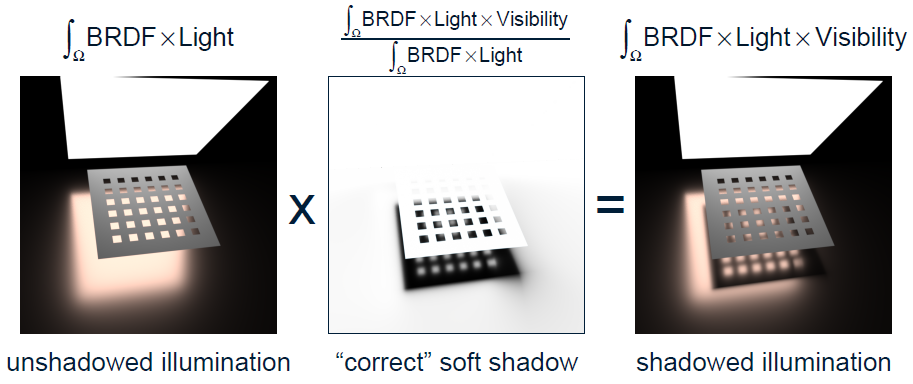

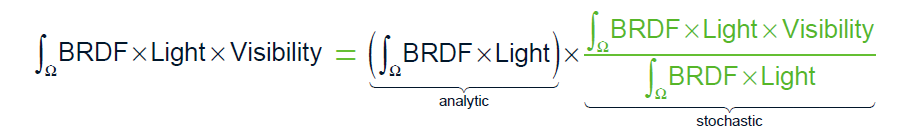

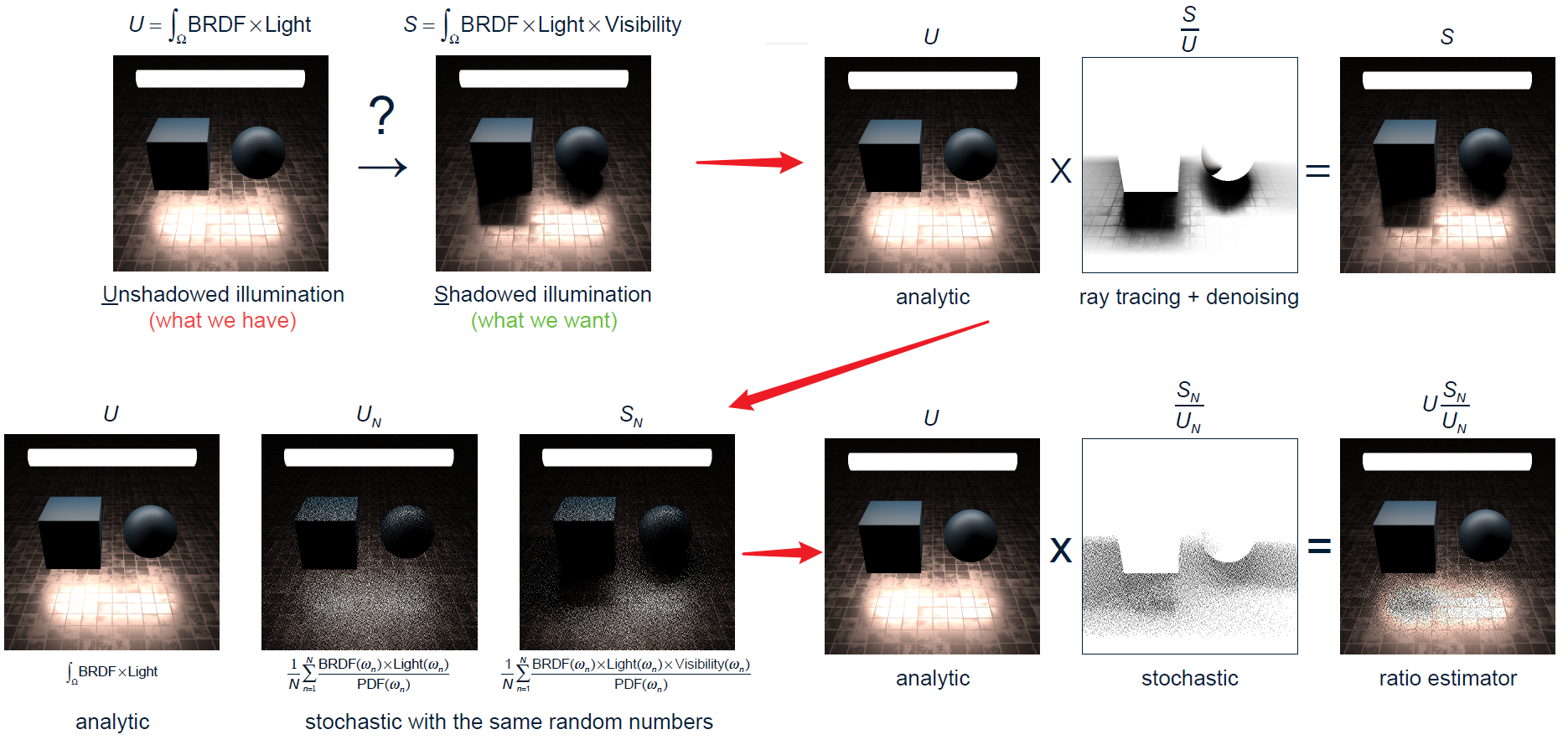

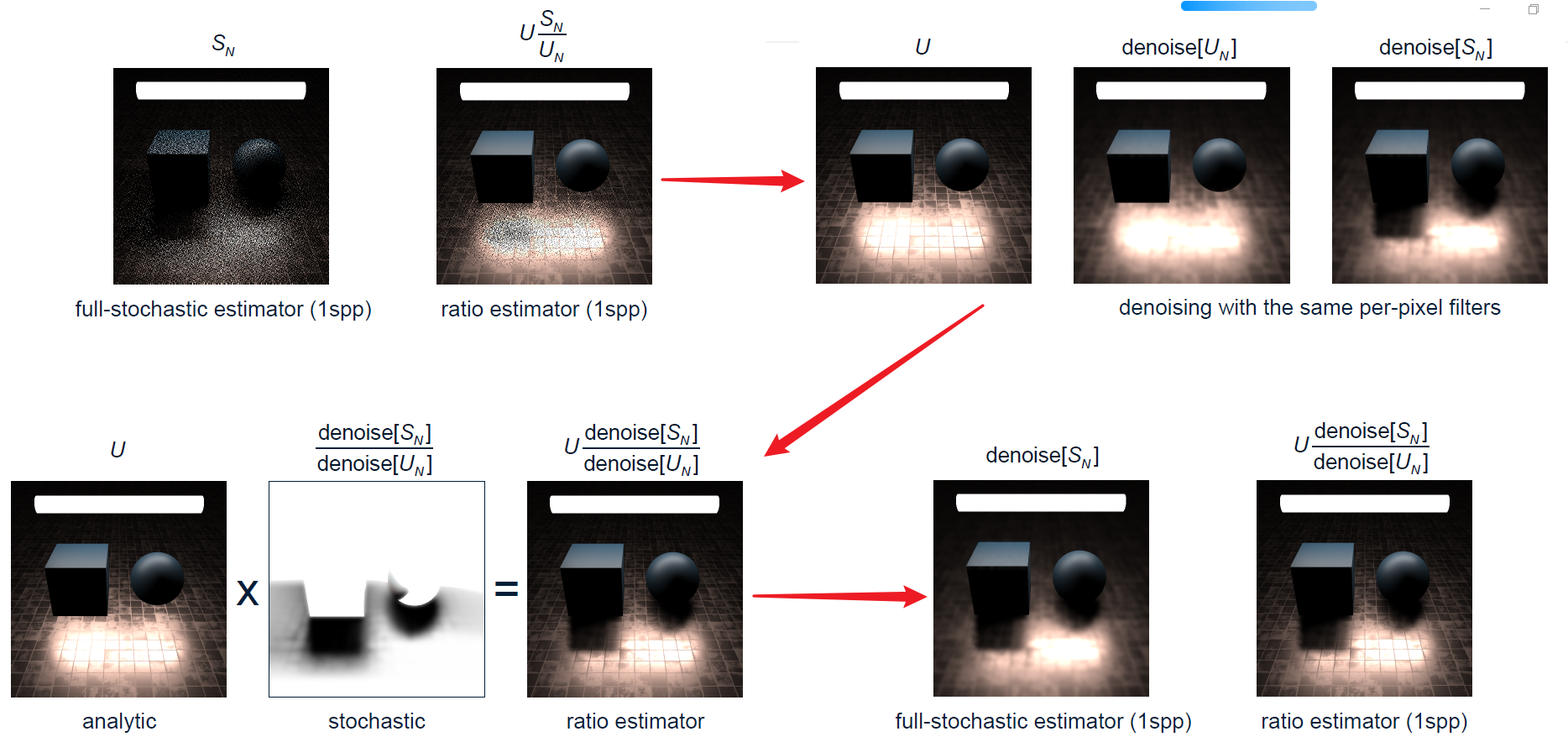

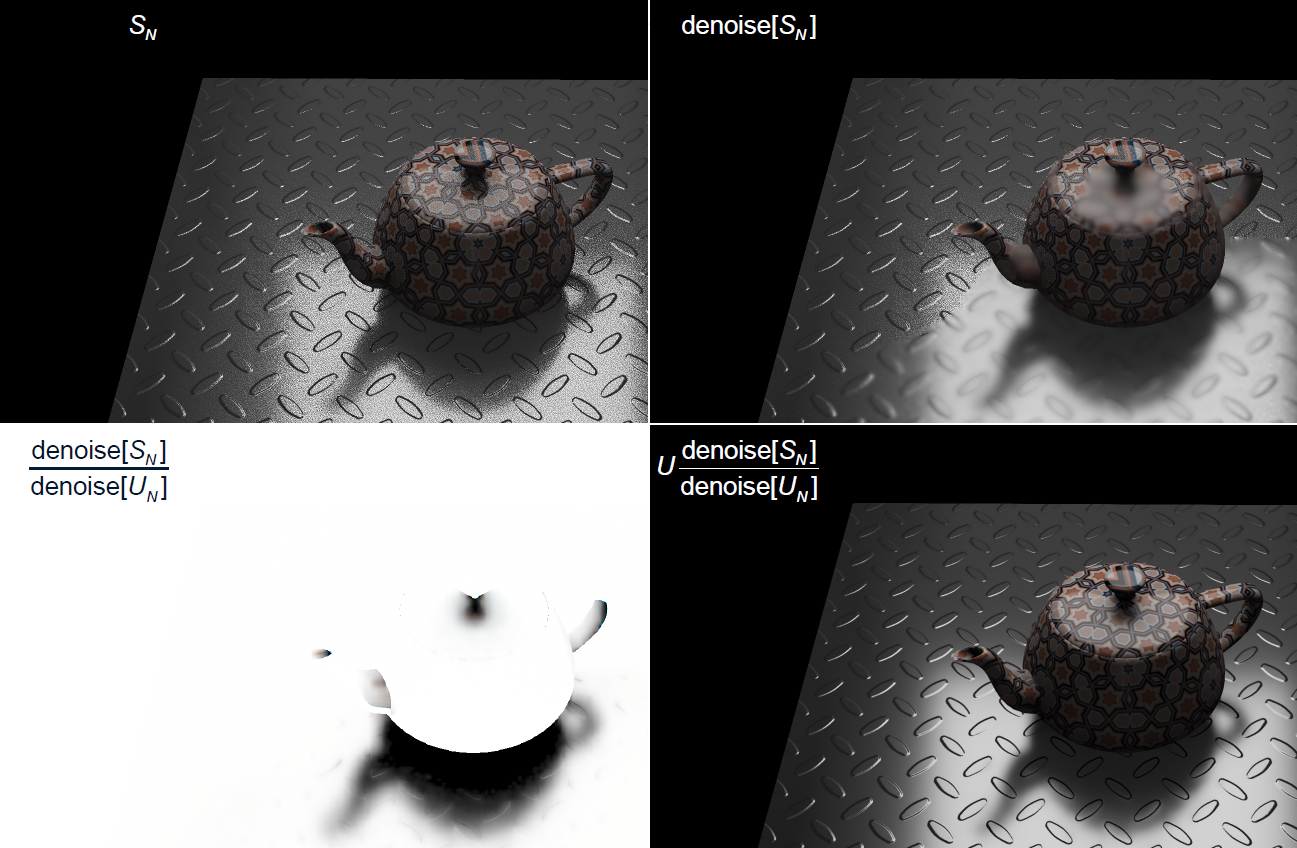

從數學上講,我們可以看到事情顯然是正確的:\(a·b/a=b\):

對應的正確隨機化公式:

更加準確的方法推導如下:

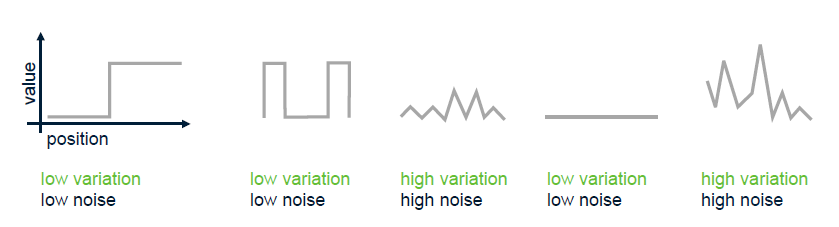

正確降噪的各個頻率的函數如下:

降噪圖例:

在取樣方面,使用了多重要性取樣:

對於電介質(非金屬),使用了電解質多重要性取樣:

最終效果對比:

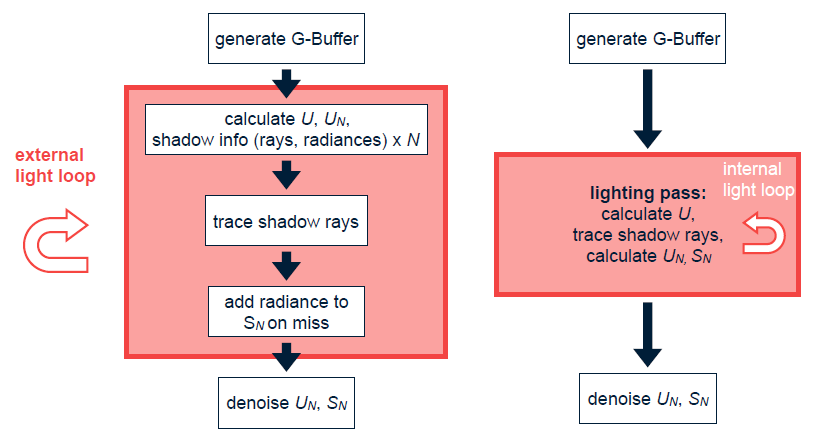

渲染通道和流程如下:

總之,比率估計器:無雜訊有偏分析+無偏雜訊隨機,作為穩健雜訊估計的總變化(非方差),由分析著色驅動的陰影多重要性取樣。實時光線追蹤GPU的注意事項包含活動狀態、延遲和佔用率、多重要性取樣的分支、波前與內聯,混合的光線+光柵圖形示例。

17.3.4 光線追蹤AO

環境遮擋可以被認為是由非常大面積的光源(即每個點上方的整個半球)進行的照明,類似於陰天的室外照明。下圖(a)顯示了來自兩個表面點的環境遮擋光線。在左側點,大部分光線擊中對象,因此遮擋較高;在正確的點上,幾乎沒有光線擊中對象,因此幾乎沒有遮擋。圖(b)顯示了茶壺場景中的環境遮擋。此圖顯示純環境遮擋;當然,可以與表面顏色、紋理等相結合。

Northlight Engine實現的SSAO和光線追蹤AO的對比圖如下:

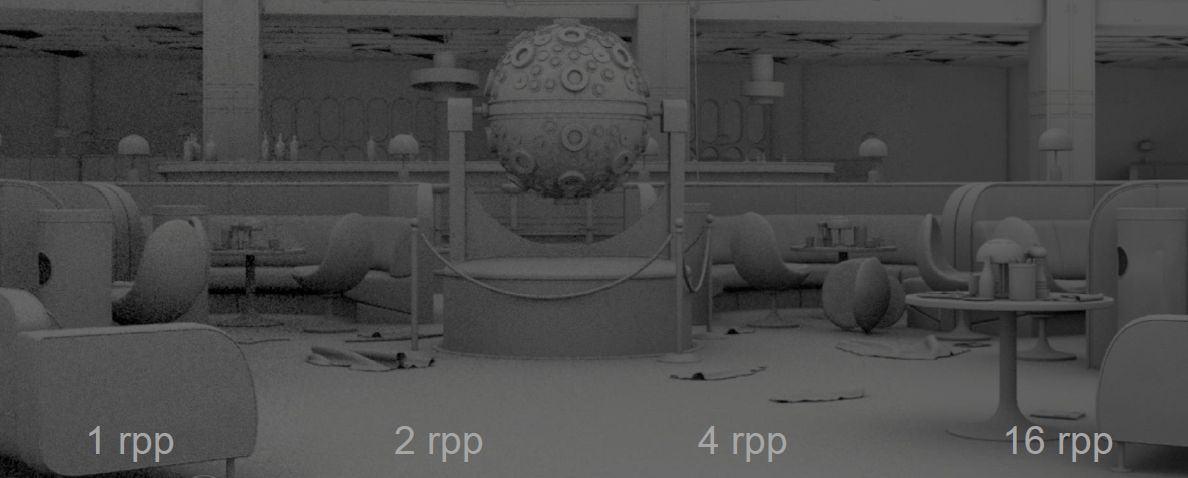

在不同的rpp(每像素光線數量)上,光線追蹤AO效果也有所不同:

Claybook在表面法線方向構造圓錐體,加上隨機變化+時間累積,AO射線使用低SDF mip,更好的GPU快取位置和更少的頻寬,軟遠程AO。Claybook也使用UE4的SSAO,小規模的環境遮擋。

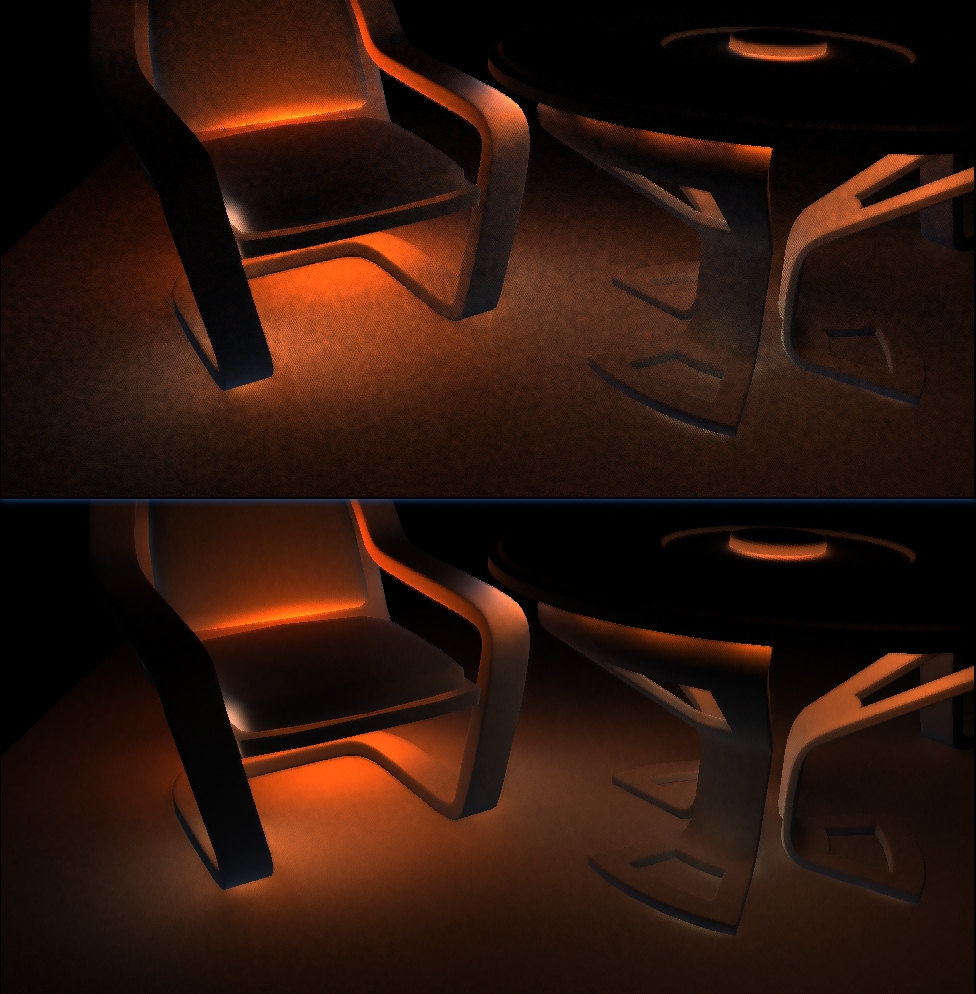

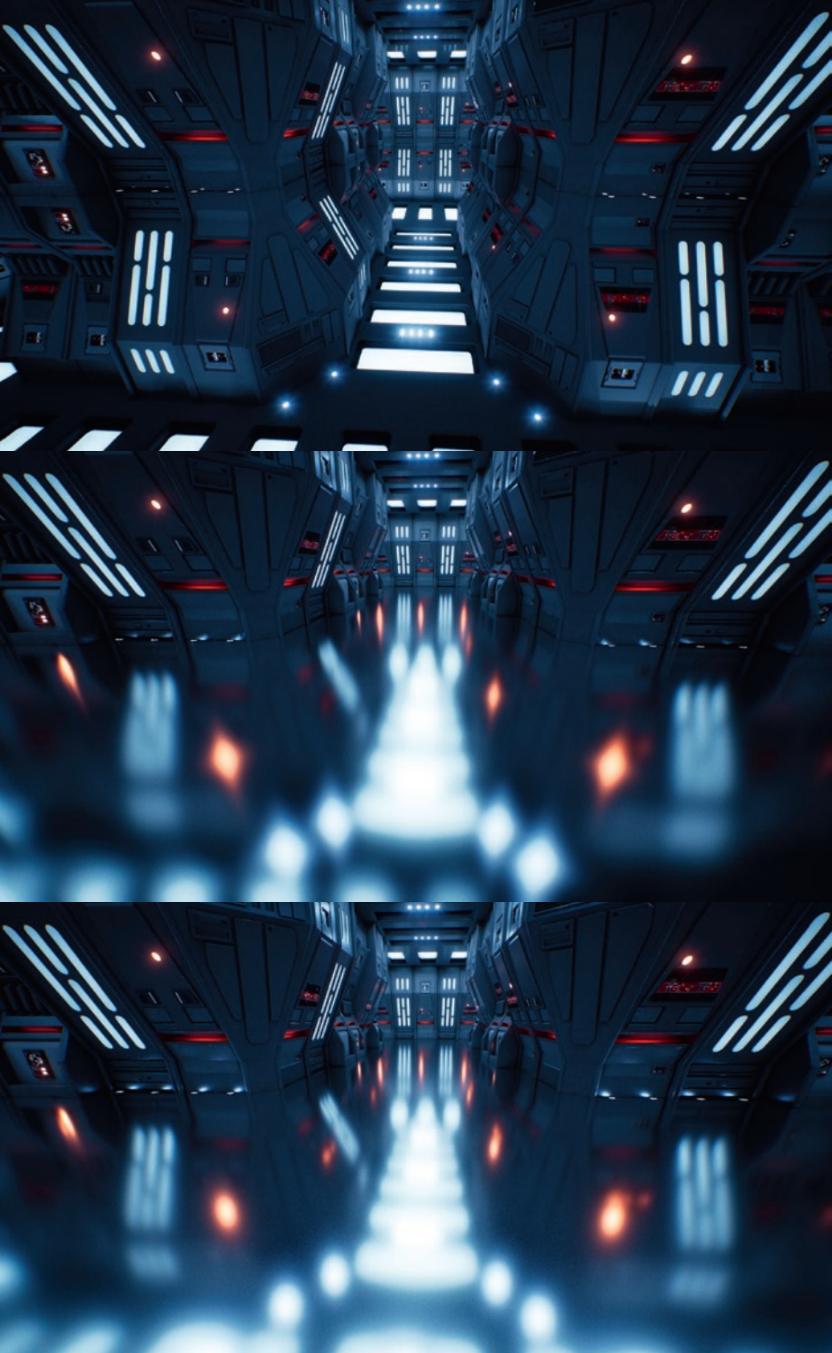

上:SSAO;下:SSAO + RTAO。

17.3.5 光線追蹤反射

當光線擊中完美鏡面反射表面時,它是否以與入射角相同的角度反射,基本物理定律最早由歐幾里德在公元前3世紀編纂。在現實世界中,反射對象很常見,不僅僅是金屬球!

對於光線追蹤反射,從反射表面發射一條額外光線,反射光線的方向使用反射定律從入射光線方向計算。光線照射場景中的對象時,使用與直接可見表面相同的照明計算對該表面進行著色。

間接光的光澤反射可以通過在光澤反射分布的方向內發射光線來計算。對於給定的入射方向和一對隨機數,反射模型提供反射方向。下圖顯示了兩個茶壺中的光澤反射,使用Ward(各向同性)光澤反射模型計算反射。

類似地,可以通過圍繞折射方向分布光線來計算光澤折射,可以產生輕微磨砂玻璃的外觀。

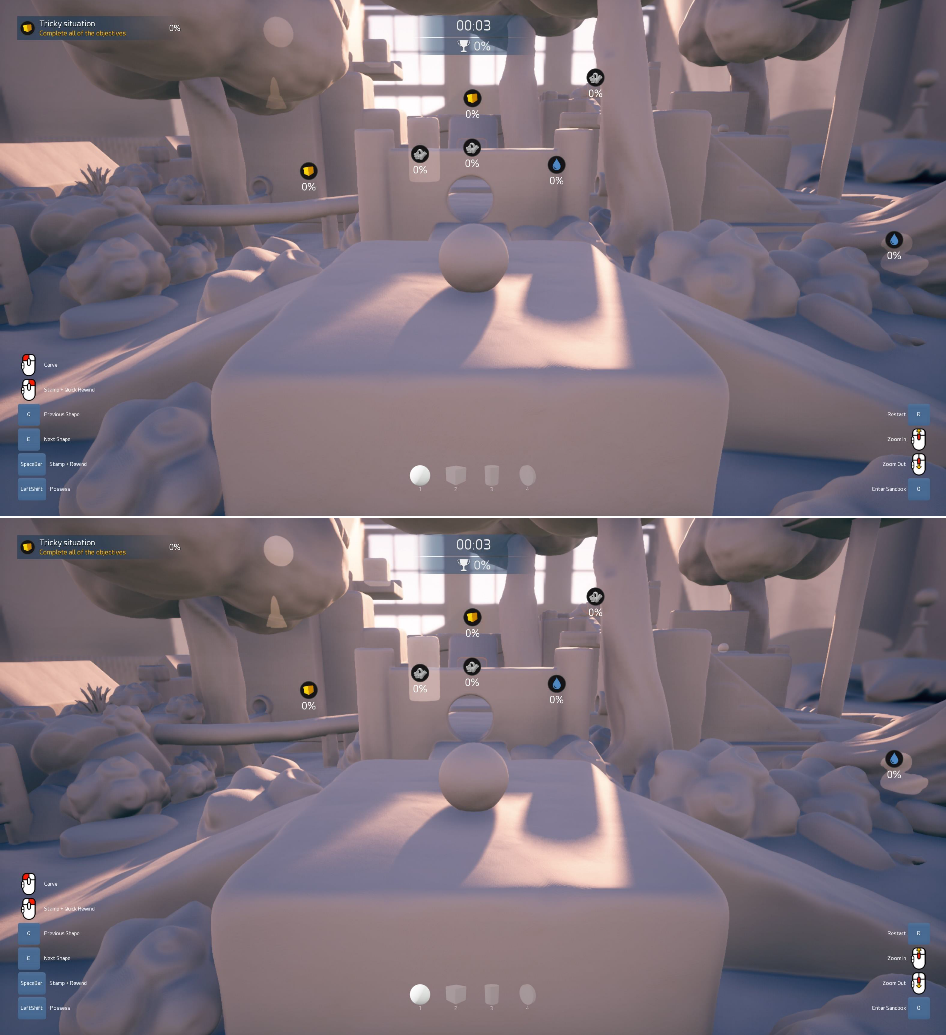

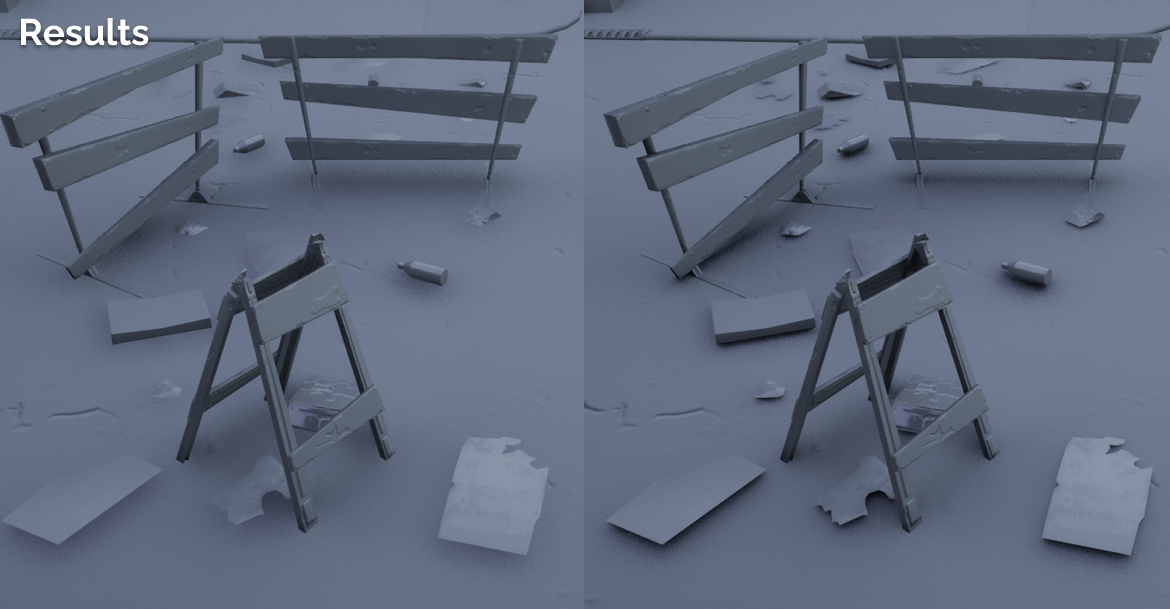

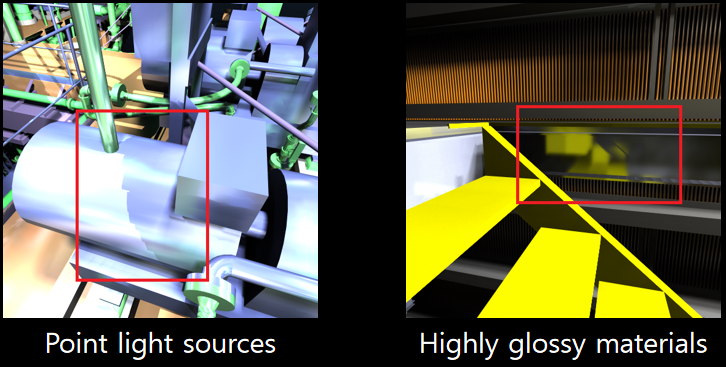

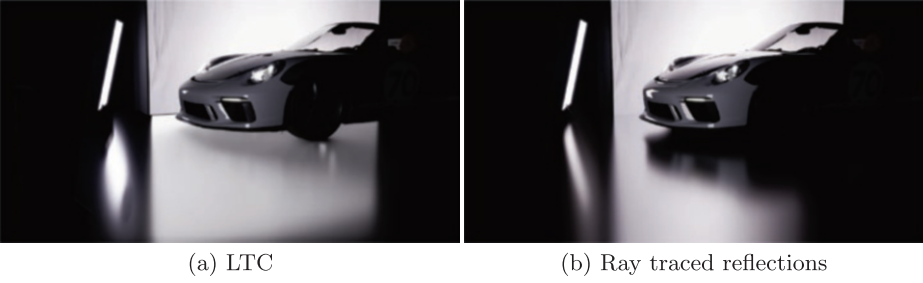

SSR和光線追蹤反射也有明顯的區別,SSR無法反射物體背面和螢幕以外的集合體,而光線追蹤反射沒有此限制:

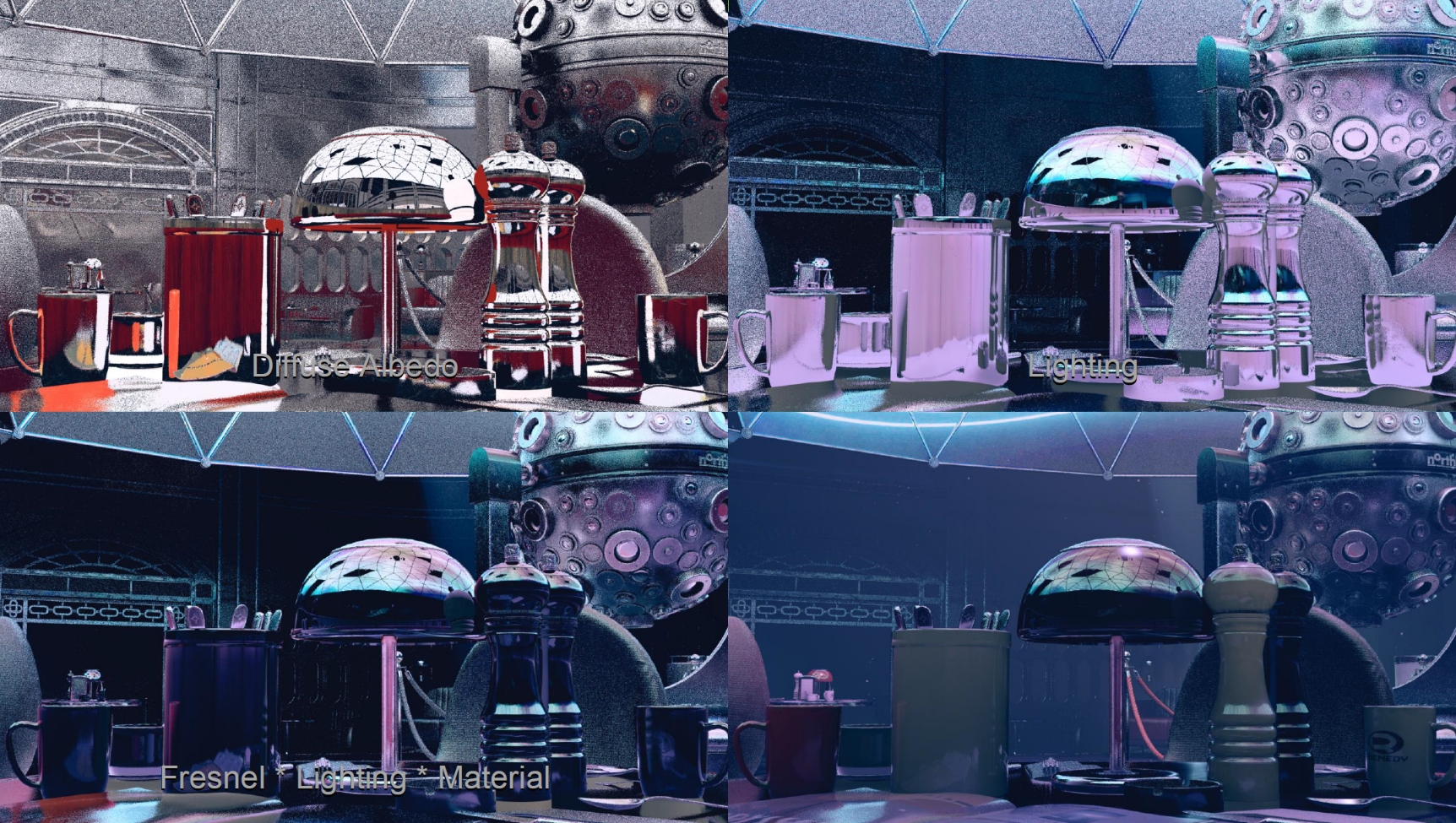

Northlight Engine實現的光線追蹤反射的各分量和合成效果如下:

對於不同的亮度,採用了不同的rpp,其中對亮度較高的像素採用更多的光線,且使用了抑制因子,最後結合陰影圖做優化。其組合過程圖例如下:

17.3.6 光線追蹤折射

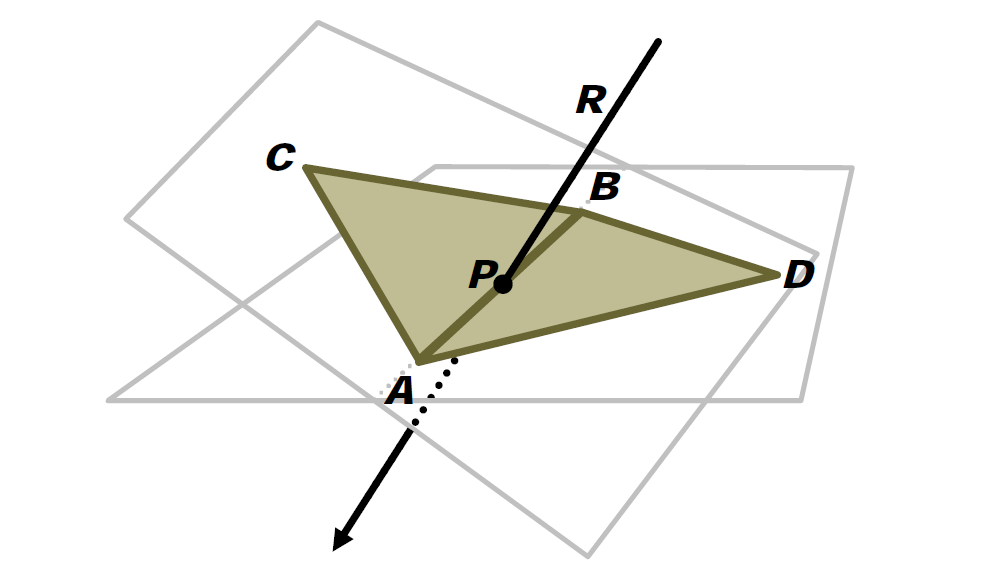

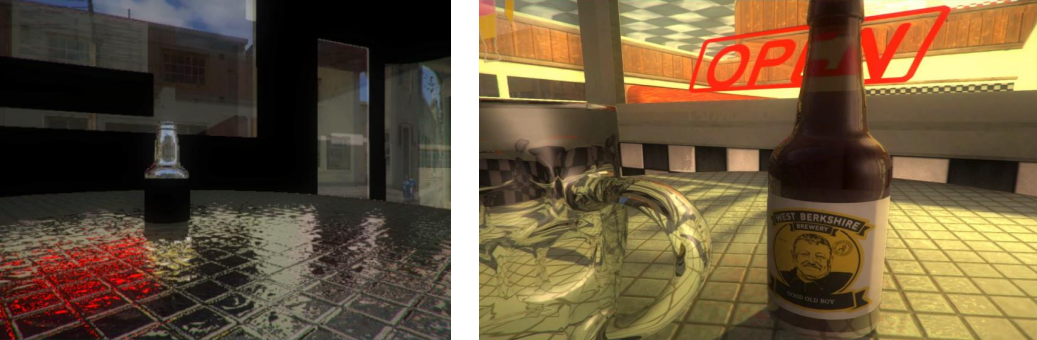

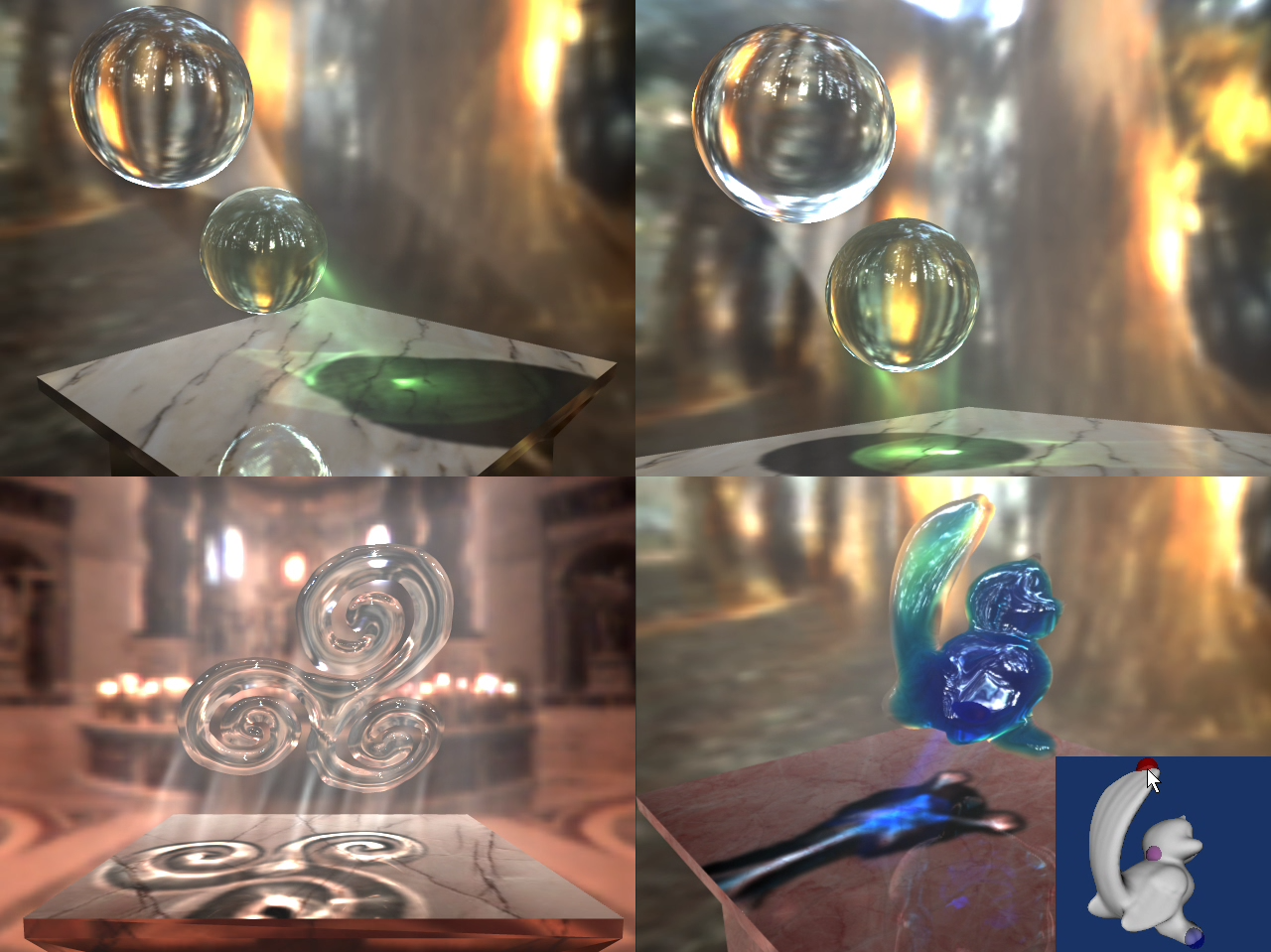

早在Siggraph 2008,周昆團隊就已經在研究基於光線追蹤的折射效果,實現了令人瞠目結舌的折射、反射、焦散、多重摺射、陰影、色散等等效果(下圖),該成果發表成論文Interactive Relighting of Dynamic Refractive Objects。

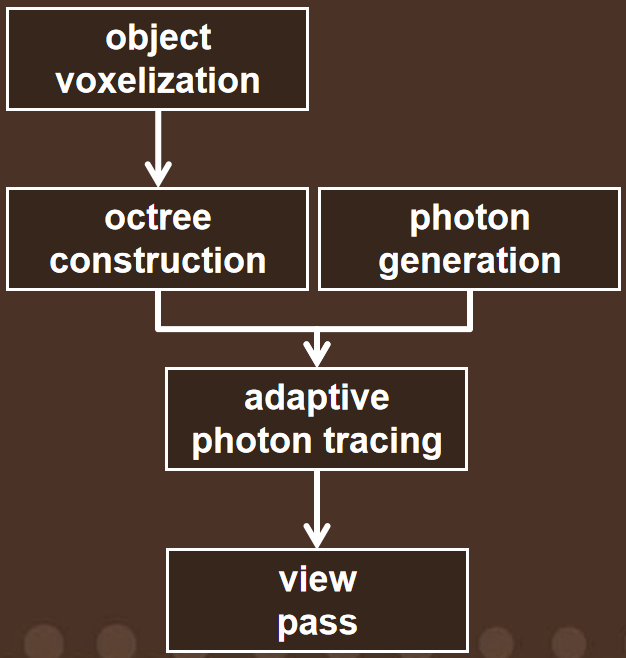

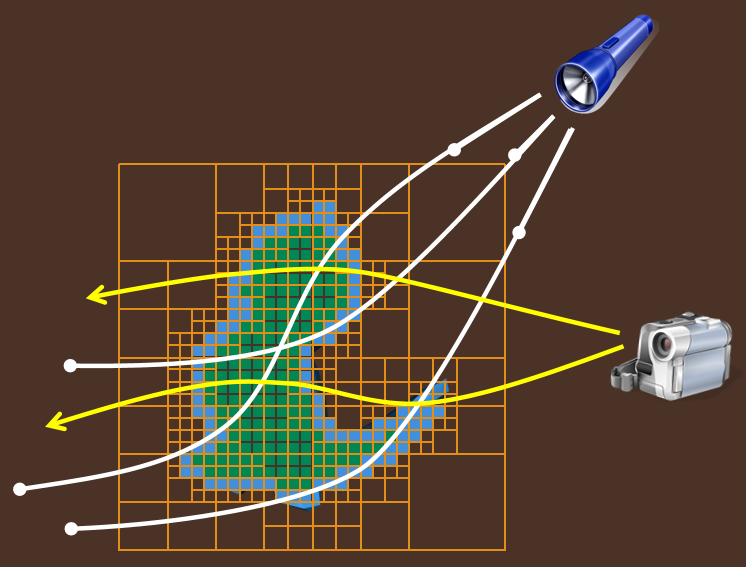

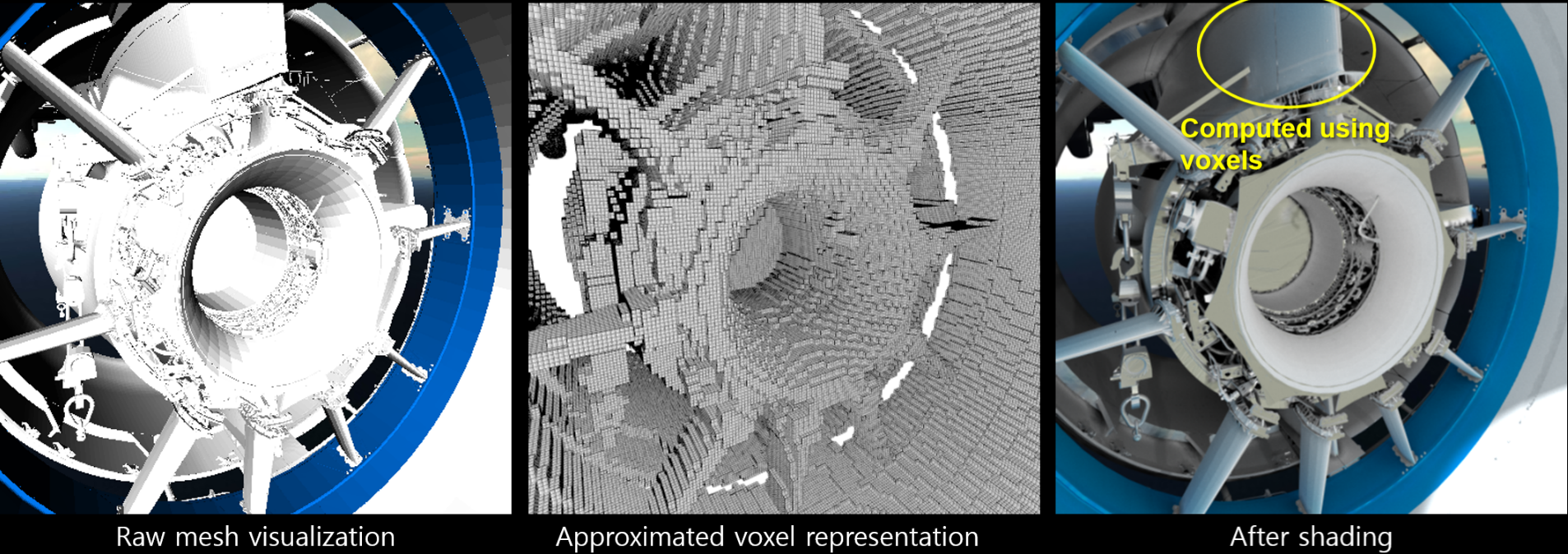

其實現流程主要是將物體體素化,生成八叉樹結構體來加速遍歷,然後採用自適應光子追蹤,從而實現高效且逼真的光線追蹤效果。

體素化的過程將三角形網格轉換為體積數據:

體素化使用GPU Gems III[Crane 07]的技術,僅在表面附近添加了超取樣,添加高斯平滑。

八叉樹構建時,使用密集3D數組代替稀疏樹,考慮折射率和消光係數,構造類似於mipmap。

生成光子時,在邊界框上生成光子,在折射對象的表面上生成光子,周圍體積必須為空,需要陰影貼圖來完成遮蔽。

將輻射直接存入體素,為每個光子步驟使用線段:

然後根據表面積的大小使用不同精度的數據(即八叉樹的不同節點數據):

不同追蹤技術的效果對比:

在view pass中,曲線觀察光線的軌跡,聚集光輝,考慮散射、衰減。同時忽略八叉樹,原因是影像對步長敏感,性能已經足夠好。

在2008年前後,採用128 x 128 x 128體積解析度、1024 x 1024初始光子、640 x 480影像解析度,使用NVIDIA GeForce 8800 Ultra渲染,可達到2到7fps。

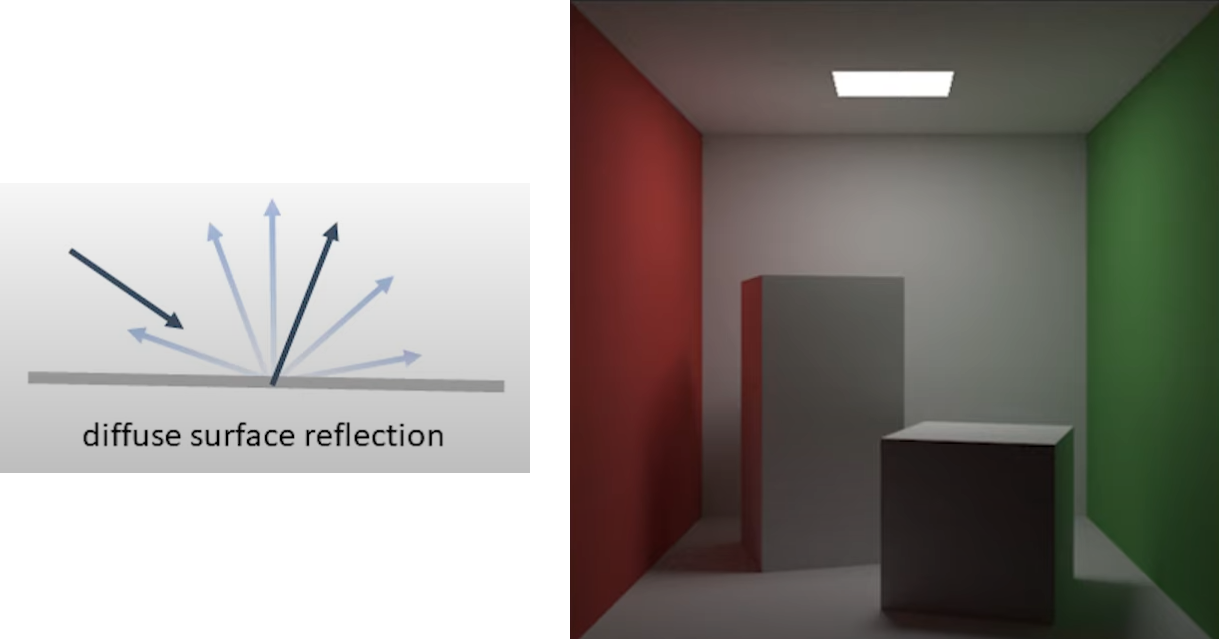

17.3.7 光線追蹤間接漫反射

Ward等人使用寬分布光線追蹤來計算間接漫射光。反射光線的分布覆蓋了每個點上方的整個半球,具有餘弦加權分布,因此在朝向極點的方向上追蹤的光線多於赤道附近的方向(下圖)。在該影像中,沒有環境光源;陰影區域中的任何光都是由於間接光的漫反射。請特別注意,白色棋盤格是如何在茶壺底部反射的,以及右茶壺上的壺嘴是如何將光線投射到茶壺主體的附近部分的。這種效果通常被稱為顏色溢出(儘管在這種情況下「顏色」是白色),並可以用附近對象的顏色對錶面著色。

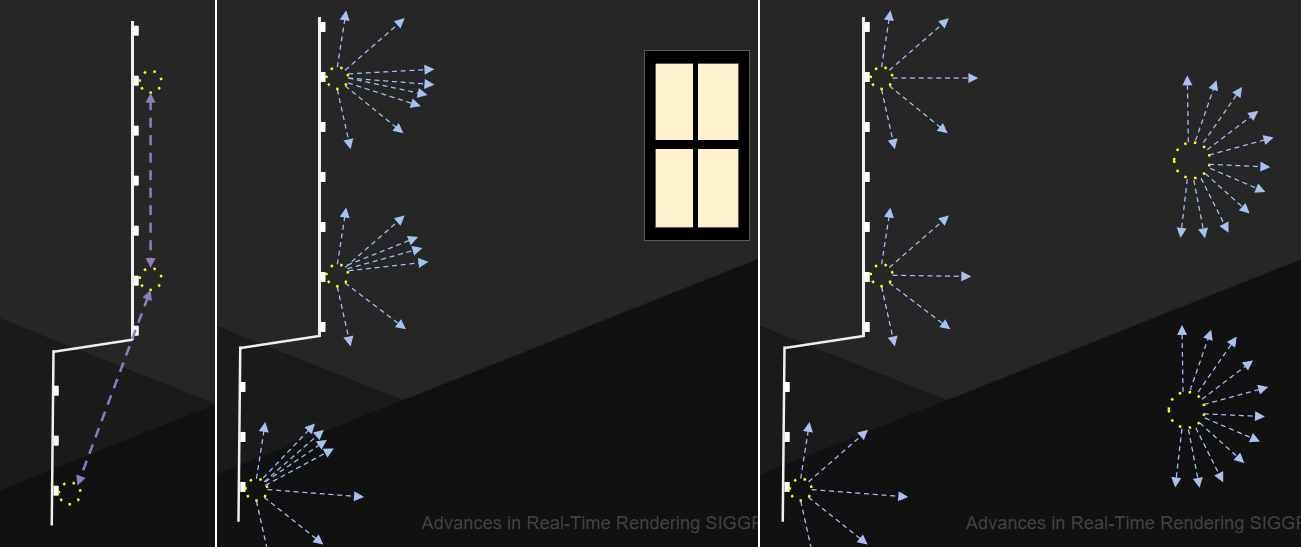

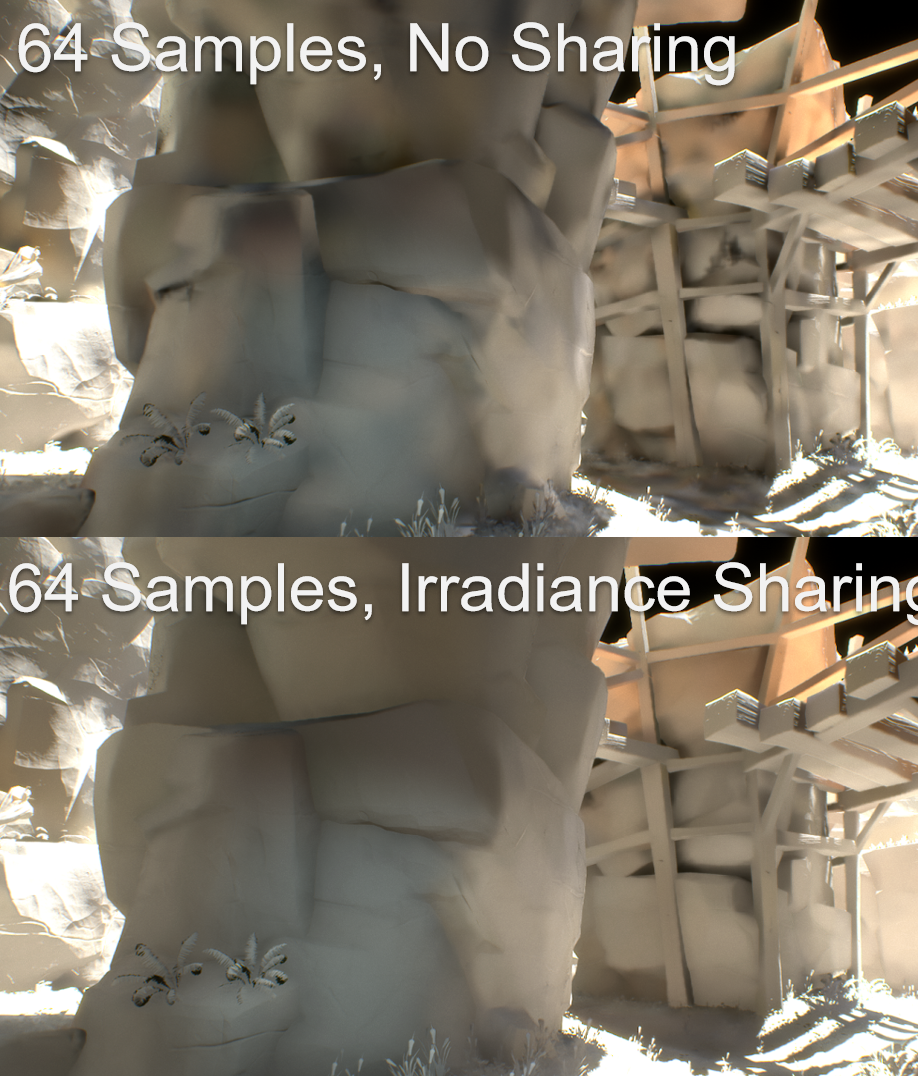

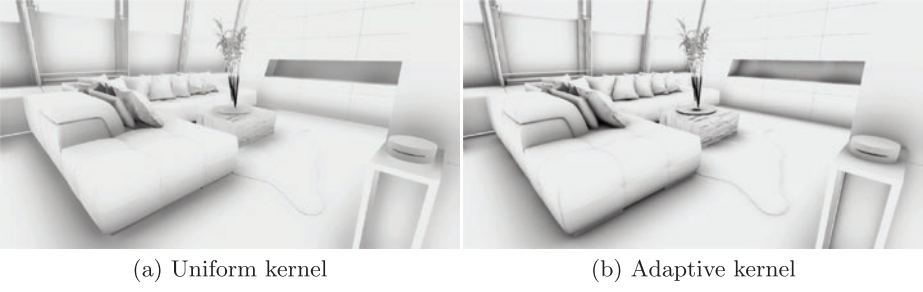

Northlight Engine在實現間接漫反射上,與AO類似,有許多非相干光線,GI存儲在稀疏網格體積中。基於靜態幾何圖形和靜態燈光集計算的輻照度,動態幾何體可以接收光,但不影響計算的輻照度,動態幾何沒有貢獻,三線性取樣創建階梯樣式,薄幾何體會導致光照泄漏,通過取樣餘弦分布上的輻射來收集照明,考慮丟失的幾何圖形(下圖)。

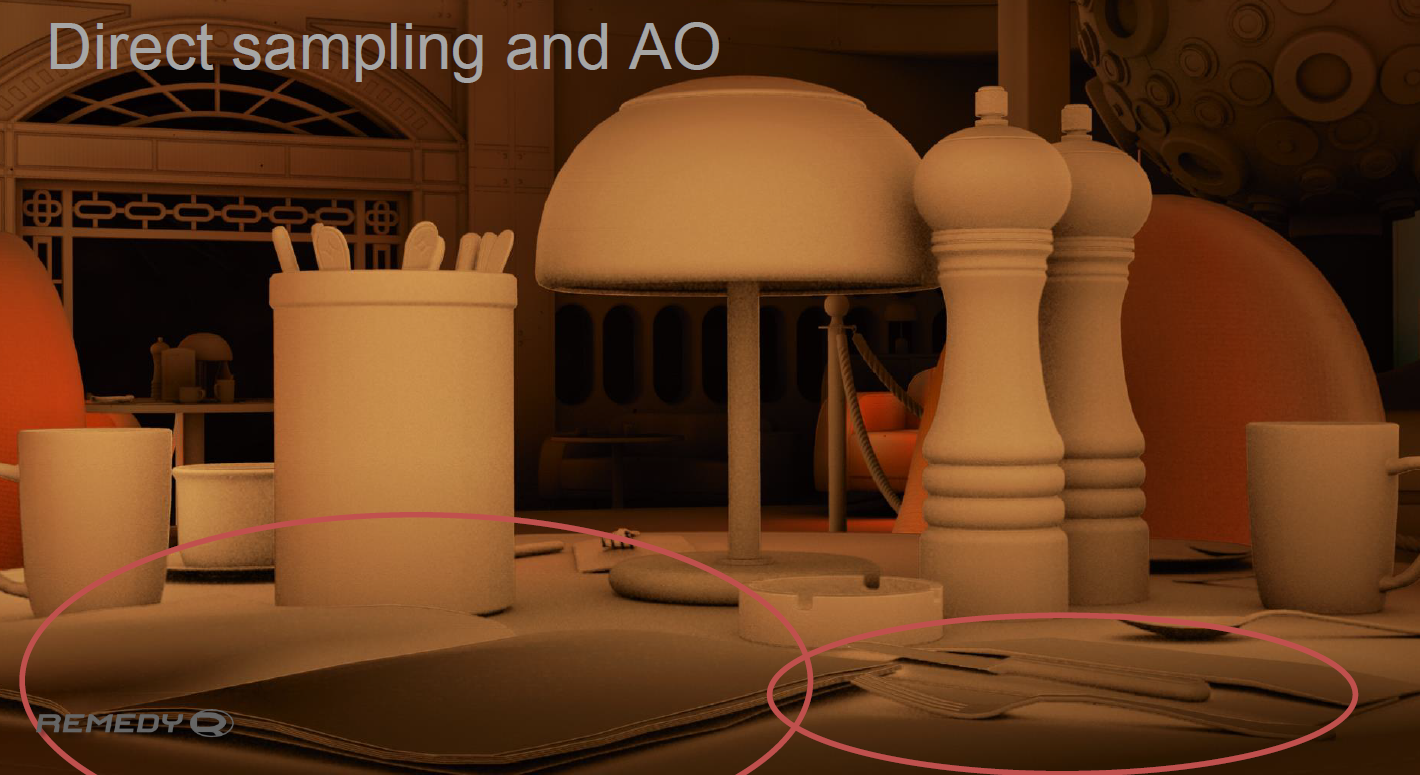

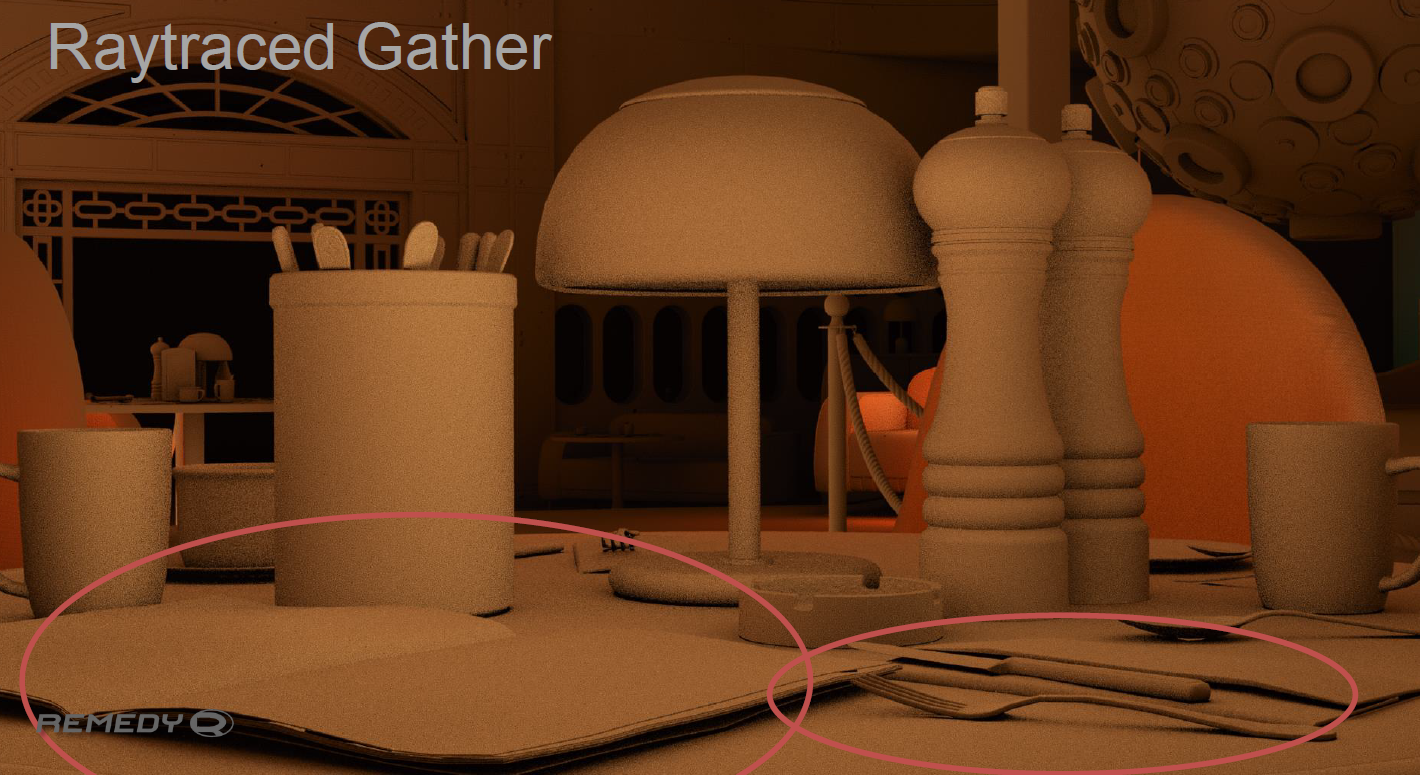

直接取樣和AO、光線追蹤收集的效果如下:

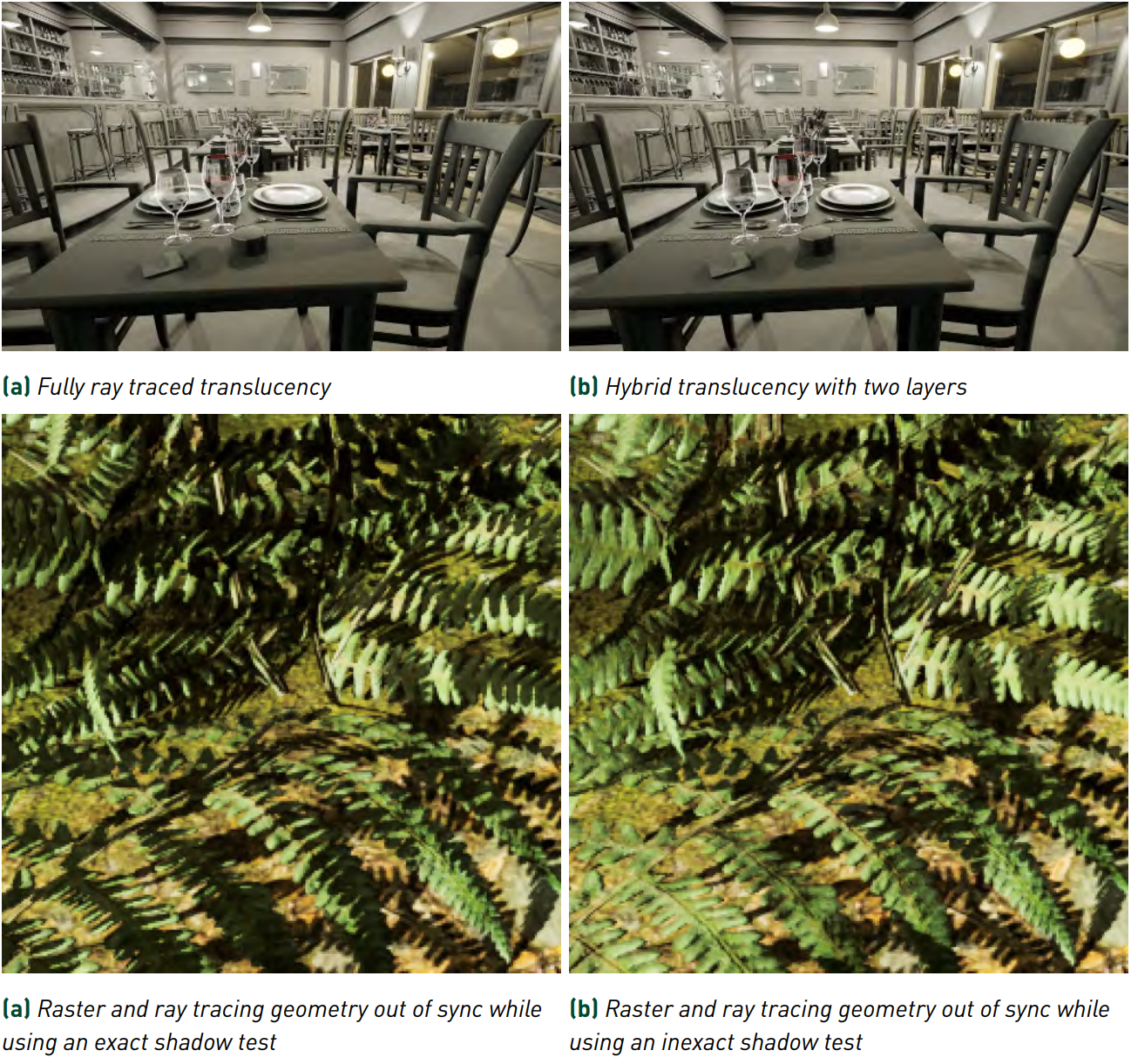

17.3.8 光線追蹤半透明

真正的透明度不是alpha混合!在現實光學中,當光穿過半透明物體時,一些光被吸收,一些光不被吸收。從表面的背面發射光線,像反射光線一樣的陰影,順序獨立。

當陰影光線擊中透明對象時,它將繼續朝向燈光。撞擊透明對象的陰影光線應進行著色並重新發射,就像它是非陰影光線一樣。陰影光線將穿過表面的完全透明區域,陰影光線從半透明對象獲取顏色。

除了以上特性,光線追蹤還可以實現互反射(Interreflection)、溢色、焦散、色散、DOF、運動模糊、複雜半透明、體積光霧、參與介質等等效果。

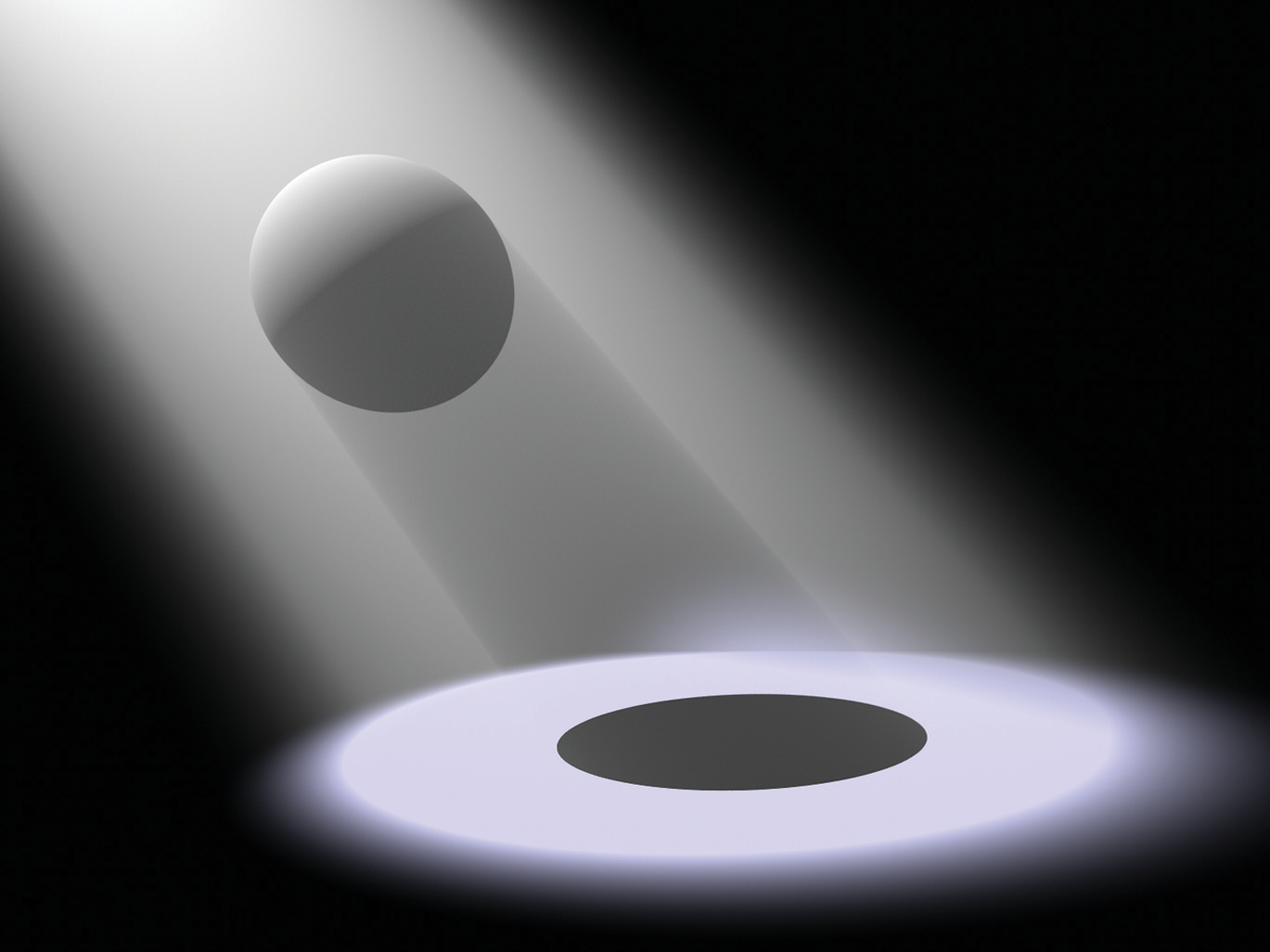

透過霧照在球體上的聚光燈。請注意,由於參與介質中的附加散射,聚光燈照明分布的形狀和球體陰影清晰可見。

17.3.9 降噪技術

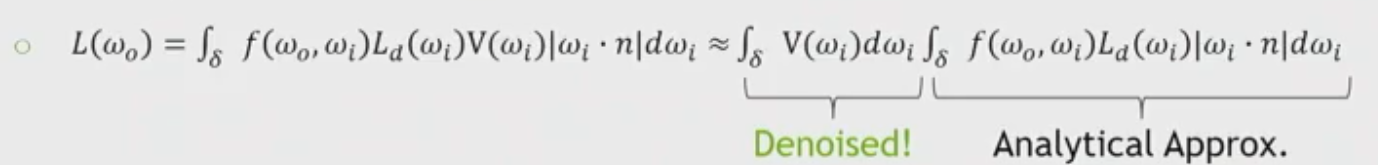

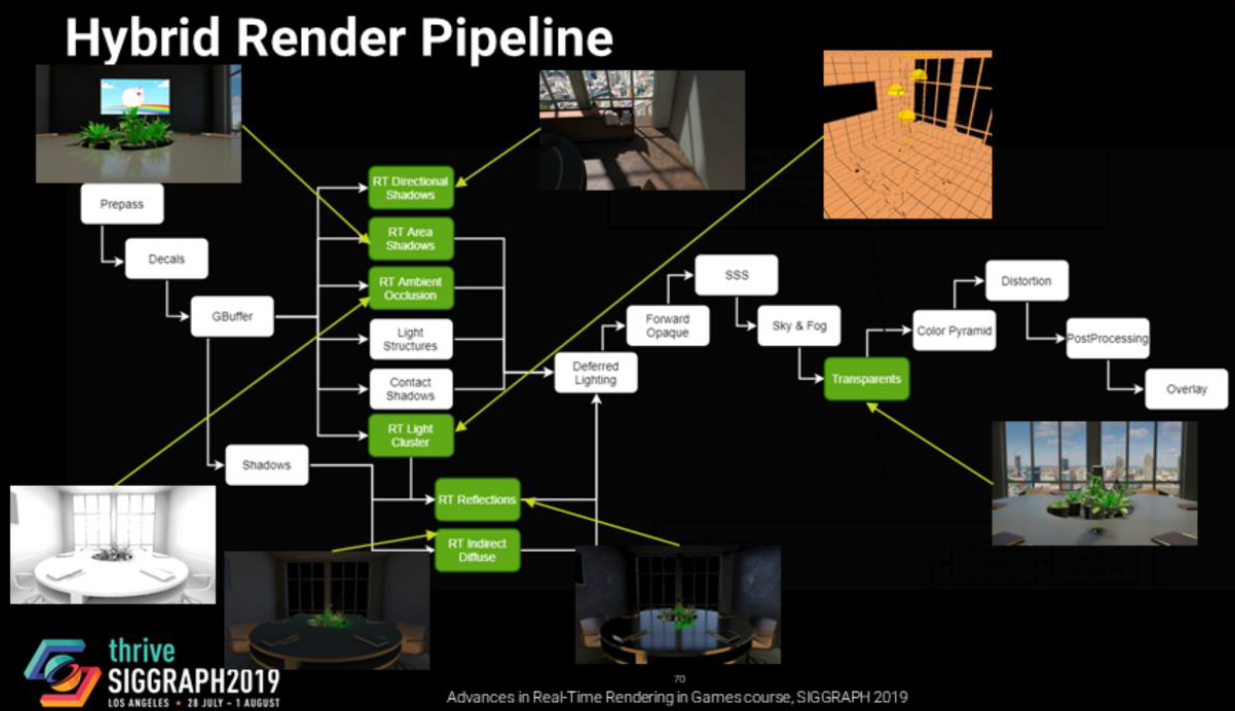

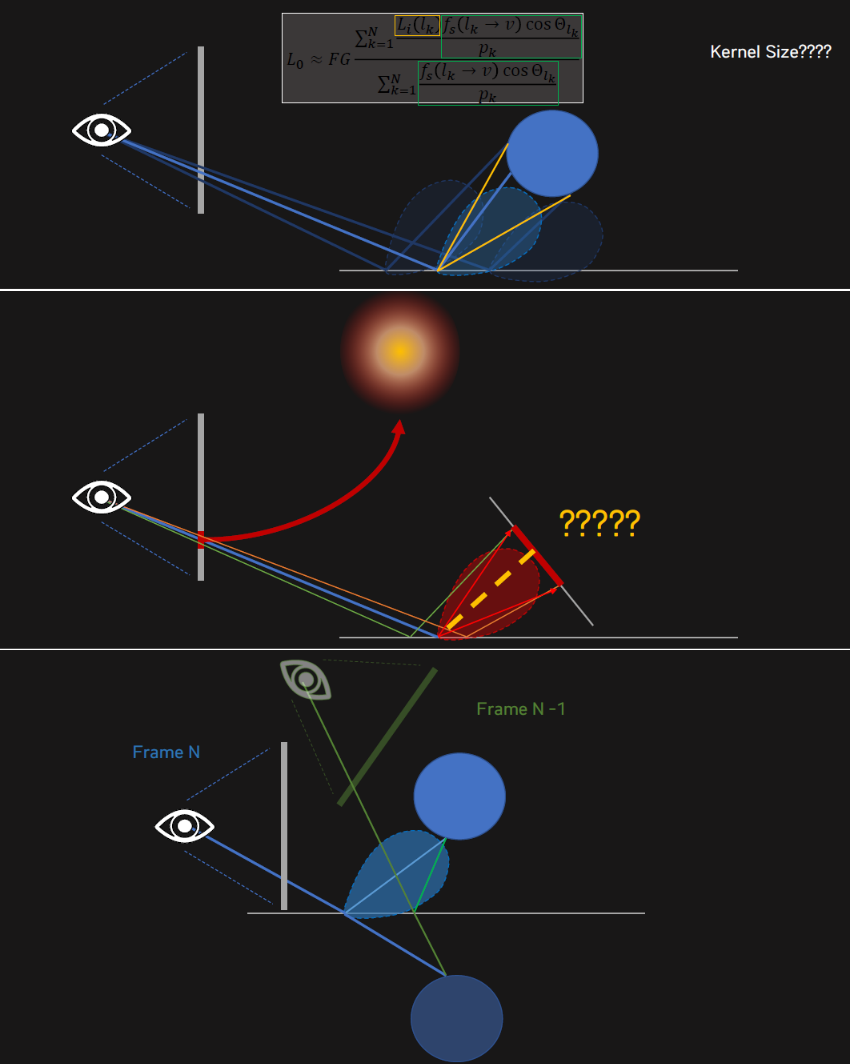

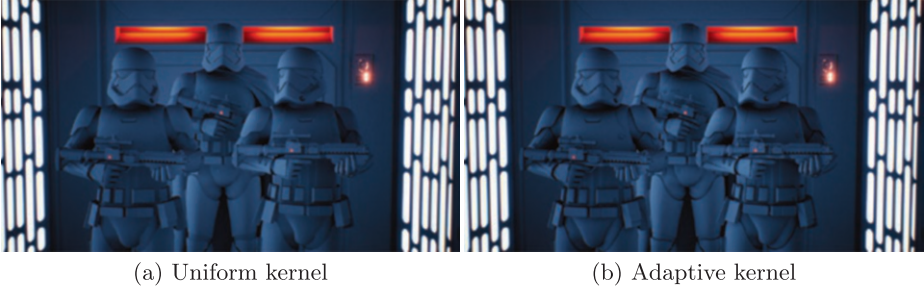

降噪技術只用於BRDF的可見項(光照項採用解析近似):

在實時光線追蹤領域,降噪演算法有很多,諸如使用引導的模糊內核的濾波,機器學習驅動濾波器或重要取樣,通過更好的准隨機序列(如藍色雜訊和時空積累)改進取樣方案以及近似技術,嘗試用某種空間結構來量化結果(如探針、輻照度快取)。

-

濾波(Filtering)技術。有Gaussian、Bilateral、À-Trous、Guided以及Median,這些方法常用於過濾蒙特卡洛追蹤的模糊照片。特別是由特性緩衝區(如延遲渲染的GBuffer)和特殊緩衝區(如first-bounce data, reprojected path length, view position)驅動的引導濾波器已被廣泛使用。

-

取樣(Sampling)技術。有TAA、Spatio-Temporal Filter、SVGF(Spatio-Temporal Variance Guided Filter)、Adaptive SVGF (A-SVGF)、BMFR(Blockwise Multi-Order Feature Regression)、ReSTIR(Spatiotemporal Importance Resampling for Many-Light Ray Tracing)等技術。

-

近似(approximation )技術。常用於嘗試微調路徑追蹤器的不同方面的行為。

-

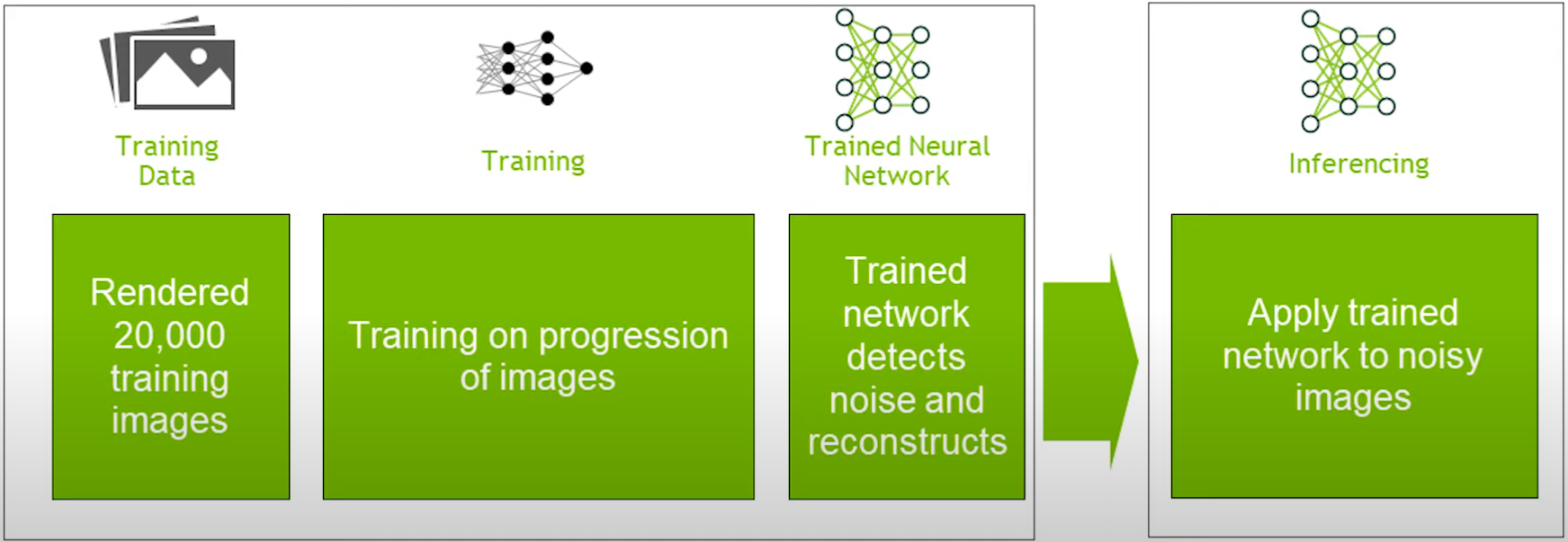

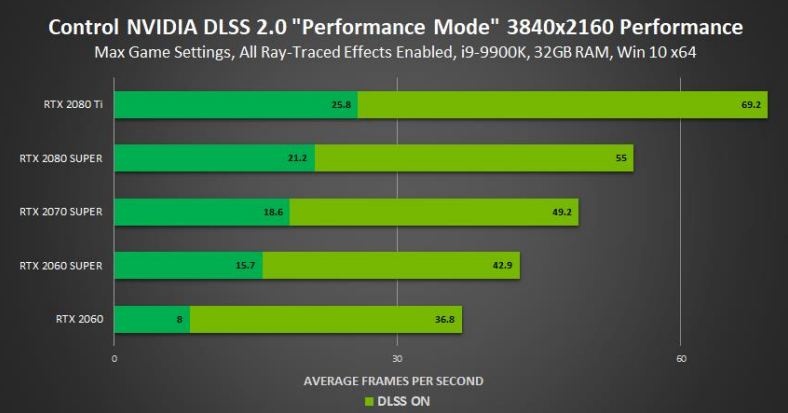

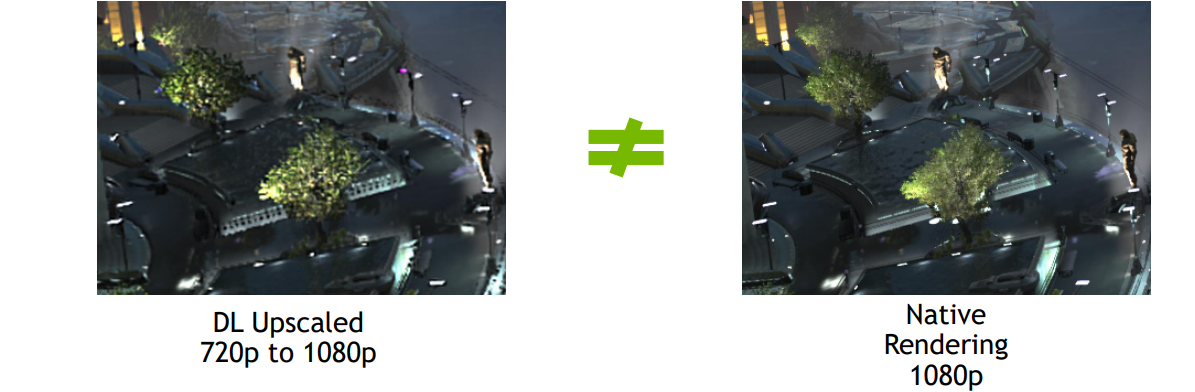

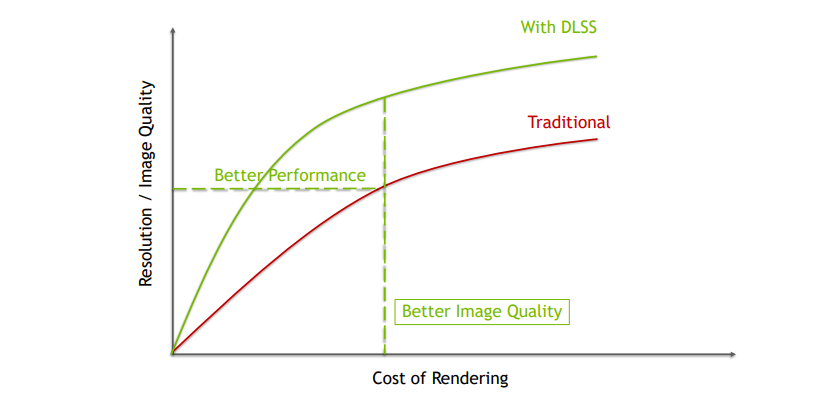

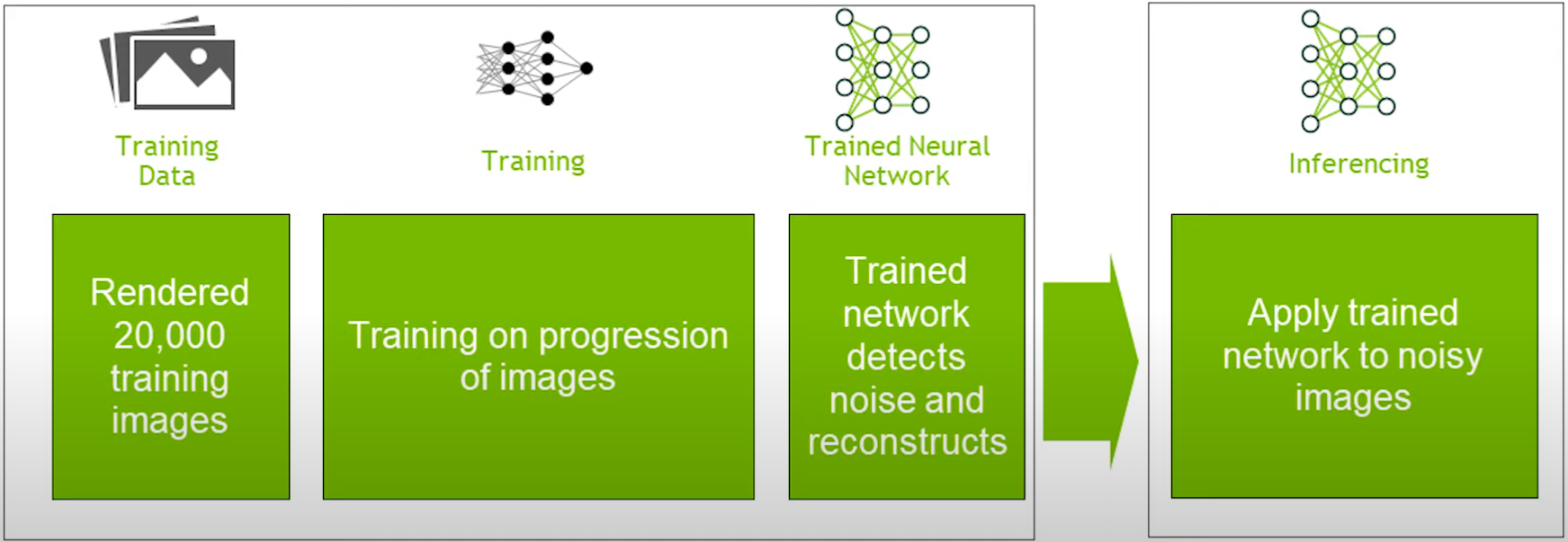

深度學習降噪技術。常見的有DLSS、OIDN、Optix等。Intel和NVIDIA等行業領先企業贊助了基於機器學習的降噪器的研究,Intel Open Image Denoise和NVIDIA Optix Autoencoder都使用降噪自動編碼器對影像進行降噪,取得了巨大成功。NVIDIA的深度學習超級取樣(DLSS 2.0)也被用於升級光線追蹤應用程式,如Minecraft RTX、Remedy Entertainment的控制等,目的是通過將原始影像的一部分上取樣到原生解析度來降低計算成本。深度學習超取樣(DLSS)是一种放大技術,它使用小的顏色緩衝區和方向圖將輸出解析度乘以2-4倍,是由NVIDIA預先批准的開發人員專用的,因此目前無法公開使用,也就是說,有其他替代方案,如 DirectML’s SuperResolution Sample。

NVIDIA基於AI的降噪架構圖。

下面抽取部分重要的降噪技術來剖析。

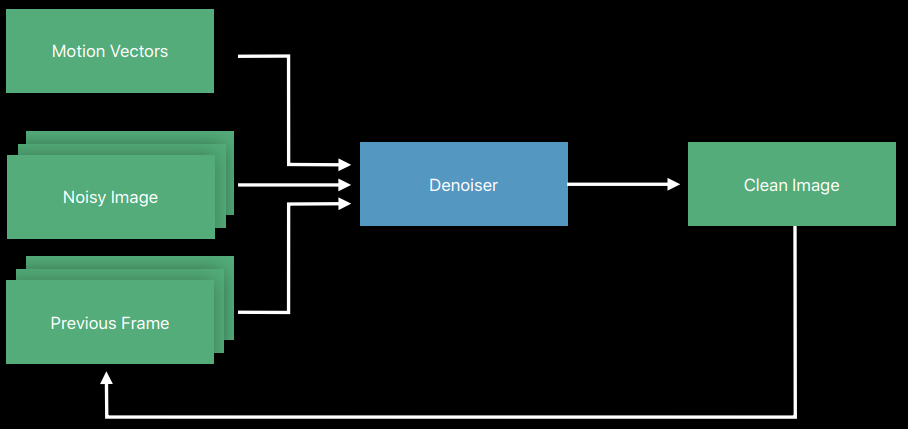

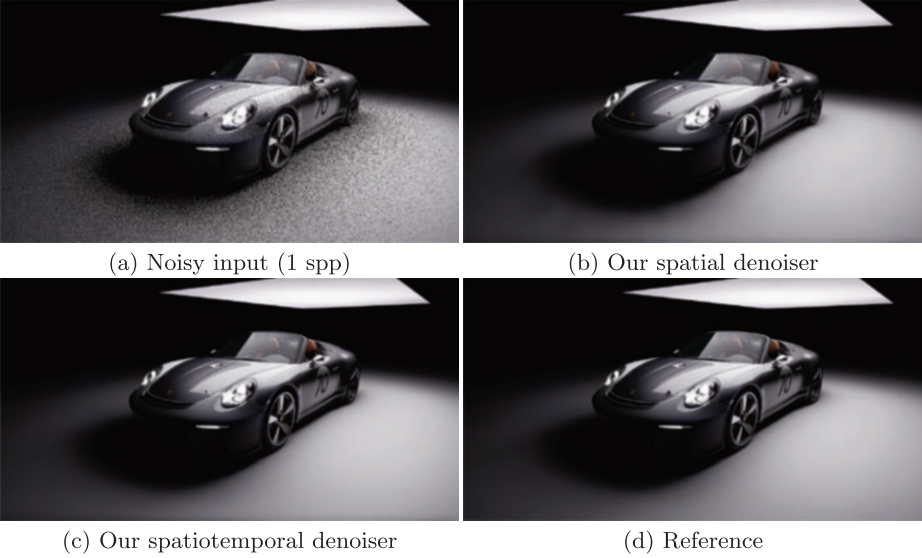

17.3.9.1 SVGF / A-SVGF

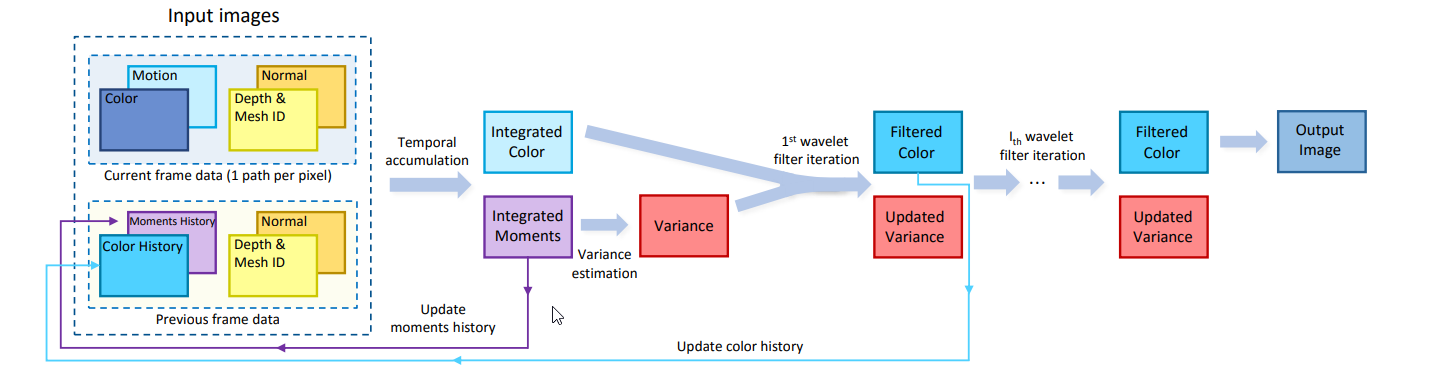

時空方差引導濾波器(SVGF)[Schied 2017]是一種降噪器,使用時空重投影以及特徵緩衝器(如法線、深度和方差計算)驅動雙邊濾波器模糊高方差區域。

SVGF將噪點輸入轉換為完整影像,通常需要10毫秒才能運行,因此將其集成到實時光線追蹤器中可能沒有好處。深度學習過濾器可能在更短的時間內完成類似的任務。然而,該技術非常擅長重建最終影像,尤其是調整版本(A-SVGF,自適應SVGF)。NVIDIA聲稱,與之前的互動式重建濾波器相比,提供了大約10倍的時間穩定結果,匹配參考影像的效果更好5-47%(根據SSIM),並且在1920×1080解析度的現代圖形硬體上僅運行10毫秒(15%以內誤差)。

自適應時空方差引導濾波(A-SVGF)[Schied等人2018]是一種較新的技術,在SVGF基礎上進行了改進,消除了閃爍等問題,通過自適應地重用根據時間特徵(如編碼在矩緩衝器中的方差、視角等的變化)在空間上重新投影的先前樣本,並使用快速雙邊濾波器對其進行濾波,改進了SVGF。因此,與基於歷史長度累積樣本不同,矩緩衝區充當替代色調,使用方差的變化來驅動舊樣本和新樣本的比例,從而減少重影。雖然SVGF僅使用矩緩衝器來驅動模糊,但A-SVGF將其用於濾波和累積步驟。

雖然引入力矩緩衝區有助於消除時間延遲,但並不能完全消除時間延遲。具有大量累積樣本的區域和新區域之間可能存在亮度差異。這在光線追蹤場景的較暗區域(如室內)中尤其明顯。為了緩解這種情況,最好在場景的黑暗區域使用2 spp,而不是使用每像素1個取樣(1 spp)。

Quake 2 RTX使用A-SVGF作為其去噪解決方案。

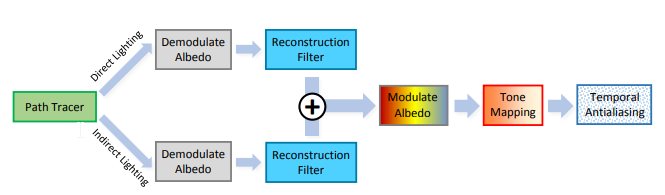

路徑追蹤器/光線追蹤器提供直接和間接照明,經過重建濾波器並被合併。然後,對結果應用色調映射和TAA(可以替換為色調映射+DLSS)。

g)

g)

如上圖所示,重建濾波器使用時間累積來確定積分顏色/矩,並使用方差估計來獲得濾波後的顏色。意味著我們需要歷史緩衝區(來自先前的幀重建),需要光柵化來提供法線、反照率、深度、運動矢量和網格id。

Minecraft RTX使用特殊形式的SVGF,添加了輻照度快取,使用光線長度更好地驅動反射,並對透射表面(如水)進行分割渲染。SVGF雖然非常有效,但確實引入了在遊戲中可能注意到的時間延遲。

17.3.9.2 ReSTIR

多光線追蹤的時空重要性重取樣(ReSTIR)[Bitterli等人2020]試圖將實時降噪器的時空重投影步驟移到渲染的早期,重用來自相鄰取樣概率的統計數據。本質上是一篇早期論文的結合,討論了重取樣重要性取樣,並添加了時空去噪器引入的思想。

ReSTIR將可用於NVIDIA的RTXDI SDK。已被NV實現在UE的分支中,源碼在//github.com/NvRTX/UnrealEngine/tree/NvRTX_Caustics-4.27。詳細的原理參見Spatiotemporal Reservoir Resampling (ReSTIR) – Theory and Basic Implementation。

17.3.9.3 DLSS

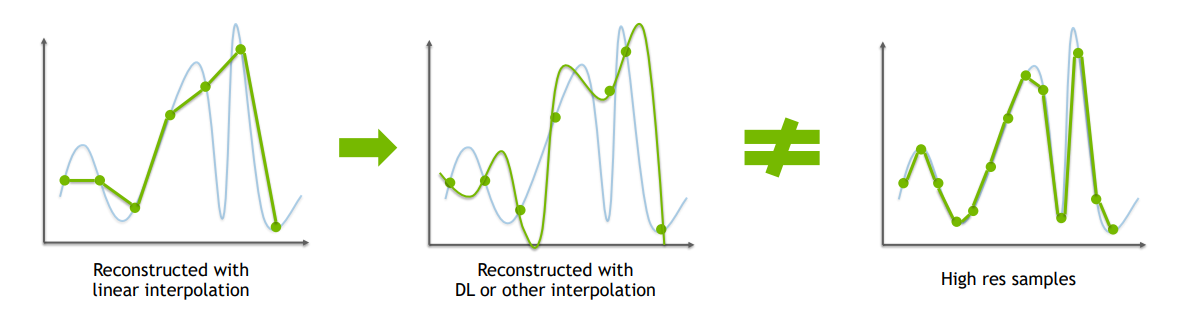

在DLSS面世之前,NV已經有AI超取樣:

DLSS利用AI的學習能力,將低解析度的輸入畫面,上取樣成高清(接近原生解析度)的畫面:

利用DLSS2.0將1080P上取樣到4K比原生4K有了巨大的性能提升(2x到5x):

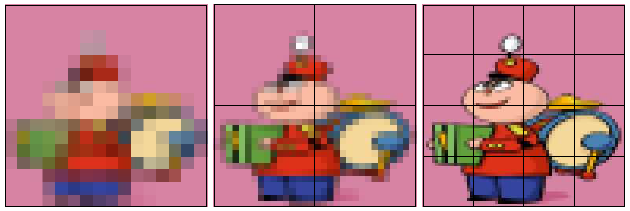

傳統初級的抗鋸齒演算法是通過插值低解析度像素重建高解析度影像,常見的選擇是雙線性、雙三次、lanczos,對比感知銳化,深度神經網路可以根據先驗或訓練數據在現有像素的基礎上產生幻覺(hallucination)。它們與原生高解析度影像相比,生成的影像缺少細節。由於幻覺,影像可能與原生渲染不一致,且時間不穩定:

進一步的演算法,如TAAU等使用鄰域截取,對高頻訊號、新出現的訊號重建後方差大,從而導致摩爾紋、閃爍、模糊、重影等瑕疵:

實時超解析度的挑戰是:對於單幀方法,模糊影像品質,與原生渲染現不一致,時間不穩定;對於多幀方法,用於檢測和糾正跨幀變化的啟發式方法,啟發式的局限性導致模糊、時間不穩定和重影。

在重建訊號時,和傳統的抗鋸齒等演算法不同,DLSS 2.0是基於DL(深度學習)的多幀重建,使用從成千上萬的高品質影像中訓練的神經網路,神經網路比手工製作的啟發式更強大,使用來自多幀的樣本進行更高品質的重建,從而獲得更為精準的重建訊號(下圖)。

左:原始的高頻訊號;中:非DL技術的重建,和原始訊號方差大;右:DLSS重建方法,更加精準貼合原始訊號。

DLSS 2.0在相同的渲染消耗下,獲得更佳的解析度和影像品質:

以下是1080P+TAA、540P+DLSS 2.0、540P+TAAU的畫面對比:

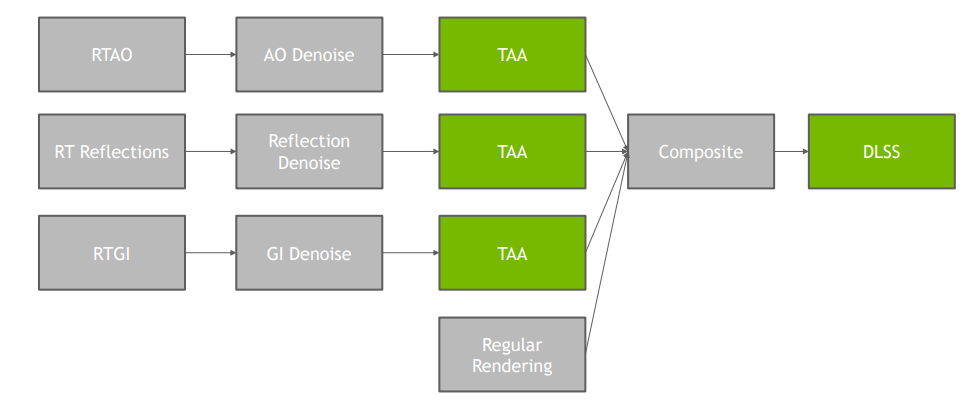

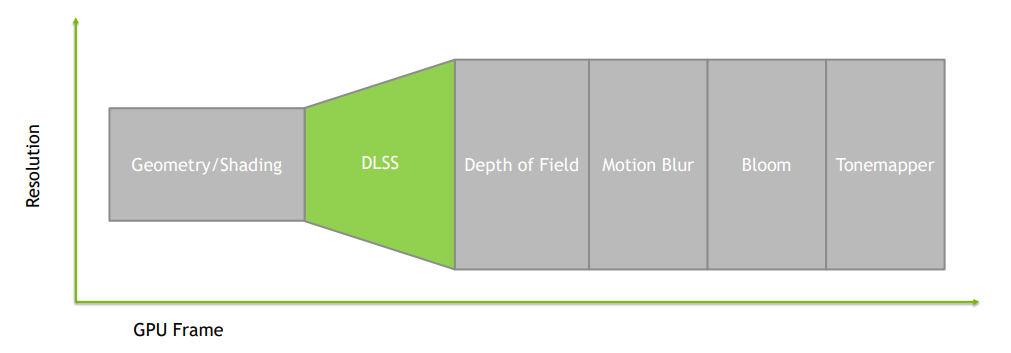

如果遊戲引擎需要集成DLSS,其步驟概覽如下:

Geometry/Shading階段,因為TAA被DLSS取代,依賴TAA的去噪器需要改進降噪器或在降噪後添加專用的TAA通道:

DL Upsampling需要輸入以下資訊,通過NGX SDK處理成降噪和抗鋸齒後的畫面:

Post(後處理)階段採用放大後的解析度渲染,引擎需要處理與幾何體和著色不同的後處理解析度:

值得一提的是,DLSS的主要研發者是閆令琪的師弟文刀秋二——跟部落客一樣是個熱愛攝影的人 。

。

17.3.9.4 降噪實現

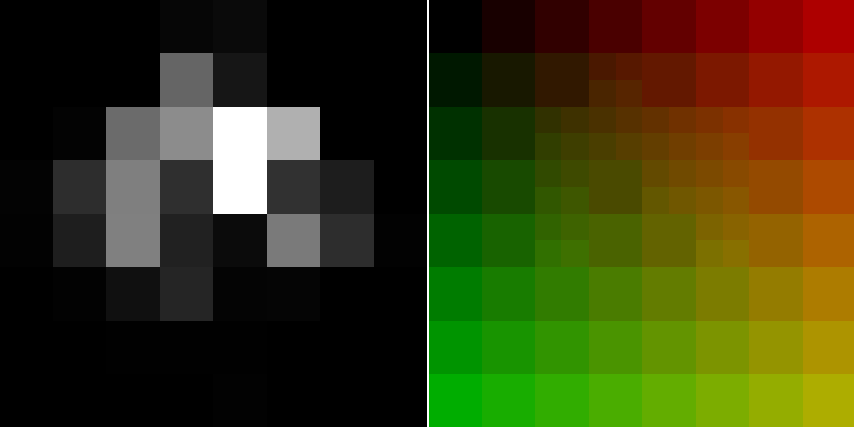

理想的降噪器結合了最新技術論文中的想法,圖例和步驟如下所示:

1、Prepass

計算場景的NDC空間速度,寫入常見的G-Buffer附件,如反照率、法線等。可能還需要這些緩衝區的第一次反彈版本,將需要基於光線追蹤的prepass ,而不是基於光柵的prepass 。

在降噪之前,重要的是使用某種通用通道(G通道)對材質資訊進行編碼,如法線、反照率、深度/位置、對象ID、粗糙度/金屬度等。此外,訪問速度可以將以前的取樣轉換到當前位置。可以通過確定渲染的每個頂點的先前和當前NDC空間坐標位置,並取兩者的差來計算速度緩衝區。

\]

因此,需要對象的前一幀modelViewProjection矩陣,以及該對象的動畫頂點速度,即當前和先前動畫取樣之間的位置差。

// NDC space velocity

float3 ndc = inPosition.xyz / inPosition.w;

float3 ndcPrev = inPositionPrev.xyz / inPositionPrev.w;

outVelocity = ndc.xy - ndcPrev.xy;

可以進一步使用此概念,例如使用運動矢量進行第一次反彈光澤反射,使用陰影運動矢量在對象移動時進行更好的陰影重投影,甚至使用雙運動矢量進行遮擋。[Zeng等人,2021]

2、Ray Trace

使用[Kuznetsov等人2018年][Hasselgren等人2020年]的人工智慧自適應取樣和樣本映射,以更好地確定哪些區域應接收更多樣本,通常是高光/陰影,以幫助避免鹽巴/胡椒(salt/peppering)等瑕疵,並隨時間保持亮度。將鏡面反射和全局照明寫入單獨附件的分離降噪器比較理想,因為反射降噪將更好地處理第一次反彈數據,全局照明、環境遮擋、陰影可以基於較少的數據使用更簡單的時空累積。

3、Accumulation(累積)

儘可能頻繁地使用時空重投影,對於朗伯數據(如全局照明/環境遮擋)更容易實現,而對於鏡面反射數據(如反射)則更難實現。為了獲得更好的結果,使用啟發式數據(如法線/反照率/對象ID)將之前的樣本轉換為當前位置,以及第一次反彈數據(如視圖方向、第一次反彈法線、反射率等)。然後,任何成功的重投影都可以用於重要性樣本[Bitterli等人2020],或將其輻射編碼到輻射歷史緩衝區[Schied等人2018]。

時空重投影是重複使用來自前一幀的數據,將其空間重投影到當前幀。將以前的取樣轉換為當前幀需要首先在視圖空間中找到以前幀數據的坐標,可以通過添加速度緩衝區來完成。通過比較此螢幕空間坐標的當前位置/法線/對象ID/等與其上一個坐標之間的差異,可以判斷對象是否已被遮擋,現在是否在視圖中,或者重用以前的取樣。

在執行時空重投影時,具有描述給定樣本必須累積的時間的緩衝區非常有價值,即歷史緩衝區。它可以用於驅動濾波器在具有較少累積樣本的區域中模糊更強,或者用於估計當前影像的方差(較高的歷史將意味著較小的方差)。

outHistoryLength = successfulReprojection ? prevHistoryLength + 1.0 : 0.0;

然後,歷史長度可以用作累積因子\(\alpha\),即當前取樣對最終輻射的貢獻因子。

outColor = lerp(colorPrevious, colorCurrent, accumulationFactor);

雖然歷史緩衝區是一個有用的東西,但有更好的方法來確定累積因子,而不是成功重投影的比率,我們可以使用統計分析來防止時間延遲。

4、Statistical Analysis(統計分析)

估計當前光線追蹤影像的方差,計算亮度/速度的方差變化,並使用其驅動時空重投影和濾波。嘗試使用該差異資訊拒絕螢火蟲(fireflies,即異常亮點)。

\]

方差是訊號平均值(均值)的平方差。我們可以取當前訊號的平均值,然後用3×3高斯核(本質上是張量),然後取兩者的差。

\]

const float radius = 2; // 5x5 kernel

float2 sigmaVariancePair = float2(0.0, 0.0);

float sampCount = 0.0;

for (int y = -radius; y <= radius; ++y)

{

for (int x = -radius; x <= radius; ++x)

{

// Sample current point data with current uv

int2 p = ipos + int2(xx, yy);

float4 curColor = tColor.Load(p);

// Determine the average brightness of this sample

// Using International Telecommunications Union's ITU BT.601 encoding params

float samp = luminance(curColor);

float sampSquared = samp * samp;

sigmaVariancePair += float2(samp, sampSquared);

sampCount += 1.0;

}

}

sigmaVariancePair /= sampCount;

float variance = max(0.0, sigmaVariancePair.y - sigmaVariancePair.x * sigmaVariancePair.x);

Christoph Schied在A-SVGF中將空間方差估計為邊緣避免guassian濾波器(類似於A-trous引導濾波器)的組合,並在回饋迴路中使用它來驅動時空重投影期間的累積因子。除了管理累積,估計方差還可以讓我們在時間上降低過濾器的權重,[Olejnik等人2020]使用類似於A-SVGF的泊松圓盤過濾器,以更好地渲染接觸陰影。

/**

* Variance Estimation

* Copyright (c) 2018, Christoph Schied

* All rights reserved.

* Slightly simplified for this example:

*/

// Setup

float weightSum = 1.0;

int radius = 3; // ⚪ 7x7 Gaussian Kernel

float2 moment = tMomentPrev.Load(ipos).rg;

float4 c = tColor.Load(ipos);

float histlen = tHistoryLength, ipos, 0).r;

for (int yy = -radius; yy <= radius; ++yy)

{

for (int xx = -radius; xx <= radius; ++xx)

{

// We already have the center data

if (xx != 0 && yy != 0) { continue; }

// Sample current point data with current uv

int2 p = ipos + int2(xx, yy);

float4 curColor = tColor.Load(p);

float curDepth = tDepth.Load(p).x;

float3 curNormal = tNormal.Load(p).xyz;

// Determine the average brightness of this sample

// Using International Telecommunications Union's ITU BT.601 encoding params

float l = luminance(curColor.rgb);

float weightDepth = abs(curDepth - depth.x) / (depth.y * length(float2(xx, yy)) + 1.0e-2);

float weightNormal = pow(max(0, dot(curNormal, normal)), 128.0);

uint curMeshID = floatBitsToUint(tMeshID, p, 0).r);

float w = exp(-weightDepth) * weightNormal * (meshID == curMeshID ? 1.0 : 0.0);

if (isnan(w))

w = 0.0;

weightSum += w;

moment += float2(l, l * l) * w;

c.rgb += curColor.rgb * w;

}

}

moment /= weightSum;

c.rgb /= weightSum;

varianceSpatial = (1.0 + 2.0 * (1.0 - histlen)) * max(0.0, moment.y - moment.x * moment.x);

outFragColor = float4(c.rgb, (1.0 + 3.0 * (1.0 - histlen)) * max(0.0, moment.y - moment.x * moment.x));

螢火蟲抑制(Firefly Rejection)可以通過多種方式進行,從調整光線追蹤期間的取樣方式,到使用過濾技術或關於輸出輻射亮度的huristics。

// 增加每次彈跳的粗糙度

////twitter.com/YuriyODonnell/status/1199253959086612480

////cg.ivd.kit.edu/publications/p2013/PSR_Kaplanyan_2013/PSR_Kaplanyan_2013.pdf

////jcgt.org/published/0007/04/01/paper.pdf

float oldRoughness = payload.roughness;

payload.roughness = min(1.0, payload.roughness + roughnessBias);

roughnessBias += oldRoughness * 0.75f;

// 截取拒絕

// Ray Tracing Gems Chapter 17

float3 fireflyRejectionClamp(float3 radiance, float3 maxRadiance)

{

return min(radiance, maxRadiance);

}

// 方差拒絕

// Ray Tracing Gems Chapter 25

float3 fireflyRejectionVariance(float3 radiance, float3 variance, float3 shortMean, float3 dev)

{

float3 dev = sqrt(max(1.0e-5, variance));

float3 highThreshold = 0.1 + shortMean + dev * 8.0;

float3 overflow = max(0.0, radiance - highThreshold);

return radiance - overflow;

}

5、Filtering(過濾)

可以使用À-Trous雙邊濾波器快速完成,根據想要的模糊強度重複此步驟3到5次,每次將步長減小2的冪(因此,在3次迭代的情況下,順序為4、2、1)。或者,可以使用降噪自動編碼器,該編碼器速度較慢,但可以產生更好的過濾結果。然後,該結果可以輸入一個超級取樣自動編碼器,該編碼器可以上取樣結果,類似於NVIDIA的DLSS 2.0。

À-Trous避免了以略微抖動的模式取樣,以覆蓋比3×3或5×5高斯核通常可能的更寬的半徑,同時具有重複多次的能力,並避免由於不同輸入的數量而在邊緣模糊。可以結合以下方法進行:

- 根據抖動模式進行子取樣,從而進一步減少模糊內核中的取樣數。

- 使用更多資訊驅動模糊,如表面粗糙度[Abdollah shamshir saz 2018]、近似鏡面BRDF瓣[Tokuyoshi 2015]、陰影半影[Liu等人2019]等。

6、History Blit(歷史拷貝)

寫入當前預處理數據,如反照率、深度等,以便重新投影下一幀。

NVIDIA發布了一個使用ReSTIR的類似降噪器的示例實現[Wyman等人2021]。下圖是NV的AI降噪,可利用1取樣高噪點圖,通過降噪演算法,獲得良好的降噪結果。

上:1次取樣的原始噪點圖;下:開啟了降噪處理的畫面。

頂部影像中的環境遮擋使用每像素一條光線進行光線追蹤,然後進行降噪。縮放影像從左至右顯示:基準真相、螢幕空間環境遮擋、光線追蹤環境遮擋。其中光線追蹤環境遮擋每幀每像素一個樣本,並從每像素一樣本進行降噪。降噪影像不會捕獲所有較小的接觸陰影,但仍然比螢幕空間環境遮擋更接近基準真相。(NVIDIA提供)

所有這些類型的演算法都依賴於重用數據,因此,當重用數據不可用時,例如在快速移動的對象、高度複雜的幾何體或歷史資訊很少的區域,每個方法的品質都會下降。有一些方法可以利用一些快取數據來幫助避免這種情況,例如使用輻照度快取來獲得更好的默認顏色,如Minecraft RTX。

對於反射,時空重投影也非常困難,因此通常情況下,降噪器將依賴於第一次反彈數據,其中反射表面的法線、位置數據等基於第一次反射,而不是原始表面。

降噪可以通過時空重投影重新使用以前的樣本——自適應地重新取樣輻射或統計資訊以進行重要性取樣,並使用快速高斯/雙邊濾波器等濾波器或人工智慧技術(如去噪自動編碼器和通過超取樣進行放大),幫助彌合低樣本/像素影像與基準真相之間的差距。

雖然降噪並不完美,因為時間技術可能會引入輻射滯後,並且任何濾波器都會由於試圖模糊原始影像而導致銳度損失,但引導濾波器可以幫助保持銳度,並且自適應取樣或增加每幀像素的樣本數可以使去噪影像和地面真實影像之間的差異可以忽略不計。儘管如此,每像素取樣率更高是無法替代的,因此使用不同的每像素取樣(spp)計數來試驗這些技術。

一個健壯的降噪器應該考慮使用所有這些技術,但取決於應用程式的權衡和需求。最近的研究側重於通過改進取樣方案和使用快取資訊重新取樣像素,將降噪移到渲染的早期,而之前的研究則側重於過濾、機器學習中的自動編碼器、重要性取樣以及當前在商業遊戲和渲染器中生產的實時方法。

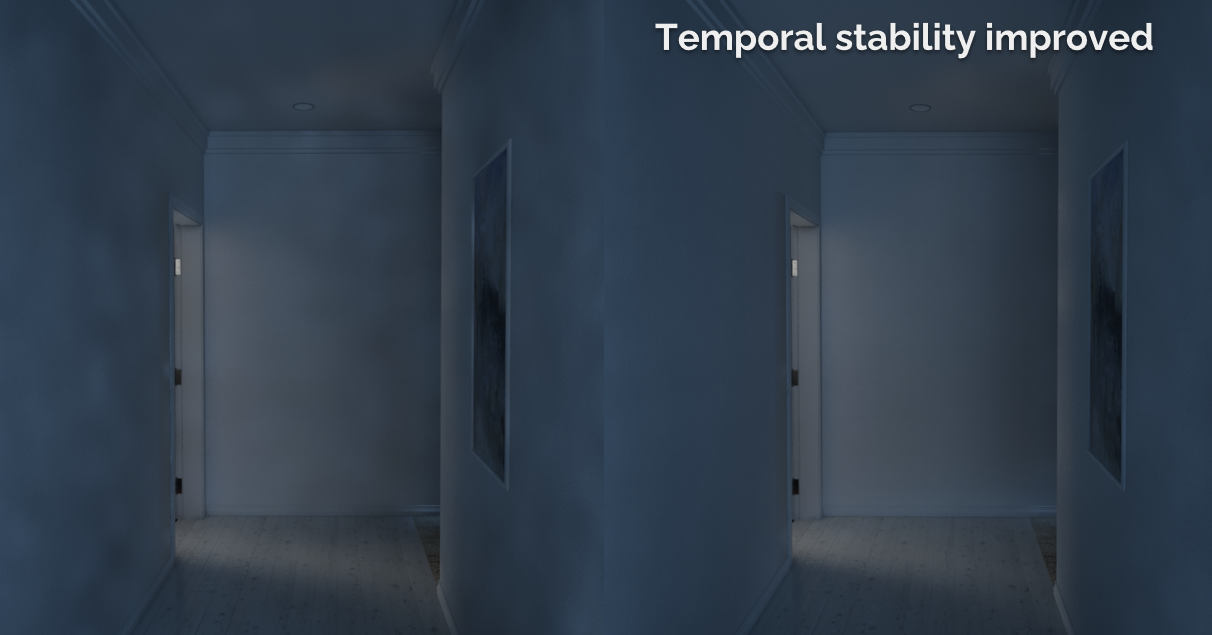

UE大量綜合使用了濾波、取樣的若干種技術(雙邊濾波、空間卷積、時間卷積、隨機取樣、訊號和頻率等等),而不僅僅限於光線追蹤,還用於包含SSGI、SSR、SSAO等螢幕空間技術。下圖是UE的SSGI在經過時間累積之後,可以看到畫面的噪點更少且不明顯了:

17.3.9.5 降噪文獻

降噪是未來值得深究的課題和領域,希望童鞋們有志參與其中,現推薦部分降噪相關的樣例、論文、演講和文獻:

-

Samples

-

Dihara Wijetunga (@diharaw94) released a blog post that discusses denoising different aspects of a hybrid renderer.

-

NVIDIA released their Real-Time Denoiser for limited review. You can sign up to view it here.

-

Interactive Path Tracing and Reconstruction of Sparse Volumes uses a machine learning denoiser to denoise volumes with adaptive sampling.

-

Peter Kristof of Microsoft made a really robust DirectX Ray Tracing Ambient Occlusion example with a robust implementation of SVGF here.

-

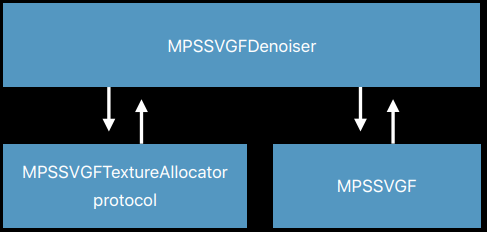

The Apple Metal Team released an example of using Metal Performance Shaders, Temporal Anti-Aliasing (MPSTAA), and SVGF (MPSSVGF) to denoise a ray traced scene.

-

AMD’s FidelityFX SSSR features spatio-temporal reprojection to denoise screen space reflections. Here’s their Github. AMD also released several denoisers for reflections and shadows on thisGithub Repo.

-

NVIDIA has released an SDK to itegrate Deep Learning Super Sampling here. AMD’s Fidelity FX Super resolution is also available for developers to integrate into their applications.

-

Ingo Wald (@IngoWald)) released a Optix course which showcases how to use the Optix denoiser here.

-

Christof Shied (@c_schied) and Alexey Panteleev (@more_fps) of NVIDIA wrote the denoiser for Quake 2 RTX which is on Github here.

-

Microsoft’s DirectML Super Resolution Example, while not NVIDIA Deep Learning Super Sampling 2.0 (DLSS 2.0), is similar in that both perform upscaling.

-

Xiaoxu Meng released the source of their Neural Bilateral Grid paper here.

-

released a number of open source denoisers for shadows and reflections in raster based rendering here.

-

In the University of Pennsylvania’s CIS565 course, a number of students, teaching assistants, and former students made awesome projects that implement the latest in denoising research:

- CUDA SVGF by Zheyuan Xie, Yan Dong, and Weiqi Chen

- Blockwise Multi-Order Feature Regression for Real-Time Path Tracing Reconstruction (BMFR) by Jiangping Xu, Gangzheng Tong, and Tianming Xu

- Interactive Reconstruction of Monte Carlo Image Sequences using a Recurrent Denoising Autoencoder by Dewang Sultania & Vaibhav Arcot implemented with Pytorch.

- ReSTIR in DirectX 12 by Sydney Miller, Sireesha Putcha, Thy Tran.

- ReSTIR in DirectX 12 by Jilin Liu (@Jilin18043110), Keyi Yu, and Li Zheng.

- ReSTIR in Vulkan by Xuanyi Zhou, Xuecheng Sun, Jiarui Yan.

-

-

Talks

- Chris Wyman’s High Performance Graphics 2020 talk on ReSTIR is available here.

- Eric Haines (@pointinpolygon) released Ray Tracing Essentials Part 7: Denoising for Ray Tracing, a great introduction to denoising.

- Tomasz Stachowiak (@h3r2tic) et al. designed the Pica Pica renderer, an amazing reference hybrid renderer featured in Ray Tracing gems. Their talk is available here.

- Ray Tracing in Games with NVIDIA RTX (Presented by NVIDIA)

-

Articles

- Kostas Anagnostou (@KostasAAA) wrote an article describing a method of handling global illumination denoising inspired in part by Metro Exodus.

- Ray Tracing Filtering

- Machine Learning Denoising

- Real-Time_Rendering_4th-Real-Time_Ray_Tracing

- Ray Tracing Denoising

- DirectML’s SuperResolution Sample

- Spatiotemporal Variance-Guided Filtering

- TURING RTX RAY TRACING 與 DLSS

- DLSS 2.0 – IMAGE RECONSTRUCTION FOR REAL-TIME RENDERING WITH DEEP LEARNING

- Spatiotemporal Reservoir Resampling (ReSTIR) – Theory and Basic Implementation

17.3.10 光線追蹤優化

光線追蹤的實際場景可能很複雜:數千個光源,超過記憶體容量的紋理,超過記憶體容量的幾何圖形(以鑲嵌形式),非常複雜的可編程著色器,用於位移、照明和反射。

17.3.10.1 光源優化

在光源方面,直接照明的主要消耗通常是陰影。如果使用陰影貼圖,則必須為每個光源渲染和管理陰影貼圖。如果使用光線追蹤,並且我們必須為每個光源追蹤至少一條陰影光線,則渲染時間將長得無法接受。幸運的是,可以通過基於潛在照明對光源進行排序來處理來自許多光源的陰影。有些光源太遠,照明太暗,因此可以非常粗略地近似。在每個表面點處,計算每個光源的直接照明,然後根據照明強度對燈光進行排序,最後對要計算陰影的燈光、要計算無陰影的燈光和要跳過的燈光進行概率選擇。

17.3.10.2 紋理優化

在紋理方面,當渲染影像所需的紋理超過可用記憶體時,必須按需從磁碟讀取紋理,僅以所需解析度讀取紋理,並將紋理快取在記憶體中。

可以使用紋理Mipmap和紋理分塊。分塊紋理以便將相鄰像素組一起從磁碟讀取到存儲器,下圖顯示了平鋪紋理MIP貼圖的三個級別。在本例中,每個分塊包含16×16像素。最粗糙的MIP貼圖級別(級別0-3)可以壓縮到單個塊中(此處未顯示),MIP映射級別4由單個塊組成,下一層有2×2個分塊(每個分塊中仍有16×16個像素),下一層有4×4個分塊,依此類推。

此外,還可以使用多解析度紋理分塊快取。多解析度紋理分塊快取的紋理訪問對於直接可見幾何體的渲染具有高度一致性,快取大小為總紋理大小的1%就足夠了。當光線微分用於為紋理查找選擇適當的MIP貼圖級別時,觀察到光線追蹤的類似結果,選擇紋理像素與射線束橫截面大小大致相同的級別。非相干光線具有較寬的光線束,因此將選擇粗略的MIP貼圖級別。更精細的MIP圖級別將僅由具有窄射線束的射線訪問;幸運的是,這些光線是相干的,因此生成的紋理快取查找也將是相干的。

17.3.10.3 幾何優化

對於複雜場景,可以使用實例化、光線重新排序和著色快取(Ray reordering and shading caching)、幾何替身( stand-ins)、多解析度曲面細分等技術。

在光線重新排序和著色快取方面,Toro渲染器對光線進行了重新排序,以增加幾何相干性,使得光線追蹤大於電腦主記憶體的場景成為可能。對射線重新排序要求每個射線的影像貢獻是線性的,這種要求對於真實的物理反射是正確的,但對於電影製作中使用的非常藝術化的可編程著色器通常不是正確的。Razor項目受到用於掃描線渲染的REYES演算法的啟發,一次性對曲面點的整個網格進行著色,並存儲著色結果中與視圖無關的部分。如果以下某些光線擊中同一曲面面片,則可以重複使用著色結果。

幾何替身的預計算是一個相當長的過程,但一旦完成,就可以互動式地對場景進行光線追蹤。

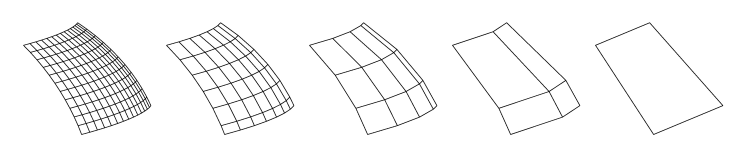

對於多解析度曲面細分,在實際應用中,對曲線、Bezier面片、NURBS曲面、細分曲面和任何具有位移的曲面進行細分,而不是用數值方法計算光線曲面交點是有利的。這些曲面被分割為大小可控的較小曲面面片,對應於紋理的分塊。直接可見曲面面片的鑲嵌率應取決於觀察距離和曲面曲率,還可選擇地取決於觀察角度。對於反射或陰影,我們通常可以使用更粗糙的曲面細分。下圖顯示了曲面面片的五個細分的示例,最精細的細分率為14×11,較粗的層次由最精細細分的頂點子集組成,最粗糙的細分只是面片的四個角,可以將不同級別的細分視為細分幾何體的MIP貼圖。

曲面面片的多解析度細分示例:14×11、7×6、4×3、2×2和1個四邊形。

Pharr和Hanrahan快取了置換曲面的曲面細分幾何體,但沒有利用多解析度曲面細分。根據需要以所需的解析度細分曲面面片(然後在適當的情況下置換頂點),並將細分存儲在快取中。由於細分的大小相差很大,快取可以存儲比精細細分多得多的粗細分。

對於射線相交測試,可以選擇四邊形與射線束橫截面大小大致相同的細分。對精細和中等鑲嵌的訪問通常是非常一致的,對粗細分的訪問相當不一致,但粗細分的快取容量很大,而且這些細分無論如何都很快重新計算。精細細分僅用於直接可見的幾何體、平面的鏡面反射和折射以及光線原點附近的漫反射和環境遮擋光線,對於所有其他光線,光線束較寬,並使用中等和粗糙曲面細分。(類似不同粗糙度對應不同紋理的Mipmap等級!)

17.3.10.4 並行計算

光線追蹤似乎非常適合併行加速:每個像素的計算獨立於所有其他像素,導致人們普遍認為光線追蹤是「令人尷尬的平行」。但是,只有當場景數據適合主記憶體時,這才是成立的!如果場景較大,則必須非常小心地維護和利用數據訪問一致性,安排執行順序以使後續光線趨向於遍歷相同的幾何體並訪問相同的紋理,從而確保良好的快取行為。此舉非常值得,可提升快取命中率。

現代CPU有SIMD指令(英特爾上的SSE、IBM/Motorola上的AltiVec、AMD上的3dNow),可以並行執行四種操作。利用這些指令對平行於一個三角形的四條射線進行交叉測試。如果光線是相干的,將提供良好的加速,對於可見性光線,典型的加速比約為3.5倍。

利用SIMD指令的另一種方法是對平行的四個三角形進行一條射線的交叉測試。如果三角形是相干的(就像它們來自細分曲面上的相鄰位置一樣),會提供良好的加速,並且不需要光線是相干的。SIMD指令的另一個用途是平行交叉測試軸對齊包圍盒的所有三個平面。

17.3.10.5 GPU加速

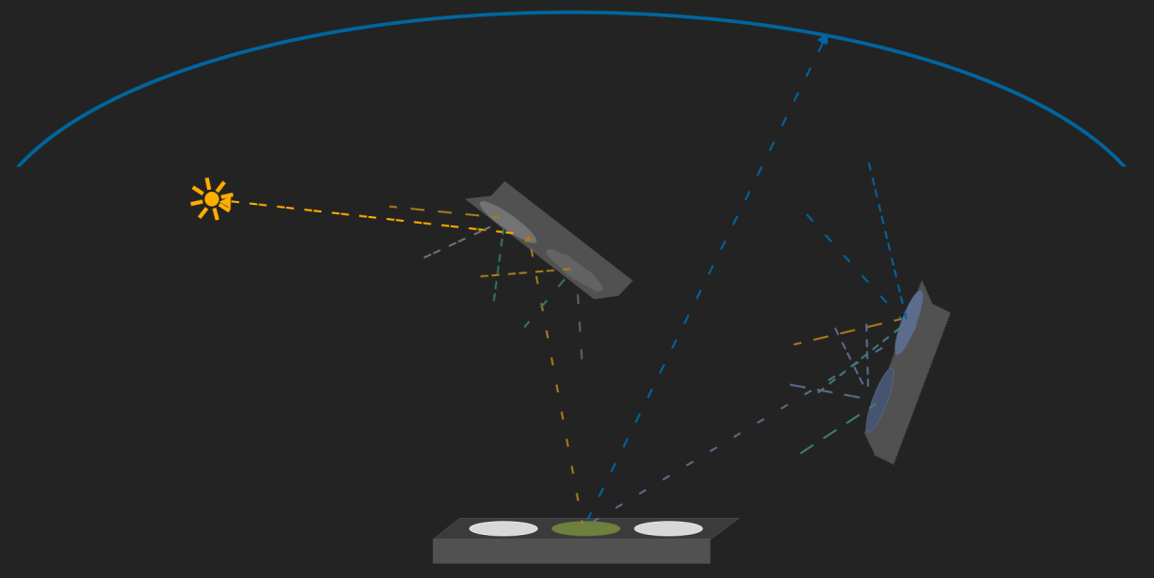

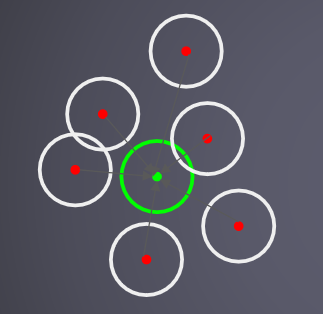

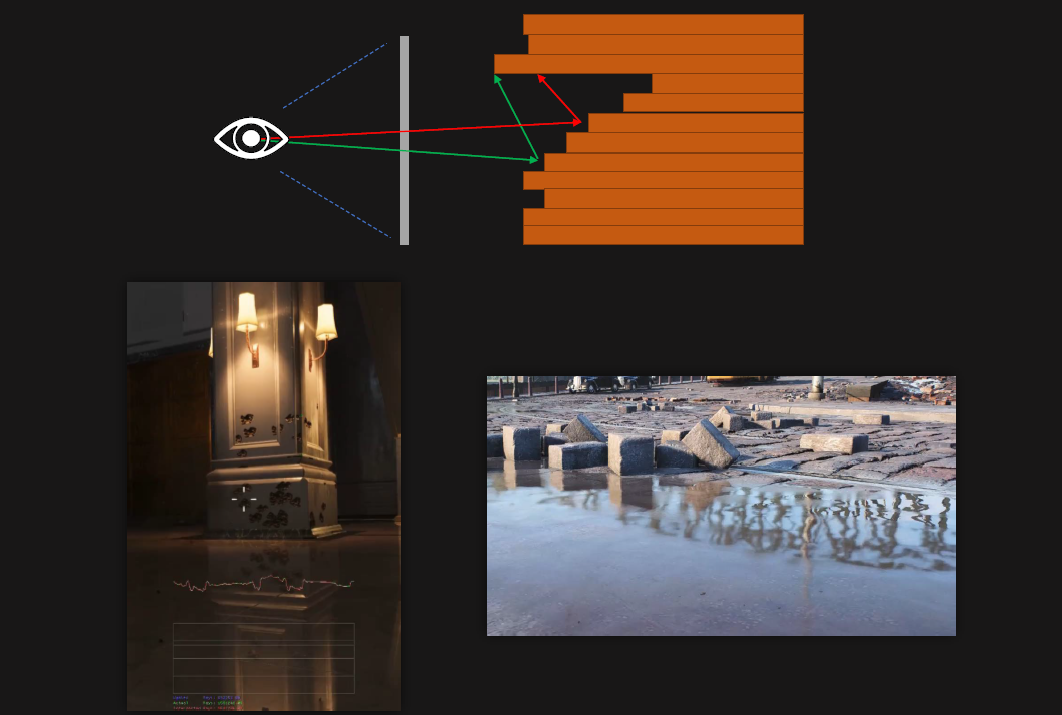

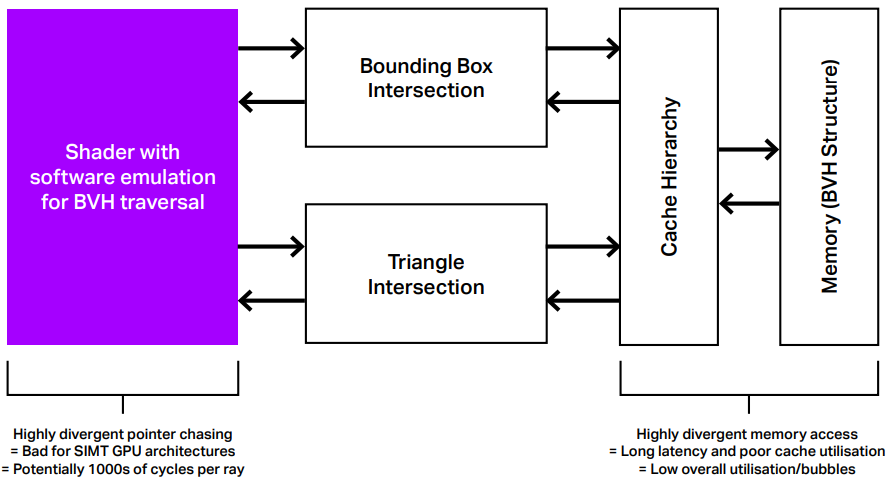

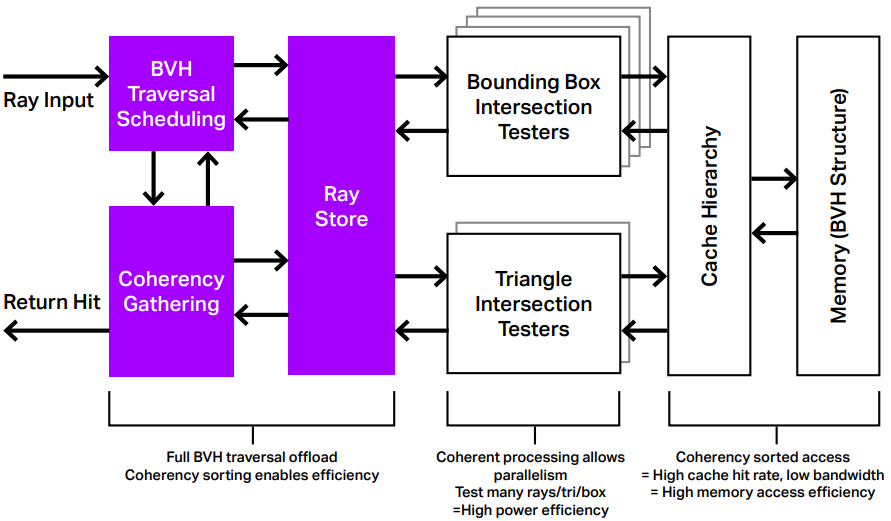

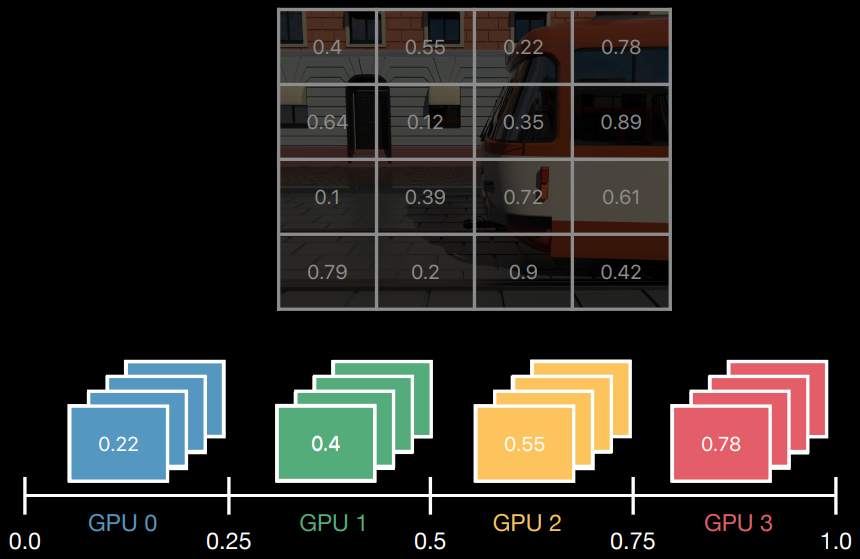

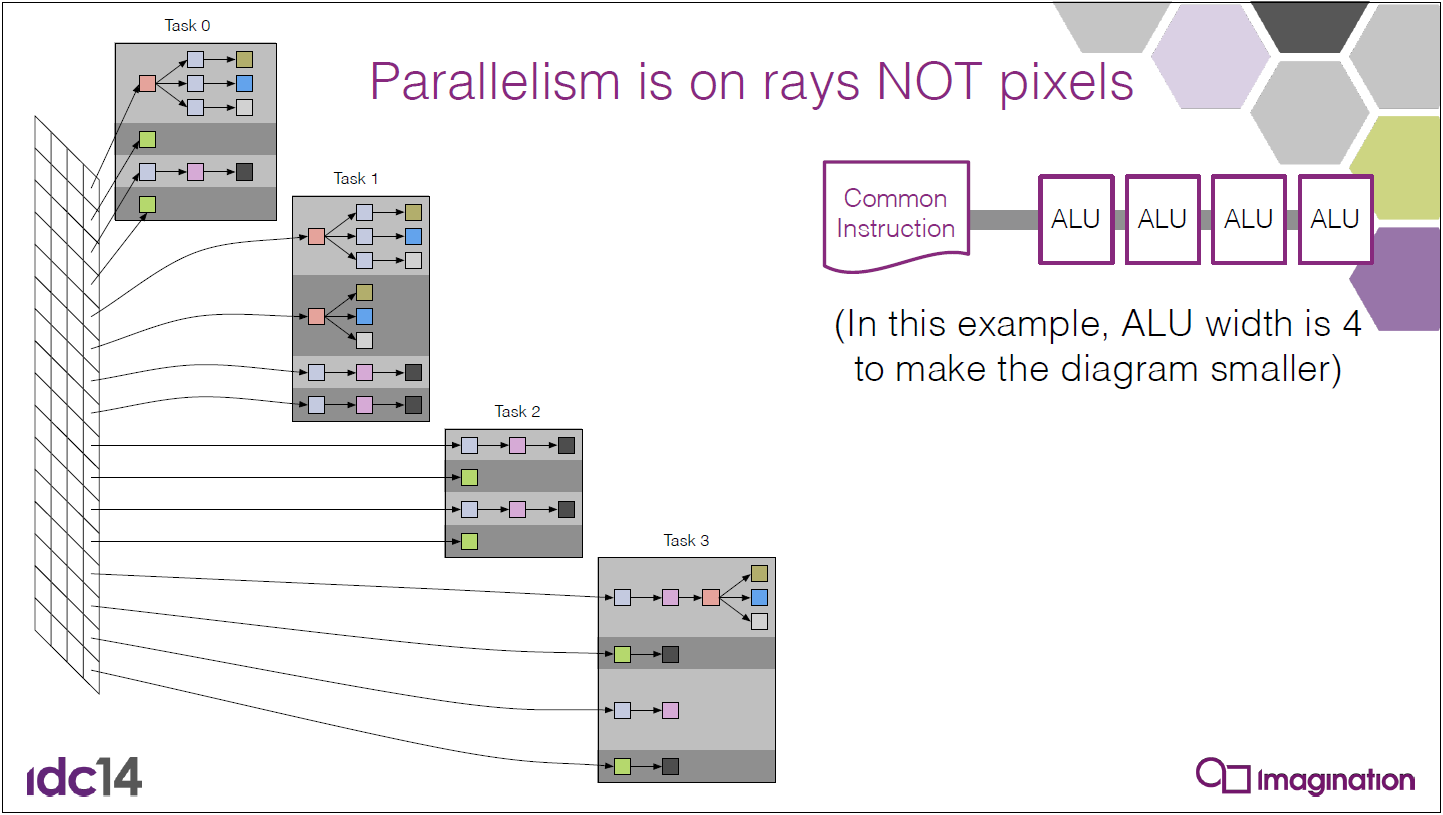

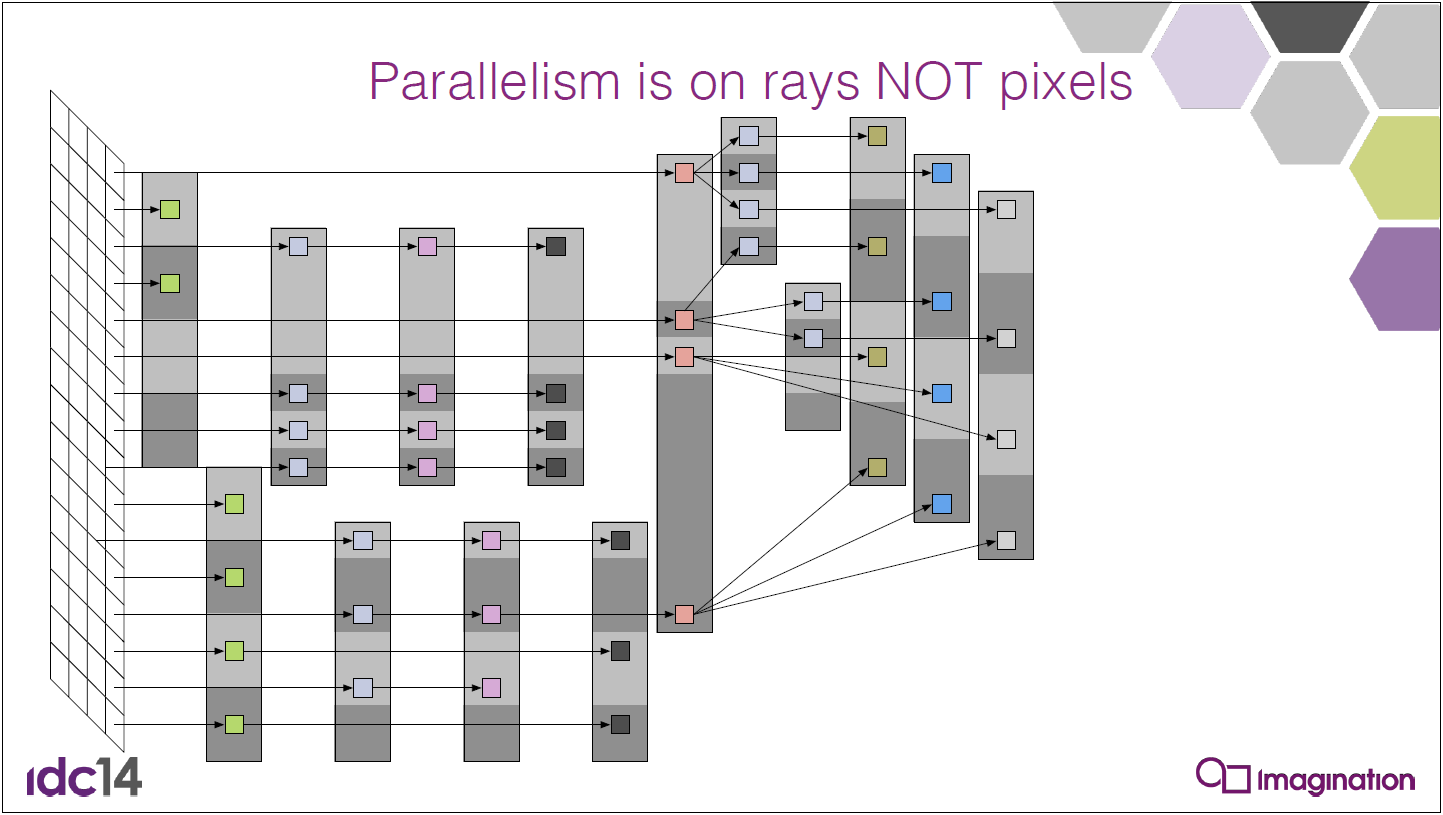

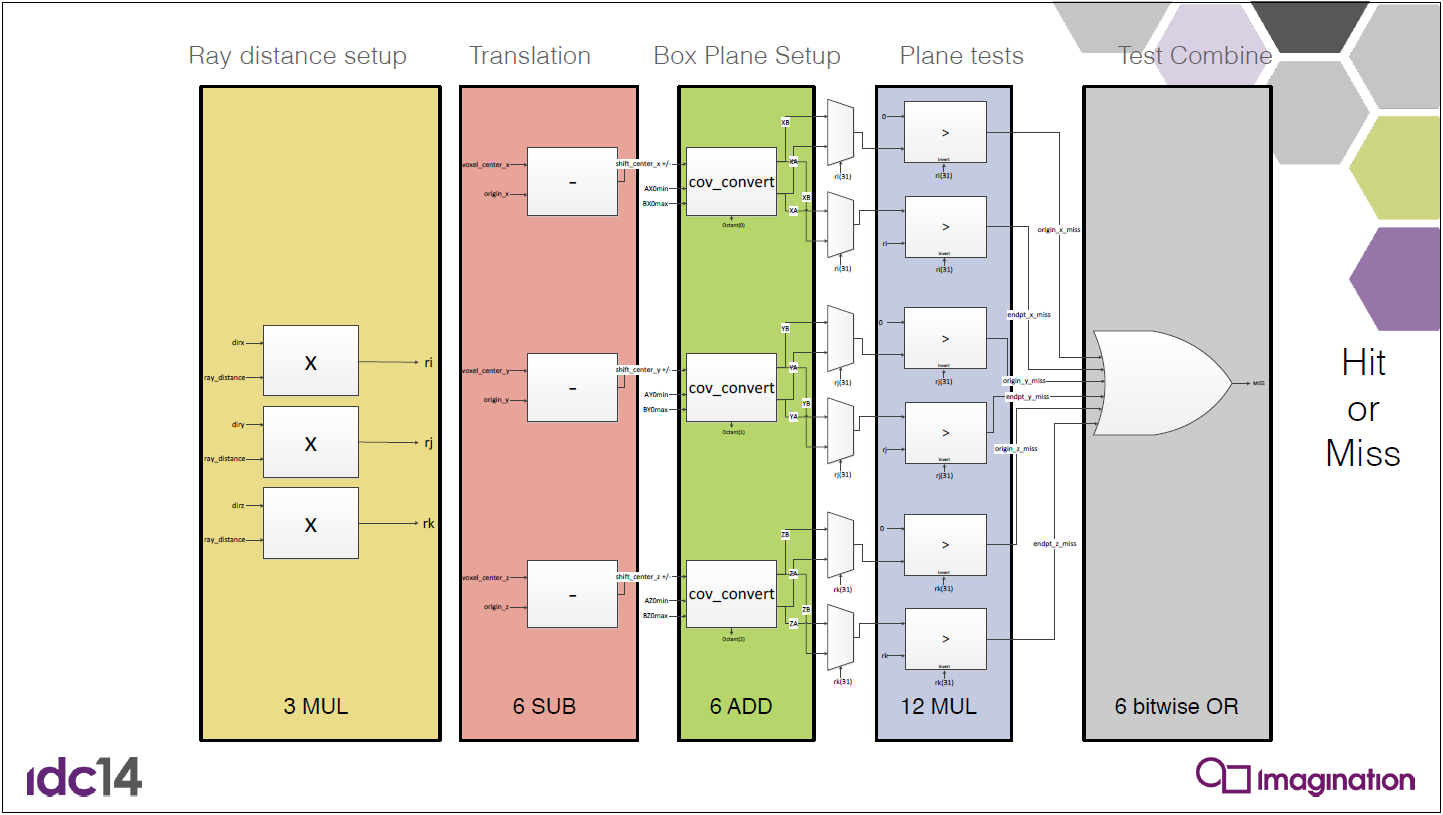

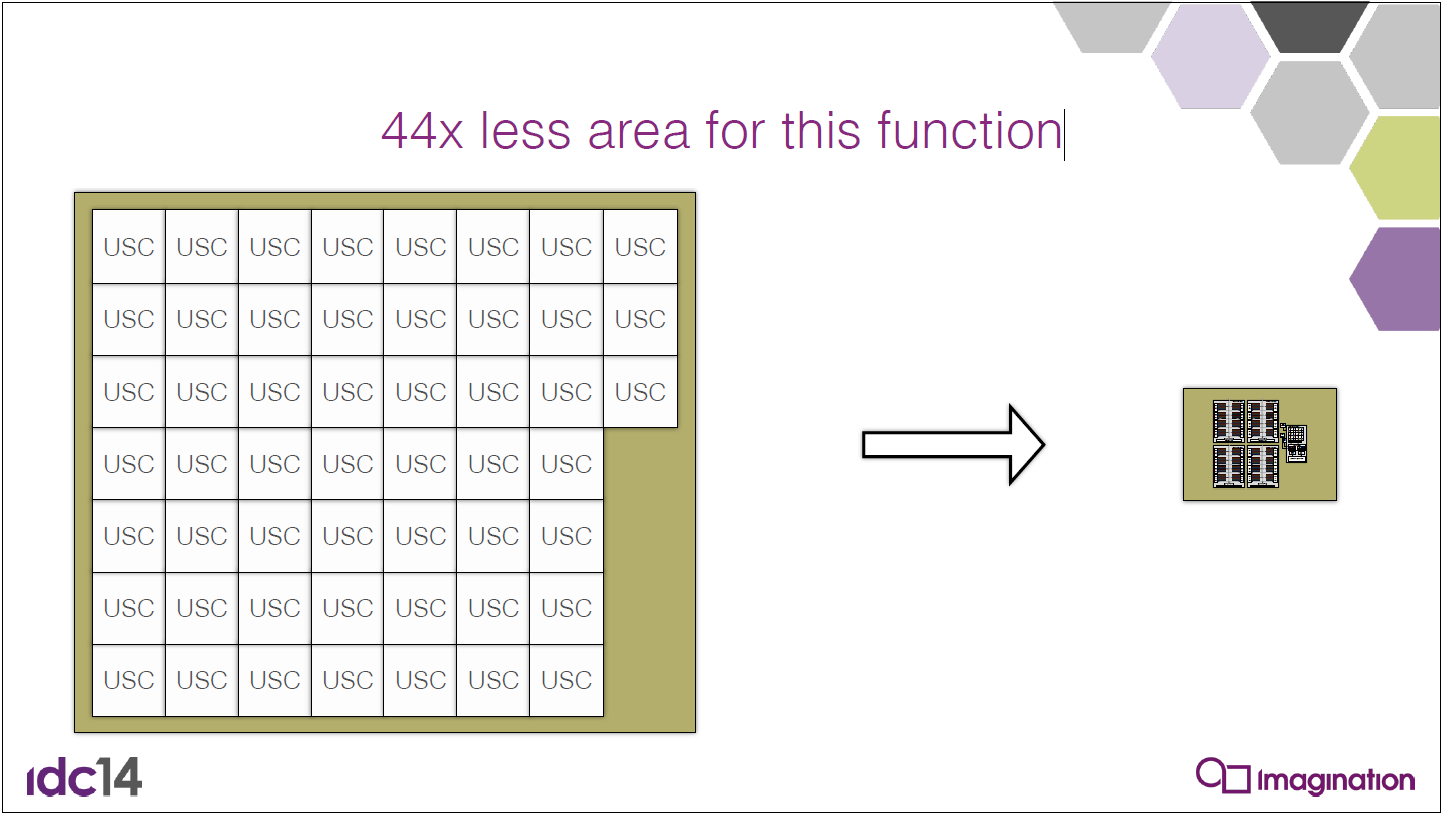

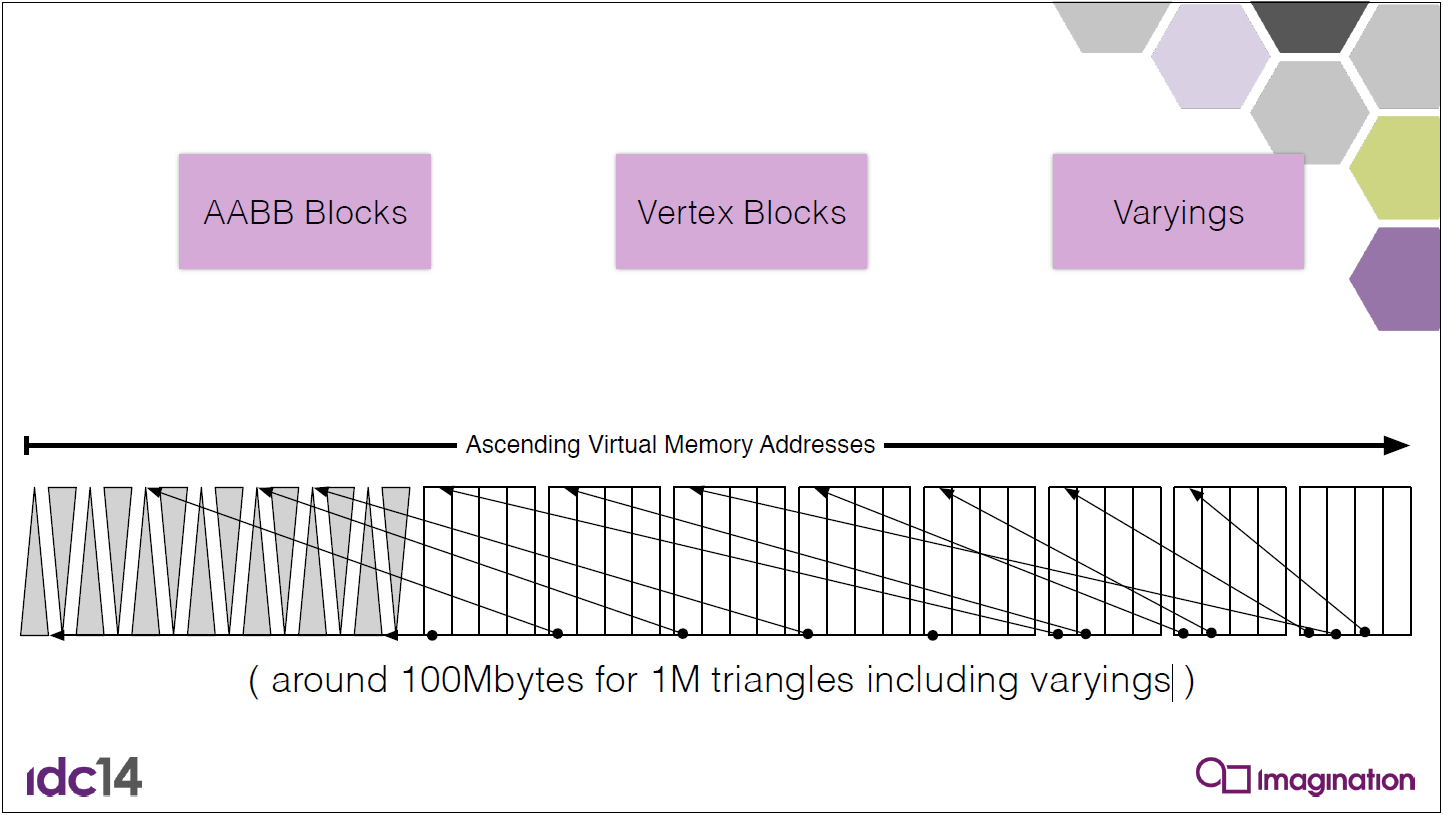

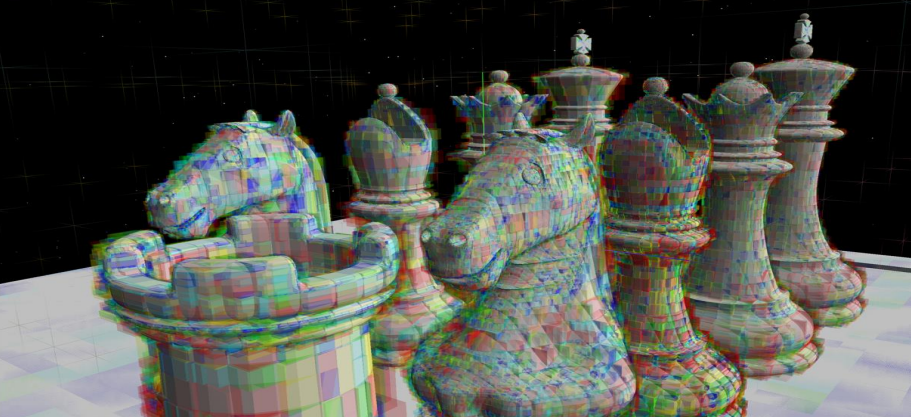

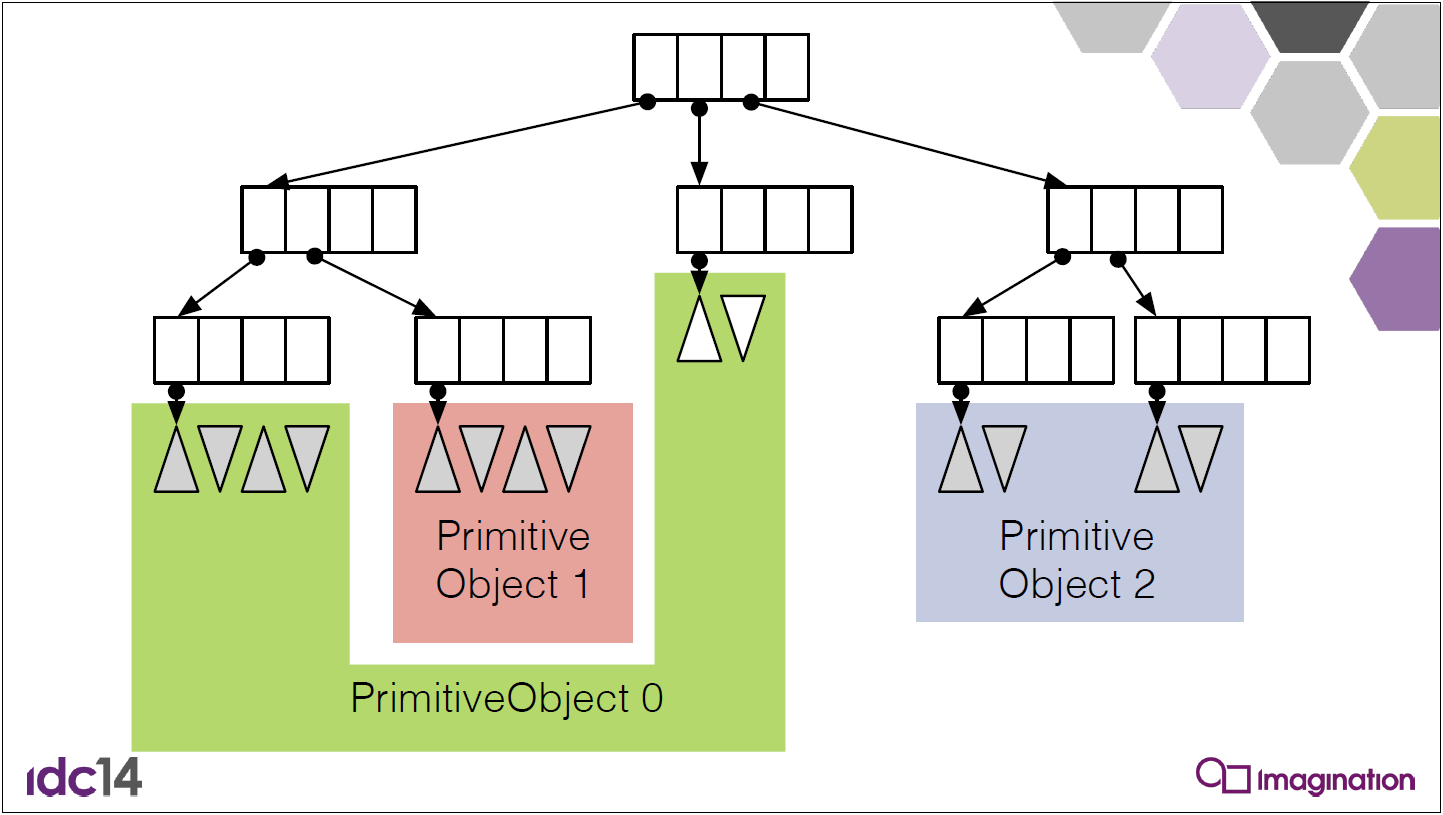

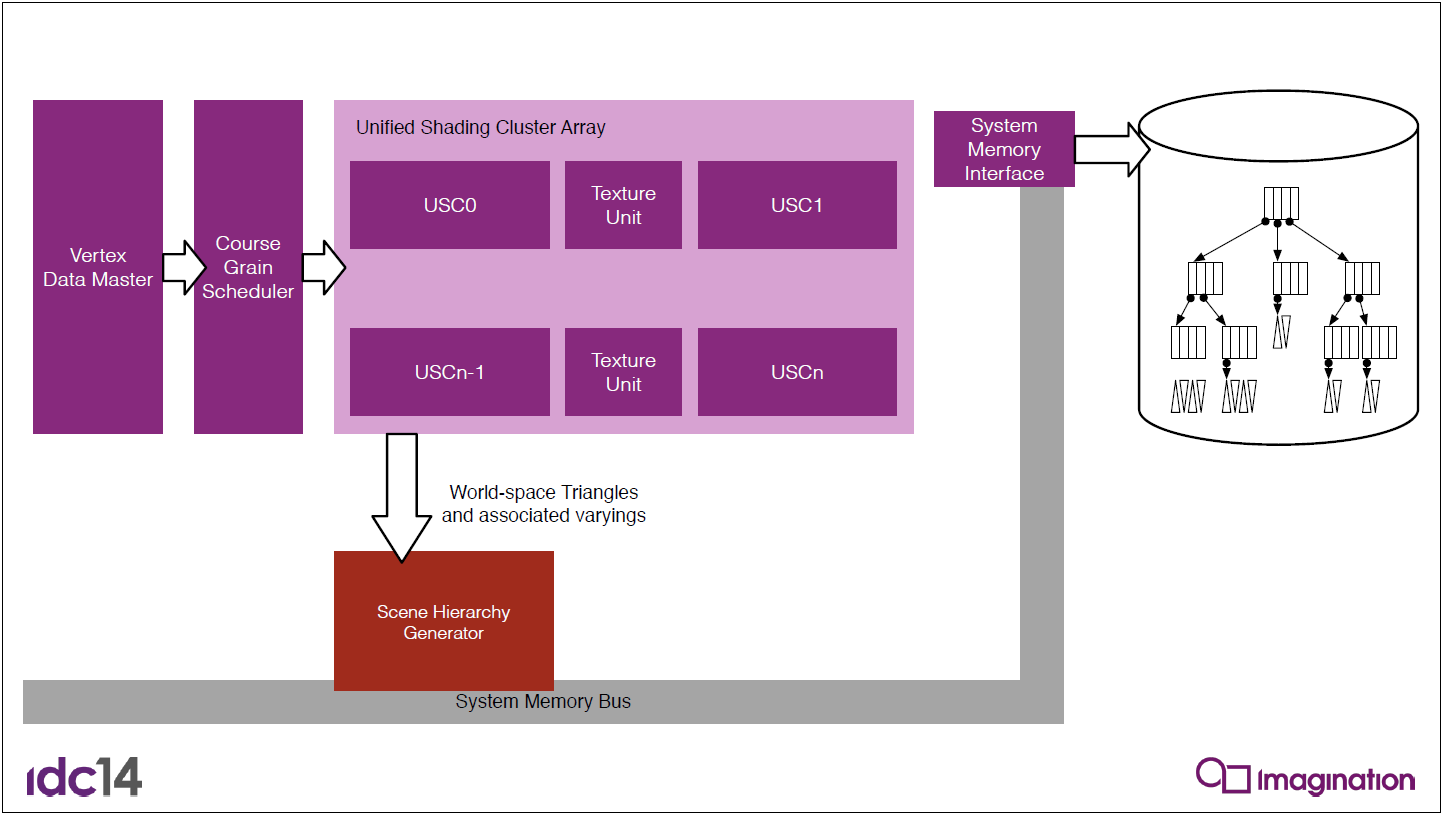

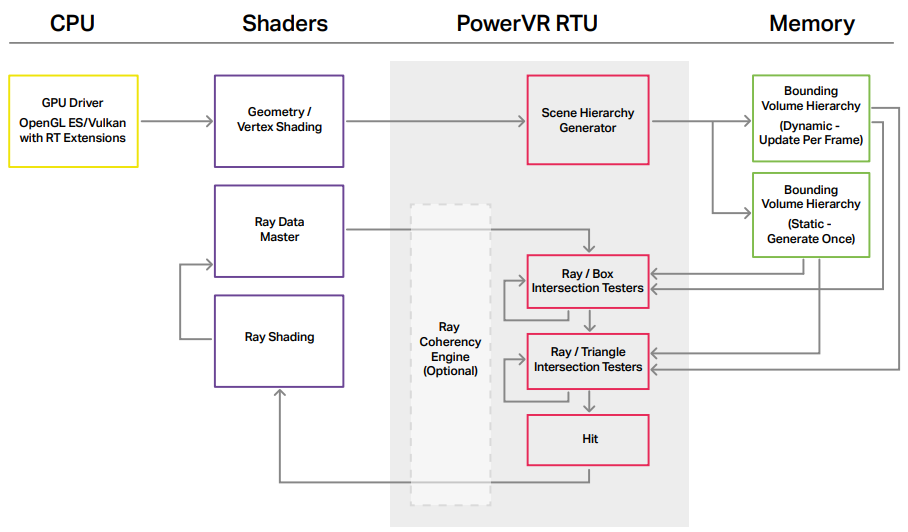

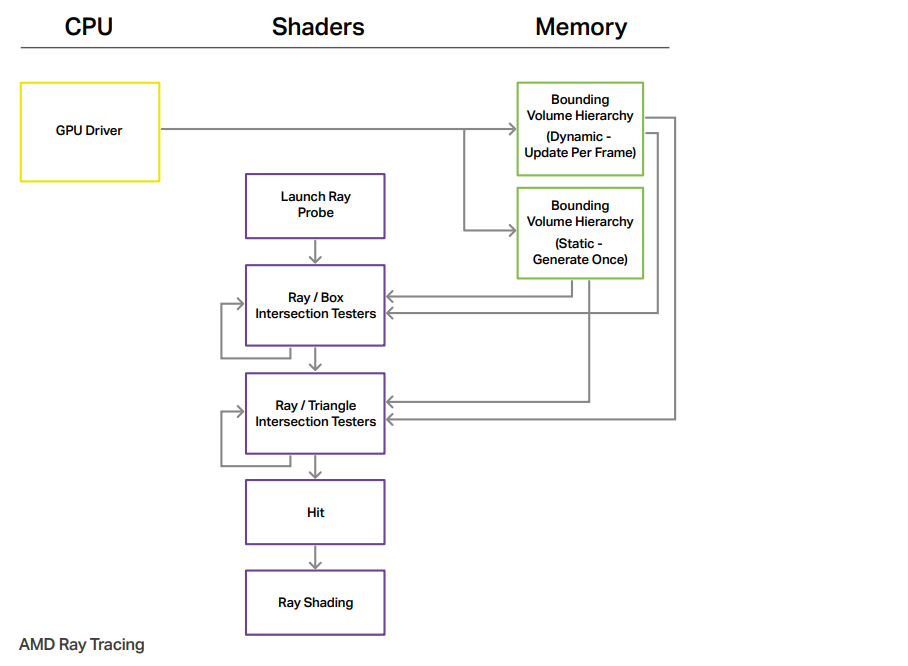

PowerVR、RTX等系列GPU已經新增了光線追蹤的硬體單元,從而加速了實時光線追蹤的到來。此外,在GPU內如何提升光線、紋理等數據的一致性也是提升光線追蹤的首要問題。PowerVR內置了一致性引擎,用來收集和處理相關性高的光線(下圖)。

此外,GPU需要考慮SIMD、SIMT、連貫性、記憶體合併、核心佔用、管線瓶頸、同步方式甚至物理溫度(防止降頻)等,更多可參閱:Parallel Architectures。

在實現時,需要注意或使用自相交、數據精度、面片(patch)相交、載入均衡、多相交、LOD等問題或技巧。更多可參閱:

17.3.11 綜合技術

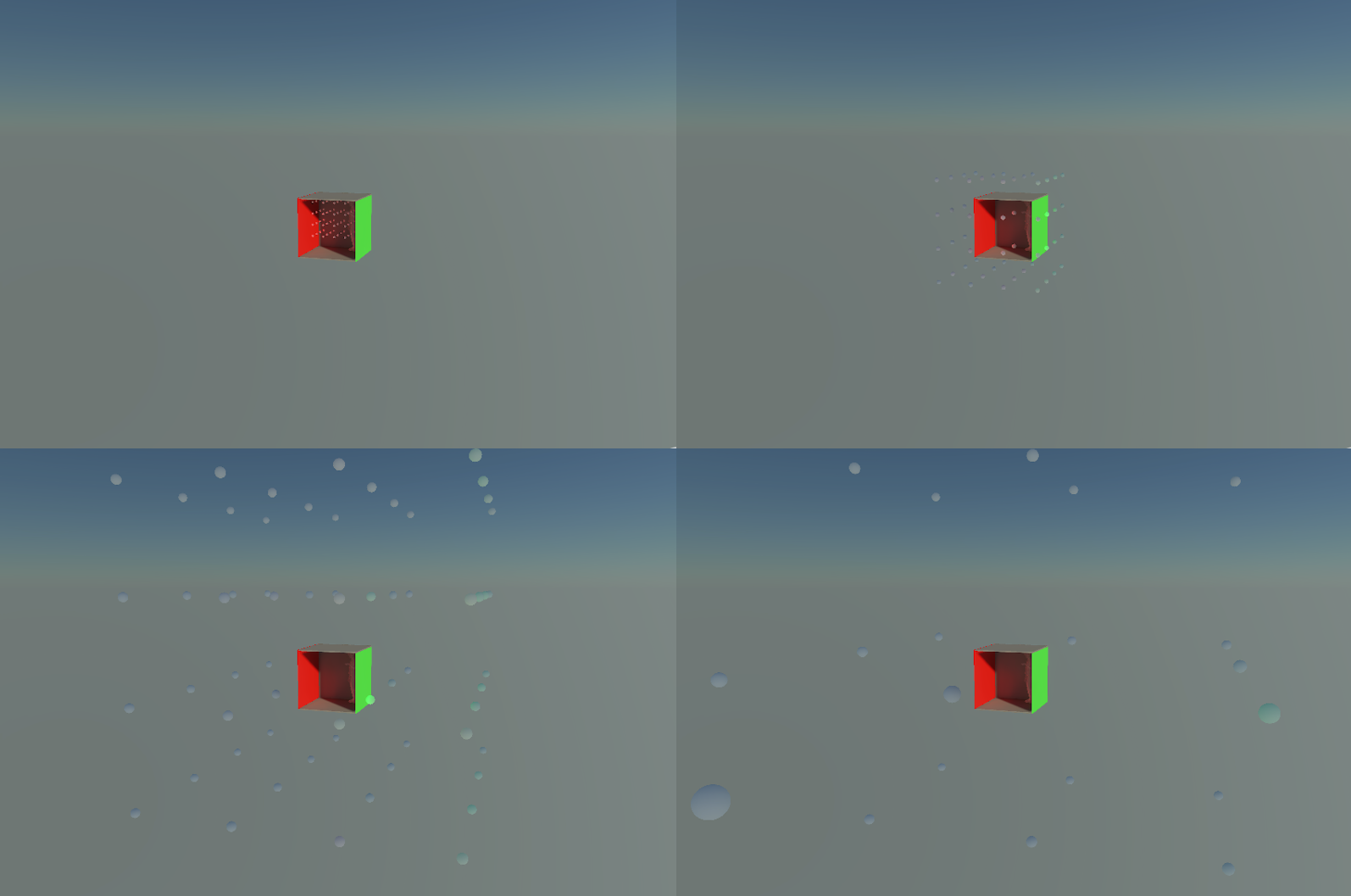

17.3.11.1 Lumen GI

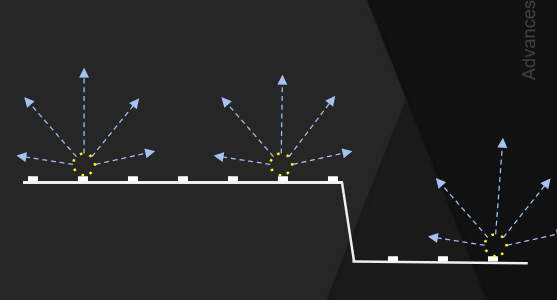

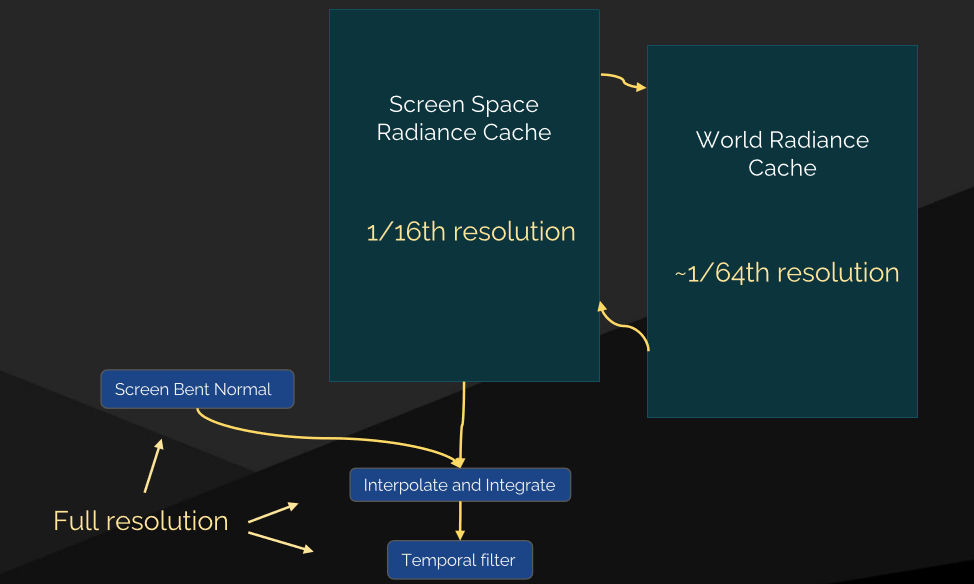

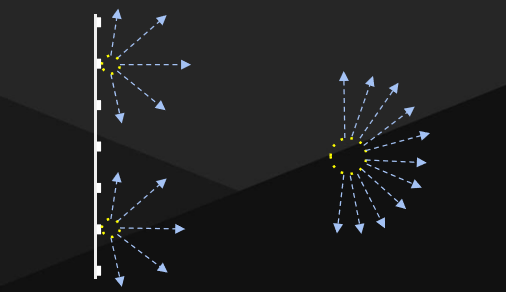

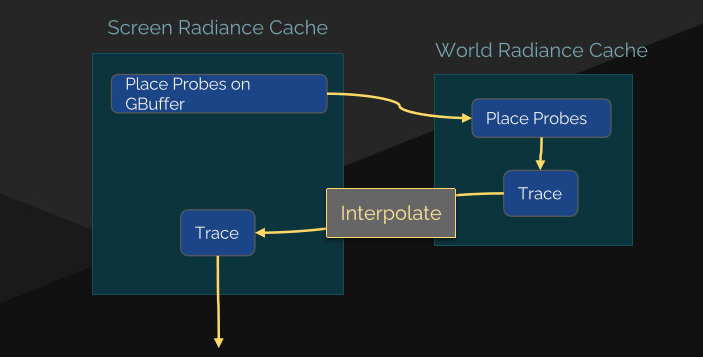

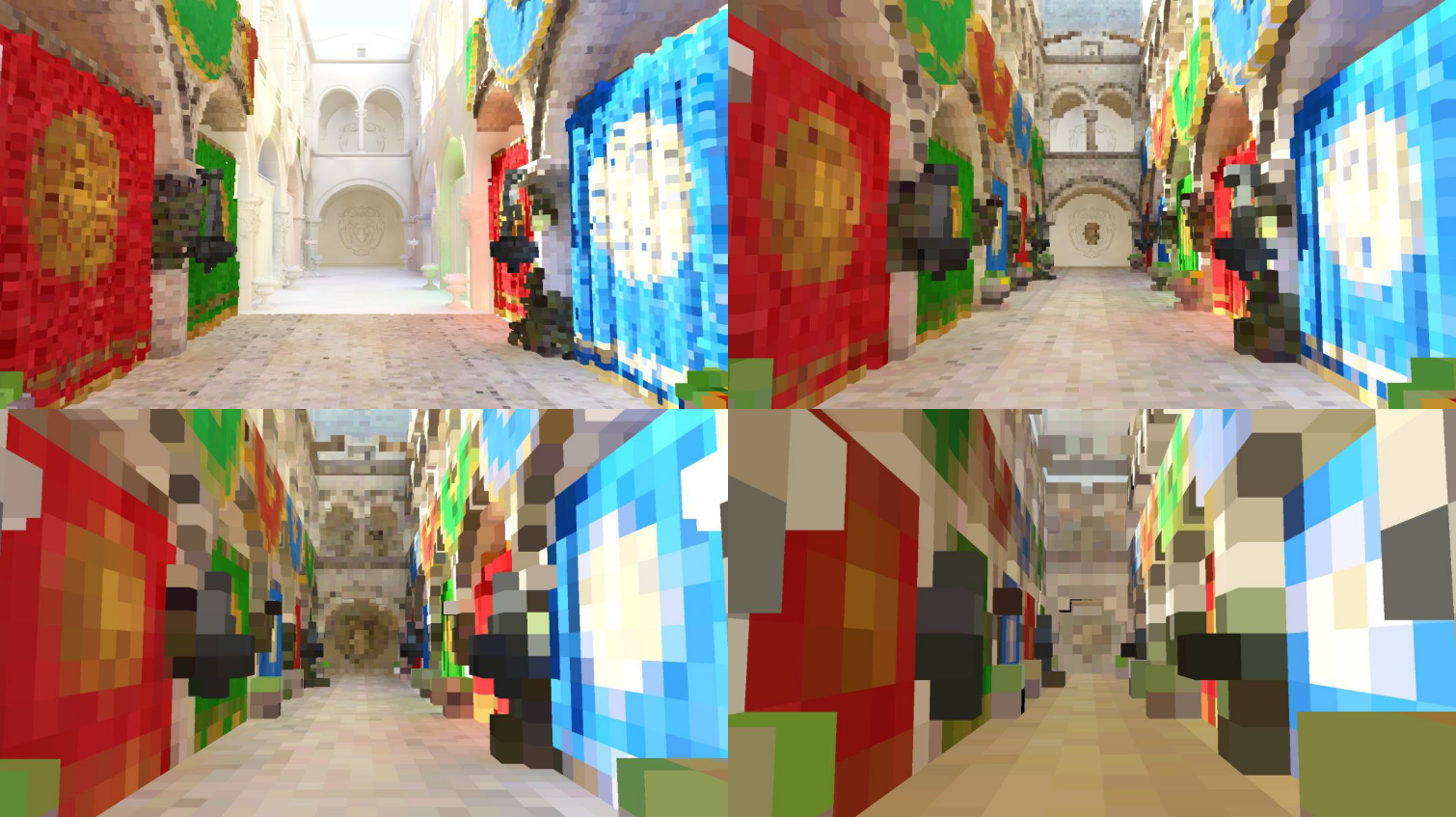

以往的實時研究有輻照度場(Irradiance Fields)、螢幕空間降噪器(Screen Space Denoiser)等方式。而UE5的Lumen使用了螢幕空間降噪器(Screen Space Denoiser)。

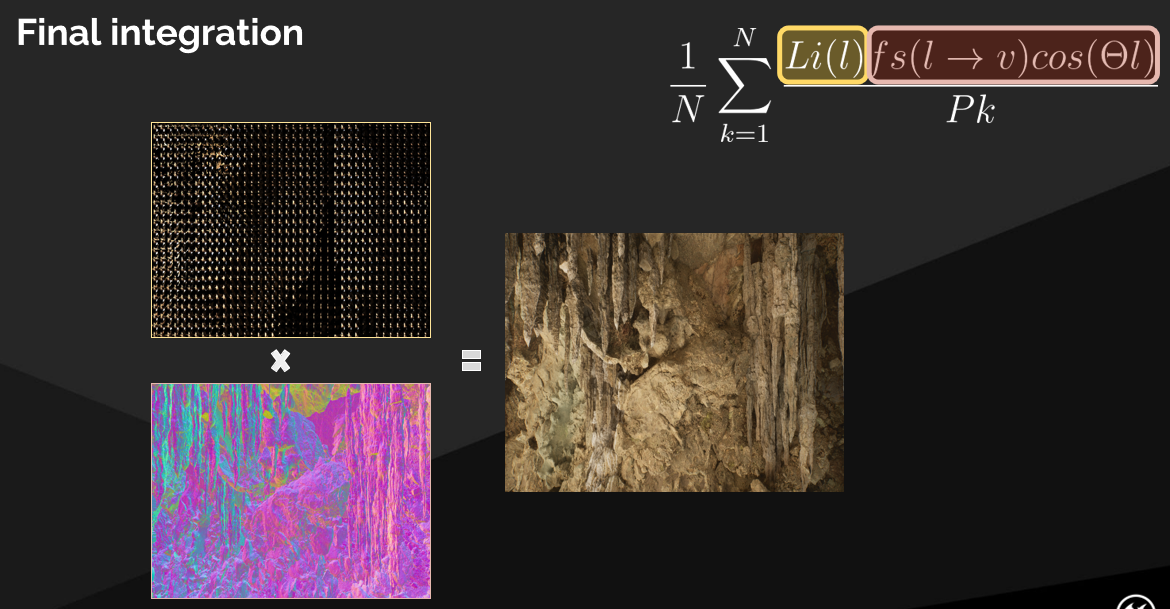

下取樣入射輻射,入射光是相干的,而幾何法線不是,以全解析度積分BRDF上的輸入照明:

在輻射快取空間中過濾,而不是螢幕空間(下圖左)。首先要進行更好的取樣——重要的是對入射光進行取樣(下圖中)。穩定的遠距離照明和世界空間輻射快取(下圖右)。

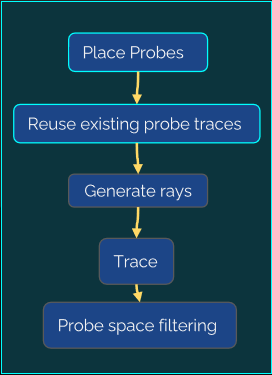

最終收集管線:

其中螢幕空間的輻照率快取可以細分成以下階段:

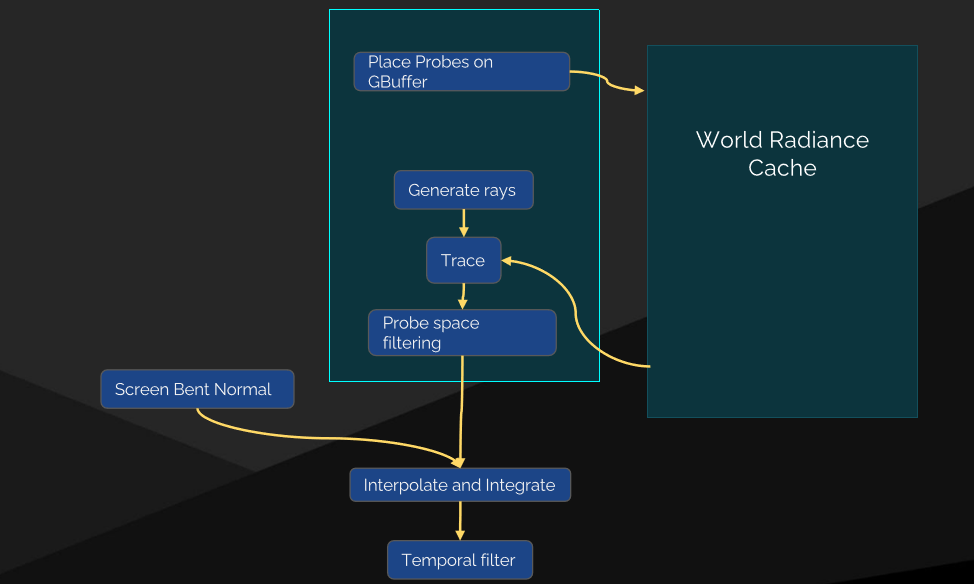

螢幕探針結構體:帶邊框的八面體圖集,通常每個探針8×8個,均勻分布的世界空間方向,鄰域有相同的方向,二維圖集中的輻射率和交點距離:

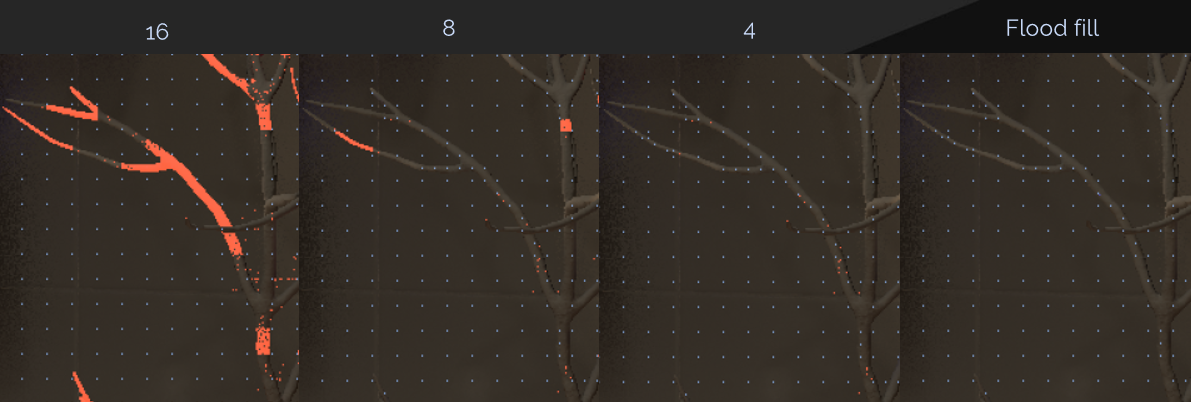

螢幕探針放置:分層細化的自適應布局[Křivánek等人2007],迭代插值失敗的地方,最終級別的地板填充(Flood fill)。

採用自適應取樣——實時性需要上限,不希望在處理自適應探針時遇到額外障礙,將自適應探針放在圖集底部:

螢幕探針抖動——時間抖動放置網格和方向,直接放置在像素上,沒有泄露,螢幕單元格內的遮擋差異必須通過時間過濾來隱藏:

面距離加權,防止前台未命中泄漏到後台,插值中的抖動偏移,只要還在同一個面上,在空間上分布探針之間的差異,通過擴展TAA 3×3的鄰域達到時間穩定最終照明。

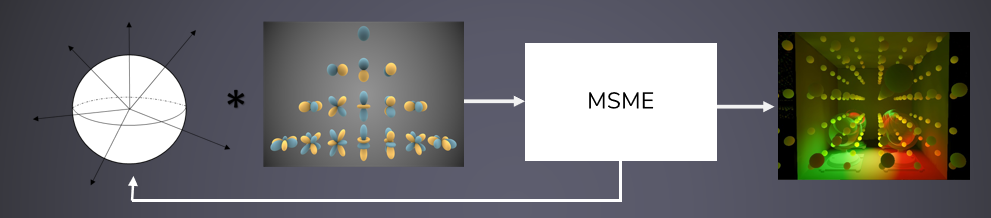

還使用了重要性取樣——對於入射輻射率\(L_i(l)\),重投射最後一幀的螢幕探針的輻射率!不需要做昂貴的搜索,光線已按位置和方向索引,回退到世界空間探針上。對於BRDF,從將使用此螢幕探針的像素累積,更好的是,希望取樣與入射輻射率\(L_i(l)\)和BRDF的乘積成比例。

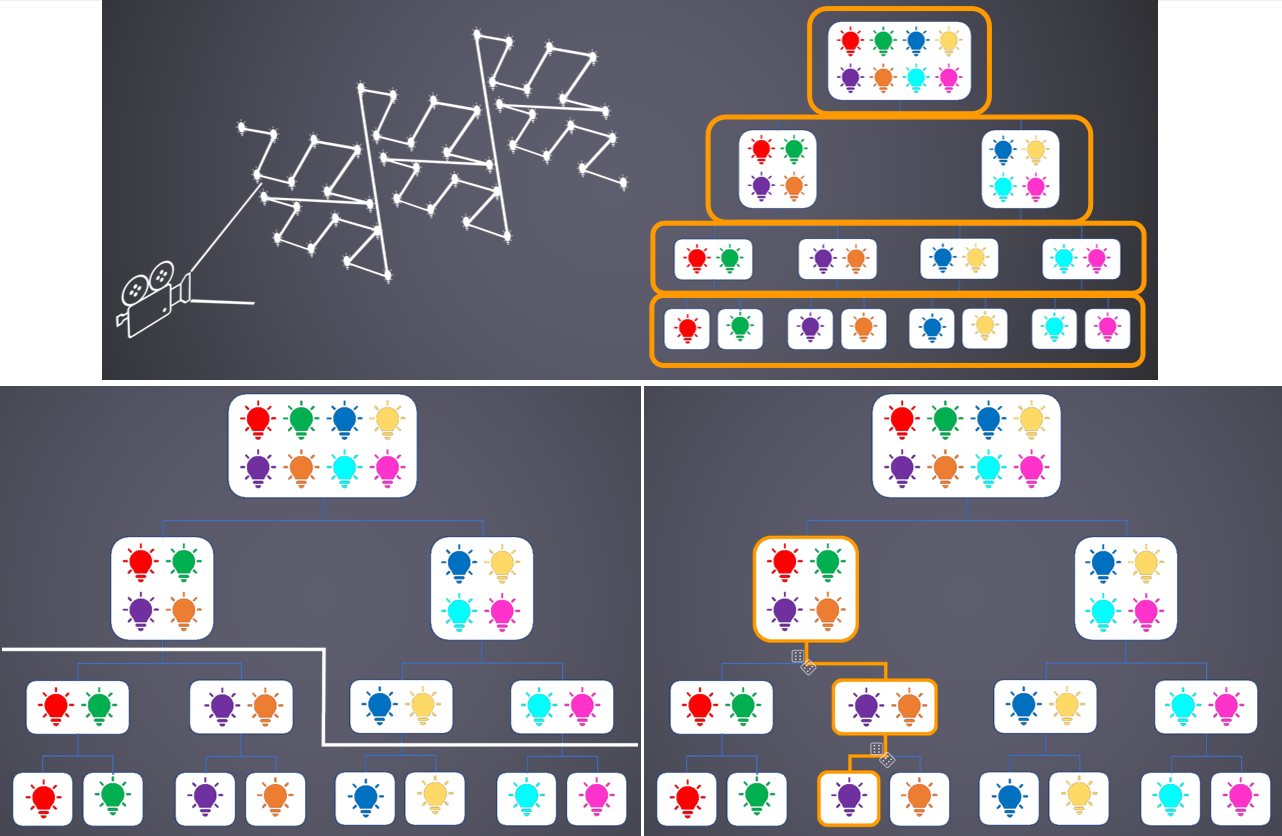

結構重要性取樣(Structured Importance Sampling)——將少量樣本分配給概率密度函數(PDF)的層次結構區域,實現良好的全局分層,樣本放置需要離線演算法。

完美地映射到八面體mip四叉樹!

集成到管線中——向追蹤執行緒添加間接路徑,存儲RayCoord、MipLevel,追蹤後,將TraceRadiance組合進均勻的探針布局,以進行最終集成:

光線生成演算法——計算每個八面體紋理的BRDF的PDF x 光照的PDF,從均勻分布的探針射線方向開始,需要固定的輸出光線計數——保持追蹤執行緒飽和。按PDF對光線進行排序,對於PDF低於剔除閾值的每3條光線,超級取樣以匹配高PDF光線。

改進的點是不允許光照PDF來剔除光線,光照PDF為近似值,BRDF為精確值,藉助空間過濾可以更積極地進行剔除,具有較高BRDF閾值的剔除,在空間過濾過程中減少剔除光線的權重,修復角落變暗的問題。

重要性取樣回顧:使用最後一幀的光照和遠距離光照引導此幀的光線,將射線捆綁到探針中可以提供更智慧的取樣。

接下來聊空間過濾的技術。

輻射快取空間中的過濾:廉價的大空間濾波,探針空間為32×32,螢幕空間為482×482,可以忽略空間鄰域之間的發現差異,僅深度加權。從鄰域收集輻射率——從相鄰探針中匹配的八面體單元收集,誤差權重——重投影的相鄰射線擊中的角度誤差,過濾遠處的燈光,保留局部陰影。

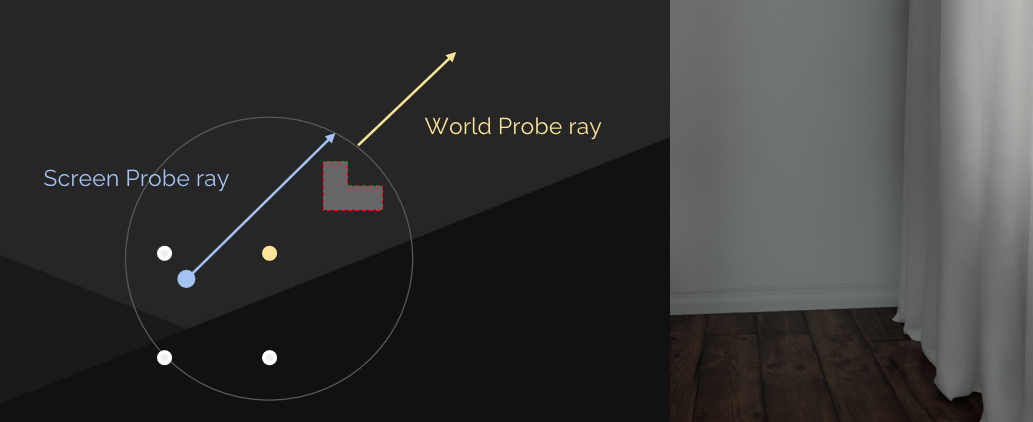

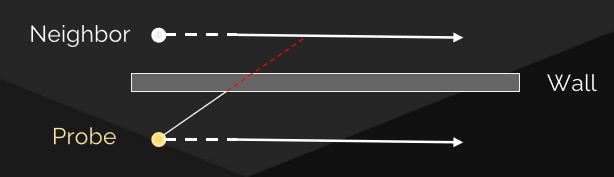

對於平坦表面的效果是良好的,但對於幾何接觸的地方,存在漏光的問題:

保持接觸陰影——角度誤差偏向遠光等於泄漏,遠距離光沒有視差,永遠不會被拒絕。解決方案是在重投影之前,將鄰域的命中距離截取到自己的距離。

接下來聊世界空間的輻射快取。

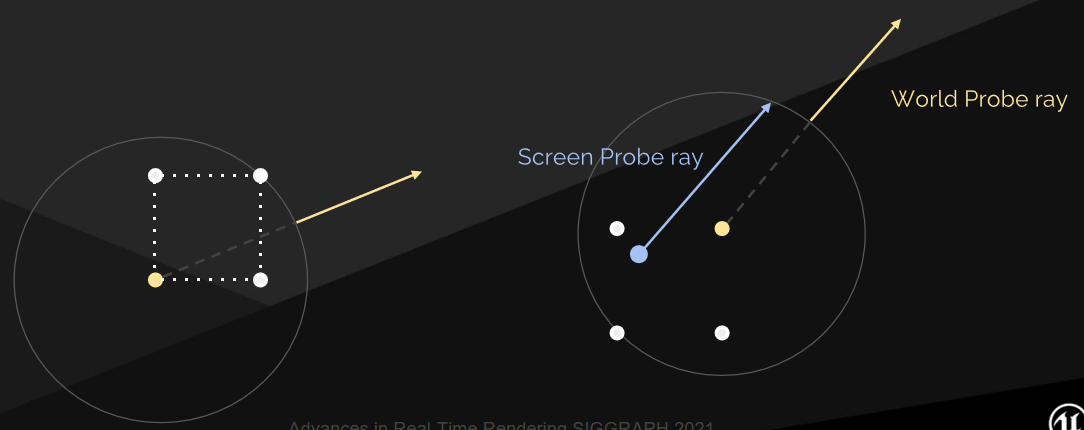

遠距離光存在問題,微亮特徵的噪點隨著距離的增加而增加,長而不連貫的追蹤是緩慢的,遠處的燈光正在緩慢變化——快取的機會,附近螢幕探針的冗餘操作,解決方案是對遠距離輻射進行單獨取樣。用於遠距離照明的世界空間輻射快取(The Tomorrow Children [McLaren 2015]的技術),自世界空間以來的穩定誤差——易於隱藏,就像體積光照圖一樣。

管線集成——在螢幕探針周圍放置,然後追蹤計算輻射,插值以解決螢幕探測光線的遠距離照明。

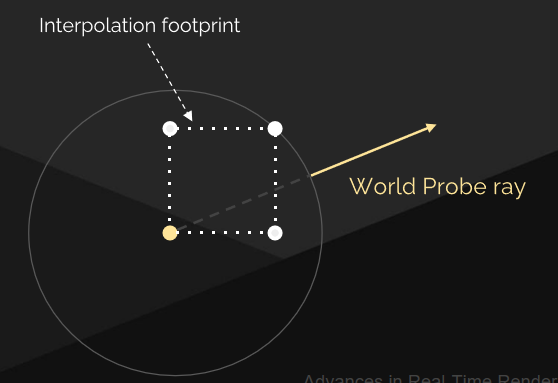

世界探針射線必須跳過插值足跡以避免自光照:

螢幕探針光線必須覆蓋插值足跡+跳過距離:

還存在漏光的問題,世界探針的輻射應該被遮擋,但不是因為視差不正確。

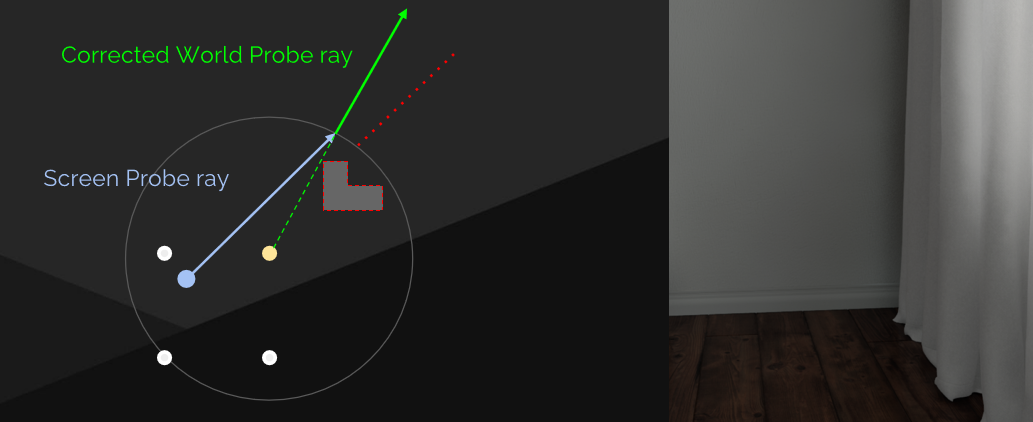

解決方案是簡單的球面視差,重投影螢幕探針光線與世界探針球相交。

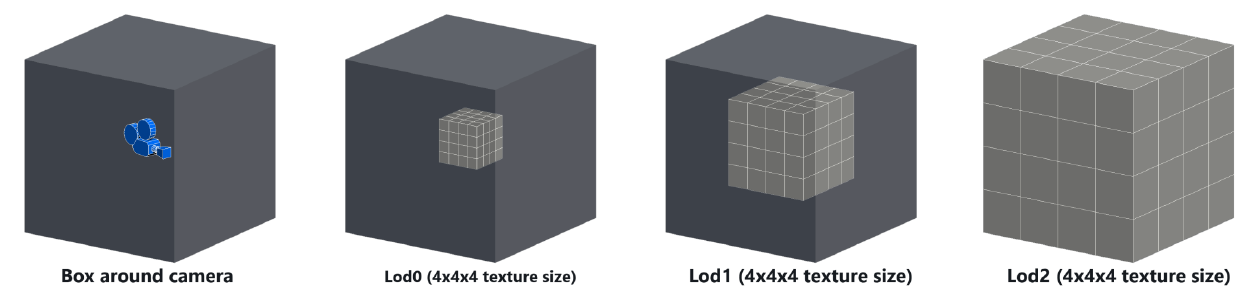

稀疏覆蓋——以攝影機為中心的3d clipmap網格將探針索引存儲到圖集中,Clipmap分布保持有限的螢幕大小。

八面體探針圖集存儲輻射、追蹤距離,通常每個探針為32×32的輻射率:

放置和快取——標記將在後面的clipmap間接中插入的任何位置,對於每個標記的世界探針:重用上一幀的追蹤,或分配新的探針索引,重新追蹤快取命中的子集以傳播光照更改。

依然存在的問題是高度可變的成本,快速的攝像機移動和不連續需要追蹤許多未經快取的探針。解決方案是全解析度探針的固定預算,快取未命中的其它探針追蹤的解析度較低,跳過照明更新的其它探針追蹤。

BRDF的重要取樣的做法是從螢幕探針累積BRDF,切塊(Dice )探針追蹤分塊,根據BRDF生成追蹤分塊解析度。超取樣近的相機,高達64×64的有效解析度,4096條追蹤!非常穩定的遠距離照明。

探針之間的空間過濾——再次拒絕鄰域交點,問題是不能假設相互可見性。理想情況下,通過探測深度重新追蹤相鄰射線路徑,單次遮擋試驗效果良好,幾乎免費——重複使用探針深度。

世界空間輻射快取還用於引導螢幕探針重要性取樣、頭髮、半透明、多反彈。

回到積分,現在已經在螢幕空間的輻射快取中以較低的解析度計算了入射輻射,需要以全解析度進行積分,以獲得所有的幾何細節。

重要性取樣BRDF會導致不一致的獲取,8spp*4相鄰探針方向查找,可以使用mips(過濾重要性取樣),但會導致自光照,尤其是在直接照明區域周圍。將探針輻射轉換為三階球諧函數:SH是按螢幕探針計算的,全解析度像素一致地載入SH,SH低成本高品質積分。

對於高粗糙度下的光線追蹤反射,在漫反射上聚集。重用螢幕探針——從GGX生成方向,取樣探針輻射,自動利用已完成的探針取樣和過濾!下取樣追蹤會丟失接觸陰影。使用全解析度彎曲法線——使用快速螢幕追蹤進行計算,與螢幕探針之間的距離耦合的追蹤距離,約16像素。與螢幕空間輻射快取積分——將螢幕探針GI視為遠場輻照度,全解析度彎曲法線表示場的數量,基於水的間接照明,多重反彈似給出場輻照度。

接著使用時間過濾——抖動探針位置需要可靠的時間過濾,使用深度剔除,結果穩定,但對光線變化的反應也很慢。追蹤過程中追蹤命中速度和命中深度,屬於快速移動對象的投影面積。當追蹤擊中快速移動的對象時,切換到快速更新模式,降低時間過濾,提高空間過濾。

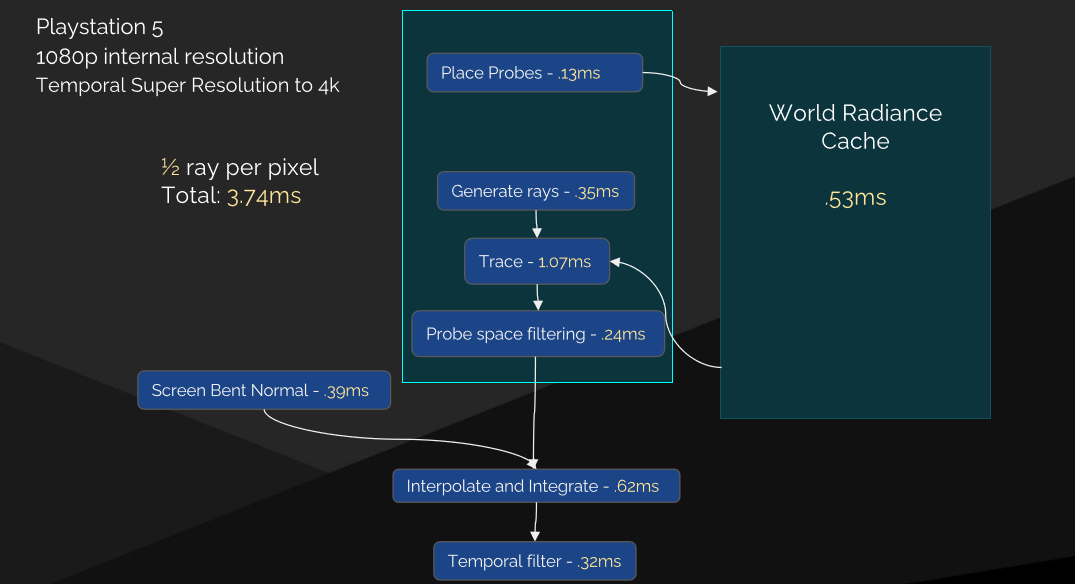

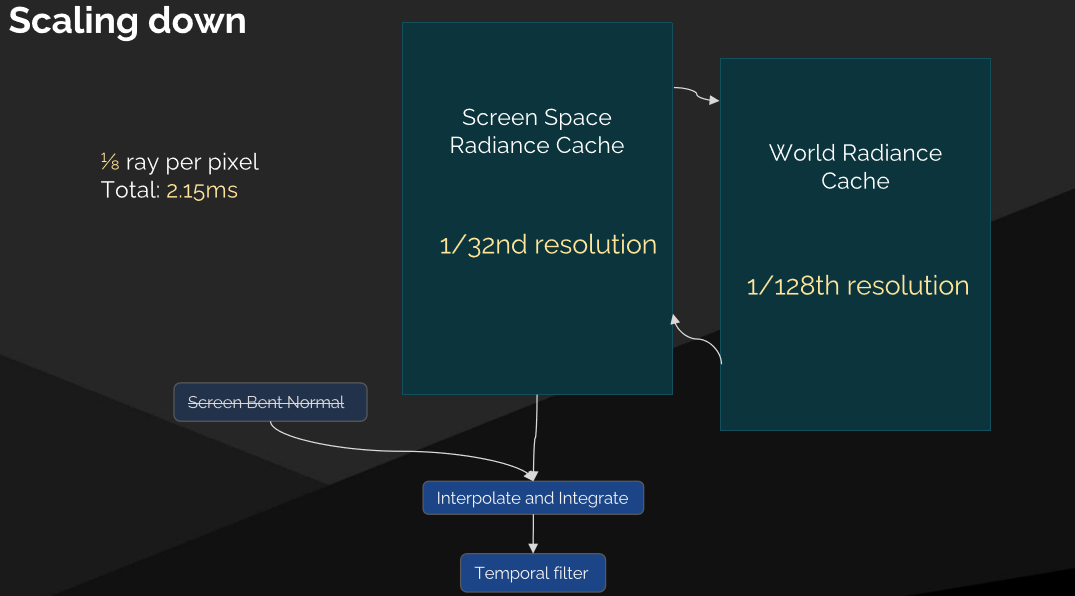

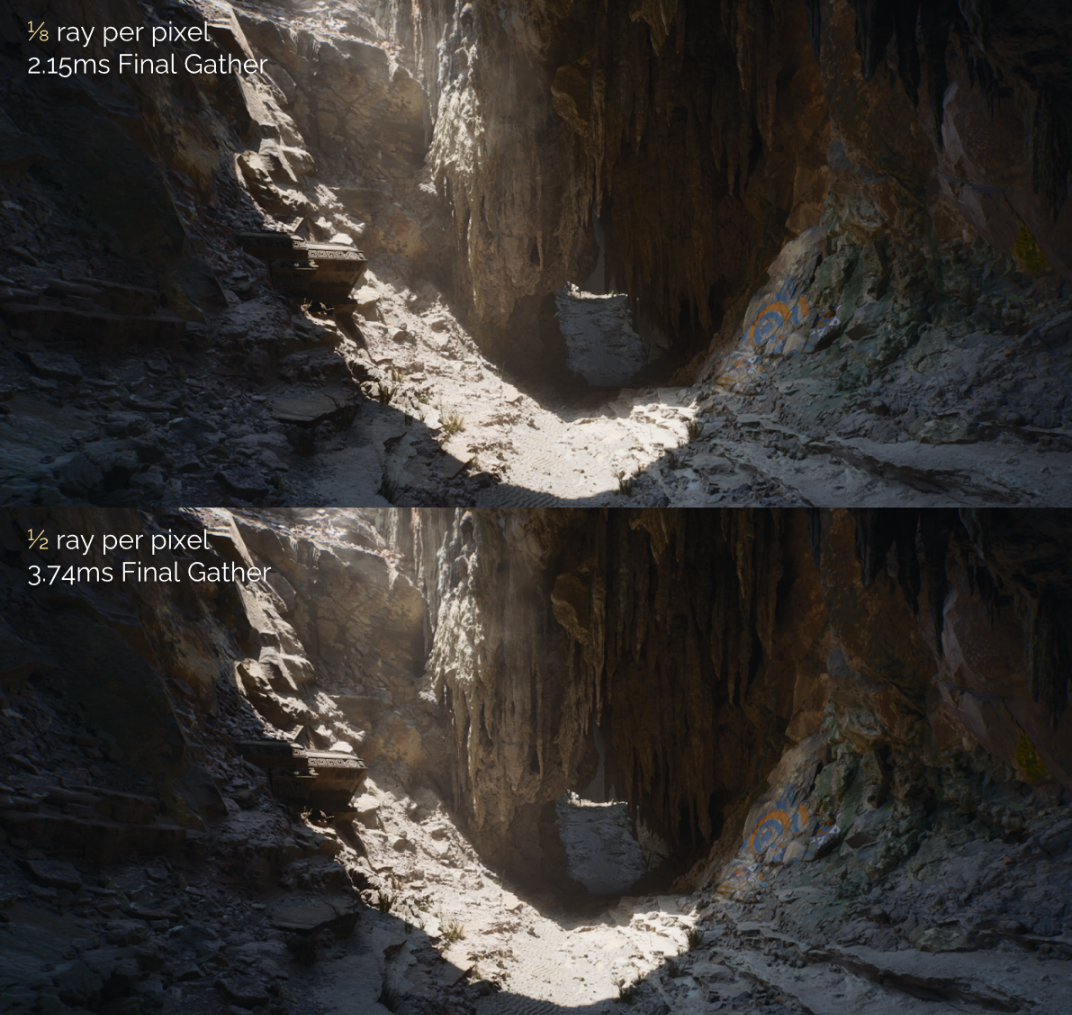

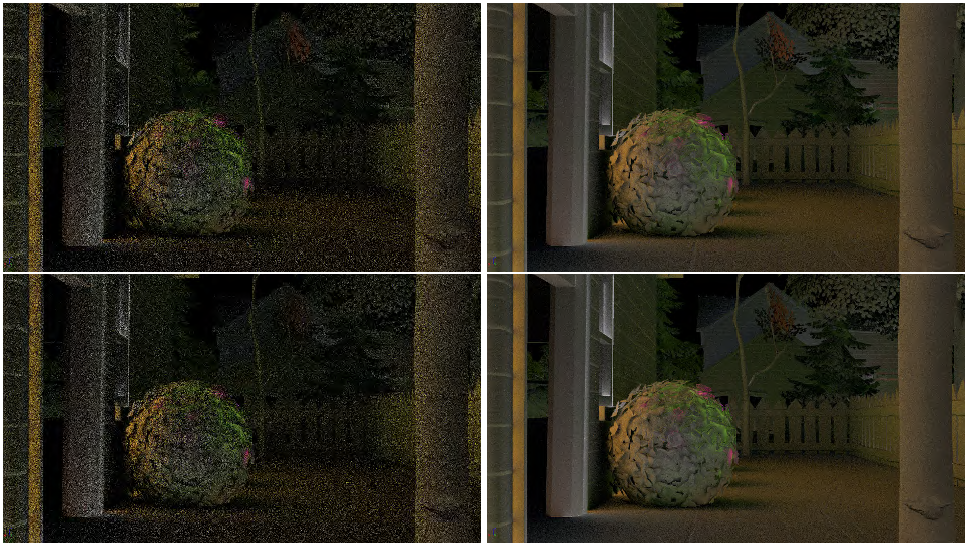

最終收集性能:

未來的工作是降噪品質、高動態場景中的時間穩定性、將螢幕空間輻射快取應用於Lumen的表面快取以實現多反彈GI。

Radiance Cache只是Lumen的一小部分技術,Lumen還涉及表面快取、軟體射線追蹤、硬體光線追蹤、反射、透明GI等內容。關於Lumen的源碼剖析可參見:剖析虛幻渲染體系(06)- UE5特輯Part 2(Lumen和其它)。

17.3.11.2 Surfel GI

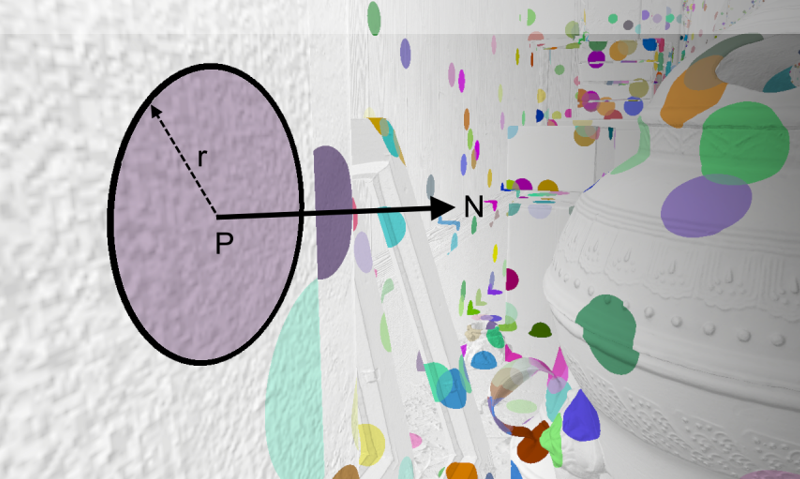

Surfel即表面元素(Surface Element),一個surfel由位置、半徑和法線定義,並近似了給定位置附近表面的一個小鄰域(下圖)。

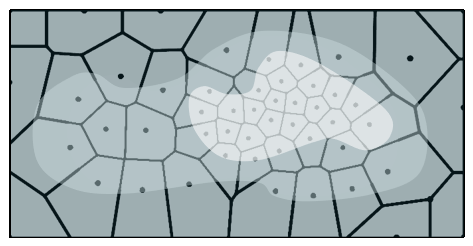

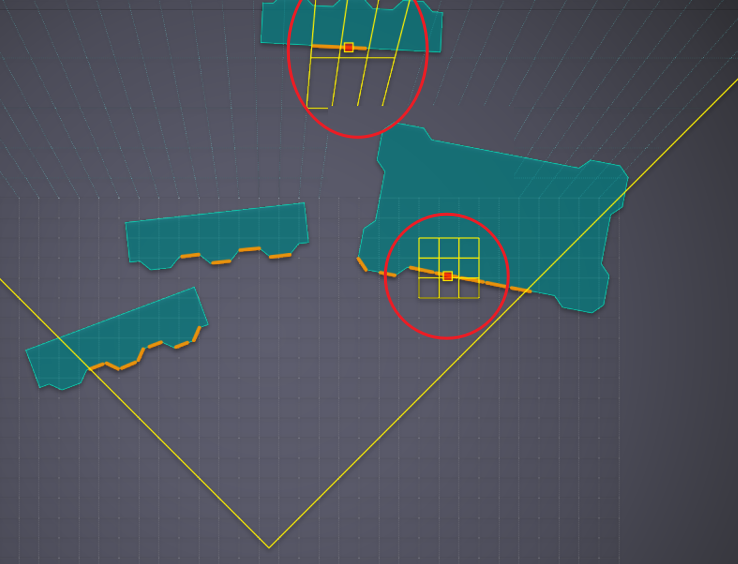

從GBuffer中生成面元,當幾何圖形進入視圖時填充螢幕,在世界空間中持久存在,累積和快取輻照度。迭代螢幕空間填充,將螢幕拆分為16×16塊,找到覆蓋率最低的tile,應用面元覆蓋率和追蹤權重,如果tile超過隨機閾值,則生成surfel。

除了支援剛體,還支援蒙皮骨骼的面元化。由於所有東西都假設是動態的,所以蒙皮幾何體和移動幾何體都與解決方案的其餘部分交互,就像靜態幾何體一樣。

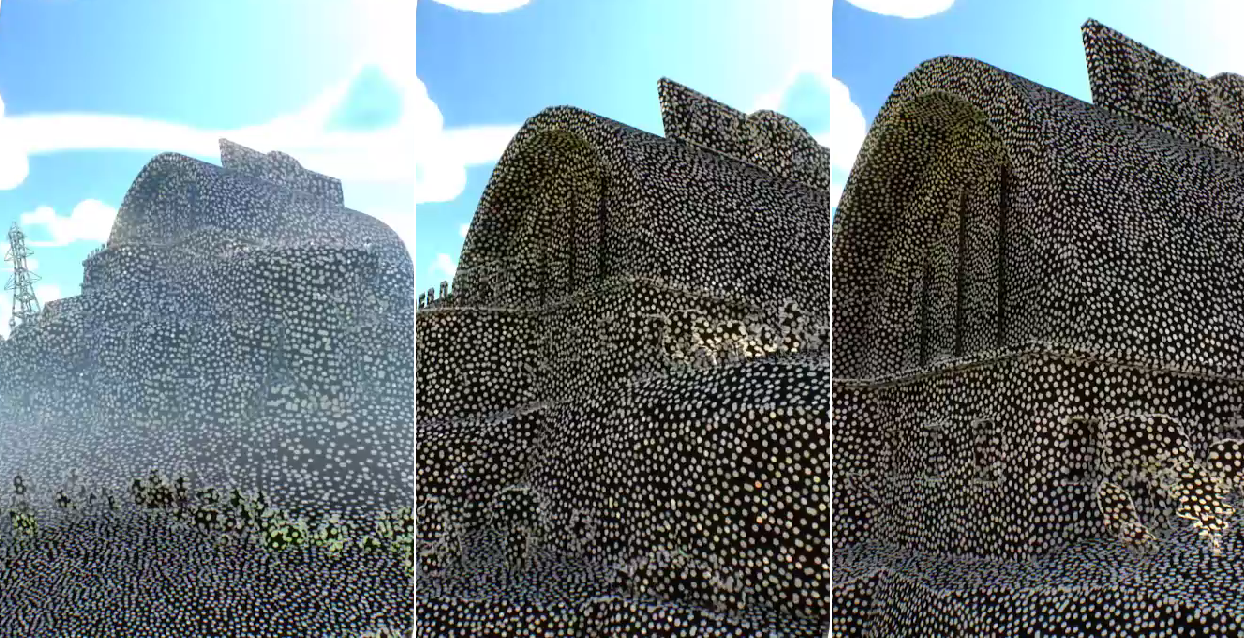

面元根據螢幕空間投影進行縮放,生成演算法確保覆蓋範圍在任何距離,由非線性加速度結構支撐。

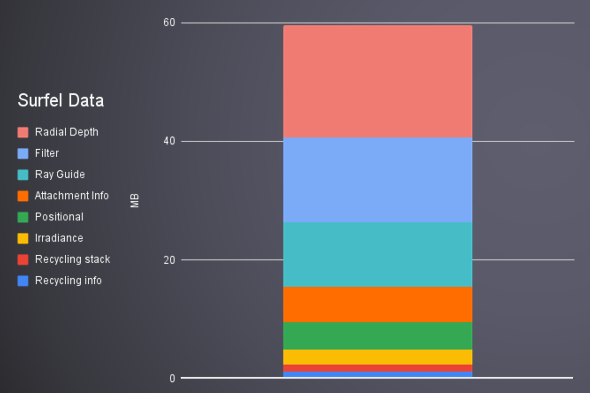

所有東西都有固定大小的緩衝區,可預測的預算,固定數量的面元,固定的加速度結構,回收未使用的面元。

讓相關的面元保持活躍,最後一次見到時追蹤,如果在間隙檢測期間看到,則重置,位置更新期間增加。啟發式基於激活的面元總數、自從見過的時間、距離、覆蓋率。下圖是距離啟發式:

為了應用光照,對每個像素:查找表面網格單元,從單元格里取N個面元,累積表面輻照度,按距離和法線加權,如果輻照度權重<1,則添加加權的平均單元格的輻照度。存在光照溢出的問題,使用徑向高斯深度來解決:

修復前後對比:

積分輻照度圖示:

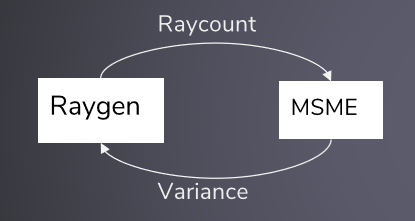

修正指數移動平均估值器[BarréBrisebois2019],追蹤短期均值和方差估計值,使用短期估計器調整混合因子,能夠快速響應變化,同時收斂到低噪點。基於短期方差的偏差光線計數,使用射線計數通知相對置信度的多尺度均值估計器,回饋迴路對變化和變化做出快速反應,在穩定的情況下保持光線計數小。

累積漫反射輻照度,假設是蘭伯特BRDF,通過對餘弦葉進行重要取樣來生成光線:

採用了光線引導:

每個surfel在其半球上生成一個移動平均6×6亮度圖,存儲在單個4K紋理中(可支援所有surfel的7×7),每個紋理8位+每個紋理單個16位縮放,規範化每幀函數。

有了重要性取樣變數,函數的每個離散部分都將根據其值按比例選取,還有它的概率密度函數,也就是函數在那個位置的值。

利用附近的面元數據,允許surfel查找相鄰surfel的輻射,結構化加速,使用與surfel VPL相同的權重、Mahalanobis距離、深度函數。

輻照度共享前後對比:

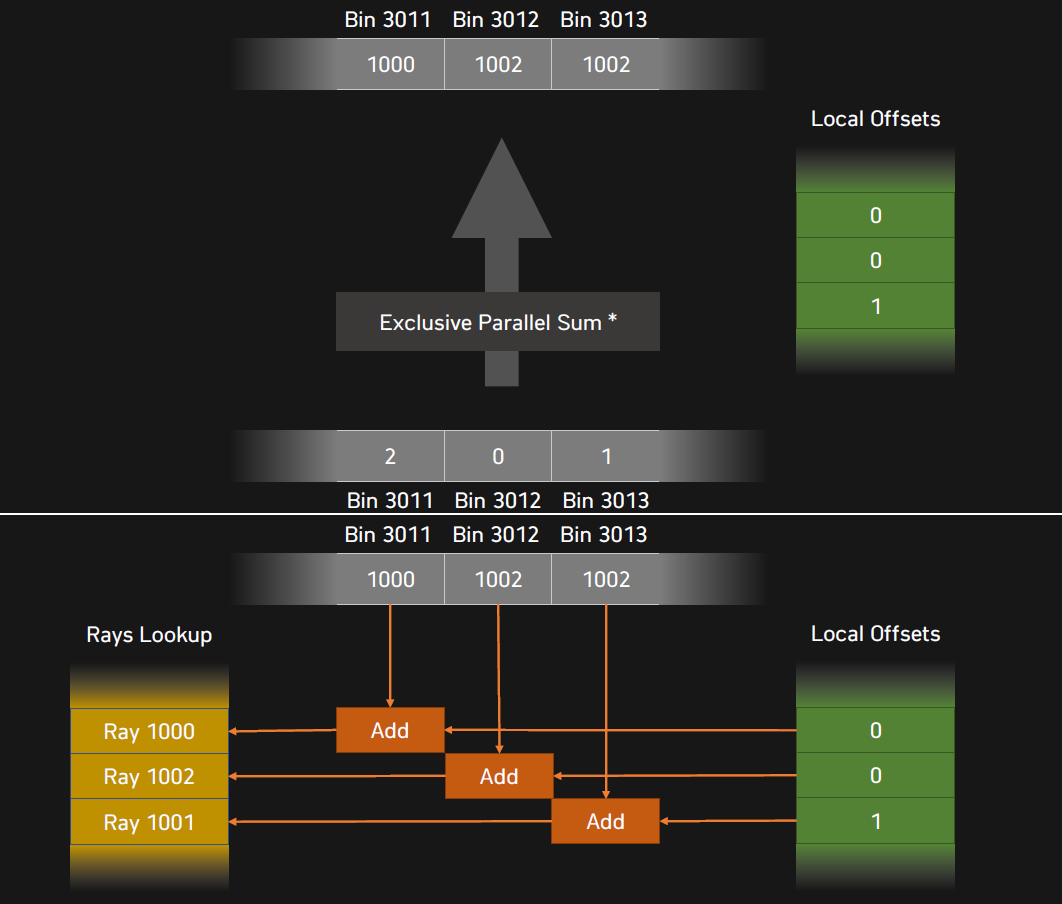

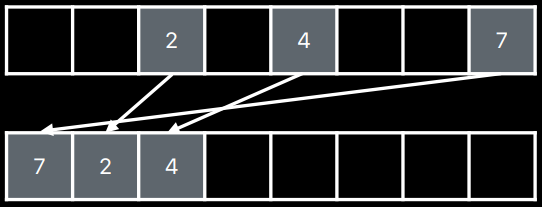

還可以使用BF5方法對光線進行排序,按位置和方向排列的箱射線,12位表示空間,4位表示方向,空間散列的單元定位,射線方向定向,計算箱子總計數和偏移量,根據光線索引和以前計算的面元偏移對光線重新排序。

多光源取樣使用了重要性取樣(隨機光源分割、儲備取樣)。隨機光源切割是小樣本快速收斂,需要預先構建的數據結構,取樣可能開銷很大。

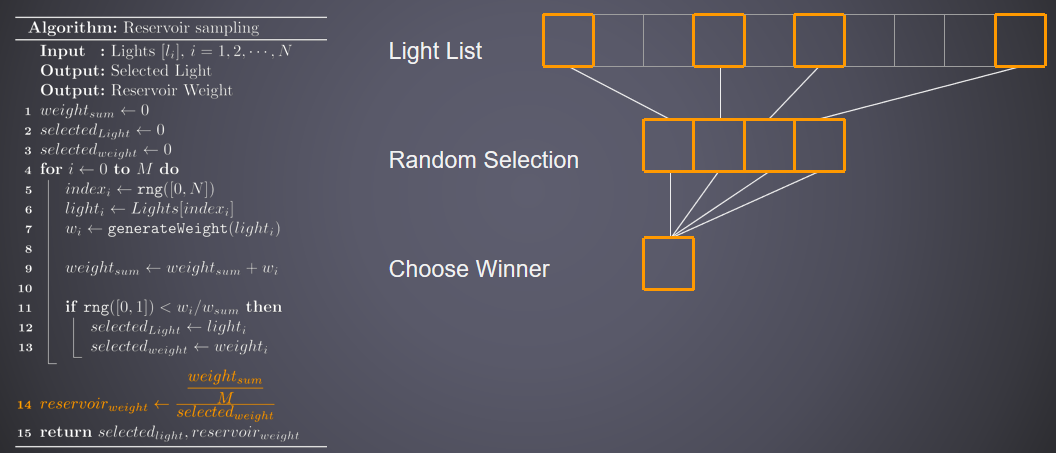

蓄水池取樣(Reservoir Sampling)示意圖:

光線追蹤探針示意圖:

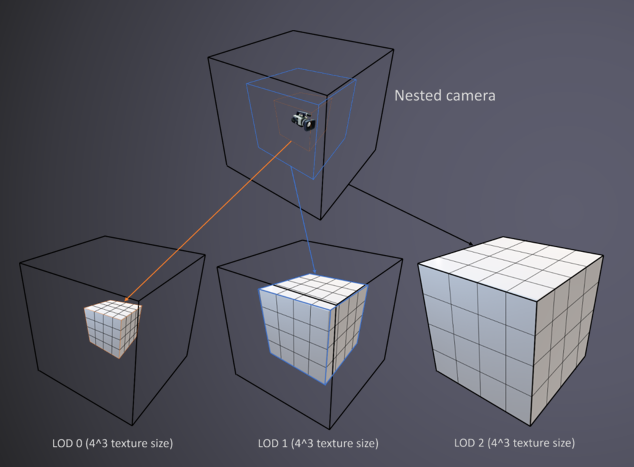

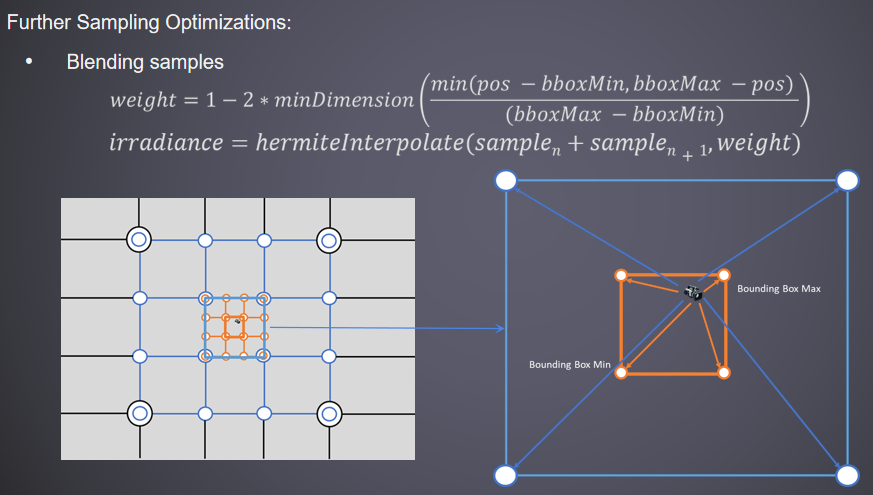

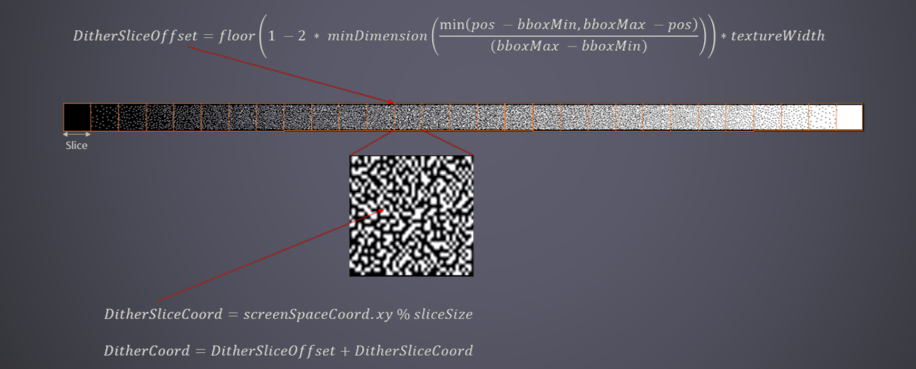

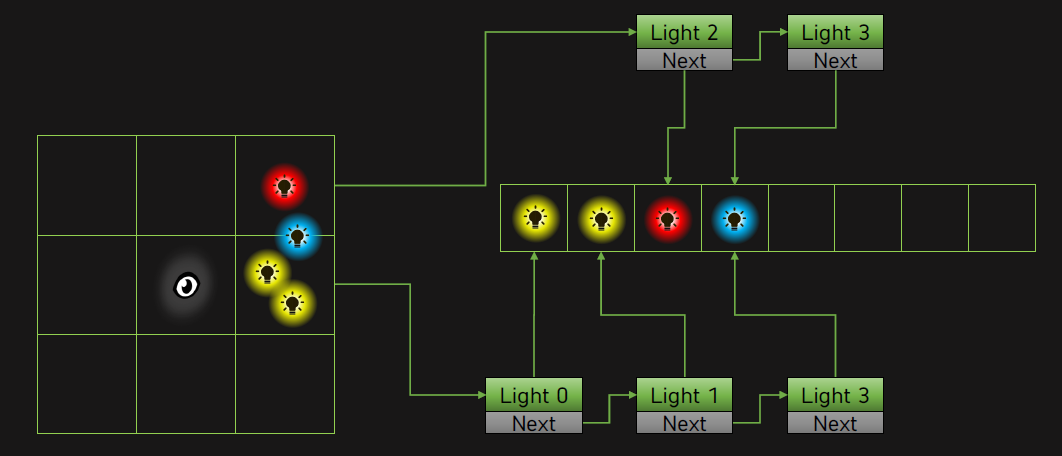

透明對象需要大螢幕支援,例如不透明對象,Clipmap是滿足需求的最佳選擇:保持近距離的細節,支援大規模場景,具有低記憶體成本的稀疏探針放置,LOD的變速率更新。

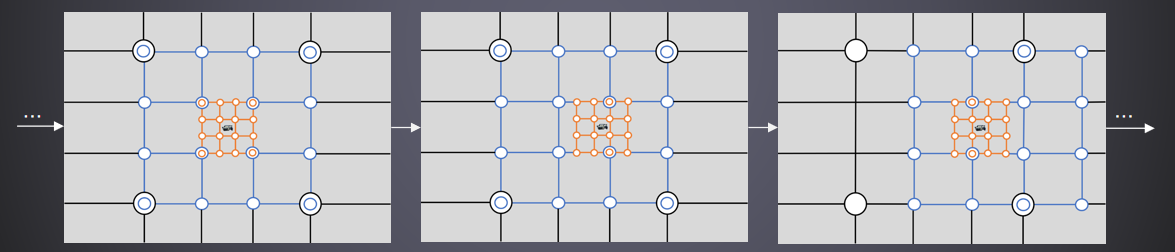

計算更新方向和距離,複製移位後有效的探針數據,用更高級別的探針初始化新創建的探針。

4級clipmap的放置示意圖:

Clipmap取樣過程如下:

進一步的取樣優化是使用藍色雜訊梯度抖動取樣。

一幀概覽:

- 持續的。位置更新,回收利用,網格分配,射線排序,光線追蹤,Clipmap更新,探針追蹤。

- 創建。幾何法線重建,空隙填充,射線排序,光線追蹤,寫入持久存儲,寫入探針體積。

- 過濾。空間降噪,時間降噪。

- 應用。注入新的創建,應用照明(以四分之一區域解析度運行),照明上取樣,Clipmap取樣。

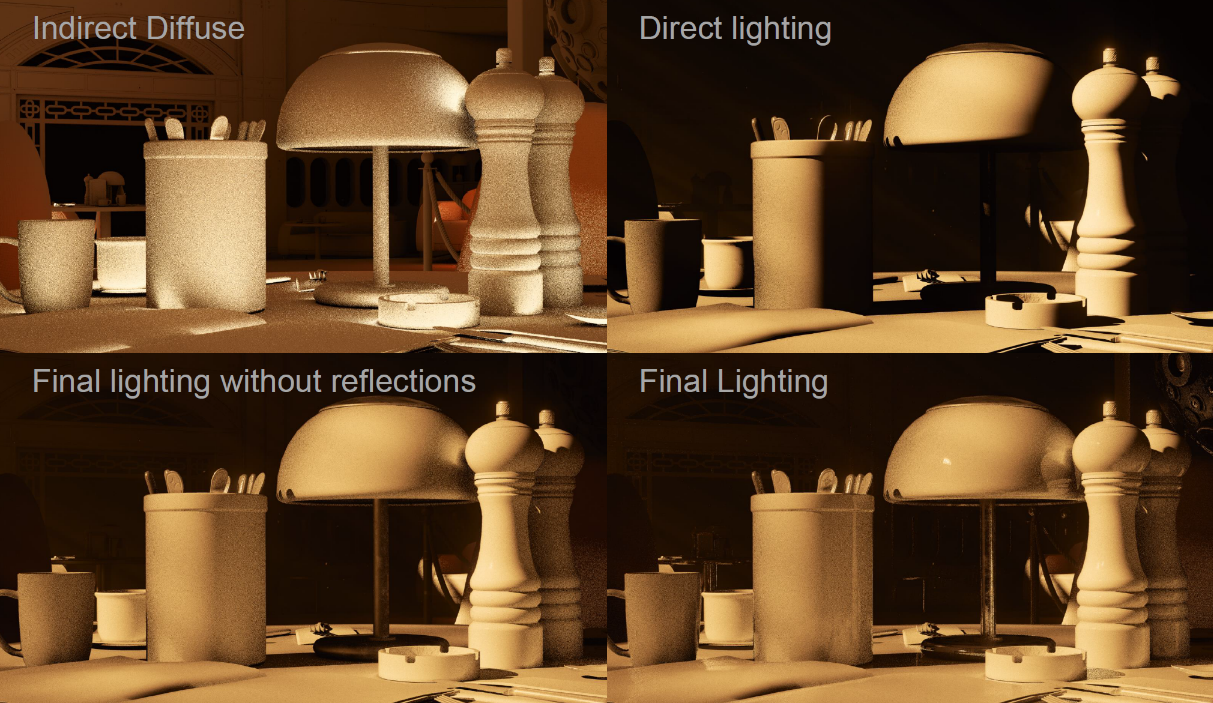

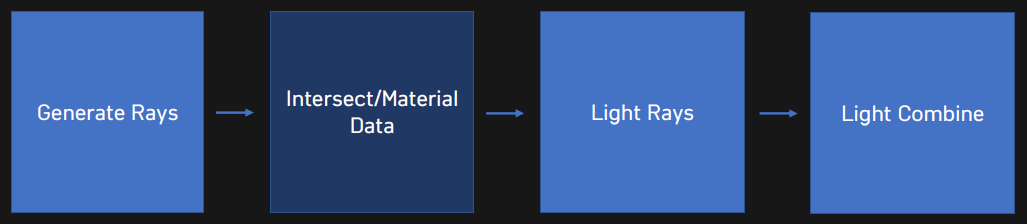

17.3.11.3 收集與合成

過濾通常被認為是取平均值的過程,用於產生模糊像素的相鄰像素的加權平均值,我們稱這種方法為聚集(也稱收集,Gathering),許多像素被聚集在一起以產生一個輸出。Northlight Engine在幾何體交點上取樣照明,最終的光線追蹤各分量和組合效果如下:

總之,通過DXR輕鬆訪問最先進的GPU光線追蹤,性能正在達到目標,易於不適合光柵化的原型化演算法,可與現有低頻結構相結合。

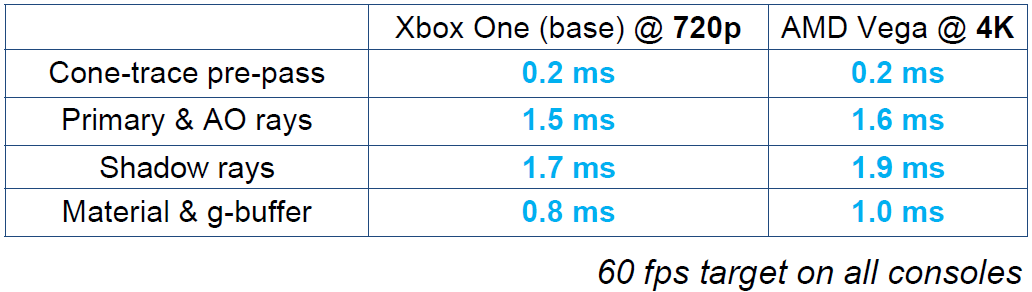

Claybook在光線追蹤的各項時間消耗如下表:

SDF到網格的轉換使用雙通道近似,多個三角形指向同一個粒子,首先需要生成粒子。輸出用於PBD模擬器的線性粒子數組(表面)和三角形渲染的索引緩衝區。使用單個間接繪製調用繪製的所有網格。轉成粒子使用64x64x64的dispatch、4x4x4的執行緒組,過程如下:

- 分組:將\(6^3\)個SDF鄰域載入到GSM。

- 讀取\(2^3\)個GSM的鄰域,如果在邊緣內/外找到:

- 將P移動到表面(梯度下降)。

- 分配粒子id(L+G原子)。

- 將P寫入數組[id]。

- 將粒子id寫入643643網格。

轉成三角形使用64x64x64的dispatch、4x4x4的執行緒組,過程如下:

- 分組:將\(63^3\)個SDF鄰域載入到GSM。

- 讀取\(2^3\)GSM的鄰域,如果找到XYZ邊緣:

- 每個XYZ邊分配2倍三角形(L+G原子)。

- 從643643的id網格讀取3倍的粒子id。

- 將三角形寫入索引緩衝區(3倍的粒子id)。

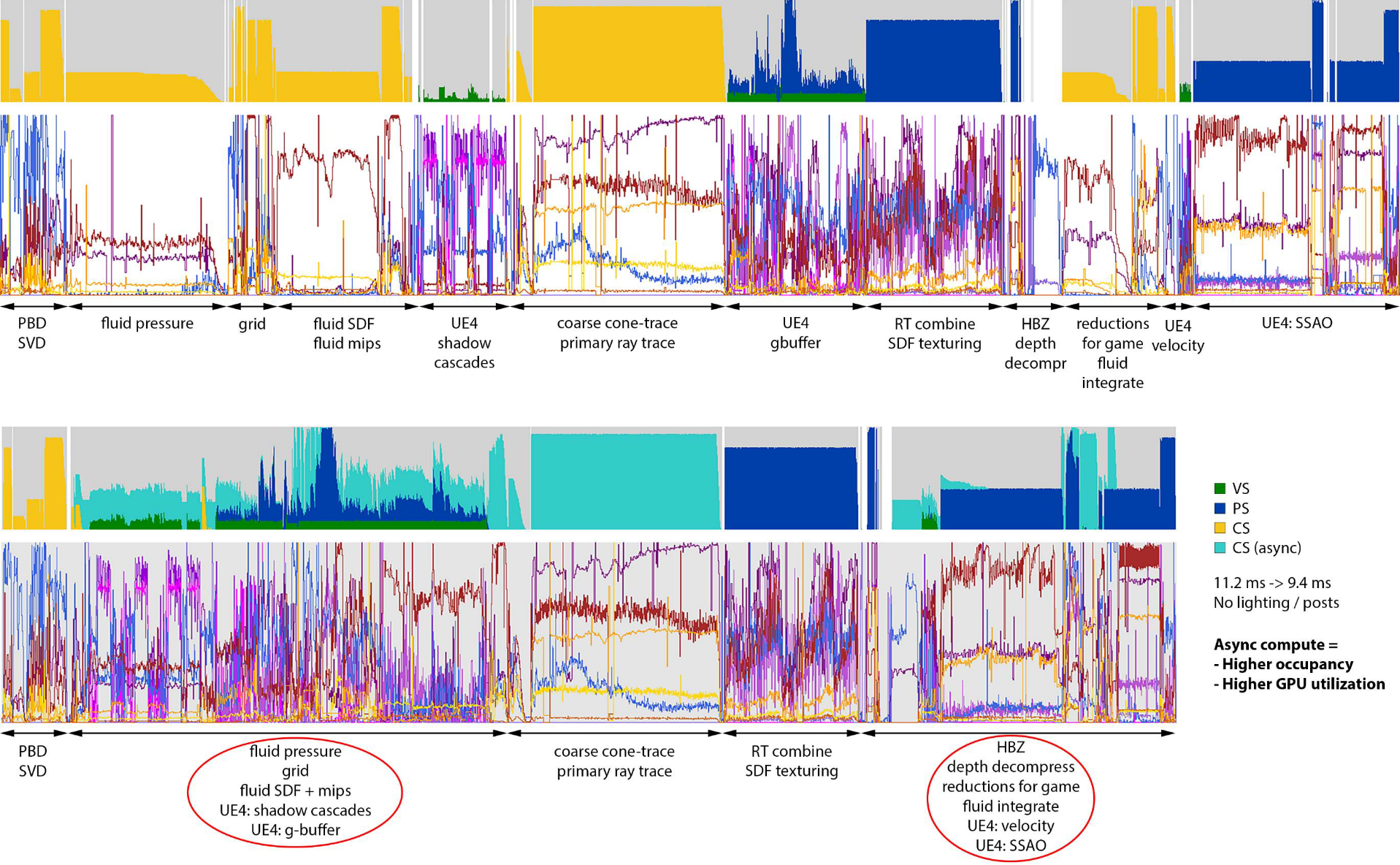

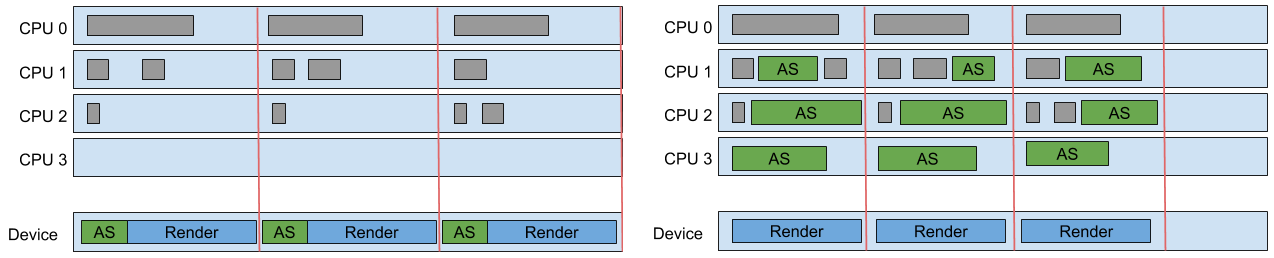

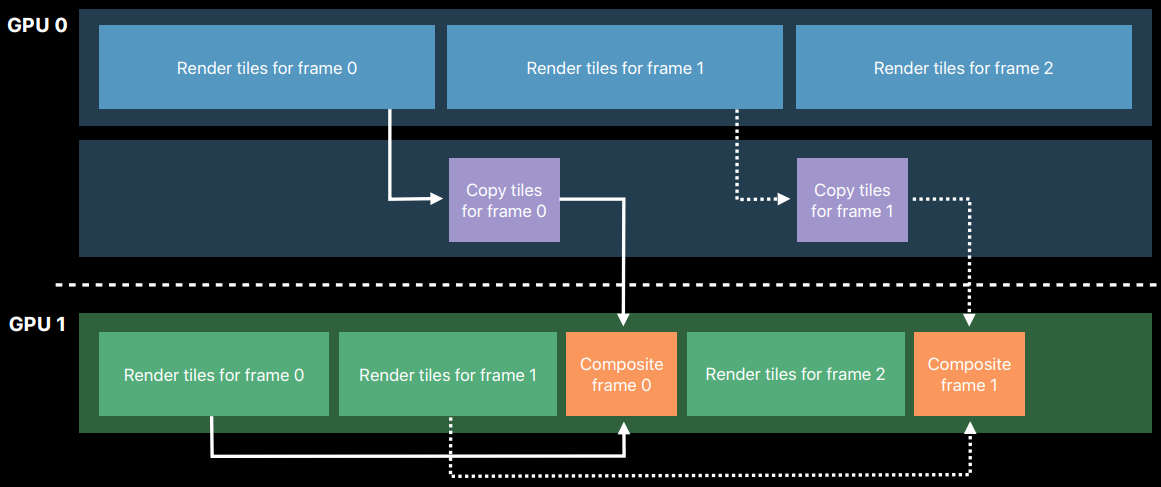

非同步計算:

- 將幀拆分為3個非同步段。

- 重疊UE4的GBuffer和陰影級聯。

- 重疊UE4的速度渲染和深度解壓縮。

- 重疊UE4的照明和後處理。

- 工作立即提交。

- 計算隊列等待柵欄啟動(x3)。

- 主隊列等待柵欄繼續(x3)。

非同步計算可以讓fps提升19%+。

集成到UE4渲染器:

- GBuffer組合。

- 全螢幕PS組合光線追蹤數據。

- 取樣材質貼圖(自定義gather4過濾)。

- 寫入UE4的GBuffer+深度緩衝區(SV_Depth)。

- 陰影遮蔽(shadow mask)組合。

- 全螢幕PS到球體追蹤陰影。

- 寫入UE4陰影遮罩緩衝區(使用alpha混合)。

UE4 RHI訂製:

- 在不進行隱式同步的情況下設置渲染目標。

- 可以對重疊深度/顏色進行解壓縮。

- 可以將繪製重疊到多個RT(下圖)。

- 清除RT/buffer而不進行隱式同步。

- 缺少非同步計算功能。

- 緩衝區/紋理複製並清除。

- 計算著色器索引緩衝區寫入。

此外,Claybook額外訂製了UE4 RHI,使用GPU->CPU緩衝區回讀,UE4僅支援2d紋理回讀而不停頓,其它readback API會讓整個GPU陷入停頓,緩衝區可以有原始視圖和類型化視圖,寬原始寫入等於高效填充窄類型緩衝區。

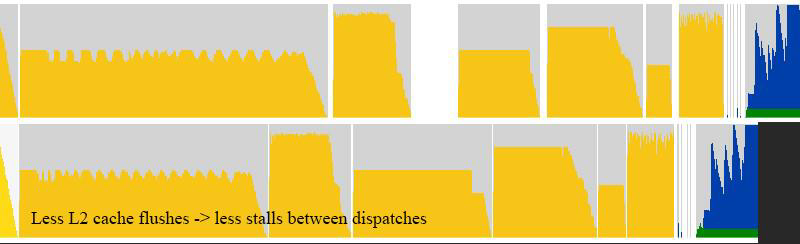

其它的UE4優化:允許間接分派/提取的重疊,允許清除和複製操作重疊,允許不同RT的繪製重疊,減少GPU快取刷新和停頓(下圖),優化的暫存緩衝區,快速清晰的改進。優化屏障和柵欄,優化紋理數組子資源屏障,更好的3d紋理GPU分塊模式,改進的部分2d/3d紋理更新,5倍更快的直方圖+眼睛適應著色器,4倍更快的離線CPU SDF生成器(烘焙)。

物理數據存儲在一個大的原始緩衝區中,寬載入4/Store4指令(16位元組),位壓縮:粒子位置:16位範數、粒子速度:fp16、粒子標誌(活動、碰撞等)的位欄位,基準工具://github.com/sebbbi/perftest。

Groupshared記憶體是一個巨大的性能利器,SDF生成、網格生成、物理,重複載入相同數據時使用。標量載入是AMD在性能上的一大勝利,用例:常量索引原始緩衝區載入,用例:基於SV_GroupID的原始緩衝區載入,存儲到SGPR的負載獲得更好的佔用率。

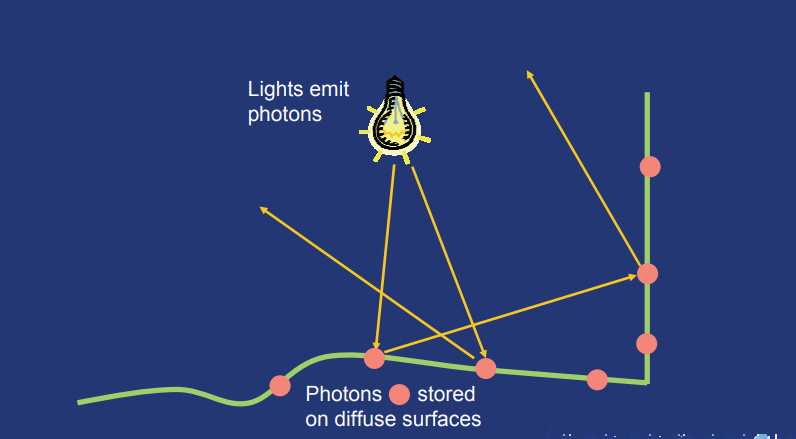

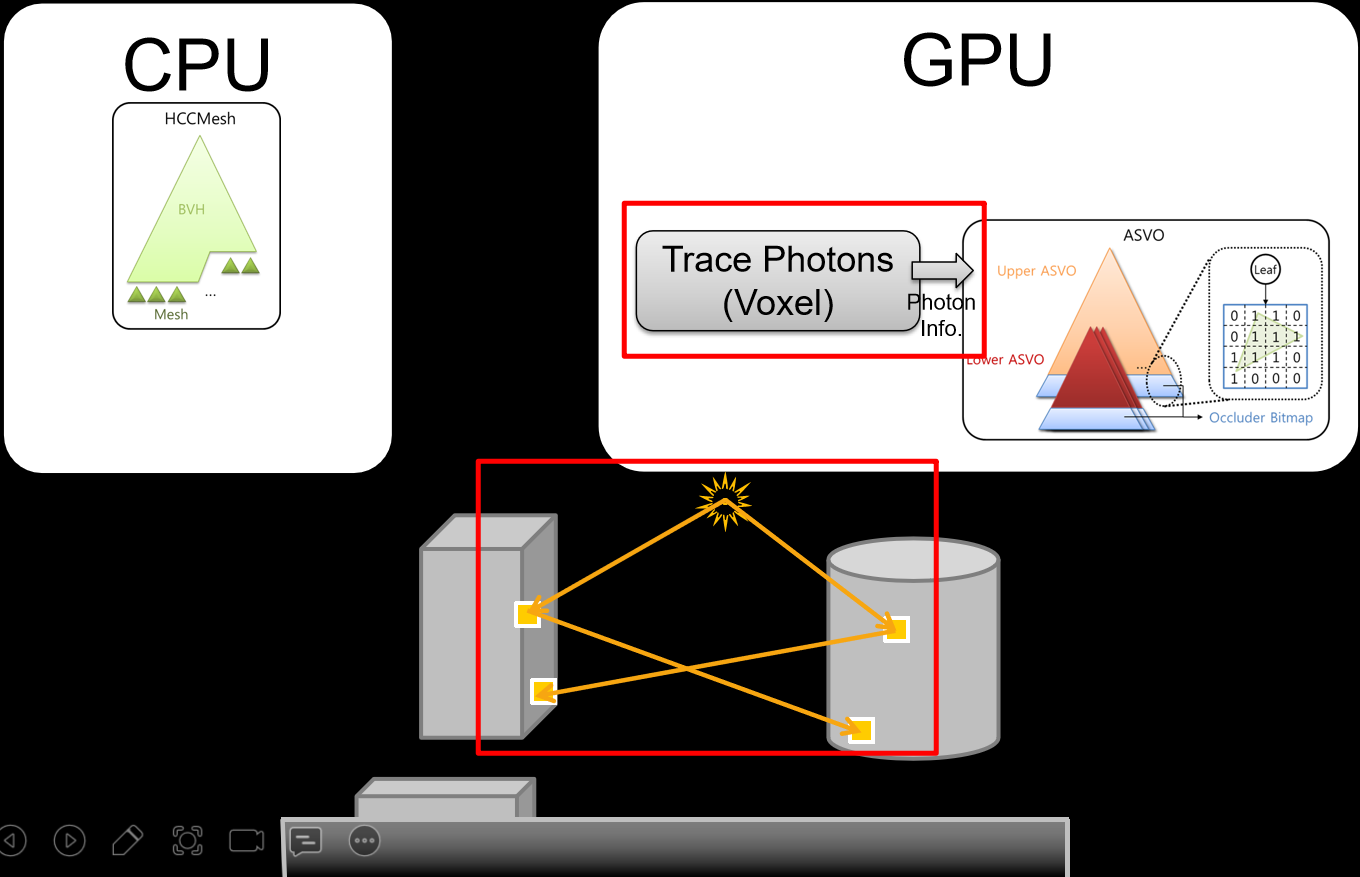

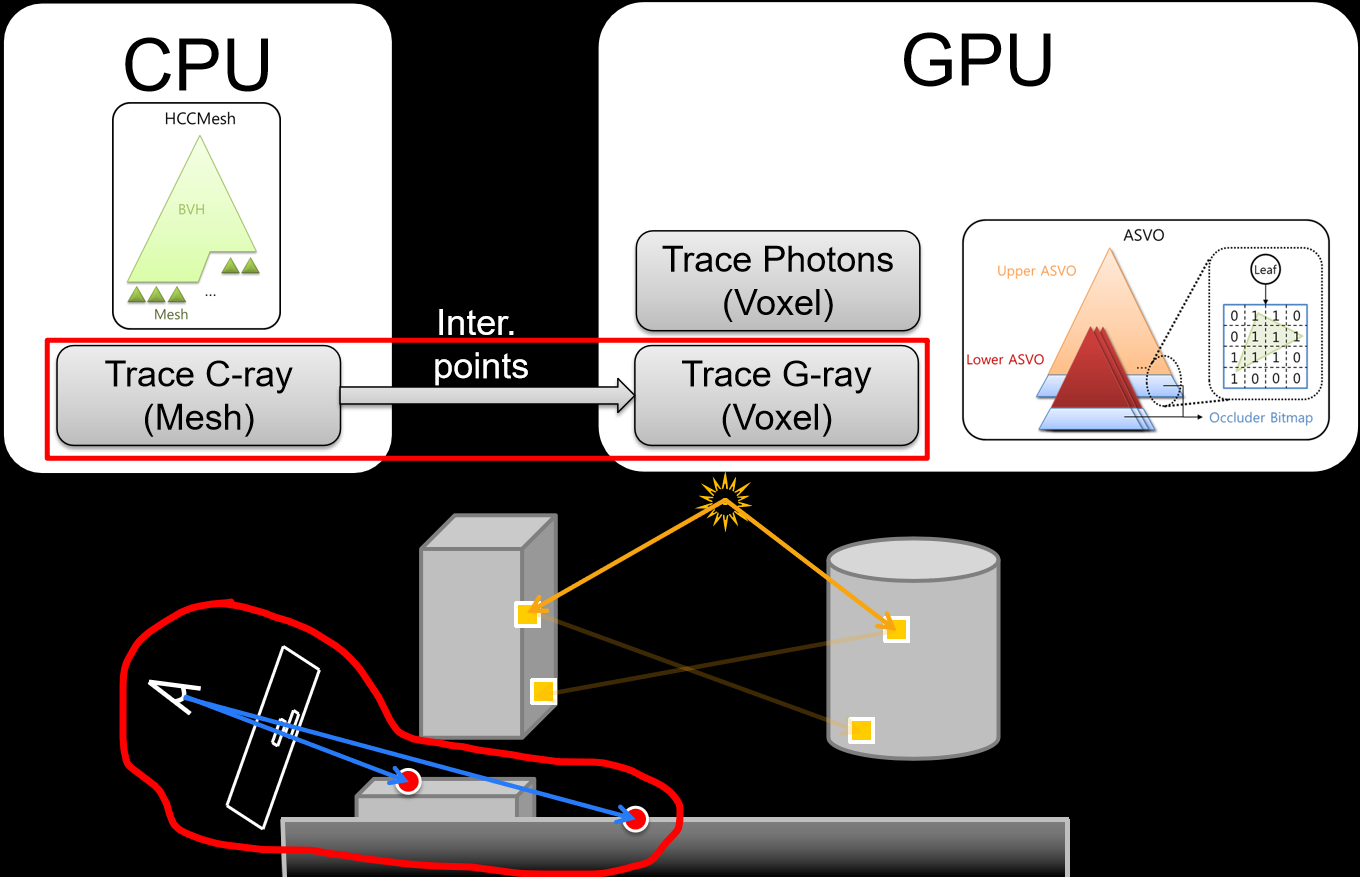

17.3.11.4 光子映射

光子映射綜合來看,分為兩個Pass:

-

Pass 1:光子追蹤。粗略的GI解決方案。

-

Pass 2:光線追蹤。影像渲染。

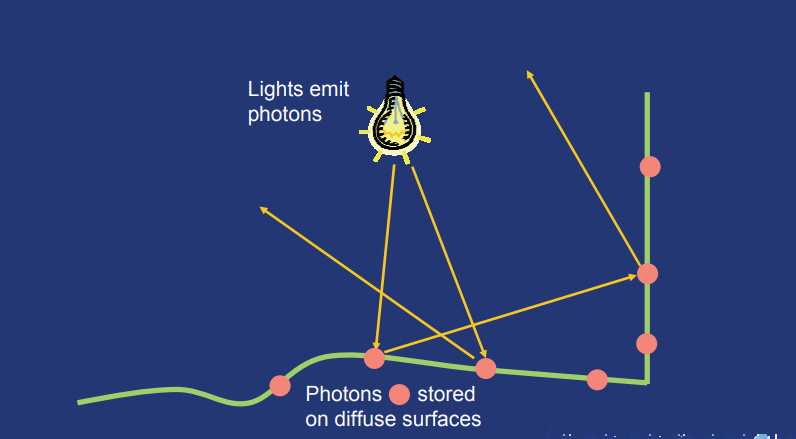

光子追蹤過程的目的是計算漫反射表面上的間接照明,是通過從光源發射光子、在場景中追蹤光子並將其存儲在漫反射表面來實現的。

從光源發射的光子應具有對應於光源發射功率分布的分布,以確保發射的光子攜帶相同的通量,即我們不會在低功率光子上浪費計算資源。

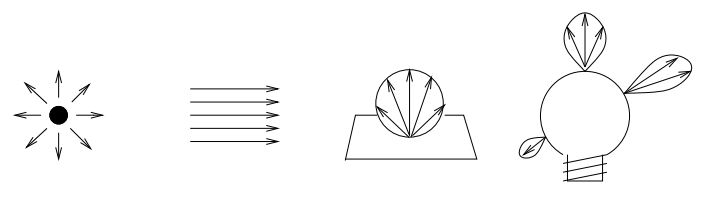

來自漫射點光源的光子從該點以均勻分布的隨機方向發射。來自平行光的光子都沿同一方向發射,但來自場景外部的原點。來自漫反射正方形光源的光子從正方形上的隨機位置發射,方向限於半球。發射方向從餘弦分布中選擇:在平行於正方形平面的方向上發射光子的概率為零,在垂直於正方形的方向上的發射概率最高。

通常,光源可以具有任何形狀和發射特性——發射光的強度隨原點和方向而變化。例如,燈泡具有非平凡的形狀,從其發出的光的強度隨位置和方向而變化。光子發射應遵循此變化,因此通常,發射概率根據光源表面上的位置和方向而變化。下圖顯示了這些不同類型光源的發射:

光源發光:點光源、定向光源、方形光源、普通光源。

光源的功率必須分布在從光源發射的光子之間。如果光源的功率為\(P_{light}\)且發射光子的數量為\(n_e\),則每個發射光子的功率是:

\]

下面給出了漫射點光源光子發射的簡單示例的偽程式碼:

為了進一步減少計算的間接照明(在渲染期間)的變化,希望儘可能均勻地發射光子。例如,可以使用分層或者低差異准隨機取樣。

在具有稀疏幾何體的場景中,許多發射的光子不會擊中任何對象,發射這些光子將浪費很大時間。為了優化發射,可以使用投影圖(Projection map)。投影圖只是從光源看到的幾何圖形的圖,由許多小單元格(cell)組成。如果在該方向上有幾何圖形,則單元格為「開」,如果沒有,則為「關」。例如,投影貼圖是點光源的場景的球形投影,是平行光的場景的平面投影。為了簡化投影,可以方便地圍繞每個對象或對象簇投影邊界球體。此舉也大大加快了投影圖的計算,因為不必檢查場景中的每個幾何元素。投影圖最重要的方面是,它給出了從光源發射光子所需方向的保守估計。如果估計不是保守的(例如,可以先用幾個光子對場景進行取樣),可能會丟失重要的效果,例如焦散。

使用投影圖發射光子非常簡單。可以在包含對象的單元格上循環,並向單元格所表示的方向發射隨機光子。然而,這種方法可能會導致稍微有偏差的結果,因為光子圖可能在訪問所有單元格之前「已滿」。另一種方法是生成隨機方向,並檢查對應於該方向的單元是否有任何對象(如果沒有,則應嘗試新的隨機方向)。這種方法通常效果良好,但在稀疏場景中可能代價高昂。對於稀疏場景,最好為具有對象的單元隨機生成光子。一種簡單的方法是選擇具有對象的隨機單元,然後為該單元的發射光子選擇隨機方向。在所有情況下,都必須根據投影圖中的活動單元格數量和發射的光子數量來縮放存儲光子的能量。因此需要修改光子能力的公式:

\]

投影圖的另一個重要優化是識別具有鏡面反射特性的對象(即可以生成焦散的對象)。如後所述,焦散是單獨生成的,由於鏡面反射對象通常稀疏分布,因此使用焦散投影圖非常有益。

場景中的光子路徑:(a)兩次漫反射後被吸收;(b)鏡面反射後轉為兩次漫反射;(c)兩次鏡面透射後被吸收。

光子發射後,將使用光子追蹤在場景中進行追蹤(也稱為「光線追蹤」、「反向光線追蹤」、「正向光線追蹤」和「反向路徑追蹤」)。光子追蹤的工作方式與光線追蹤完全相同,只是光子傳播通量,而光線收集輻射。這是一個重要的區別,因為光子與材質的相互作用可能不同於射線的相互作用。一個值得注意的例子是折射,其中根據相對摺射率改變輻射亮度的情況不會發生在光子上。

當光子擊中物體時,它可以被反射、透射或吸收——根據表面的材質參數概率而定。用於確定交互類型的技術稱為俄羅斯輪盤賭——擲骰子,決定光子是否應該存活並被允許執行另一個光子追蹤步驟。

光子僅存儲在它們撞擊漫反射表面(或更準確地說,非特殊表面)的位置。原因是,在鏡面反射表面上存儲光子不會提供任何有用的資訊:從鏡面反射方向具有匹配入射光子的概率為零,因此,如果我們想要渲染精確的鏡面反射,最好的方法是使用標準光線追蹤沿鏡面方向追蹤光線。對於所有其他光子-表面相互作用,數據存儲在全局數據結構(光子圖)中。注意,每個發射的光子可以沿其路徑存儲多次。此外,有關光子的資訊存儲在其被吸收的表面(如果該表面是漫反射的)。

對於每個光子-表面相互作用,存儲位置、入射光子功率和入射方向(實際還會為每個光子數據集保留了一個標記空間,該標記在光子圖中的排序和查找過程中使用)。

struct Photon

{

float x,y,z; // position

char p[4]; // power packed as 4 chars

char phi, theta; // compressed incident direction

short flag; // flag used in kdtree

};

再次考慮上圖中的簡單場景,(a)顯示了該場景的傳統光線追蹤影像(直接照明和鏡面反射和透射),(b)顯示了為該場景生成的光子圖中的光子,玻璃球下光子的高濃度是由玻璃球聚焦光子引起的。

數據存儲還可以擴展到參與介質,以及多重散射、各向異性散射和非均勻介質。

光子僅在光子追蹤過程中生成,在渲染過程中,光子圖是一種靜態數據結構,用於計算場景中許多點處的入射通量和反射輻射的估計。為此,需要在光子圖中定位最近的光子。這是一個非常頻繁的操作,因此需要在渲染過程之前優化光子圖,以便儘可能快地找到最近的光子。

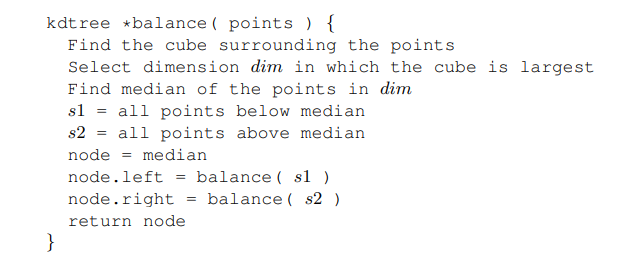

首先,我們需要選擇一個好的數據結構來表示光子圖。數據結構應緊湊,同時允許快速最近鄰搜索。它還應該能夠處理高度不均勻的分布——在焦散光子貼圖中非常常見。處理這些需求的自然候選者是平衡kd樹。用於平衡光子圖的偽程式碼:

光子映射方法的一個基本組成部分是計算任何給定方向上任何非鏡面反射表面點處的輻射估計的能力。光子輻射亮度估算可由經典的BRDF推導而成:

L_{r}(x, \vec{\omega})=\int_{\Omega_{x}} f_{r}\left(x, \vec{\omega}^{\prime}, \vec{\omega}\right) L_{i}\left(x, \vec{\omega}^{\prime}\right)\left|\vec{n}_{x} \cdot \vec{\omega}^{\prime}\right| d \omega_{i}^{\prime}, \\

L_{i}\left(x, \vec{\omega}^{\prime}\right)=\cfrac{d^{2} \Phi_{i}\left(x, \vec{\omega}^{\prime}\right)}{\cos \theta_{i} d \omega_{i}^{\prime} d A_{i}}, \\

L_{r}(x, \vec{\omega})=\int_{\Omega_{x}} f_{r}\left(x, \vec{\omega}^{\prime}, \vec{\omega}\right) \cfrac{d^{2} \Phi_{i}\left(x, \vec{\omega}^{\prime}\right)}{\cos \theta_{i} d \omega_{i}^{\prime} d A_{i}}\left|\vec{n}_{x} \cdot \vec{\omega}^{\prime}\right| d \omega_{i}^{\prime} \\

=\int_{\Omega_{x}} f_{r}\left(x, \vec{\omega}^{\prime}, \vec{\omega}\right) \cfrac{d^{2} \Phi_{i}\left(x, \vec{\omega}^{\prime}\right)}{d A_{i}} . \\

L_{r}(x, \vec{\omega}) \approx \sum_{p=1}^{n} f_{r}\left(x, \vec{\omega}_{p}, \vec{\omega}\right) \cfrac{\Delta \Phi_{p}\left(x, \vec{\omega}_{p}\right)}{\Delta A} .

\end{array}

\]

這個過程可以想像為圍繞\(x\)展開一個球體,直到它包含\(n\)個光子(見下圖),然後使用這\(n\)個光子來估計輻射亮度。

使用光子圖中最近的光子估計輻射亮度。

上圖使用了球體,通過假設曲面在\(x\)周圍局部平坦,我們可以通過將球體投影到曲面上並使用所得圓的面積來計算該面積(即上圖中的陰影區域),等於:

\]

其中\(r\)是球體的半徑,即\(x\)和每個光子之間的最大距離。使用光子圖計算表面處反射輻射的公式變成了以下等式:

\]

該估計基於許多假設,精度取決於光子圖和公式中使用的光子數。由於球體用於定位光子,因此很容易在估計中包括錯誤的光子,特別是在物體的角和銳邊。邊和角也會導致面積估計錯誤。發生這些誤差的區域的大小在很大程度上取決於光子圖和估計中的光子數量。隨著估算和光子圖中使用更多光子,公式變得更精確。如果我們忽略由於位置、方向和通量表示的有限精度而導致的誤差,那麼我們可以達到極限並將光子數量增加到無窮大。將給出了以下有趣的結果,其中\(N\)是光子圖中的光子數:

\]

該公式適用於位於表面局部平坦部分上的所有點\(x\),其中BRDF不包含狄拉克\(δ\)函數(不包括完美鏡面反射)。上面等式中的原理是,不僅將使用無限量的光子來表示模型內的通量,而且還將使用無限數量的光子來估計輻射,並且估計中的光子將位於無窮小的球體內。不同的無限度由項\(N_α\)控制,其中\(α∈]0,1[\),確保了估計中的光子數量將無限小於光子圖中的光子數。

上述公式意味著我們可以通過使用足夠的光子獲得任意好的輻射估計!在基於有限元的方法中,獲得任意精度更為複雜,因為誤差取決於網格的解析度、輻射的方向表示的解析度和光模擬的精度。

上圖顯示了定位最近的光子如何類似於圍繞x展開球體並使用該球體內的光子。在此過程中,可以使用球體以外的其他體積。人們可以使用立方體,圓柱體或圓盤。這可能有助於獲得定位最近光子更快的演算法,或者在選擇光子時可能更準確。如果使用不同的體積,則∆等式中的A應替換為體積與在x處接觸表面的切面之間的交點面積。

球體具有明顯的優點,即投影面積和距離計算非常簡單,因此計算效率高。通過將球體沿x處表面法線方向壓縮(如下圖所示),將球體修改為圓盤(橢球體),可以獲得更精確的體積。使用圓盤的優點是,在邊緣和拐角處的估計中使用更少的「假光子」。例如,在房間的邊緣效果非常好,因為可以防止牆壁上的光子泄漏到地板上。然而,仍然存在的一個問題是,面積估計可能是錯誤的,或者光子可能泄漏到它們不屬於的區域。這個問題主要通過使用過濾來解決。

使用球體(左)和圓盤(右)來定位光子。

如果光子圖中的光子數太低,則輻射亮度估計在邊緣處變得模糊。當光子圖用於估計分布射線追蹤器的間接照明時,這種偽影可能令人滿意,但在輻射估計表示焦散的情況下,這種偽影是不需要的。焦散通常具有銳利的邊緣,在不需要太多光子的情況下保留這些邊緣會很好。

為了減少邊緣的模糊量,對輻射估計進行濾波。濾波背後的思想是增加接近感興趣點x的光子的權重。由於我們使用球體來定位光子,因此自然會假設濾波器應該是三維的。然而,光子存儲在二維表面上。面積估計也基於光子位於表面的假設。因此,我們需要在光子定義的區域上歸一化的2d濾波器(類似於影像過濾器)。

過濾焦散可以使用兩個徑向對稱過濾器:錐形過濾器、高斯過濾器及專用微分過濾器(differential filter)。前面兩個過濾器是老調重彈了,下面重點說說微分過濾器。

基於微分檢查的過濾器的思想是在估計過程中檢測邊緣附近的區域,並在這些區域中使用更少的光子。這樣,我們可能會在估計中得到一些雜訊,但通常比模糊邊緣更好。基於以下觀察修改輻射估計:在邊緣附近向估計添加光子時,估計的變化將是單調的。也就是說,如果我們剛好在焦散線之外,並且我們開始將光子添加到估計中(通過增加包含光子的以x為中心的球體的大小),那麼可以觀察到,隨著我們添加更多光子,估計值正在增加;反之亦然,當我們在焦散中時。基於此觀察,可以將微分檢查添加到估計中-如果我們觀察到隨著更多光子的添加,估計值不斷增加或減少,則停止添加光子並使用可用的估計值。

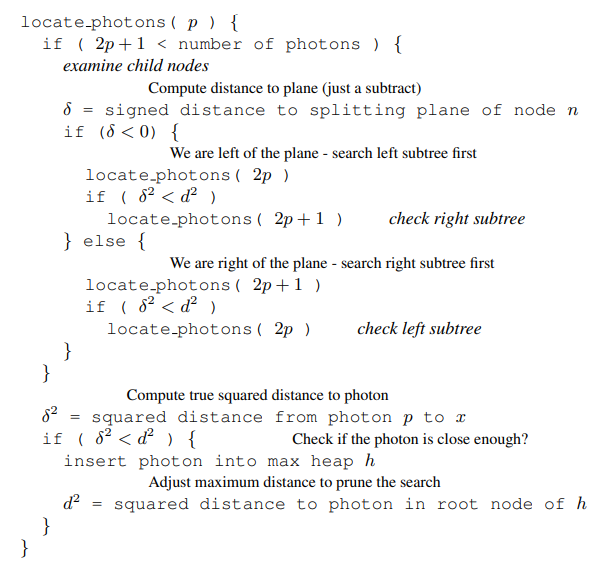

定位最近的光子需要一種高效的演算法,下面是其中一種的偽程式碼:

對於該搜索演算法,需要提供初始最大搜索半徑。選擇好的半徑可以很好地減少搜索,減少測試的光子數量。另一方面,太小的最大半徑將在光子圖估計中引入噪點。可以基於誤差度量或場景的大小來選擇半徑,誤差度量例如可以考慮所存儲光子的平均能量,並根據該平均能量計算最大半徑,假設輻射估計中存在一些允許誤差。

可以添加一些額外的優化,例如,將最大堆的構建延遲到找到所需光子數的時間,在所請求的光子數量較大時特別有用。也可以初始最大搜索半徑被設置為非常低的值,如果該值太低,則使用更高的最大半徑執行另一次搜索。搜索常式的另一個更改是使用前面描述的磁碟檢查,有助於避免不正確的顏色溢出,並且在不使用收集步驟且光子直接可視化的情況下特別有用。

接下來就是渲染部分了。

使用分布光線追蹤來渲染最終影像,其中通過對多個樣本估計求平均來計算像素輻射亮度,每個樣本包括從眼睛通過一個像素追蹤光線進入場景。可將照光拆分為直接光、鏡面和光澤反射、焦散、多重漫反射以及參與介質等部分。它們和傳統的PBR比較類似,本文就忽略研討之。

光子映射的效果圖。

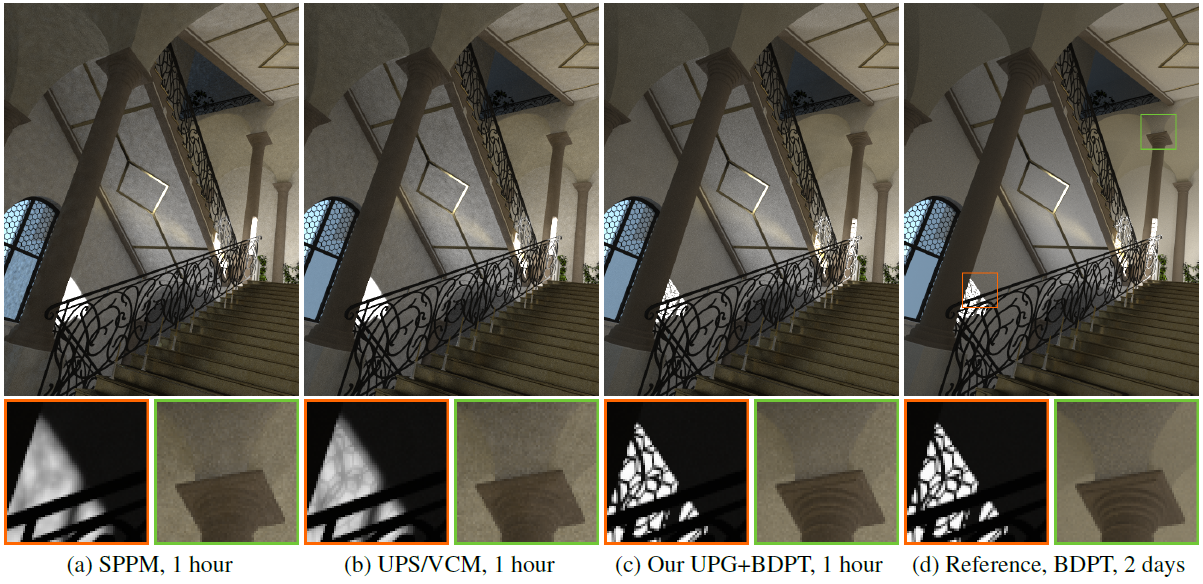

Unbiased Photon Gathering for Light Transport Simulation提出了一種新的光子收集方法,以有效地實現光子映射的無偏倚渲染。不像經典光子映射那樣將收集的光子收集到估計的密度中,而是單獨處理每個光子,並將相應的光子路徑與生成聚集點的眼睛子路徑連接,從而創建無偏路徑樣本。通過以嚴格和無偏的方式評估所有相關項來計算此類路徑樣本的蒙特卡洛估計,從而形成一種獨立的無偏取樣技術。該文進一步開發了一組多重要性取樣(MIS)權重,允許文中方法與雙向路徑追蹤(BDPT)進行最佳組合,從而產生一種無偏渲染演算法,該演算法可以有效地處理各種光路,並與以前的演算法相比較。實驗證明了該方法的有效性和魯棒性。

隨機漸進光子映射(SPPM)、統一路徑取樣/頂點連接和合併(UPS/VCM)和該文的無偏光子採集與雙向路徑追蹤(UPG+BDPT)在渲染1小時後的比較。SPPM利用偏置光子映射來產生低方差結果,代價是過度模糊銳利特徵。UPS/VCM從BDPT中獲得額外的好處,但頂點合併部分仍有偏差。文中的方法既無偏又穩健,產生了與參考最相似的結果。請注意,左插圖設置為曝光1=64,以使HDR陰影細節可見。

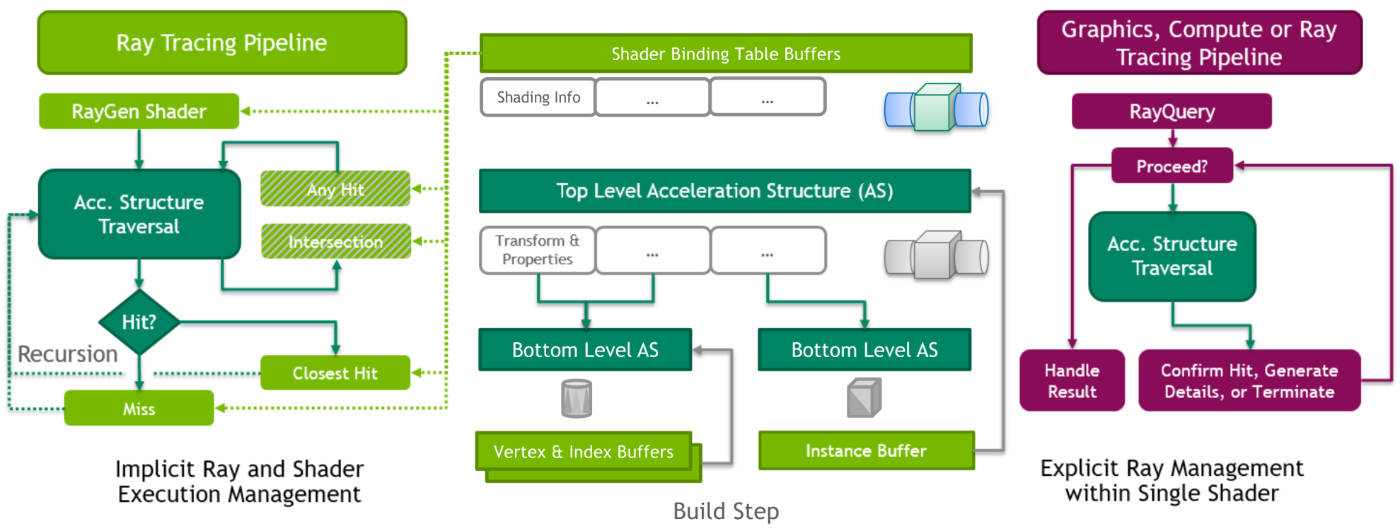

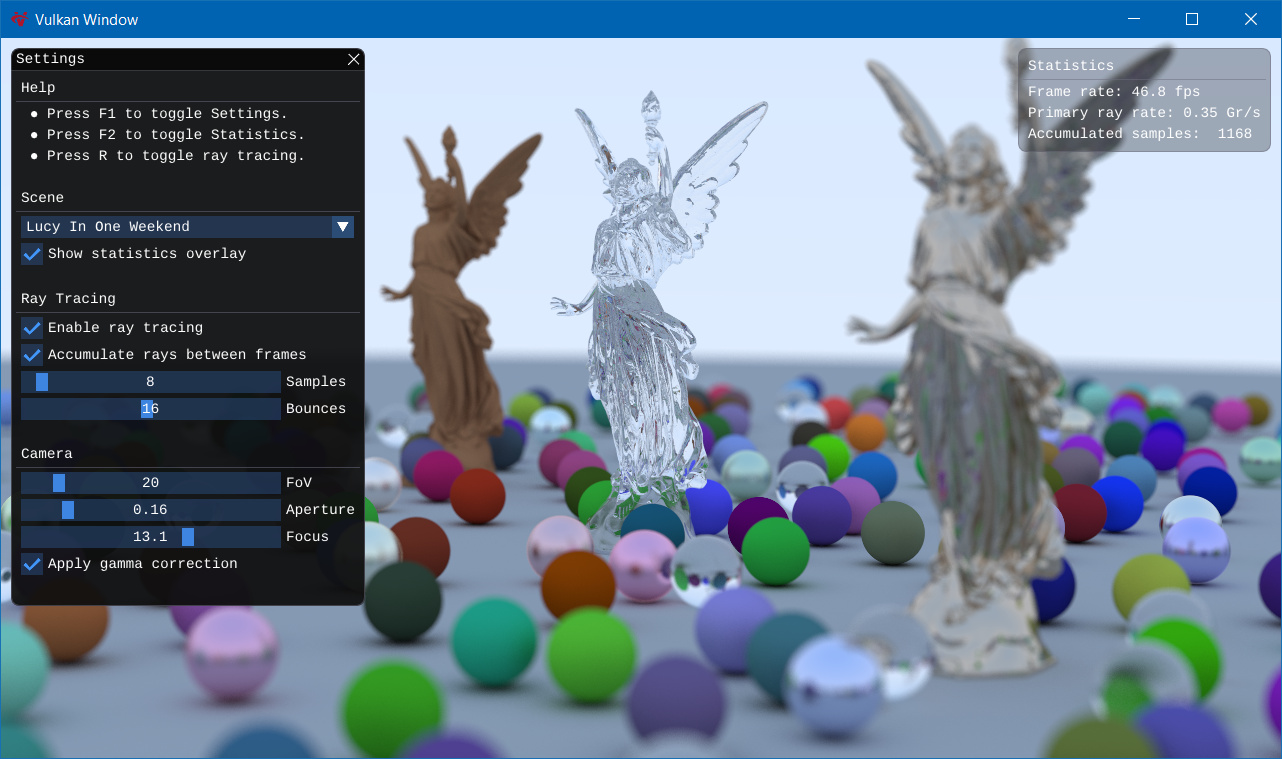

17.3.11.5 綜合實現

當前階段,光柵化仍然比光線追蹤「快」,而光線追蹤可以比光柵化更好地處理某些效果,如反射、軟陰影、全局照明等。目前通常採用混合射線追蹤,例如僅反射使用光線追蹤而光柵化其他所有內容(包括主光線)。主流的GPU已基本支援光柵化、計算、光線追蹤甚至深度學習等管線混合計算:

確定遊戲開發人員在集成到現有遊戲引擎基礎設施時必須解決的問題,因為遊戲引擎是為GPU設計和優化的,包含藝術資源和材質著色器。

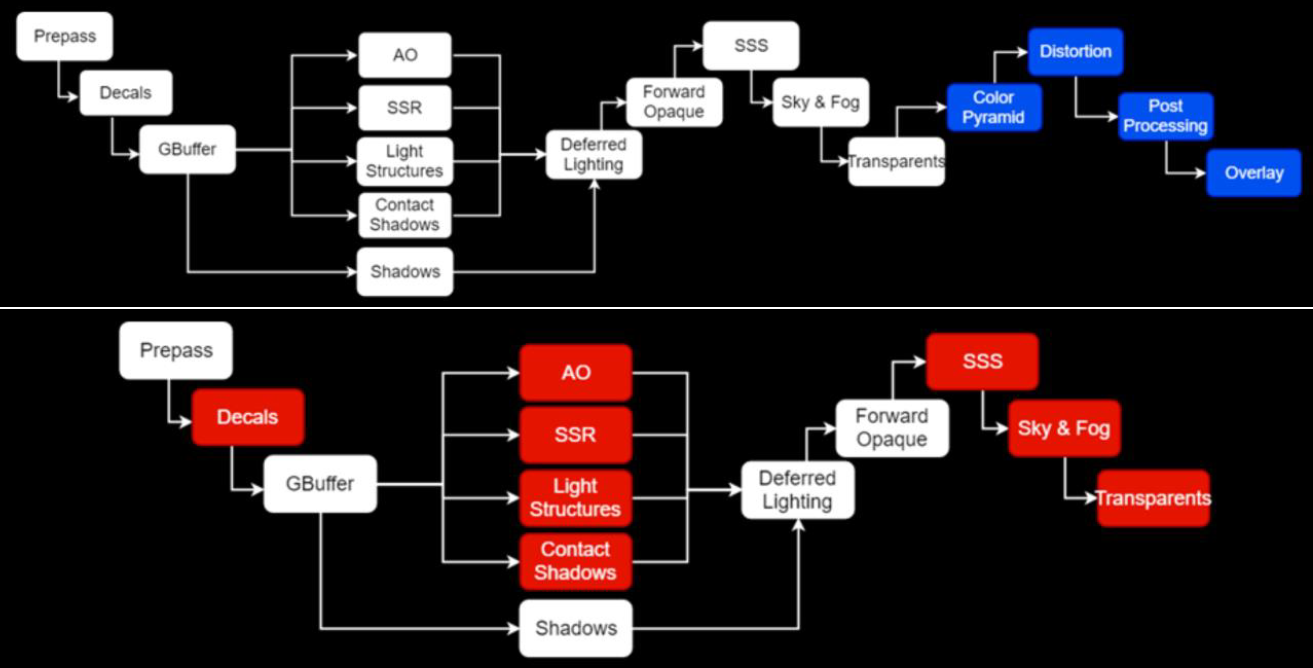

傳統的渲染管線如下圖上所示,其中藍色部分和間接光無關,可以忽略。下圖下的紅色是和間接光相關的階段。

對於下圖的黃色步驟,解決方案是多次反彈或近似。接下來要看的是透明度,它似乎是光線追蹤的一個很好的候選者,對嗎?

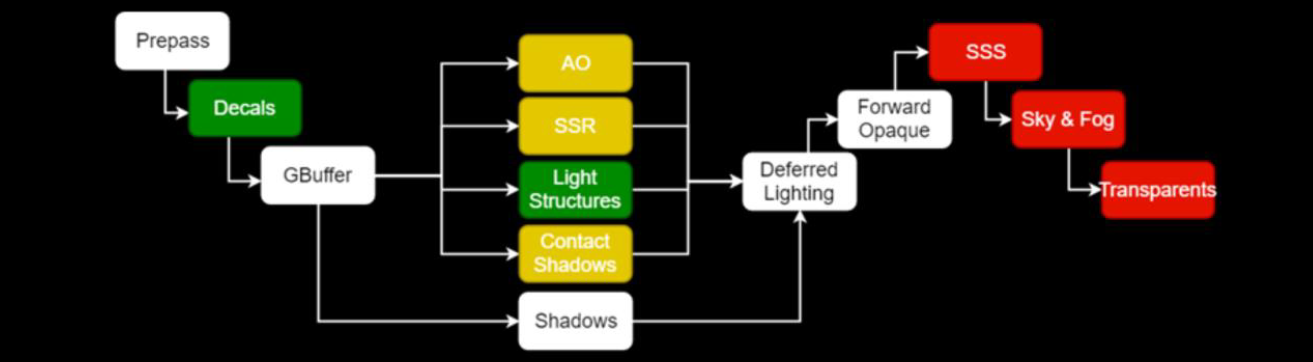

事實證明,螢幕空間照明問題同樣適用於透明材質(多維性、性能、過濾)。當前已經在探索SSS的體積解決方案,但沒有正確的SSS體積解決方案。混合渲染管線的流程如下:

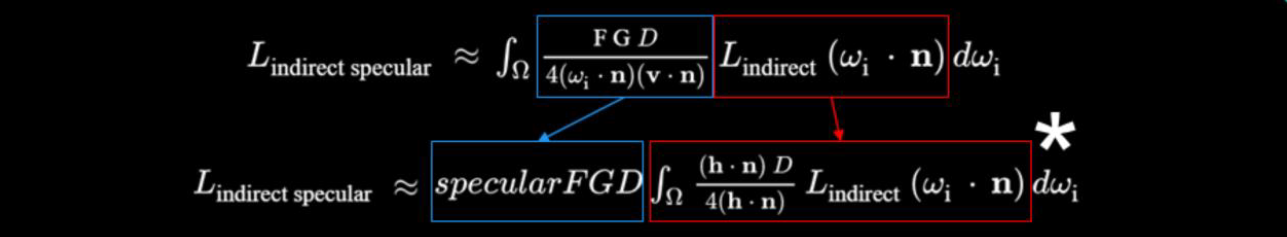

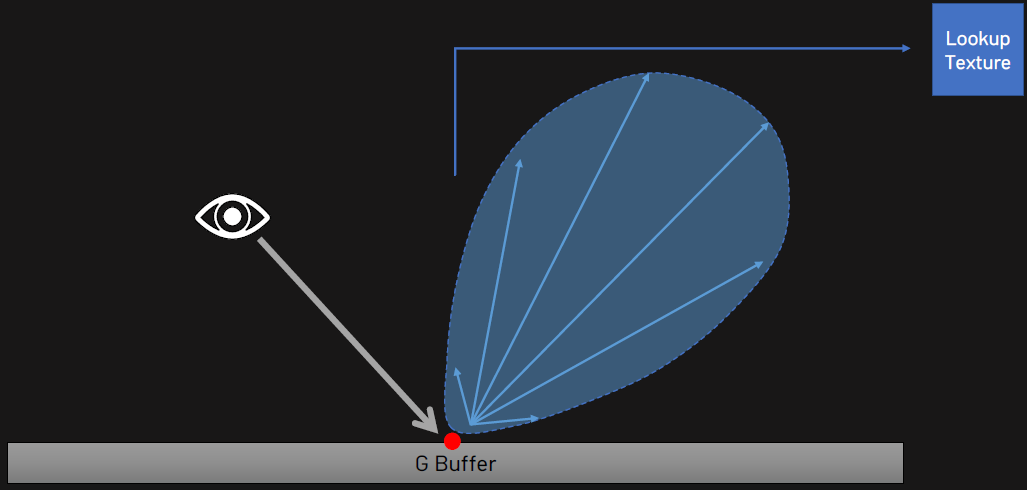

對於非直接光照,分裂和近似Karis 2013有助於減少方差,藍色是預先計算的,使用光柵化或光線追蹤進行評估。

在RTX的渲染流程如下:

隨機化的區域光渲染流程如下:

Battlefield V的光線追蹤包含了GPU光線追蹤管線、DXR的引擎集成、GPU性能等。

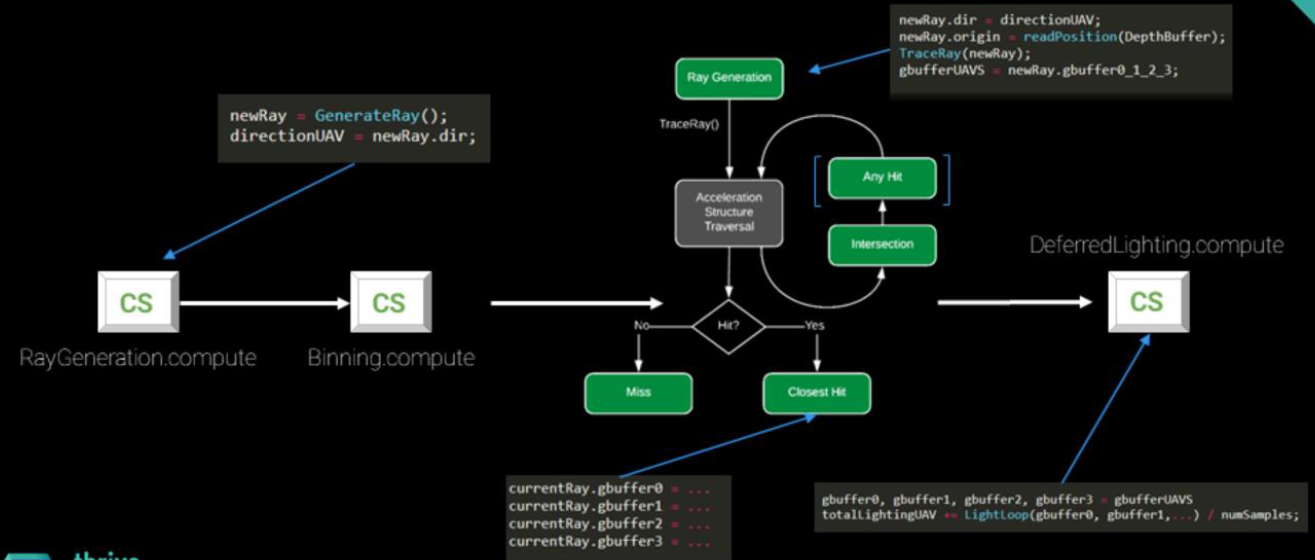

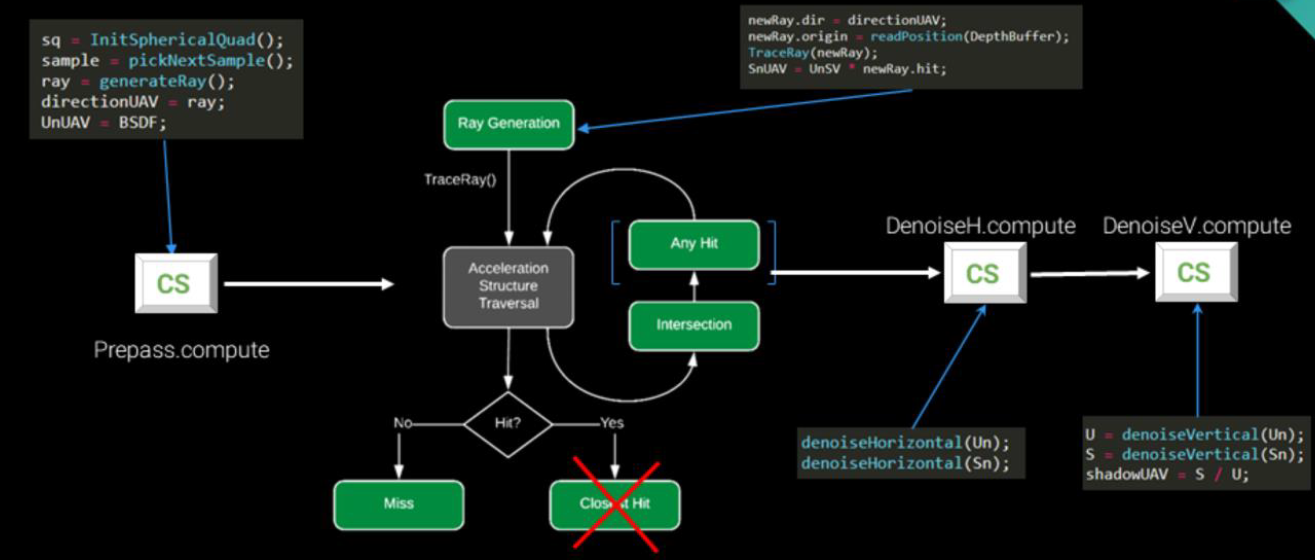

簡單光線追蹤管線:

生成管線階段,讀取GBuffer的紋理,使用隨機光柵化來生成光線:

float4 light(MaterialData surfaceInfo , float3 rayDir)

{

foreach (light : pointLights)

radiance += calcPoint(surfaceInfo, rayDir, light);

foreach (light : spotLights)

radiance += calcSpot(surfaceInfo, rayDir, light);

foreach (light : reflectionVolumes)

radiance += calcReflVol(surfaceInfo, rayDir, light);

(...)

}

然而這種簡單的光線追蹤管線渲染出來的畫質存在噪點、低效、光線貢獻較少等問題:

可以改進管線,在生成射線時加入可變速率追蹤:

可變速率追蹤的過程如下:

可變速率追蹤使得水上、掠射角有更多光線。但依然存在問題:

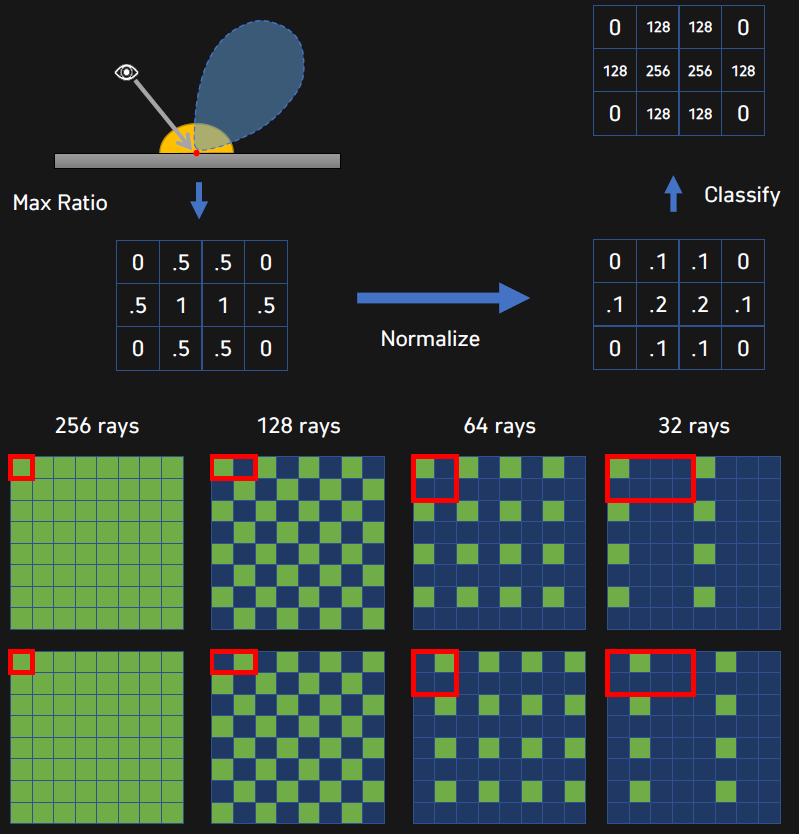

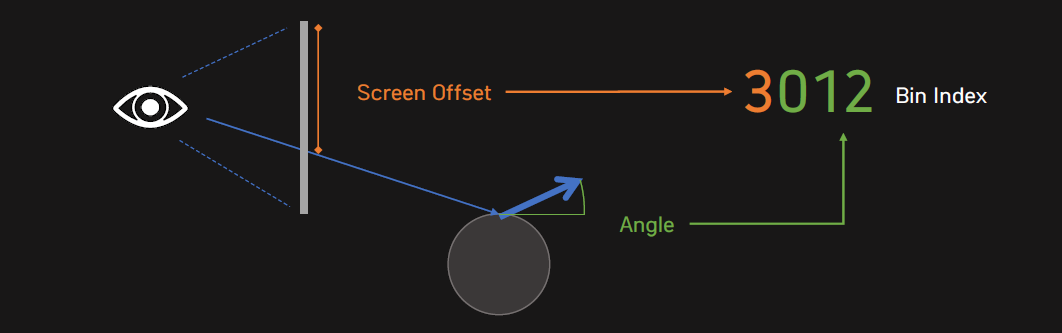

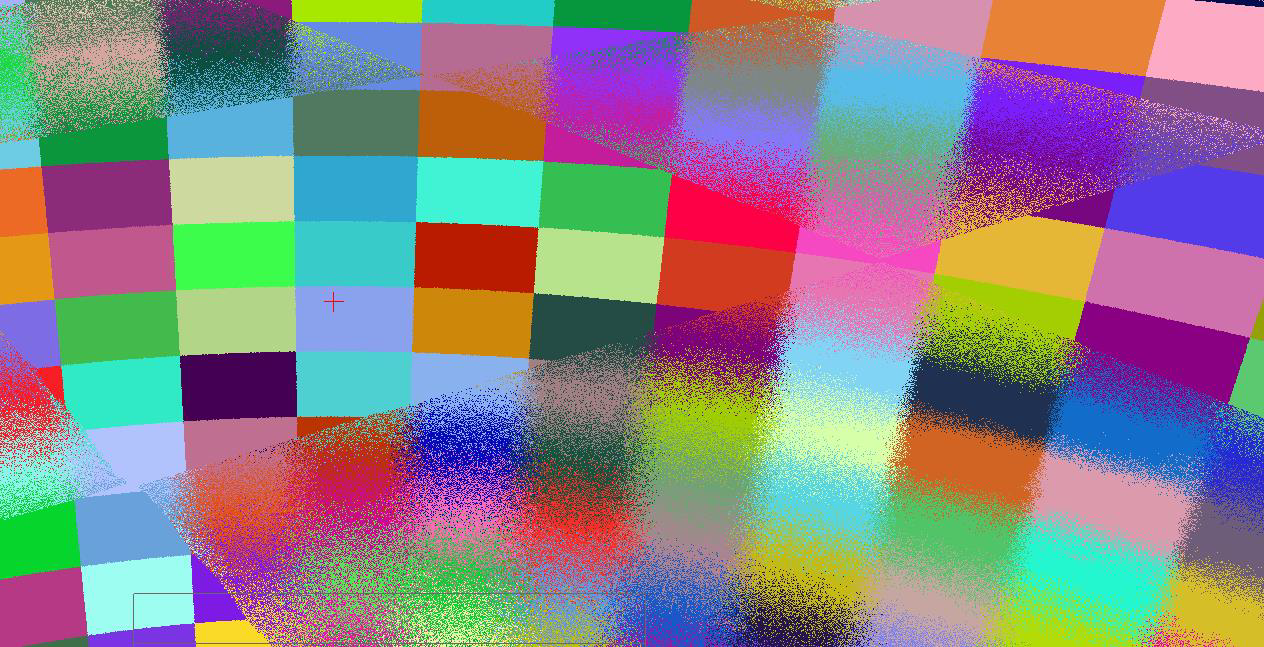

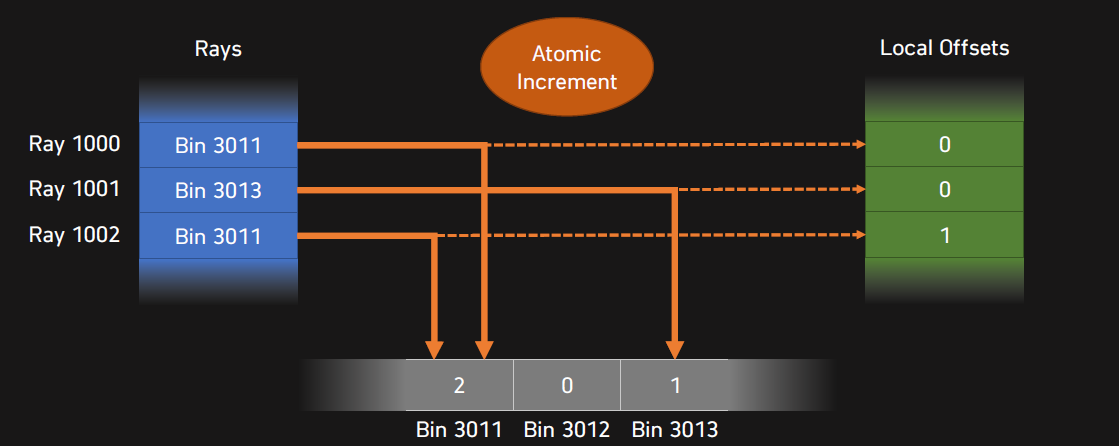

可以加入Ray Binning(光線箱化),將螢幕偏移和角度作為bin的索引。

依次可以加入SSR混合(SSR Hybridization)、碎片整理(Defrag)、逐單元格光源列表光照、降噪(BRDF降噪、時間降噪)等優化。

SSR Hybridization的過程和結果。

逐單元格光源列表光照。

BRDF降噪過程。

最終形成的新管線和時間消耗如下:

渲染效果:

DXR基礎:

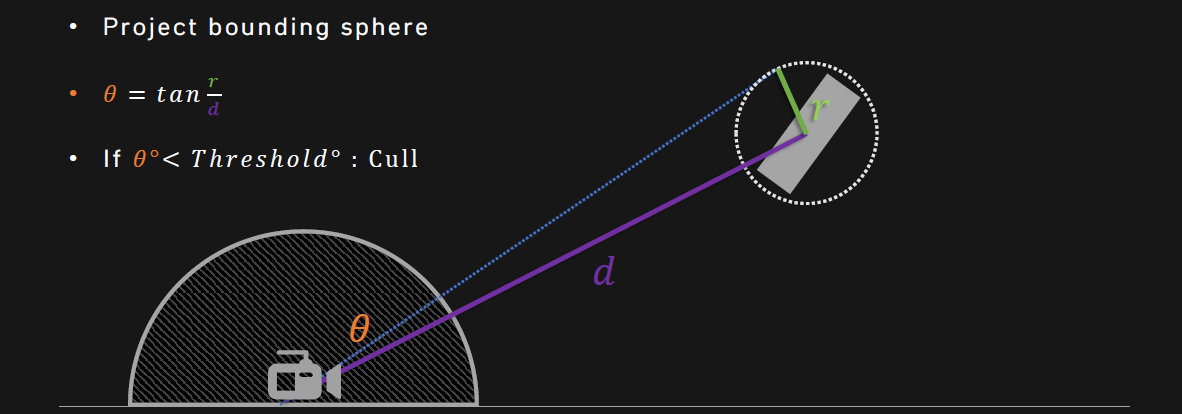

DXR的性能優化包含減少實例數、使用剔除啟發法、接受(一些)小瑕疵。剔除啟發法假設遠處的物體並不重要,除了橋樑、建築等大型物體物,需要一些測量。投影球體包圍盒,如果θθ小於某個閾值,則剔除:

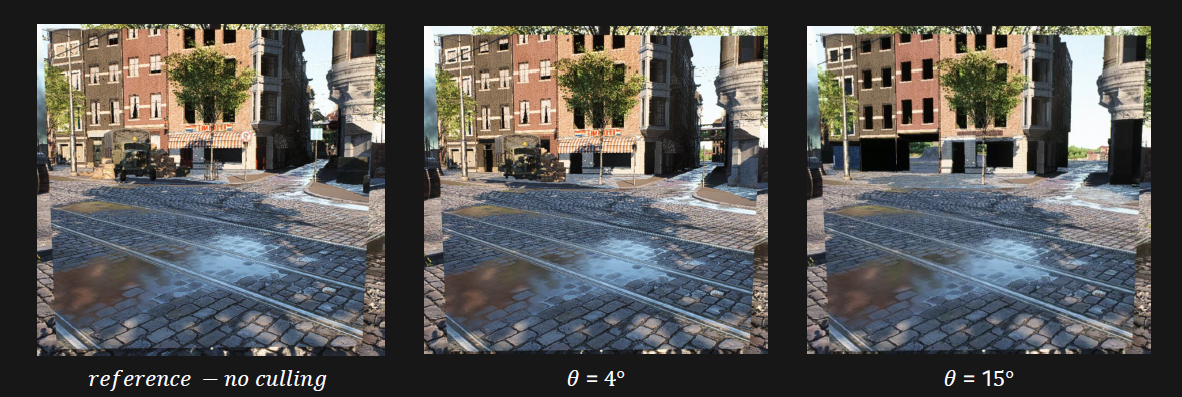

不同閾值的效果:

剔除結果是:使用4度剔除,每幀5000->400 BLAS、20000->2800個TLAS實例的重建,TLAS+BLAS構建(GPU)從64毫秒降到14.5毫秒,但引入了偶爾跳變及物體丟失等瑕疵。

BLAS更新依舊開銷大,可以採用以下方法優化:

- 錯開完整和增量BLAS重建。在完全重建之前N幀增量。

- 使用D3D12_RAYTRACING_ACCELERATION_STRUCTURE_BUILD_FLAG_PREFER_FAST_BUILD。

- 避免重複重建。檢查CS輸入(骨骼矩陣),400 -> 50,將BLAS更新與GFX重疊,如Gbuffer、陰影圖。

TLAS+BLASGPU構建耗時從14.5毫秒降低到1.15毫秒,RayGen(GPU)從0.71毫秒降低0.81毫秒(使用交錯重建+標誌)。

不透明物體應該總是使用ClosestHit著色器,僅對Alpha tested物體使用Any Hit著色器,對蒙皮、破壞使用計算著色器。

射線有效載荷(RAY PAYLOAD)在ray交點出返回,與Gbuffer RTV的格式相同,包含材質數據、法線、基礎色、平滑度等。

struct GbufferPayloadPacked

{

uint data0; // R10G10B10A2_UNORM

uint data1; // R8G8B8A8_SRGB

uint data2; // R8G8B8A8_UNORM

uint data3; // R11G11B10_FLOAT

float hitT; // Ray length

};

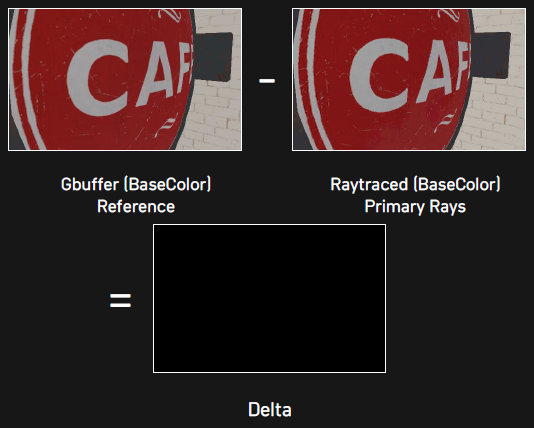

還可以驗證正確性,即光柵化輸出,向場景中發射主要光線,將有效載荷與Gbuffer進行比較,如果是非零輸出,則有bug!需要修正錯誤。

Embree是Intel開發的光線追蹤開源庫,其核心特點是:

- 主要針對專業渲染應用程式。

- 高度優化的光線追蹤內核(1.5x 6x加速)。

- 提供豐富的功能和靈活性。

- 支援最新的CPU和ISA(如英特爾®AVX 512)。

- Windows、macOS10.x和Linux支援。

- 易於集成到應用程式中的API。

- Apache 2.0許可下的開源。

它的技術上的特點是:

- 使用最新的光線追蹤演算法。

- 高品質的BVH構建,使用英特爾®TBB進行了良好的並行化。

- 寬BVH,單射線遍歷,混合射線遍歷…

- 硬體方面的優化實現。

- 儘可能矢量化,以利用SIMD和其他特殊指令。

- 減少最內部循環中的指令依賴鏈。

- 為常見情況實施快速路徑。

- 針對快取使用、記憶體訪問模式等優化數據結構…

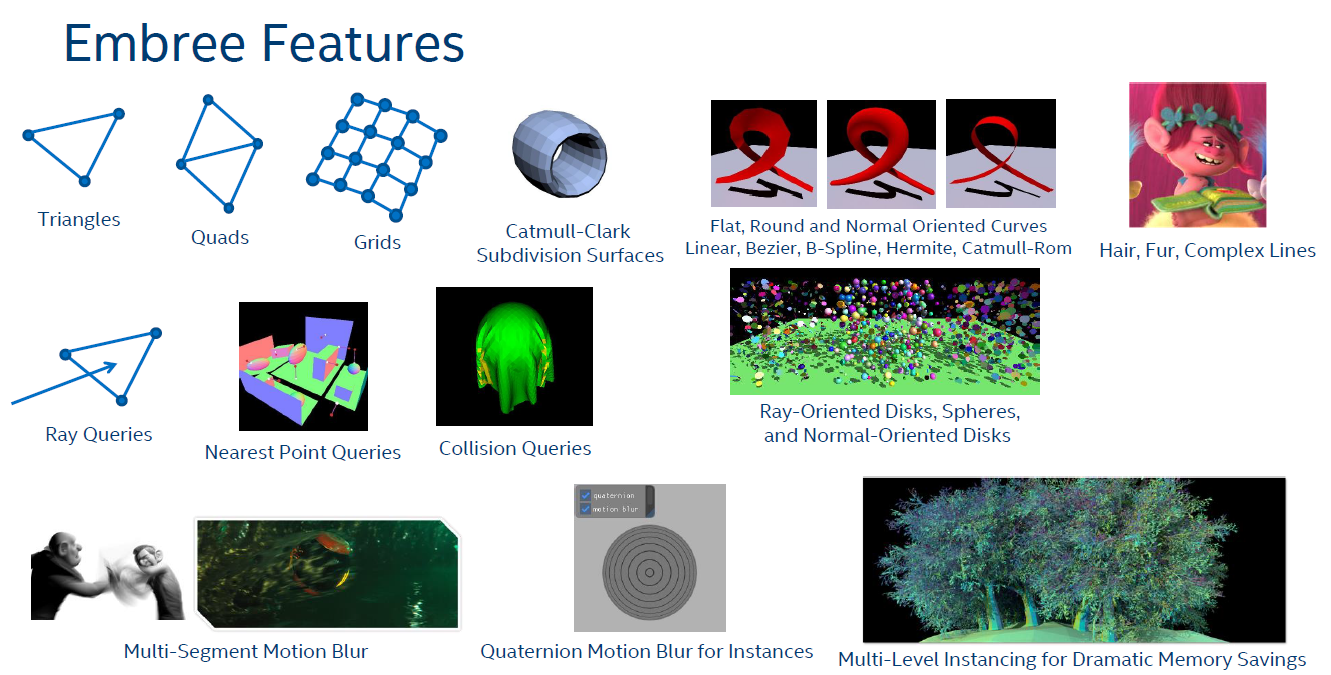

Embree支援的特性如下所示:

其系統概覽如下:

它已成功在World Of Tank等遊戲中應用。

利用GPU硬體加速的光線追蹤步驟和圖例如下:

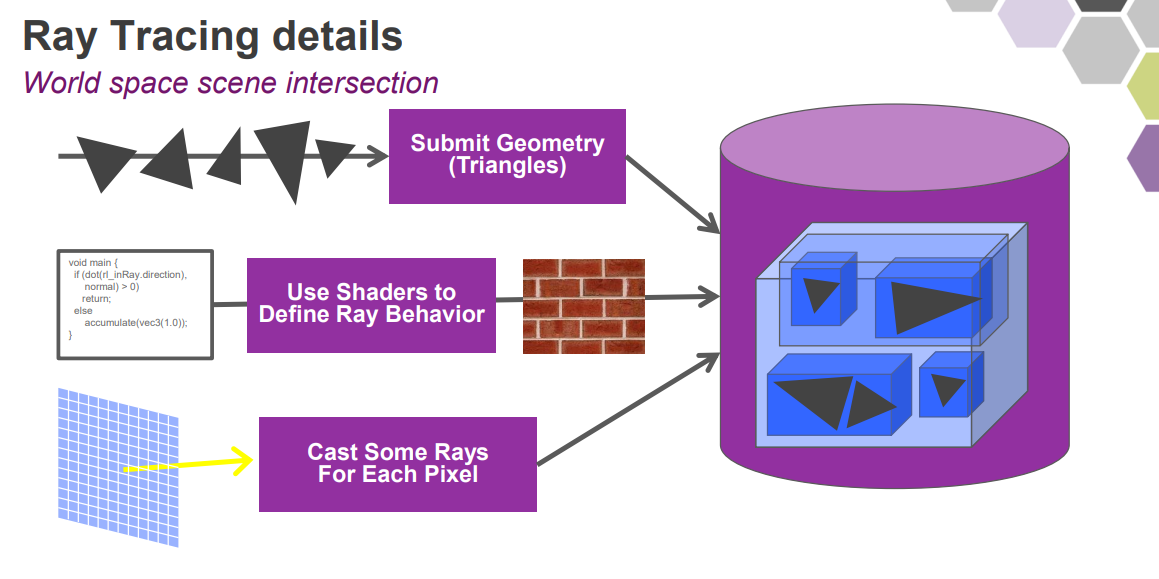

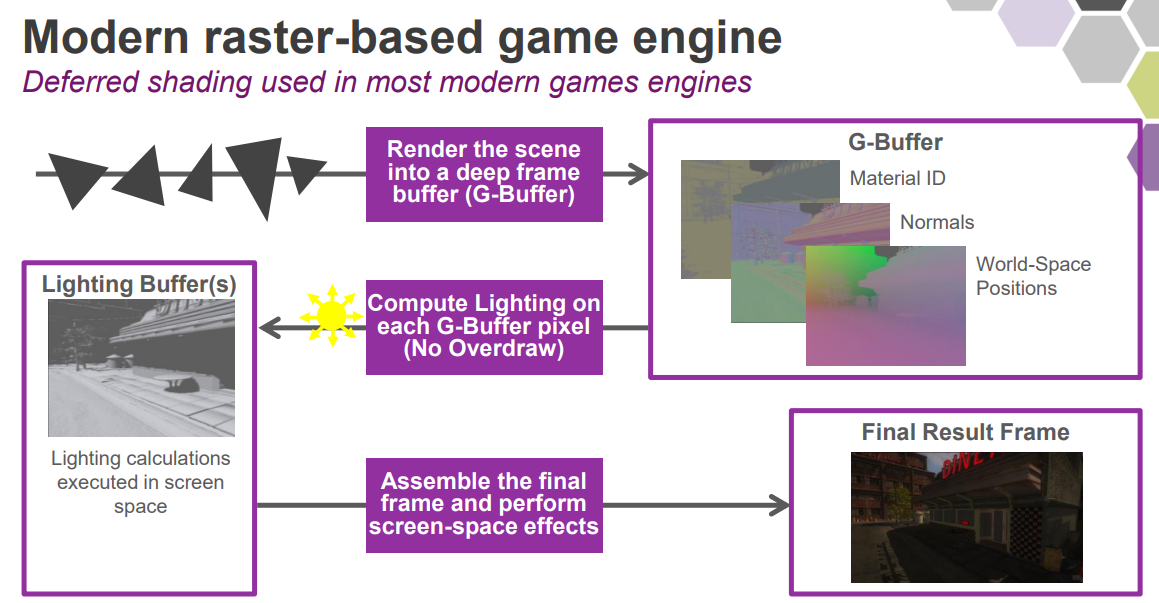

基於現代光柵化遊戲引擎的光線追蹤實現流程如下:

結合GBuffer資訊之後,由此產生了混合渲染管線:

下面是光柵化和光線追蹤的效果對比圖:

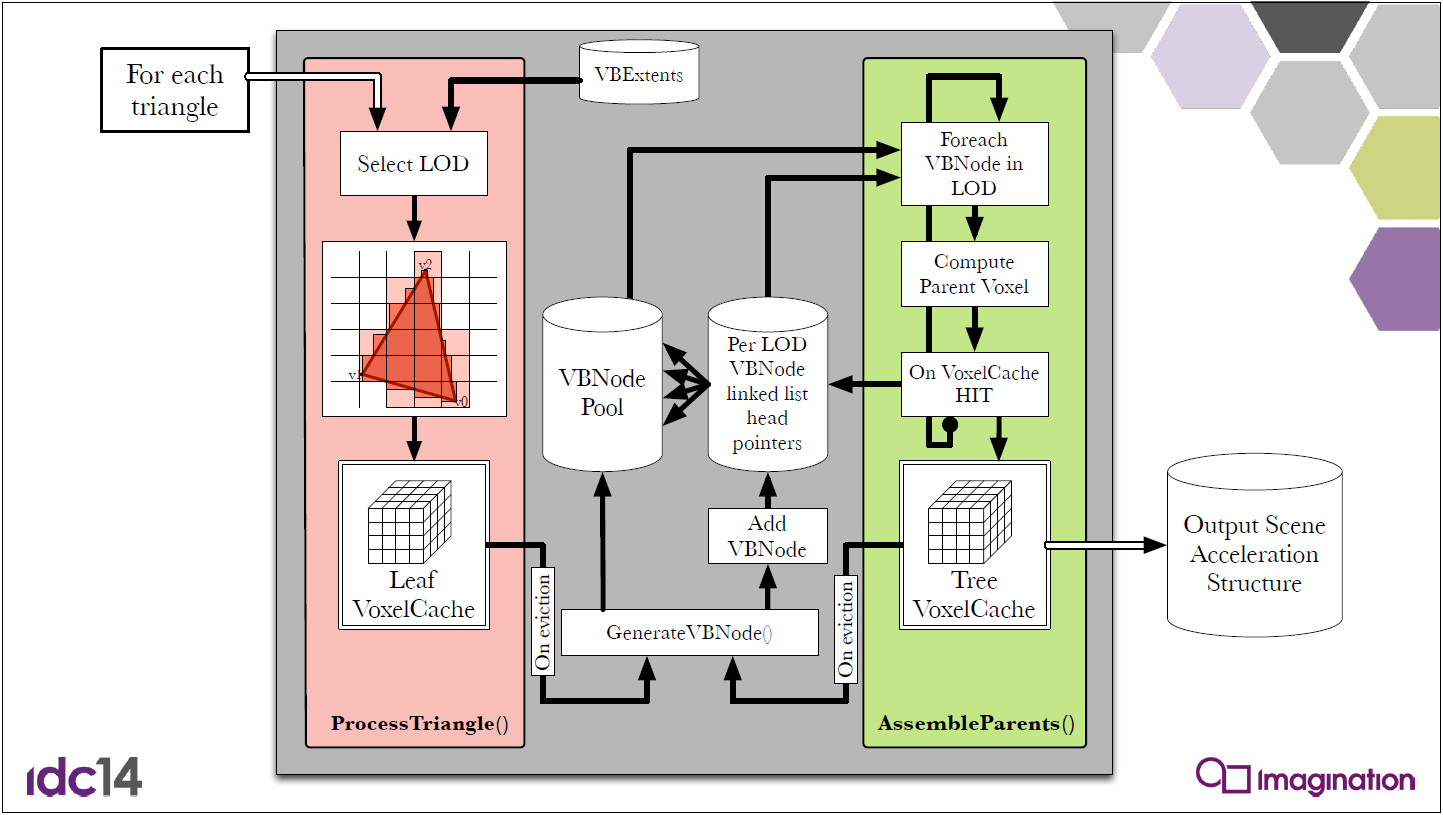

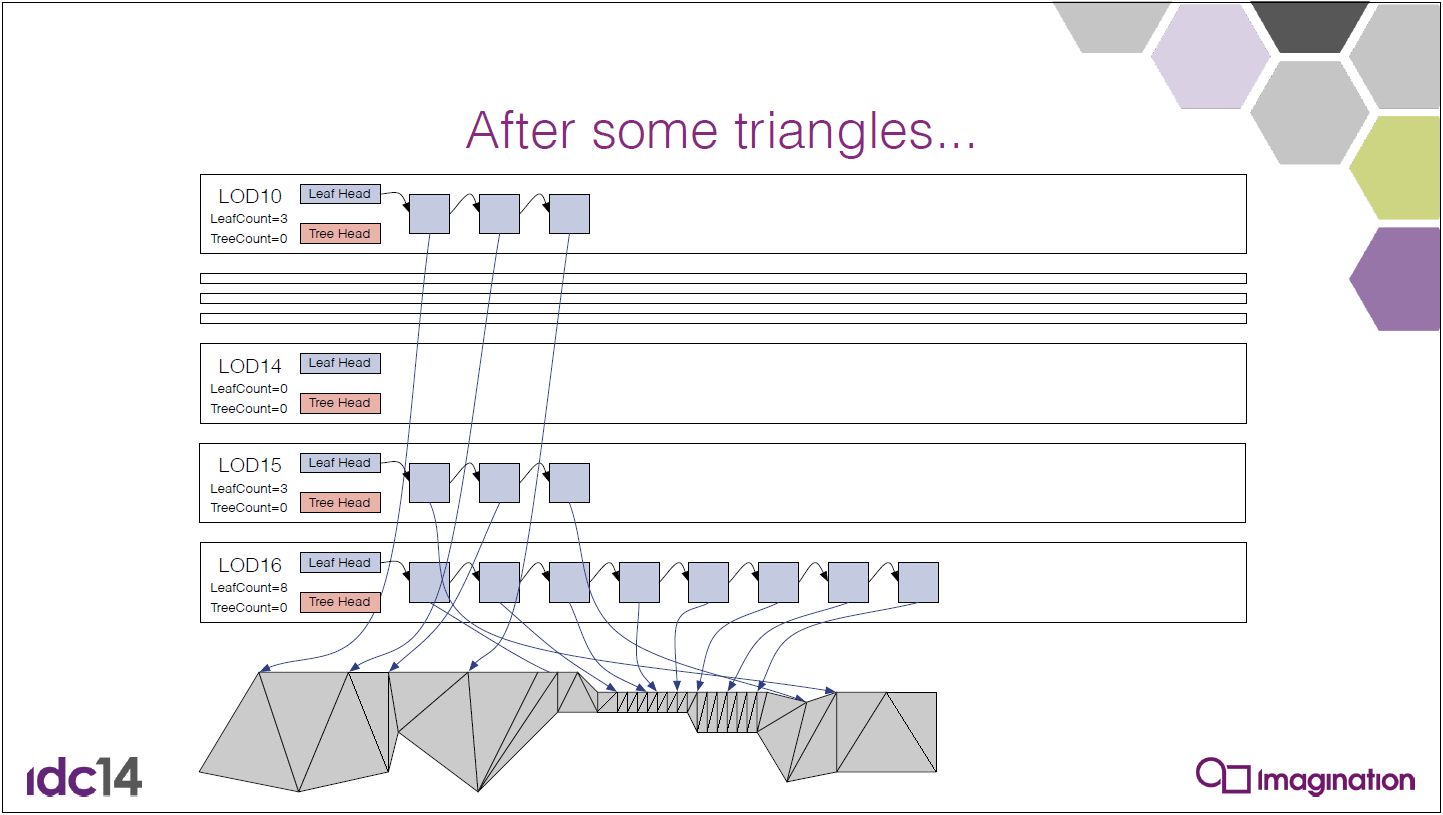

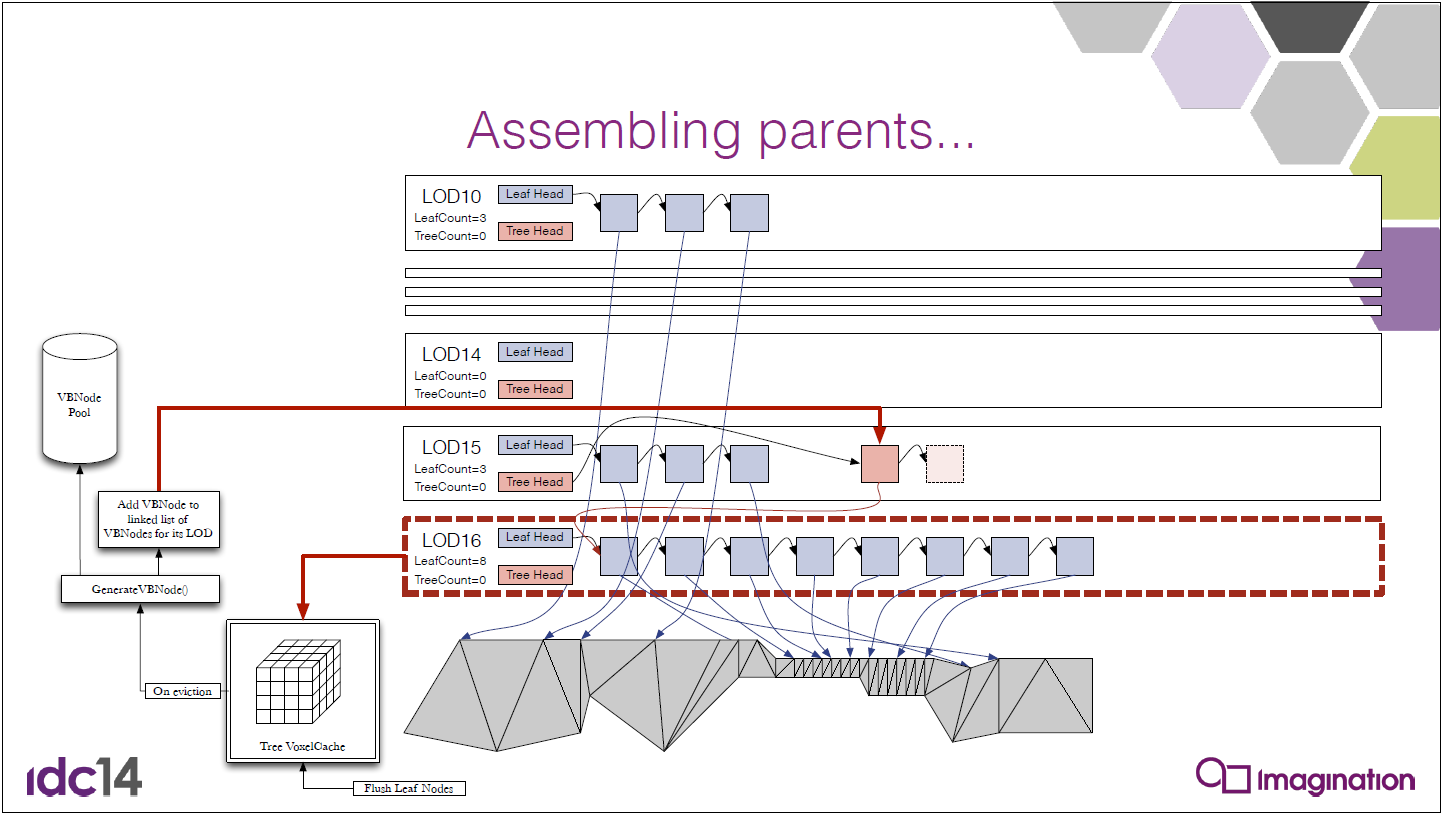

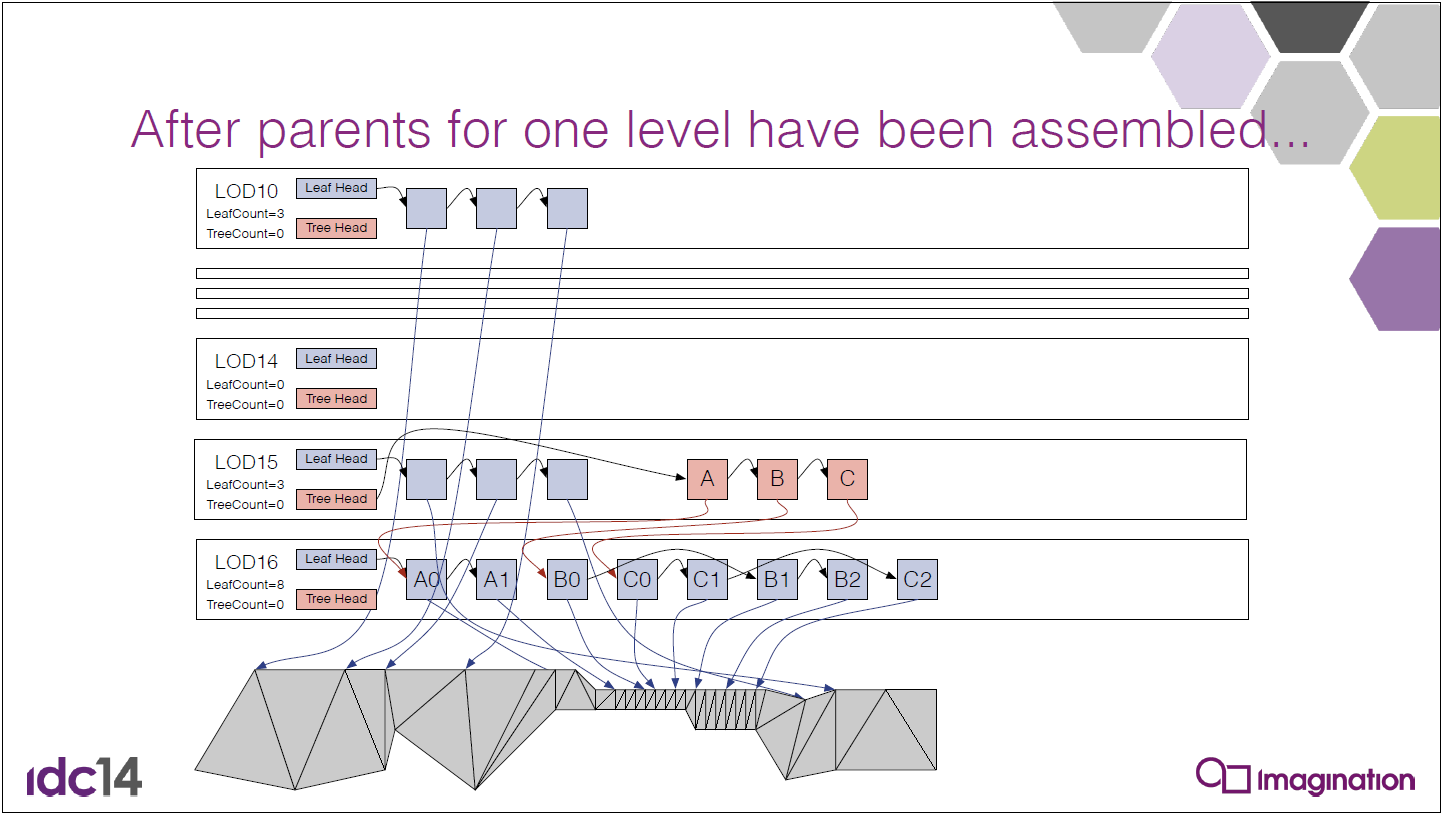

在2021年11月,Imagination Tech發布了IMG CXT系列及其突出功能:PowerVR Photon架構,提供超高效的混合光線追蹤,可提供7nm、5nm甚至3nm製程設計。其特性包括基於貼圖的延遲渲染、Imagination專用影像壓縮、超寬ALU、超標量ALU處理、廣泛的非同步機制、基於韌體的GPU、去中心化的多核等硬核技術。其中該架構添加了並發非同步光線追蹤,意味著CXT GPU現在可以有多達五種不同的任務類型在GPU內並發執行:幾何、片段/像素、計算、2D和光線追蹤。

上圖中可以看到IMG CXT GPU的高級視圖。GPU的主要組件包括:

- 統一著色集群(USC):GPU的計算核心,是一個多執行緒可編程SIMT處理器,可同時處理像素數據、幾何數據、計算數據以及2D/拷貝內務任務。對於GPU配置,更多USC等於更高的計算性能。

- 紋理處理單元(TPU):以高度優化的邏輯處理紋理定址、取樣和過濾。更多的紋理單元意味著更高的視覺複雜度、更高的刷新率和更高的顯示解析度支援。

- 光柵/幾何塊:一組固定功能單元,可在USC處理之前/之後對數據進行後處理和預處理,包括剔除、剪裁、分塊、壓縮、解壓縮、迭代等。

- 頂級(CXT RT3):包括三級快取、AXI匯流排介面和韌體處理器。

- 光線加速集群(RAC):一個新的專用塊,用於有效處理所有光線追蹤處理階段。此外,與之前的IMG B系列相比,CXT在單個核心單元中包含的ALU、TPU和幾何性能增加了50%。

與B系列GPU類似,CXT GPU也具有多核能力,可擴展到四個核。在上述「超越桌面」配置中,設計還包括額外的可選IP塊:

- NNA:我們的神經網路加速單元提供高功率、高性能和高效優化的神經網路處理。這些單元可以與IMG CXT GPU協同工作,並在具有多達八個核心的多核配置中提供多達100個頂級AI性能(如上圖所示)。

- OCM:片上共享存儲器,可用於在IMG CXT GPU和NNA單元之間高效交換數據。OCM還可以用於與其他IP塊的交互,方法是將數據保持在晶片上,以實現最高吞吐量、最低延遲和最佳功率效率。

- EPP:想像力的乙太網分組處理器(EPP)IP是一系列可擴展的多埠IEEE 802.3多千兆乙太網交換機和路由器解決方案。經過硅驗證,IP專門設計用於滿足高性能託管和非託管多埠交換機和路由器的苛刻通訊要求,非常適合汽車行業和其他網路處理市場。在此處所示的設計中,EPP將實現GPU組和/或數據存儲單元之間的高速連接,甚至允許影片壓縮遊戲流的直接流傳輸。

從3D的早期開始,傳統的渲染就使用光柵化進行,即使用三角形網格構建對象的幾何體,然後「著色」以創建其外觀。然而,通過光柵化,世界的照明方式只能近似。光線追蹤是不同的,它模擬了光在真實世界中的工作方式,其中光子從光源發射並在場景周圍反彈,直到到達觀看者的眼睛。光線追蹤將光線從觀察者(螢幕)發送到場景、對象上,並從那裡發送到光源。當燈光與對象交互時,它會被對象阻擋、反射或折射,這取決於其材質屬性,從而創建陰影和反射,甚至是螢幕外對象。一旦光線射入場景,照明過程自然發生,意味著開發人員不必花費時間創建「假」照明效果。這種優雅的照明場景方法有助於提供更逼真的圖形,改善遊戲和視覺應用程式,同時簡化內容創建者的照明過程。

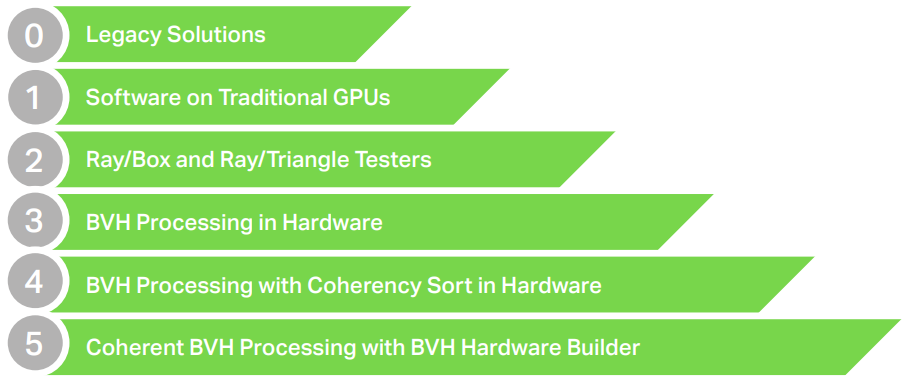

根據不同的級別,存在6種光線追蹤級別系統(Ray Tracing Levels System,RTLS):

對於Level 2,添加長方體/三角形測試器:

對於級別3,是全硬體的BVH遍歷:

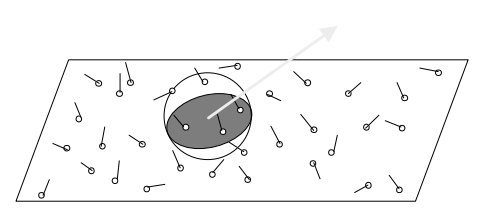

對於PowerVR Photon,支援Level 4 RTLS。PowerVR Photon體系架構旨在實現智慧手機功率和頻寬預算中的光線追蹤,還允許將這種效率擴展到移動以外的市場。光線追蹤的核心問題是缺乏一致性,因為射線可以、也會引入隨機方向,會與傳統GPU中設計的並行性相衝突。解決此問題的最佳解決方案是關注工作負載,為此,引入了一致性收集單元。

有了這個單元,BVH行走仍然是完全卸載的,但它現在變成了一個調度問題。可以存儲許多射線,然後相干單元將射線分組成類似的包或束,例如,通過BVH加速結構的類似路徑的射線——這些被稱為「相干」。雖然它們從一條射線到下一條射線可能是非相干的,但在多條射線上求平均值時,總是可以利用相似性和相關性,這正是PowerVR Photon體系結構所做的。

在PowerVR Photon中,光線被分組成處理包,不僅在處理中,而且在存儲器訪問中都將實現高效率。這種排序給了我們另一個好處:與MIMD架構不同,返回到GPU內部常見的高效處理方法:許多單元都做相同的事情。

因此,可以利用並行性,因為不只是針對一個方框檢查一條光線,可以針對同一方框檢查多條光線。此舉帶來了顯著的效率提高,並減少了對快取和記憶體子系統的壓力。對於三角形交點也是如此:可以同時針對多個三角形檢查光線。

因此,Photon架構有四個基本好處:

- 從ALU管線完整卸載BVH遍歷和箱/三測試。

- 一致性收集,確保光線處理變得並行。

- 一致性收集,確保數據重用率高,並顯著降低對快取和記憶體子系統的壓力。

- 由於有許多光線在運行,所以可以將ALU陰影工作和光線追蹤解耦,從而使延遲吸收(latency absorption)變得有效。

下表是不同的級別和對應設計的特性支援情況:

| Level 2 | Level 3 | Level 4 | |

|---|---|---|---|

| Example implementations | 2020 game console designs | 2021 desktop designs | PowerVR CXT |

| ALU Offloading | Partial | Full | Full |

| HW Box Testers | Y | Y | Y |

| HW Triangle Testers | Y | Y | Y |

| HW BVH Processing | N | Y | Y |

| HW Coherency Sort | N | N | Y |

| Cache Hit Rate | Low | Low/Medium | High |

| Memory Latency Tolerance | Low | Low | High |

| Processing Efficiency | Low(SIMT utilisation) | Low(MIMD) | High |

| Mobile Power Budget | N | N | Y |

PowerVR早在1996年就開創了基於分塊的延遲渲染(TBDR)。TBDR的重點是處理效率和頻寬。基於分塊的渲染通過在渲染之前將所有三角形幾何體排序到螢幕空間平鋪區域中來實現。這不同於即時模式渲染(IMR),其中每個三角形都被變換並立即繪製。對所有幾何體進行排序,然後按螢幕空間分塊區域(通常為16×16或32×32像素)進行渲染的好處是,可以僅使用用於深度/模板緩衝區和顏色緩衝區的片上記憶體來完成分塊區域的渲染。IMR將所有這些頻寬推離晶片,並依賴快取命中來減少頻寬,但由於幾何體提交在螢幕空間中的空間不一致,這種快取方法通常會失敗,導致高頻寬、延遲敏感性和低功率效率。

因此,通過首先對幾何體進行排序,快取命中率實際上變為100%。此外,深度和模板緩衝區通常只使用一次,因此可以丟棄。使用GBuffer和MRT渲染,許多MRT「顏色」目標僅用於中間暫存數據,只需要將一個顏色緩衝區寫入記憶體。使用TBDR,所有這些都可以在晶片上完成,節省記憶體佔用和大量頻寬。TBDR在處理抗鋸齒方面也具有顯著優勢。由於過取樣緩衝區僅存在於片上存儲器中,因此僅寫入下取樣顏色目標,再次節省了記憶體佔用和頻寬。

PowerVR Photon光線追蹤體系結構在許多方面與PowerVR TBDR體系結構相同,因為還進行了空間排序,只是將光線分成沿類似路徑通過BVH的包,而不是在2D螢幕空間中。這裡的好處與一致性排序類似——顯著的快取效率和減少的頻寬,同時處理保持SIMD/SIMT性質,確保邏輯和整體處理的高功率效率。

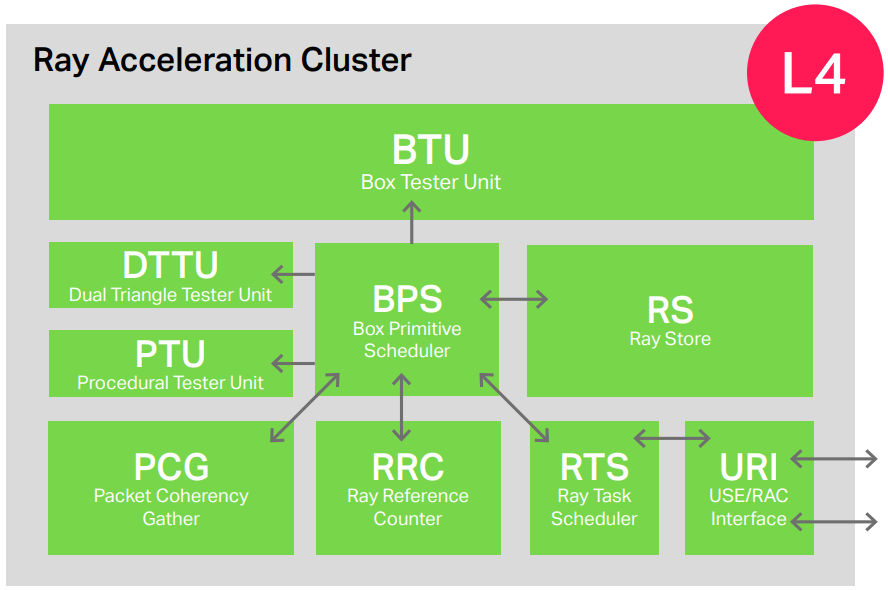

PowerVR Photon體系結構在PowerVR GPU中添加了一個新塊,稱為光線加速集簇(RAC),負責PowerVR GPU上的所有光線追蹤活動,包括整個過程:從發射光線(從著色器/內核)到將命中(或未命中)結果返回給ALU進行處理。

當光線由圖形著色器或計算內核程式生成並處理結果時,RAC與GPU的ALU引擎緊密耦合。雖然這些裝置與交換射線和命中/未命中資訊密切相關,但它們在技術上完全「解耦」,意味著兩個裝置同時運行,以實現最高的效率和利用率。RAC有效地處理整個BVH遍歷,包括計算非常密集的盒/射線和三角形射線交叉,以及效率優化,如相干排序。RAC與當前光線追蹤API公開的所有模式和功能完全兼容,包括Khronos Vulkan®擴展和Microsoft DirectX光線追蹤。

RAC是一個可擴展單元,支援多個性能點(例如,RAC的1x、0.5x、0.25x)以及多核可擴展性(2x及以上),其中多個RAC可以放置在ALU單元旁邊。在當前的PowerVR GPU設計中,RAC由兩個128寬的ALU單元共享,從而提高了RAC、ALU和紋理處理單元(TPU)的利用率。具有調度邏輯和其他固定功能支援的RAC、兩個ALU和兩個TPU單元的組合稱為可擴展處理單元(SPU)。這些構成了構建CXT GPU系列的基本單元,從每個GPU核心一個到四個SPU單元,然後由於分散多核系統,可以進一步擴展。

下表總結了不同級別及對執行效率的影響,以及由此產生的對功率、性能和頻寬的影響。

| GPU Block Ray Tracing Task | Level 1 RTLS | Level 2 RTLS | Level 3 RTLS | Level 4 RTLS |

|---|---|---|---|---|

| ALU Loading | Full | High | Low | Low |

| ALU Efficiency | Low | Low | Medium | High |

| Box/Tri Testers | N/A | Medium | High | Full |

| BVH Walking | Yes | Yes | Yes | Yes |

| Coherency | No | No | No | Yes |

| Cache Hits | Low | Low | Low/Medium | High |

| Bandwidth Usage | High | High | Medium | Low |

| Power Efficiency | Very Low | Low | Medium | High |

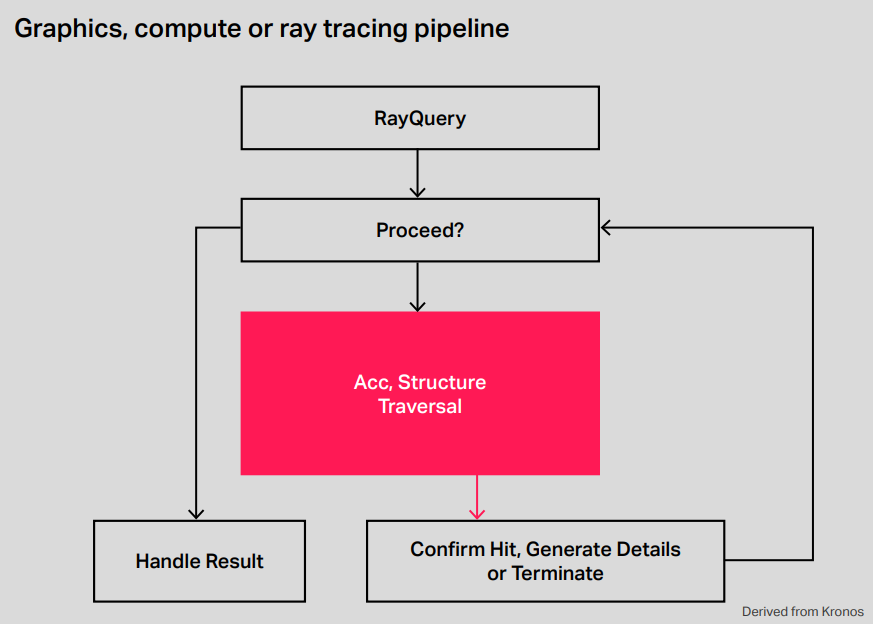

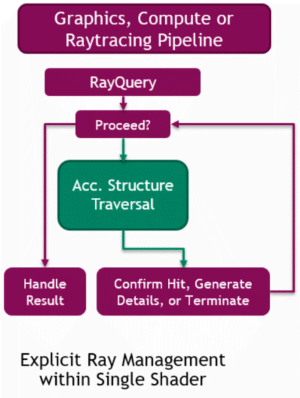

光線查詢也稱為Microsoft DirectX光線追蹤(DXR)下的內聯光線追蹤,非常容易理解,因為本質上任何著色器或內核(計算)都可以發出光線查詢,該查詢將啟動整個光線追蹤過程。在該系統中,生成的命中/未命中資訊返回到必須處理它的同一著色器/內核。因此,光線追蹤非常簡單,根據DXR名稱樣式,它實際上是一個內聯過程。

一個簡單的例子就是陰影光線。在這裡,場景被渲染為正常,但現在在片段/像素著色器中,光線朝光源發射,當光源被擊中時,我們知道當前像素被照亮,可以在著色器中執行正確的程式碼。如果擊中場景中的任何其他對象,可以知道它在陰影中,並且再次,可以在著色器中執行正確的程式碼。在該方案中,反射將更加困難,因為當反射對象被擊中時,必須觸發大量複雜度,以確定如何為該反射對象渲染正確的顏色,而這一切都必須在原始投射著色器中處理。

對於大多數初始渲染演算法,將推薦使用光線查詢,更容易添加到現有遊戲引擎中,並且也可能在實現中提供更可預測的性能。

PowerVR Photon參考了加速結構和邊界體積層次結構,用來剔除光線盒和光線三角形測試數量的高級結構,如下所示:

如圖所示,邊界體積層次結構提供了一種加速機制,可以系統地檢查邊界框,如果遺漏了一個框,我們知道可以忽略該級別下的所有框/三角形。這使得它成為一種加速結構,將射線測試過程儘可能減少到最小。這種結構以及在其創建中使用的品質和啟發式方法,將對硬體的效率產生重大影響,因為最佳結構可以比簡單、構造差的結構更有效地減少工作量。因此,API公開了生成此加速結構的快速和慢速方法。

快速構建演算法對於被動畫化並在幀與幀之間廣泛變化以保持高幀速率的對象至關重要。對於靜態對象,應在載入時(甚至在開發期間離線)使用慢速構建方法,靜態對象將在其整個生命周期中使用,因此應儘可能優化。它們由兩個元素組成,一個頂層加速結構(TLAS)和多個底層加速結構(BLAS)。上面描述的更多的是BLAS,因為它包含一個對象的加速度結構,例如示例中的兔子,而TLAS由多個BLAS結構組成。

構建加速結構的步驟如下所示:

在進入RAC之前,GPU內部需要各種其他處理步驟,對於使用光線查詢的混合渲染工作負載,可以總結如下:

應用程式通過發出API調用來渲染場景,這些API調用由GPU驅動程式在記憶體中構造命令緩衝區和數據結構(紋理、著色器、緩衝區)來處理。驅動程式還將啟動硬體,可能會將其從節能模式中喚醒,或者只是標記有更多的工作可供處理。此觸發觸發嵌入式韌體處理器,該處理器將處理所有內部活動管理,並確保所有作業遵守設置的優先順序。

典型的首先要做的是啟動幾何處理,意味著繪製調用將成為GPU內的任務,每個任務都在GPU內進行調度,並旨在在USC內保留所需的資源進行處理。然後將提取頂點/幾何體數據,當數據可用時,任務變為活動狀態並執行著色器程式。這將生成輸出幾何圖形,然後輸出幾何圖形將命中一系列固定功能塊,如剔除、剪裁、平鋪和幾何圖形壓縮,然後將中間參數數據寫入記憶體。

該參數數據是每個分片的幾何體鏈接列表,在每個分片中都可能可見,從而使基於分塊的延遲渲染髮揮其魔力。所有這些工作都是處理的第一階段,通常將其稱為幾何階段或分塊加速器(TA)階段。此階段與下一個渲染階段同時運行。

基於分塊的延遲渲染架構中的3D處理從HSR開始。所有的3D處理都是一塊一塊地完成的,意味著使用參數數據鏈表結構獲取位置數據。對於分塊深度/模板內的所有幾何數據,執行測試,在標記緩衝區內生成可見性列表,該列表指示每個像素的可見對象。一旦處理了所有幾何體,就有了按像素標記的可見性列表,從邏輯上講,它是一個單一的不透明對象(因為它後面的所有東西都將被隱藏/移除),並且在不透明對象前面有幾個Alpha混合層。

然後按正確的深度順序開始渲染,並按每個著色器進行排序,每個著色器代表一個任務。任務處理意味著,首先,調度器在USC內保留所需的資源進行處理,然後在任務變為活動狀態並執行正確的著色器程式指令之前預取任務和數據。如果任務中的著色器程式包含光線查詢調用,則將在此處觸發RAC。

對於具有光線查詢調用的著色器,該任務不僅將請求USC資源,還將請求RAC資源。當著色器使用USC/ray介面(URI)將所需的光線資訊發射到RAC時,執行實際光線追蹤,並且該資訊存儲在光線存儲中。

與紋理操作類似,在將所需光線資訊傳輸到RAC之後,USC將將任務置於非計劃等待狀態,意味著在RAC執行其工作時,USC會開始處理其他任務/作業。可以想像,所有這些工作都是大規模並行的,因為不僅僅處理一個片段/工作項或射線,而是在每個任務(warp)中並行處理多個執行緒。硬體還將執行許多此類任務,以確保延遲吸收和高利用率。RAC將有效地存儲許多需要處理的射線。

此時,光線參考計數器會追蹤每條光線,該計數器會隨著所需的每次測試而增加。根據加速度結構,這些測試從一開始,隨著更多的盒子相交而增加,從而觸發更多的盒子測試。射線處理在相干組中進行,意味著分組相干收集塊將掃描射線,以構建相干地穿過結構的射線分組。當數據包填滿時,它們將被執行,根據需要運行射線穿過盒子和/或三角形和/或基本測試儀。此處理通過專用加速結構快取(ASC)運行,確保數據也在數據包中重複使用。

當然,ASC只是一個快取級別。進一步的快取將在整個GPU記憶體層次結構中發生,包括最大的SLC快取級別,甚至可能是SoC級別的系統級快取。當該處理完成時,射線參考計數器(RRC)將隨著測試的調度和完成而遞增和遞減,直到當參考計數達到零並且射線的結果準備就緒時,處理結束。

此時,一條或多條光線將被調度為將控制權返回給USC進行進一步的著色器處理,意味著USC任務將恢復。然後,USC可以通過URI從為所有處理保留了資源的光線存儲讀取生成的光線數據。

在這個階段,著色器的處理將繼續正常進行,直到通過執行具有和不具有光線查詢的著色器/內核的混合來完全繪製分塊。在此過程中,其他固定功能塊(如紋理處理單元)將用於執行著色器。

重要的是要認識到,此時的執行是許多任務的混合:幾何體將在處理,計算任務可能在運行,RAC將追蹤光線並查找命中/未命中,而著色器核心將執行程式碼作為所有這些操作的一部分。2D和內務任務也可以用於複製數據或生成MIPMAP。對於如此多樣的作業,目標是在所有處理單元中獲得最大效率,並確保任何處理任務和記憶體訪問的延遲通過處理其他獨立任務完全隱藏。

一旦分塊完成,將觸發像素後端,將完成的分塊寫入記憶體,可能使用想像影像壓縮(IMGIC)幀緩衝區壓縮。

光線追蹤時隱藏的一致性

雖然光線追蹤在本質上是「令人尷尬的平行」,但實時光線追蹤之所以花了這麼長時間才變得實用,原因之一是,儘管存在並行性,但它通常是發散的和非相干的。可以從下圖中加以理解。

在現實世界中,材質具有不同的屬性——有些是平滑的,但大多數是粗糙的——因此,對於真實曲面,光線不會以相同的方式反射,而是在不同的方向上反彈。結果是發散,例如光線從一個像素反彈到下一個像素,光線沿不同方向傳播。因此,光線將沿著不同的路徑穿過BVH框,從而導致不同的記憶體訪問,從邏輯上講,沿不同方向傳播的光線也將與不同的三角形相交,從而觸發不同的著色器程式,從而導致著色器執行的差異。

發散對GPU是不利的,因為儘管它們非常擅長處理高度並行的工作負載,但它們的SIMD架構只有在這些工作負載一致且相似的情況下才有意義。如果每個像素都想做一些不同的事情,那麼GPU所依賴的高執行和頻寬效率的技巧就會失敗。意味著最終會採用暴力方法(即使用大量ALU和光線追蹤單元),需要在處理流程難以有效使用它們時進行補償(即儘管理論上的峰值吞吐量很高,但在實際使用中,低利用率會導致低吞吐量)。

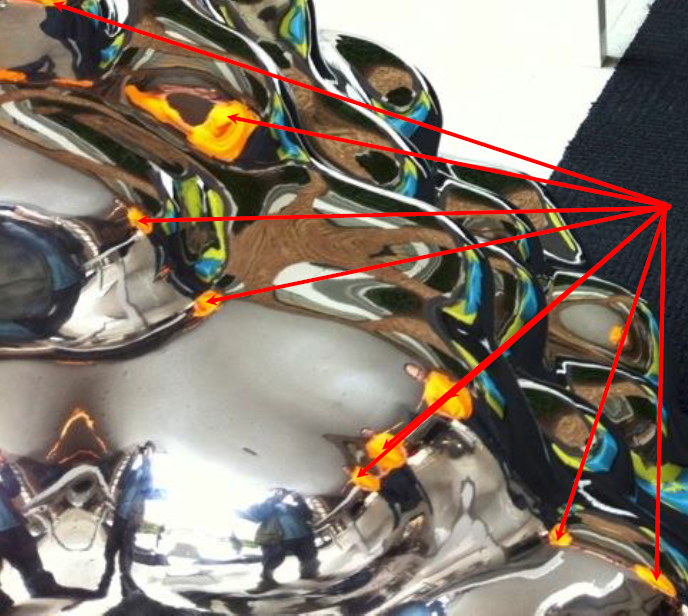

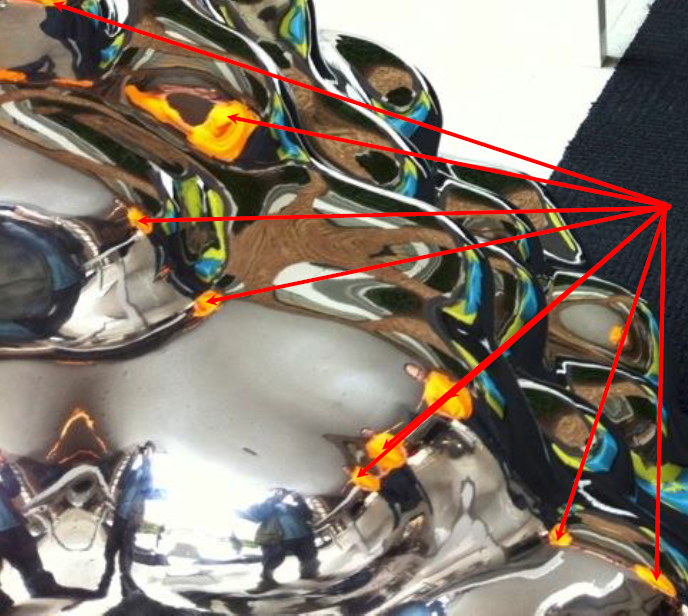

然而,雖然從一個像素到下一個像素的光線可能是發散的,但並不意味著在四處反彈的光線束之間沒有「相干」。同樣,這在下圖中得到了最好的說明。下面的反射形狀顯示了從該對象反射的光線中隱藏的相干。例如,你可以看到穿黃色衣服的人被多次反射,意味著這些光線進入同一方向,實際上是相干的。更重要的是,如果我們能將這些光線分組,它們將沿著類似的路徑通過BVH,為我們提供高速快取命中率和數據重用率。它們也將最終命中並與相同的三角形相交,並且可能還執行相同或類似的著色器程式,從而在傳統的並行GPU ALU管線中提供高效率。

大約10年前,多通道光柵化達到了臨界點,對於藝術家來說,迭代時間長,工作流程笨拙,從可視性角度渲染瑕疵近似值,預烘焙和快取照明通常有效…直到它不起作用,無法按預期準確模擬光照傳輸。採用路徑追蹤——處理一切的統一光照傳輸演算法,圖元包含曲面、頭髮、體積測量…反射包含所有類型的BSDF、BSSRDF…燈光包含點光源、區域光源、環境圖光源…

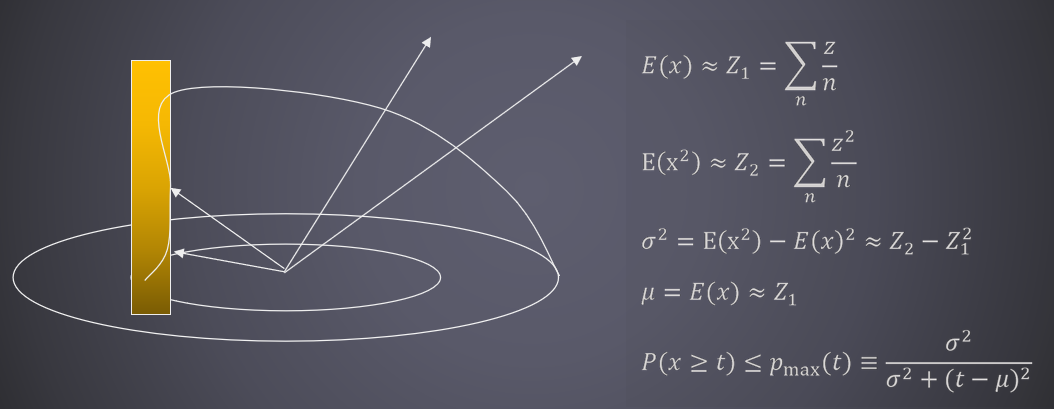

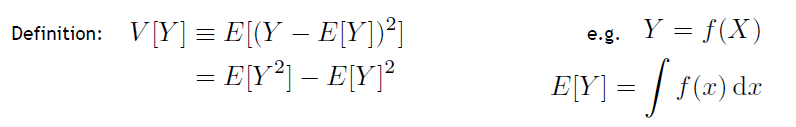

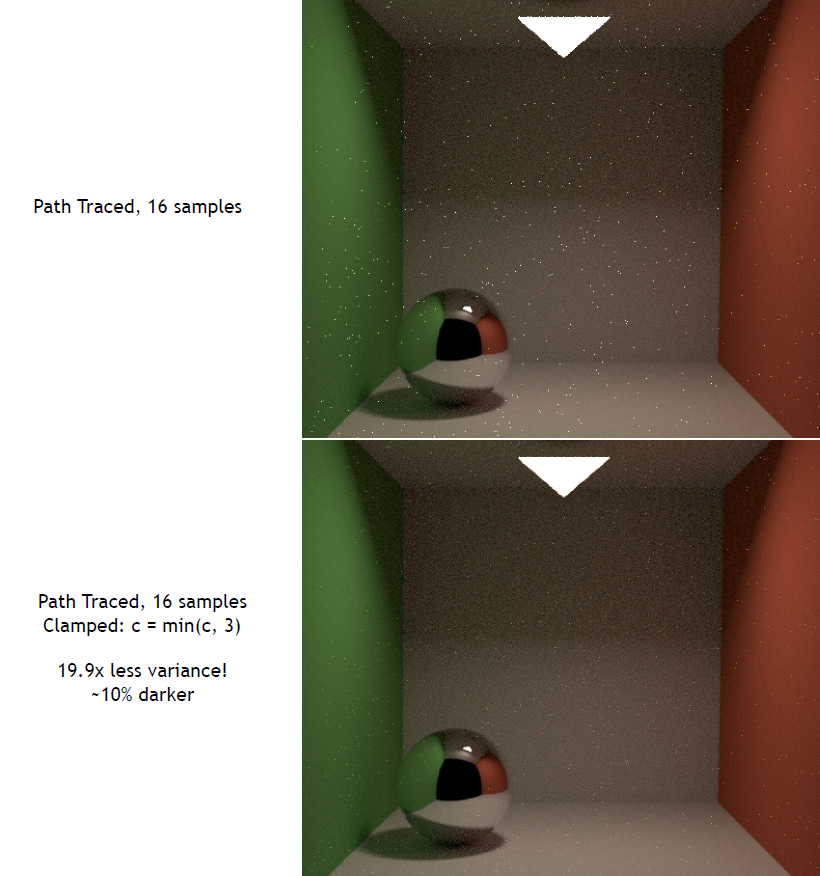

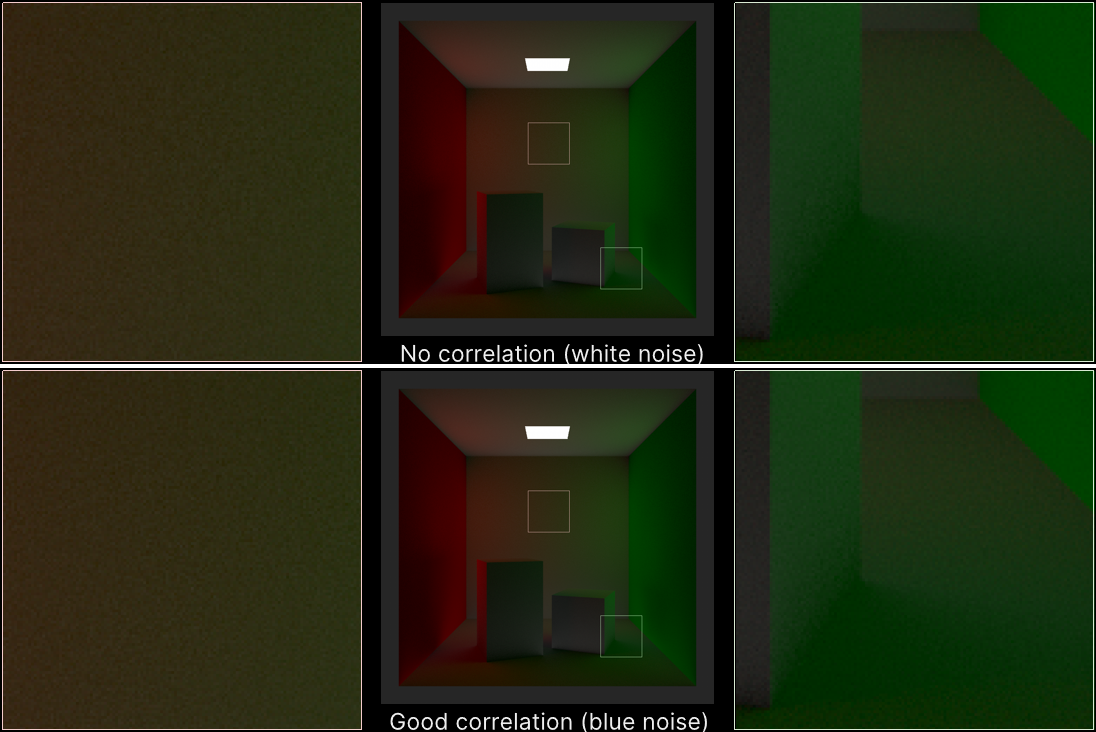

方差的概念和公式:

所有取樣技術都基於將隨機數從單位平方扭曲到其它域,再到半球、球體、球體周圍的圓錐體,再到圓盤。還可以根據BSDF的散射分布生成取樣,或選擇IBL光源的方向。有許許多多的取樣方式,但它們都是從0到1之間的值開始的,其中有一個很好的正交性:有「你開始的那些值是什麼」,然後有「你如何將它們扭曲到你想要取樣的東西的分布,以使用第二個蒙特卡羅估計」。

對應取樣方式,常用的有均勻、低差異序列、分層取樣、元素區間、藍噪點抖動等方式。低差異類似廣義分層,藍色噪點類似不同樣本之間的距離有多近。過程化模式可以使用任意數量的前綴,並且(某些)前綴分布均勻。

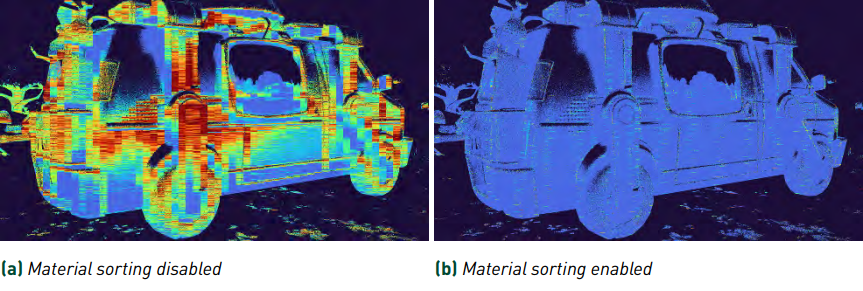

方差驅動的取樣——根據迄今為止採集的樣本,周期地估計每個像素的方差,在差異較大的地方多取樣,更好的做法是在方差/估計值較高的地方進行更多取樣,在色調映射等之後執行此操作。離線(品質驅動):一旦像素的方差足夠低,就停止處理它。實時(幀率驅動):在方差最大的地方採集更多樣本。計算樣本方差(重要提示:樣本方差是對真實方差的估計):

float SampleVariance(float samples[], int n)

{

float sum = 0, sum_sq = 0;

for (int i=0; i<n; ++i)

{

sum += samples[i];

sum_sq += samples[i] * samples[i];

}

return sum_sq/(n*(n-1))) - sum*sum/((n-1)*n*n);

}

樣本方差只是一個估計值,大量的工作都是為了降噪,MC渲染自適應取樣和重建的最新進展。總體思路:在附近像素處加入樣本方差,可能根據輔助特徵(位置、法線等)的接近程度進行加權。高方差是個詛咒,一旦引入了一個高方差樣本,就會有大麻煩了,例如考慮對數據進行均勻取樣:

1 & x<.999 \\

100 & \text { otherwise }

\end{array}\right.

\]

6個樣本:(1, 1, 1, 1, 1, 100 ) ≈ 17.5,再取6個樣本:(1, 1, 1, 1, 1, 100, 1, 1, 1, 1, 1, 1 ) ≈ 9.25,回想一下,方差隨樣本數呈線性下降…面對這種高方差樣本,最hack但也最有效的方式是clamp,如下圖所示:

更複雜的選擇是基於密度的異常值剔除,保存所有樣本,分析並過濾異常值。根據亮度將樣本分成幾個單獨的影像,然後根據統計分析重新加權。

光線追蹤從離線到實時的幾個重要方面:

- 明智地選擇光線。採用蒙地卡羅積分法、方差、重要性取樣、多重重要性取樣。

- 仔細選擇你的(非)隨機數。域扭曲、准隨機序列、低差異、分層。

- 把你的射線預算花在最有用的地方。自適應取樣。

- 理解並防止錯誤。強度夾緊、路徑正則化。

蒙特卡羅快速回顧:

准蒙特卡羅(QMC):確定性、低差異序列/集合(Halton、Hammersley、Larcher-Pillichshammer)比隨機的收斂速度更好,例如Sobol或(0-2)序列不需要知道樣本數量,奇妙的分層特性。

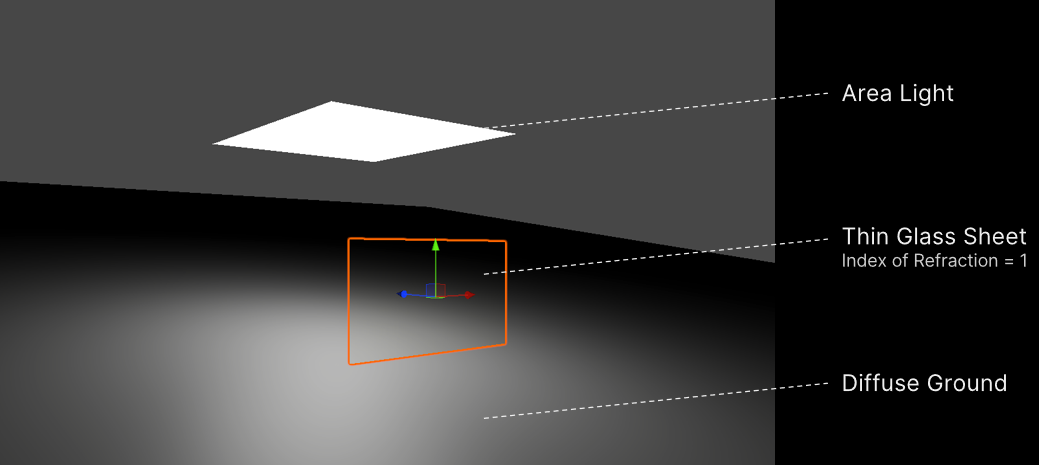

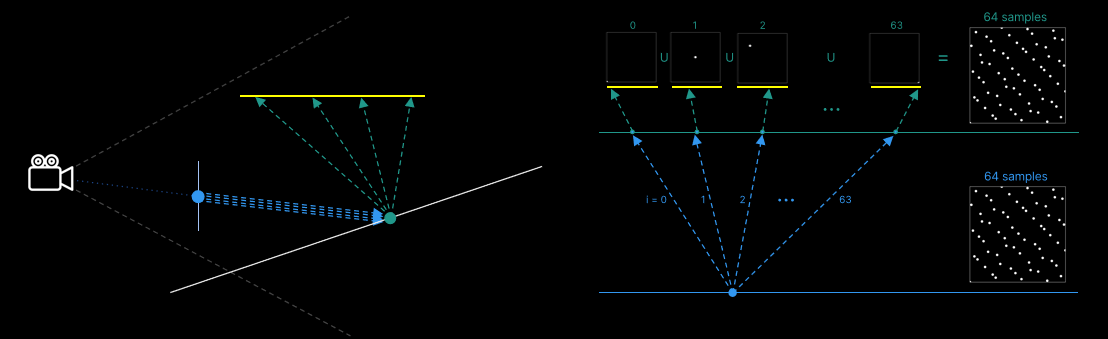

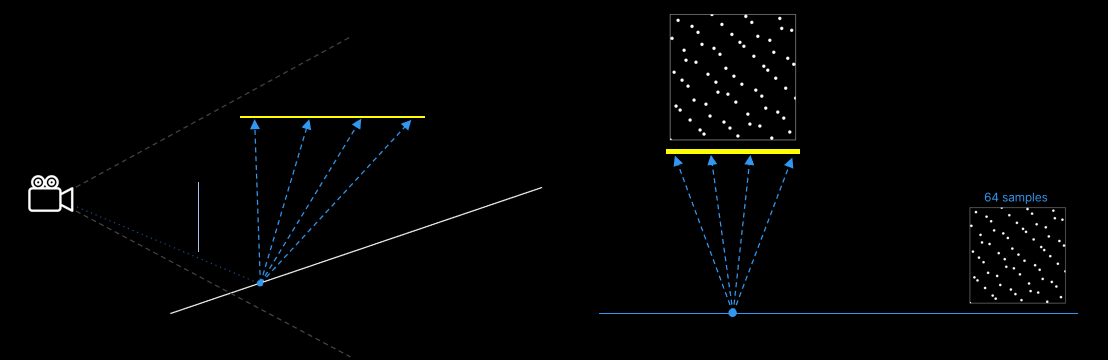

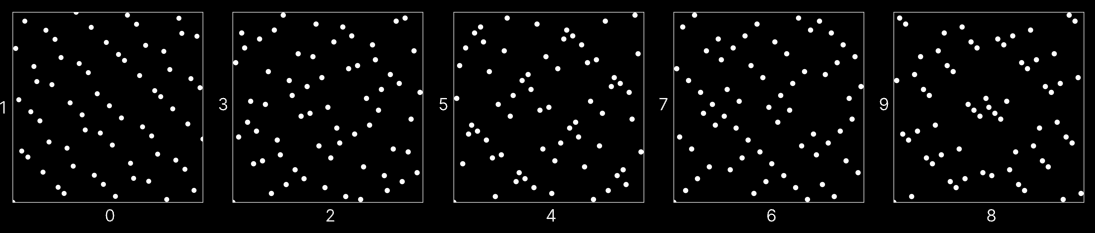

下圖中有一個大面積的光在傾斜,漫反射地面上。相機正前方是一片薄玻璃片,折射率為1(因此完全透射)。這將是一個相當常見的場景的調試版本,其中場景的大部分(如果不是全部的話)都在一個窗口後面。

因為對光線有一個固定的分裂因子,索引也很容易追蹤:對於每個光取樣計算,可以使用樣本i到i+3。如果每個照明位置都與對應位置非常不同,就像康奈爾盒子的情況一樣,不會有太大的區別(但考慮到屬性或我們的順序,至少會同樣好)。然而,如果位置更相似(甚至完全相同)。。。

在地面上使用64個相機直接可見的光源樣本。

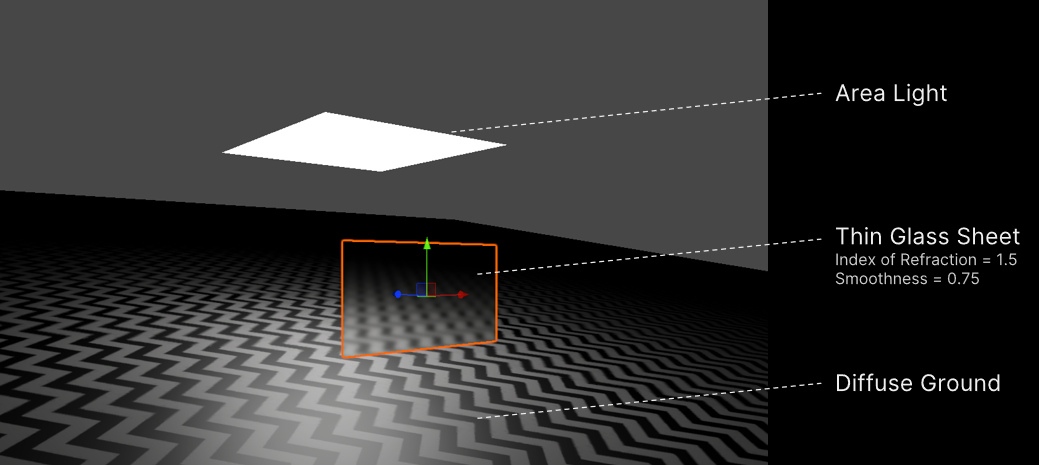

下圖是一個稍微不同的場景,使取樣預算更容易測試。場景中的薄玻璃片更粗糙,為了更好地欣賞這種粗糙的效果,對地面進行紋理處理。

若使用之前一樣的取樣方式,由粗糙玻璃產生的BSDF射線的相干度當然不如以前,由此獲得了下圖那樣更加毛躁的影像:

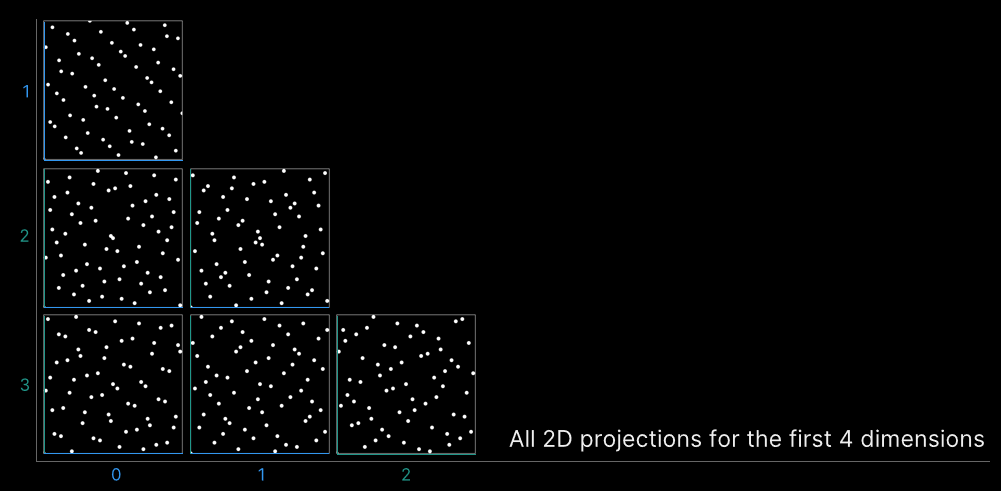

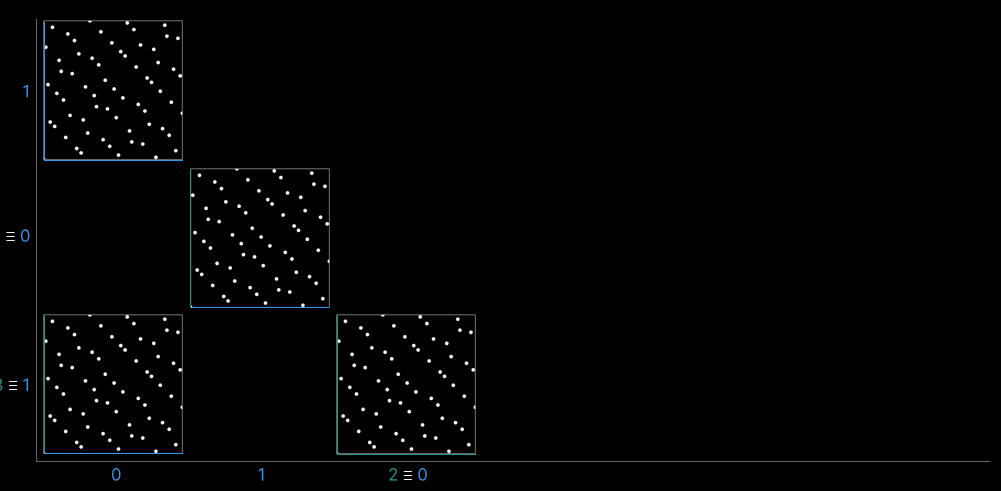

由此遇到了一個像素之間相關性很差的情況,4D序列中的一些維度在一個像素內的相關性很差。為此,需要查看4D點的不同2D投影,遵循Jarosz等人在正交陣列論文中使用的可視化約定:可以在軸上看到對應於每個維度的索引,在數組的每個單元格中,將顯示相應的2D切片,是尺寸(0,1)和(2,3)的2D切片,是在取樣常式中使用的切片,它們其實是一樣的。

現在看看下圖的「診斷」切片,(0,3)和(1,2)也是相同的。剩下的(0,2)和(1,3)相當於(0,0)和(1,1)。。。

實際上,需要使用高緯度的Sobol序列。有許多可能的Sobol序列,[Grünschloß]和[Joe 2008]的Sobol序列優化了低維2D投影的分層特性,用於低樣本數量: