ModelBox開發體驗:使用YOLOv3做口罩檢測

摘要:本案例將在ModelBox中使用YOLO v3模型,實現一個簡單的口罩檢測應用

本文分享自華為雲社區《ModelBox開發體驗Day05開發案例-使用YOLOv3做口罩檢測》,作者: 孫小北。

- 本案例將使用YOLO v3模型,實現一個簡單的口罩檢測應用

- 程式碼://github.com/sunxiaobei/modelbox_gallery

- 程式碼tag:v1.5 mask_det_yolo3,v1.5.1 mask_det_yolo3_camera

開發準備

- 開發環境安裝和部署,前面環境已完成

- 模型訓練,ModelArts訓練模型

- 模型轉換,程式碼模型已完成轉換

應用開發

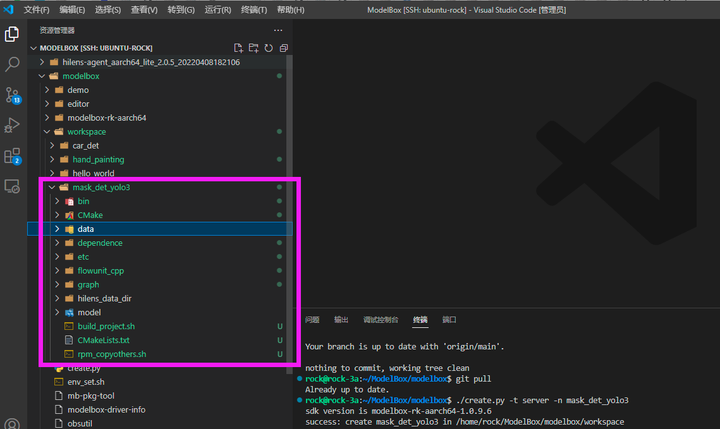

打開VS Code,連接到ModelBox sdk所在目錄或者遠程開發板,開始進行口罩檢測應用開發。

(1)創建工程

使用create.py創建mask_det_yolo3工程, 將會創建出一個空的ModelBox樣例工程。

./create.py -t server -n mask_det_yolo3 git add . git commit -m 'create mask_det_yolo3'

(2)創建推理功能單元

AI應用的核心是模型推理部分,我們用如下命令創建推理功能單元,該模組將會創建在工程目錄的model文件夾下:

./create.py -t infer -n mask_infer -p mask_det_yolo3 git add . git commit -m 'create mask_infer'

將資源包中model/mask_infer文件夾中的模型和配置文件拷貝到口罩檢測工程的model/mask_infer目錄下。其中yolo3_resnet18_mask_det_288x512-rknpu2.rknn是轉換好的rknn模型,mask_infer.toml是該模型的ModelBox功能單元配置文件,其內容如下:

# Copyright (c) Huawei Technologies Co., Ltd. 2022. All rights reserved. [base] name = "mask_infer" device = "rknpu" version = "1.0.0" description = "your description" entry = "./yolo3_resnet18_mask_det_288x512-rknpu2.rknn" # model file path, use relative path type = "inference" virtual_type = "rknpu2" # inference engine type: rockchip now support rknpu, rknpu2(if exist) group_type = "Inference" # flowunit group attribution, do not change is_input_contiguous = "false" # rk do not support memory combine, fix, do not change [input] [input.input1] name = "data" type = "uint8" device = "rknpu" [output] [output.output1] name = "yolo/output1" type = "float" [output.output2] name = "yolo/output2" type = "float" [output.output3] name = "yolo/output3" type = "float"

可以看到該模型有3個輸出節點,即YOLO v3模型輸出的3個feature map,需要從中解碼出檢測框。

(3)創建後處理功能單元

後處理功能單元負責從模型推理結果中解碼出檢測框,我們用如下命令創建該功能單元,其將會創建在工程目錄的etc/flowunit文件夾下:

./create.py -t python -n yolo3_post -p mask_det_yolo3

將common資源包中etc/flowunit/yolo3_post文件夾中的程式碼和配置文件拷貝到口罩檢測工程的同名目錄下,解碼過程的核心邏輯在yolo3_utils.py文件中,可以查閱YOLO v3模型細節閱讀程式碼。

(4)創建畫圖功能單元

得到檢測框後可以畫在原圖上進行輸出展示,我們用如下命令創建畫圖功能單元:

./create.py -t python -n draw_mask_bbox -p mask_det_yolo3

將common資源包中etc/flowunit/draw_mask_bbox文件夾中的程式碼和配置文件拷貝到口罩檢測工程的同名目錄下,畫圖的核心邏輯在draw_mask_bbox.py文件的draw_mask_info函數中:

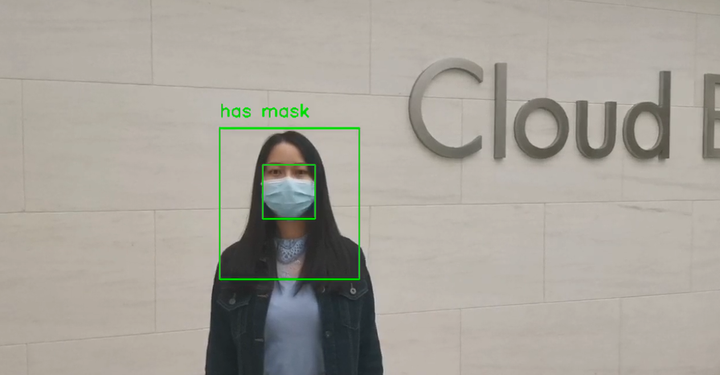

def draw_mask_info(self, image, bboxes): '''在圖中畫出口罩佩戴資訊''' thickness = 2 font_scale = 1 text_font = cv2.FONT_HERSHEY_SIMPLEX for bbox in bboxes: label_index = int(bbox[5]) if self.labels[label_index] != 'head': continue x_min, y_min, x_max, y_max = bbox[0], bbox[1], bbox[2], bbox[3] face_bbox = self.find_max_cover_bbox( bbox, bboxes, 'face', self.face_cover_ratio) if not face_bbox: cv2.rectangle(image, (x_min, y_min), (x_max, y_max), (255, 255, 0), thickness) cv2.putText(image, 'unknown', (x_min, y_min-20), text_font, font_scale, (255, 255, 0), thickness) continue mask_bbox = self.find_max_cover_bbox( face_bbox, bboxes, 'mask', self.mask_cover_ratio) if not mask_bbox: cv2.putText(image, 'no mask', (x_min, y_min-20), text_font, font_scale, (255, 0, 0), thickness) cv2.rectangle(image, (x_min, y_min), (x_max, y_max), (255, 0, 0), thickness) else: cv2.putText(image, 'has mask', (x_min, y_min-20), text_font, font_scale, (0, 255, 0), thickness) cv2.rectangle(image, (x_min, y_min), (x_max, y_max), (0, 255, 0), thickness) cv2.rectangle(image, (mask_bbox[0], mask_bbox[1]), (mask_bbox[2], mask_bbox[3]), (0, 255, 255), thickness) return image

針對每個人,該模型會嘗試檢測出head(頭肩部)、face和mask三個檢測框。如果face檢測框與mask檢測框的重合度大於某個閾值,就判為佩戴口罩;否則,就判為沒有佩戴口罩;如果沒有檢測到face檢測框,就會顯示Unknown,表示未知。

(5)修改流程圖

模型推理和配套的功能單元準備好後,我們就可以串聯出流程圖進行測試了,口罩檢測工程默認在graph目錄下生成了mask_det_yolo3.toml,我們參考資源包中的graph/mask_det_yolo3.toml將其修改為:

# Copyright (c) Huawei Technologies Co., Ltd. 2022. All rights reserved. [driver] dir = ["${HILENS_APP_ROOT}/etc/flowunit", "${HILENS_APP_ROOT}/etc/flowunit/cpp", "${HILENS_APP_ROOT}/model", "${HILENS_MB_SDK_PATH}/flowunit"] skip-default = true [profile] profile=false trace=false dir="" [graph] format = "graphviz" graphconf = """digraph mask_det_yolo3 { node [shape=Mrecord]; queue_size = 4 batch_size = 1 input1[type=input,flowunit=input,device=cpu,deviceid=0] data_source_parser[type=flowunit, flowunit=data_source_parser, device=cpu, deviceid=0] video_demuxer[type=flowunit, flowunit=video_demuxer, device=cpu, deviceid=0] video_decoder[type=flowunit, flowunit=video_decoder, device=rknpu, deviceid=0, pix_fmt=bgr] image_resize[type=flowunit, flowunit=resize, device=rknpu, deviceid=0, width=512, height=288] mask_detection[type=flowunit, flowunit=mask_infer, device=rknpu, deviceid=0] yolo3_post[type=flowunit, flowunit=yolo3_post, device=cpu, deviceid=0] draw_mask_bbox[type=flowunit, flowunit=draw_mask_bbox, device=cpu, deviceid=0] video_out[type=flowunit, flowunit=video_out, device=rknpu, deviceid=0] input1:input -> data_source_parser:in_data data_source_parser:out_video_url -> video_demuxer:in_video_url video_demuxer:out_video_packet -> video_decoder:in_video_packet video_decoder:out_video_frame -> image_resize:in_image image_resize:out_image -> mask_detection:data mask_detection:"yolo/output1" -> yolo3_post:in_feat1 mask_detection:"yolo/output2" -> yolo3_post:in_feat2 mask_detection:"yolo/output3" -> yolo3_post:in_feat3 video_decoder:out_video_frame -> draw_mask_bbox:in_image yolo3_post:out_data -> draw_mask_bbox:in_bbox draw_mask_bbox:out_image -> video_out:in_video_frame }""" [flow] desc = "mask_det_yolo3 run in modelbox-rk-aarch64"

該流程圖對於某個影片流,經過影片解碼、影像縮放、口罩檢測推理、檢測框後處理、畫圖等一系列操作後,將結果保存下來。

然後,參考common資源包中mock_task.toml,將口罩檢測工程的任務配置文件bin/mock_task.toml中輸入輸出部分修改為:

# 任務輸入,mock模擬目前僅支援一路rtsp或者本地url # rtsp攝影機,type = "rtsp", url裡面寫入rtsp地址 # 其它用"url",比如可以是本地文件地址, 或者httpserver的地址,(攝影機 url = "0") [input] type = "url" url = "../data/mask_test.mp4" # 任務輸出,目前僅支援"webhook", 和本地輸出"local"(輸出到螢幕,url="0", 輸出到rtsp,填寫rtsp地址) # (local 還可以輸出到本地文件,這個時候注意,文件可以是相對路徑,是相對這個mock_task.toml文件本身) [output] type = "local" url = "../hilens_data_dir/mask_test_result.mp4"

將common資源包中的data/mask_test.mp4測試影片拷貝到口罩檢測工程的data目錄下,該流程圖使用這一影片進行口罩檢測,檢測結果繪製後保存為hilens_data_dir/mask_test_result.mp4文件。

(6)運行應用

在mask_det_yolo3工程路徑下執行build_project.sh進行工程構建:

cd workspace/mask_det_yolo3

./build_project.sh

執行bin/main.sh運行應用(如果運行報錯請切換到root帳號再運行,本應用需要事先使用pip安裝好OpenCV和NumPy),運行結束後在hilens_data_dir目錄下生成了mask_test_result.mp4文件,可以下載到PC端查看。

bin/main.sh git add . git commit -m 'run mask_det_yolo3' git push git tag -a v1.5 -m 'mask_det_yolo3' git push origin --tags

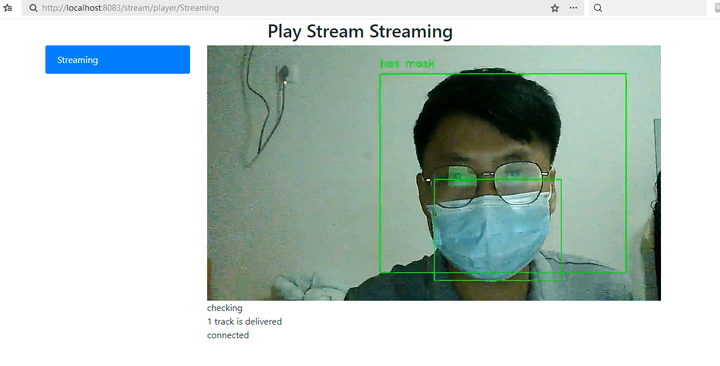

(7)實時攝影機

# 用於本地mock文件讀取任務,腳本中已經配置了IVA_SVC_CONFIG環境變數, 添加了此文件路徑 ########### 請確定使用linux的路徑類型,比如在windows上要用 D:/xxx/xxx 不能用D:\xxx\xxx ########### # 任務的參數為一個壓縮並轉義後的json字元串 # 直接寫需要轉義雙引號, 也可以用 content_file 添加一個json文件,如果content和content_file都存在content會被覆蓋 # content_file支援絕對路徑或者相對路徑,不支援解析環境變數(包括${HILENS_APP_ROOT}、${HILENS_DATA_DIR}等) [common] content = "{\"param_str\":\"string param\",\"param_int\":10,\"param_float\":10.5}" # 任務輸入,mock模擬目前僅支援一路rtsp或者本地url # rtsp攝影機,type = "rtsp", url裡面寫入rtsp地址 # 其它用"url",比如可以是本地文件地址, 或者httpserver的地址,(攝影機 url = "0") [input] type = "url" # url = "../data/mask_test.mp4" url = "0" # 任務輸出,目前僅支援"webhook", 和本地輸出"local"(輸出到螢幕,url="0", 輸出到rtsp,填寫rtsp地址) # (local 還可以輸出到本地文件,這個時候注意,文件可以是相對路徑,是相對這個mock_task.toml文件本身) [output] type = "local" # url = "../hilens_data_dir/mask_test_result.mp4" url = "rtsp://192.168.3.3:8554/outstream"

運行測試

bin/main.sh camera

小結

本次案例實踐口罩識別,通過本次案例的實踐對於開發板的使用有了進一步了解,同時也體會到了這個開發板的便捷開發模式,非常值得推薦,希望後續可以體驗更多案例,真正落地實踐。

參考文獻:

- //developer.huaweicloud.com/develop/aigallery/article/detail?id=0163b46b-34fa-468d-b243-2ef067170d4a

- //modelbox-ai.com/modelbox-book/

- //developer.huaweicloud.com/develop/aigallery/article/detail?id=adc021cb-1c12-49a1-8a0b-f56ce6fb3b25