微軟發布史上最大語言模型Turing-NLG:170億參數量

- 2020 年 2 月 20 日

- 筆記

本文轉自"雷鋒網"

NVIDIA 的「威震天」現在只能屈居第二了。

文 | 周蕾

微軟AI&Research今天分享了有史以來最大的基於Transformer架構的語言生成模型Turing NLG(下文簡稱為T-NLG),並開源了一個名為DeepSpeed的深度學習庫,以簡化對大型模型的分散式培訓。

基於Transformer的架構,意味著該模型可以生成單詞來完成開放式文本任務。除了完成未完成的句子外,它還可以生成對輸入文檔的問題和摘要的直接答案。

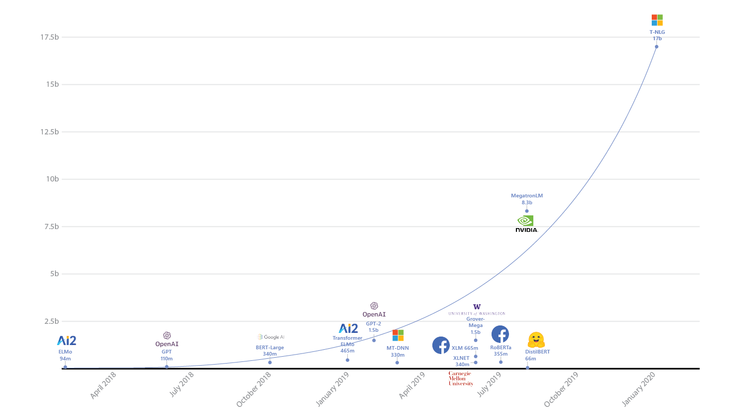

去年8月,NVIDIA 曾宣布已訓練世界上最大的基於Transformer的語言模型,當時該模型使用了83億個參數,比BERT大24倍,比OpenAI的GPT-2大5倍。

而此次微軟所分享的模型,T-NLG的參數為170億個,是NVIDIA 的Megatron(現在是第二大Transformer模型)的兩倍,其參數是OpenAI的GPT-2的十倍。微軟表示,T-NLG在各種語言建模基準上均優於最新技術,並在應用於許多實際任務(包括總結和問題解答)時表現出色。

不過,像Google的Meena一樣,最初使用GPT-2,T-NLG最初只能在私人演示中共享。

微軟AI研究應用科學家Corby Rosset在部落格文章中寫道:「除了通過匯總文檔和電子郵件來節省用戶時間之外,T-NLG還可以通過為作者提供寫作幫助,並回答讀者可能對文檔提出的問題,由此來增強Microsoft Office套件的使用體驗。」

具有Transformer架構的語言生成模型可以預測下一個單詞。它們可用於編寫故事,以完整的句子生成答案以及總結文本。

微軟表示,他們的目標是在任何情況下都能夠像人類一樣直接,準確,流暢地做出響應:以前,問題解答和摘要系統依賴於從文檔中提取現有內容,這些內容可以作為備用答案或摘要,但它們通常看起來不自然或不連貫。使用T-NLG這樣的自然語言生成模型,可以自然地總結或回答有關個人文檔或電子郵件主題的問題。

來自AI領域的專家告訴VentureBeat,2019年是NLP模型開創性的一年——使用Transformer架構無疑是2019年最大的機器學習趨勢之一,這導致了語言生成領域和GLUE基準測試領導者的進步,Facebook的RoBERTa、Google的XLNet和微軟的MT-DNN都紛紛加入到各類基準測試榜首的爭奪當中。

同樣是在今天,微軟還開源了一個名為DeepSpeed的深度學習庫。該學習庫已針對開發人員進行了優化,以提供低延遲、高吞吐量的推理。

DeepSpeed包含零冗餘優化器(ZeRO),用於大規模訓練具有1億個或更多參數的模型,微軟過去曾用它訓練T-NLG。

微軟表示,DeepSpeed和ZeRO使得他們能夠降低模型並行度(從16降低到4),將每個節點的批處理大小增加四倍,並將訓練時間減少了三分之二;DeepSpeed使用更少的GPU可以使大型模型的訓練效率更高。

開發人員和機器學習從業人員都可以使用DeepSpeed和ZeRO,因為培訓大型網路(例如利用Transformer架構的網路)可能會很昂貴,並且可能會遇到大規模問題。

另外,Google的DeepMind今天也發布了一種新的遠程記憶體模型Compressive Transformer,以及一種針對書本級語言建模的新基準PG19。

相關論文:https://www.microsoft.com/en-us/research/blog/turing-nlg-a-17-billion-parameter-language-model-by-microsoft/

github:https://github.com/microsoft/DeepSpeed

* 凡來源非註明「機器學習演算法與Python學習原創」的所有作品均為轉載稿件,其目的在於促進資訊交流,並不代表本公眾號贊同其觀點或對其內容真實性負責。