《Nature》最新研究:大腦中存在分散式強化學習機制

- 2020 年 2 月 13 日

- 筆記

作者 | DeepMind

編譯 | AI 科技評論

編者按:人工智慧與神經科學/腦科學之間存在剪不斷理還亂的關係。從人工智慧誕生之初,其研究就深受神經科學的影響,包括人工神經網路、強化學習等諸多演算法;最近較火的類腦計算,更是提出「brain-inspire」的想法。然而,我們常聽,人工智慧研究受神經科學/腦科學啟發;那麼,神經科學/腦科學的研究能否受人工智慧研究的啟發呢? DeepMind最近發表在《Nature》上的文章正是這樣的的典範,在分散式強化學習的啟發下,他們研究了小鼠多巴胺細胞的生理機制,發現大腦中同樣在使用「分散式強化學習」。這樣的研究,一方面促進了神經科學的發展,另一方面也驗證了AI研究走在正確的道路上。

學習和動機是由內、外部獎勵所驅動的。我們的許多日常行為都以預測或預測給定的行動是否會帶來積極的(即有益的)結果為指導。

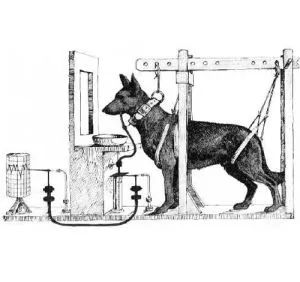

巴浦洛夫在他最著名的實驗中,訓練狗在鈴聲響起後會產生期待食物的反應,這些狗在食物到達之前聽到聲音就開始流唾液,這表明它們已經學會了預測獎勵。在最初的實驗中,巴甫洛夫通過測量它們產生的唾液量來估計它們的期望。不過最近幾十年中,科學家們開始破譯大腦如何學習這些期望的內部運作方式。

與神經科學家的研究同時,電腦科學家們也在人工系統中不斷地開發強化學習的演算法,這些演算法使AI系統不需要外部指導(而是由獎勵預測指導)即可學習複雜的策略。

DeepMind近期發表在Nature上的一項新的工作是,受電腦科學最新的研究(對強化學習演算法的重大改進)啟發,他們為大腦中獎勵學習的一些以前無法解釋的特徵提供了一個深刻而簡約的解釋,並由此開闢了研究大腦多巴胺系統的新途徑。可謂是人工智慧研究反哺神經科學/腦科學的典範。

預測鏈:時間差分學習

強化學習是人工智慧與神經科學結合形成的最為「古老」且強大的思想,早在80年代末就已經出現。當時的電腦科學研究人員試圖設計一種演算法,把獎勵和懲罰作為回饋訊號融入到機器的學習過程,目的是讓機器能夠自動執行複雜的行為。獎勵行為可以強化機器的行為,但是要解決一個特定的問題,即必須了解當前機器的行為如何帶來未來的回報;為了預測某項行為帶來的未來的總回報,通常有必要對未來採取許多措施。

時間差分演算法(TD)的出現為解決獎勵預測問題找到額突破口,TD使用一種數學技巧,通過一個非常簡單的學習過程代替對未來的複雜推理,還能得到相同的結果。簡單的說,TD演算法並不計算所能得到的未來的總回報,而是僅僅預測即時獎勵以及下一步驟所能獲得的獎勵。 然後,當下一刻出現新資訊時,將新的預測與預期的進行比較。如果它們不同,則演算法會計算出它們之間的差異,並使用此「時間差分」將舊的預測調整為新的預測。不斷調整,使期望與現實相匹配,從而使整個預測鏈逐漸變得更加準確。

大約在20世紀80年代末和90年代初,神經科學家研究了多巴胺神經元的行為,並發現此神經元的放電和獎勵有某種關係,而且這種關係依賴於感覺輸入,並且如果研究目標(例如動物)在一項任務中變得更加有經驗,則這種關係也會發生改變。

20世紀90年代中期,有一批科學家同時對神經科學和人工智慧都非常精通。他們注意到:有一些多巴胺神經元的回饋意味著獎勵預測的錯誤,例如與訓練時的預期相比,當動物得到過多或過少的獎勵時,這些多巴胺就會放電發出訊號。這些科學家於是提出了大腦使用的TD演算法,即考慮多巴胺的回饋,並用於驅動學習。此後這種多巴胺獎勵預測誤差理論( reward prediction error theory of dopamine)在數千個實驗中得到驗證,並成為了神經科學中最成功的定量理論之一。

分散式強化學習

電腦科學家的腳步並未停留於此,自2013年以來,越來越多的研究人員開始關注深度強化學習,這種在強化學習中用深度神經網路來學習表示的演算法,能夠極為有效的解決複雜問題。

圖 1 :概率表示未來可能得到的獎勵,如上圖所示,紅色表示正向結果,綠色表示負向結果。

分布強化學習是其中的代表,它能讓強化學習發揮出更加優異的效果。在許多情況下(尤其是在現實世界中),特定動作所產生的未來獎勵具有隨機性。如上圖所示,圖中的「小人」並不知道是跨過缺口,還是掉進去,所以預測獎勵的概率分布圖形出現了兩個凸起:一個代表跌落;一個代表成功跨過。傳統的TD演算法採用的方式是預測未來獎勵的平均值,這顯然無法獲得獎勵分布的兩個峰值(凸起),這時候分布強化學習則可以預測到所有的可能性。

悲觀/樂觀預測譜

最簡單的分布強化學習演算法與標準TD密切想關,這種演算法也稱為分散式TD。兩者的區別是:標準TD演算法學習單個預測或者預測的期望值;而分散式TD則學習的是一組不同的預測,這組預測中的每一個都採用標準TD方法學習。但關鍵的因素是,每個預測器都會對其獎勵預測誤差應用不同的轉換。

圖 2:a:「悲觀的」細胞將放大負向獎勵或忽略正向獎勵,樂觀的細胞將放大正向獎勵或忽略負向獎勵;b:獎勵累積分布圖;c:獎勵的完整分布圖

如上圖a所示,當獎勵預測誤差為正時,一些預測器有選擇地「放大」或「加碼」獎勵預測誤差(RPE)。與獎勵分配的較高部分相對比,這種方法能夠讓預測器學習到一個更樂觀的獎勵預測。同樣如上圖所示,其他預測因子放大了它們的負獎勵預測誤差,因此學習更悲觀的預測。綜上所述,包含悲觀和樂觀獎勵的預測器能夠繪製完整的獎勵分布圖。

除了簡單之外,分散式強化學習的另一個好處是,與深度神經網路結合使用時,它會非常強大。在過去5年中,基於原始的深度強化學習DQN agent的演算法取得了很大進展,並且經常在Atari 2600遊戲的Atari-57基準測試集上進行評估。

圖 3:將經典的深度強化學習與分布強化學習進行對比,在Atari-57基準上的標準化得分中位數(Atari-57 human-normalised scores)

圖3比較了在相同基準下經過相同條件訓練和評估的多個標準RL和分散式RL演算法。分散式強化學習agent以藍色顯示,可以看出取得了顯著的提升。其中的三種演算法(QR-DQN,IQN和FQF)是我們一直在討論的分散式TD演算法的變體。

為什麼分布強化學習演算法如此有效?雖然這仍然還是一個活躍的研究課題,但其中一點則在於了解獎勵的分布情況會為神經網路提供更強的訊號,從而以一種對環境變化或策略變化更具魯棒性的方式來塑造其表示形式。

多巴胺中的分散式程式碼

由於分散式時間差分在人工神經網路中的功能如此強大,一個科學問題隨之出現:分散式時間差分能被應用到大腦中嗎?這就是驅動研究者開始這篇《Nature》論文工作的最初動機。

在這篇論文中,DeepMind與哈佛Uchida Lab 合作,分析了他們對小鼠多巴胺細胞的記錄。這些記錄記下了小鼠在一項任務中表現出的學習能力,在任務中,它們獲得了意料之外的大量的獎勵(如圖4 的彩圖所示):

圖4:在該任務中,小鼠被給予隨機確定、容積可變的水獎勵,容積從0.1ul到20ul不等(獎勵大小由擲骰子決定):(A)經典TD 模型下模擬的多巴胺細胞對7種不同獎勵大小的反應;(B)分散式TD 模型下,每一行點對應著一個多巴胺細胞,每一種顏色對應著不同的獎勵大小,顏色曲線表示數據的樣條插值。一個細胞的「反轉點」(細胞的獎勵預測誤差、放電率在0值處相交)就是特定細胞將獎勵「調」到的預期獎勵,例如,由於獎勵大小達到了細胞的期望,所以它的放電率與它的基準線率相比不多也不少;(C)實際多巴胺細胞對其中不同獎勵大小的反應,與分散式TD模型的預測非常接近。插圖展示了三個對正向和負向的獎勵預測誤差有不同的相對縮放比例的示例細胞。

研究者評估了多巴胺神經元的活動是與「標準的時間差分」還是與「分散式時間差分」更加一致。

如上所描述的,分散式時間差分依賴於一組不同的獎勵預測。因此,研究首要的問題便是,是否能夠在神經數據中找到這些真實多樣的獎勵預測。

在此前的工作中,研究者了解到多巴胺細胞會改變它們的放電率,來暗示出現了預測誤差,也就是說,當動物獲得了比它們的預期更多或更少的獎勵,就是發生了預測誤差。而當細胞獲得了與它的預測恰好相等的獎勵,預測誤差就為 0 ,從而其放電率也不會發生任何變化。

研究者為每個多巴胺細胞決定好不會改變它的基準線放電率的獎勵大小,對此研究者稱之為細胞的「反轉點」。他們希望能夠了解到,細胞與細胞之間的「反轉點」是否不同。

在圖4c中,作者展示了細胞之間的顯著差異,一些細胞預測的獎勵非常大,而另一些細胞預測的獎勵卻非常小。這些差異超出了預期從記錄中原有的隨機變異性,所看到的差異程度。

在分散式時間差分中,獎勵預測中的這些差異源自於正向或負向的獎勵預測誤差的選擇性放大。放大正向的獎勵預測誤差,會造成學習的獎勵預測更樂觀;而放大負向的獎勵預測誤差,則會帶來悲觀的獎勵預測。

所以研究者接下來測量了不同多巴胺細胞表現的不同正向和負向預測的相對放大程度。在細胞間,研究者發現了可靠然而卻無法用雜訊來解釋的多樣性。並且最關鍵的是,研究者發現,放大了正向獎勵預測誤差的相同的細胞,也有更高的反轉點(圖4c,右下角圖),也就是說,它們顯然將反轉點調整到了更高獎勵量的預期。

最後,分散式時間差分理論預測出,細胞之間不同的「反轉點」、不同的不對稱性應該一起對學到的獎勵分布編碼。所以最後一個問題就是,是否能夠基於多巴胺細胞的放電率對獎勵分布解碼。

圖5:多巴胺細胞作為一個群體,對學到的獎勵分布的形狀進行編碼:可以給予放電率對獎勵分布編碼,灰色的陰影區域是任務中遇到的真實的獎勵分布。每條淺藍色的軌跡都顯示了執行解碼過程的示例。深藍色表示的是淺藍色軌跡平均超出灰色區域的部分。

如圖5 所示,研究者發現僅使用多巴胺細胞的放電率,完全有可能重構一個獎勵分布(藍色軌跡),這與小鼠參與任務中的實際獎勵分布(灰色區域)非常接近。

這一重構依賴於將多巴胺細胞的放電率解譯為分布時間差分模型分布的獎勵預測誤差並進行推理以確定模型已經了解的分布。

總結

總結來說,研究者發現大腦中的每個多巴胺神經元都被調到了不同的積極或消極程度。要是它們是一個唱詩班,它們唱的並不是一個音符,而是在唱和聲,它們都像低音或女高音歌手一樣,有著各自始終如一的聲帶。

在人工強化學習系統中,這種多樣的調整,創造了更加豐富的訓練訊號,極大地加速了神經網路中的學習速度,研究者推斷大腦也會出於這種考量而去採用這種多樣的調整方式。

大腦中現存的分散式強化學習,對AI 和神經科學都有著非常有意思的影響。首先,這一發現驗證了分散式強化學習,讓我們更加堅信:AI 研究正走在正確的軌跡上,因為分散式強化學習演算法已經應用於我們認為最智慧的實體:大腦。

其次,它為神經科學提出了新問題,並為理解心理健康和動機提供了新的視角。如果一個人的大腦有選擇性地「傾聽」樂觀或悲觀的多巴胺神經元,會發生什麼?這會引起衝動或是抑鬱的情緒?大腦的優勢在於其強大的表示能力——所以,分散式學習到底是怎麼形成的這種強大的表示能力的呢?當動物學習了獎勵分布,又是如何在其下游使用這種表示?多巴胺細胞之間的各種正向表示,與大腦中已知的其他多樣性形式又有何關係呢?這些都有待進一步去探索。

我們希望能有更多的研究人員去提出並回答類似這樣的問題,從而來推動神經科學的進步,並反過來讓 AI 研究受益,形成一個良性的閉環!

via https://deepmind.com/blog/article/Dopamine-and-temporal-difference-learning-A-fruitful-relationship-between-neuroscience-and-AI

參考:https://www.nature.com/articles/s41586-019-1924-6

關注 「AI 科技評論」微信公眾號,回復「大腦中的分散式強化學習」,可下載本篇論文。