Python網路爬蟲實戰(五)批量下載B站收藏夾影片

- 2019 年 10 月 3 日

- 筆記

我們除了爬取文本資訊,有的時候還需要爬媒體資訊,比如影片圖片音樂等。就拿B站來說,我的收藏夾內的影片可能隨時會失效,所以把它們下載到本地是非常保險的一件事。

對於這種大量列表型的數據,可以猜測B站收藏夾的請求中,詳細的收藏詳細可能會是非同步載入的,因為這部分數據可能比較龐大。

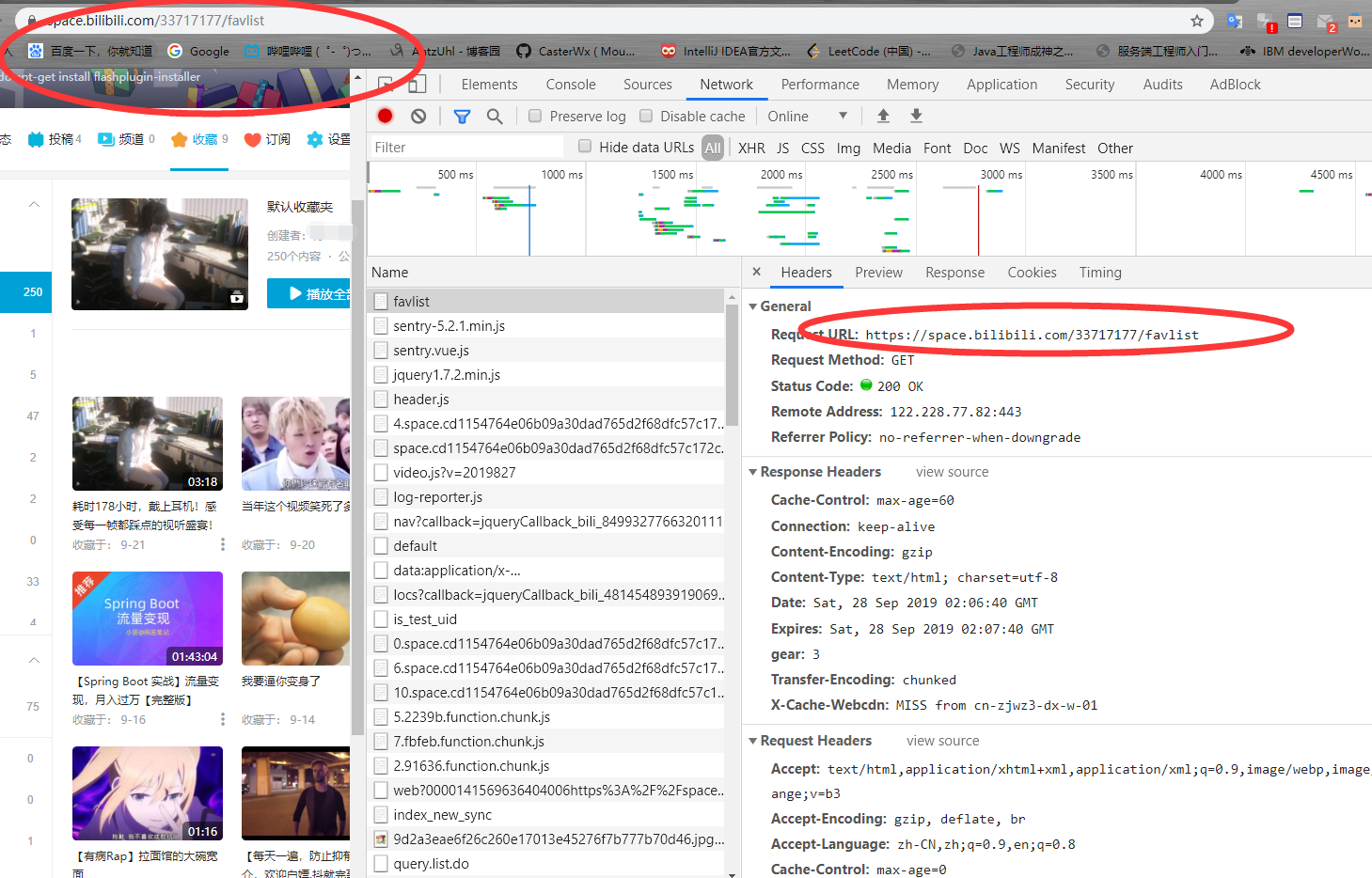

我們來分析一下網路請求。

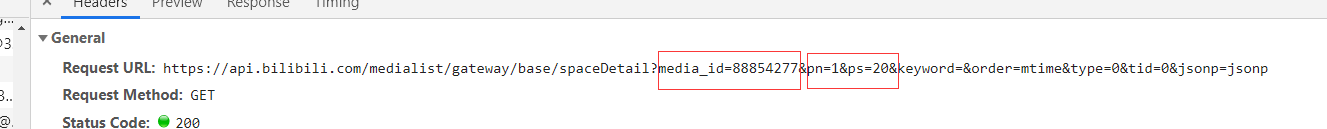

可以看到對收藏夾的請求是指定URL加收藏夾的id號,我們爬取的前提是這個收藏夾是公共收藏夾,不然是無法訪問的。

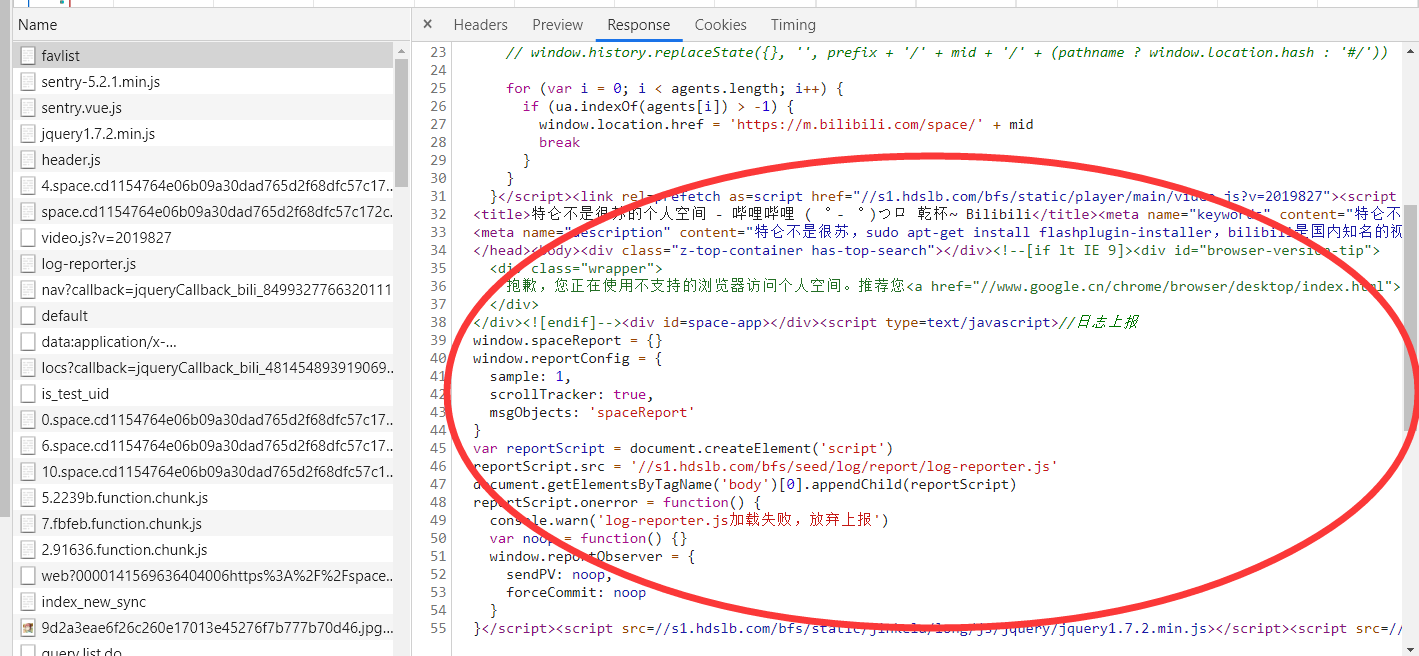

再來看他的返回,明顯沒有收藏影片的資訊,所以可以判斷收藏影片的資訊是通過api介面非同步載入的。

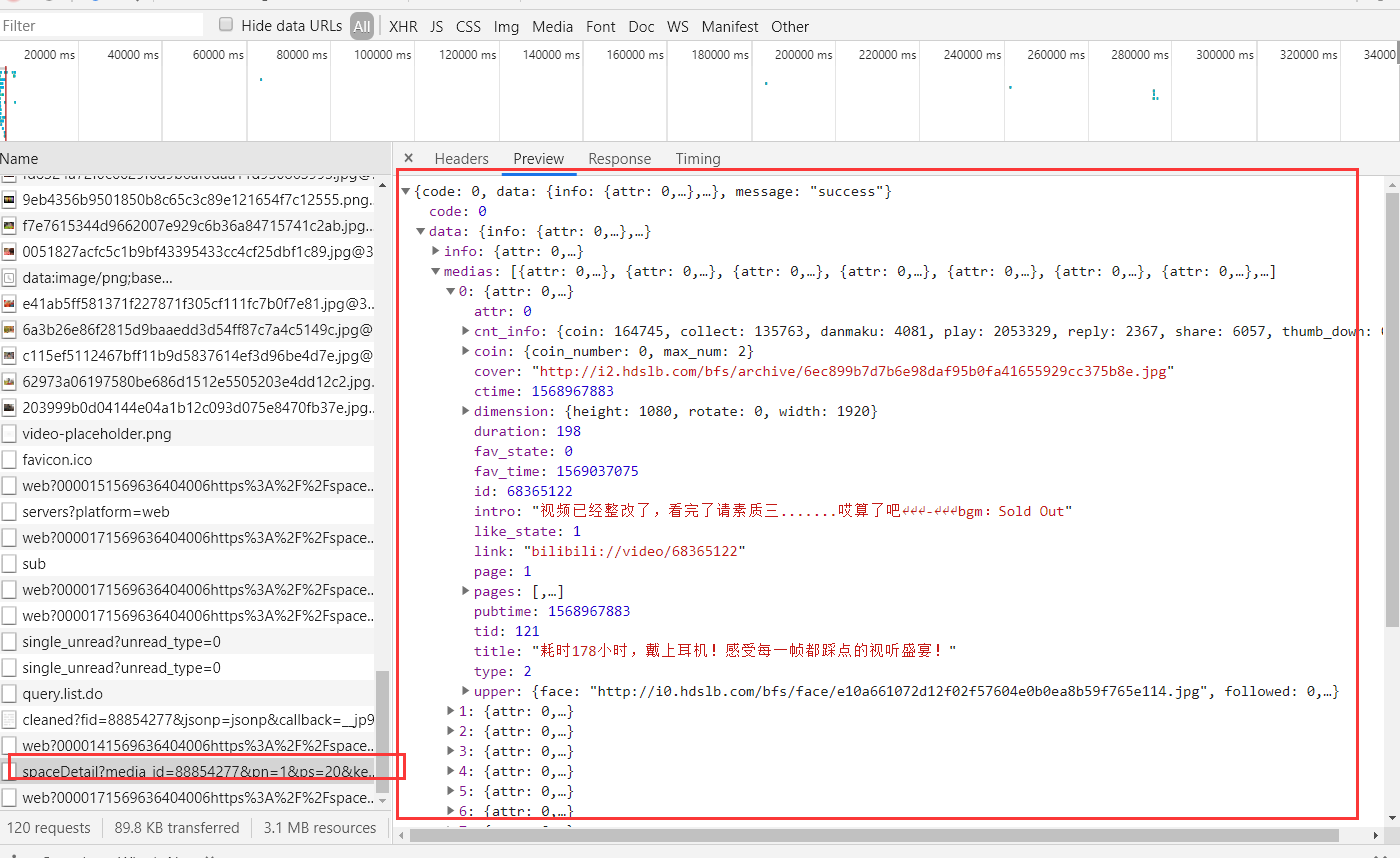

詳細查看一下其他的請求,你會發現這樣一條。

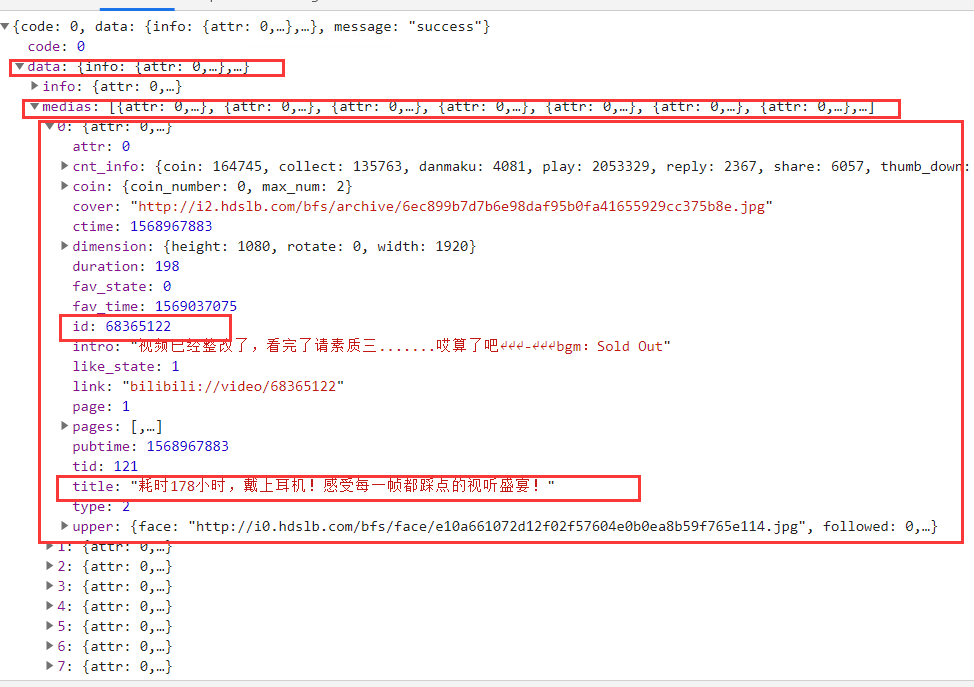

可以看到這裡返回了json數據,內容就是我們收藏夾中的影片,但是這裡這有20個,再來看請求的URL。

media_id是收藏夾的id號,pn是代表哪一分頁,ps是當前分頁中影片數量。

那麼我們就可以調用這個api來拿到所有收藏的影片了。

我們的影片分頁當然不可能只有一頁,所以我們可以遍歷pn遞增。

i = 1 while 1 : url = 'https://api.bilibili.com/medialist/gateway/base/spaceDetail?media_id=88854277&pn='+ str(i) +'&ps=20&keyword=&order=mtime&type=0&tid=0&jsonp=jsonp' html = requests.get(url) i = i + 1 print(html.text)這樣就能拿到一個收藏夾下所有影片了,當i超過收藏夾頁數時,直接異常退出即可。

接下來我們需要解析出每一個影片的id。

根據之前說的json解析,我們很容易就能用

res['data']['medias']來獲得所有的影片,然後再根據下標解析出每一個影片。

res = json.loads(html.text) len_video = len(res['data']['medias']) for id in range(0,len_video): create_thread(res['data']['medias'][id])這樣我們就可以獲取當前頁影片數量,然後創建執行緒進行下載了,因為下載是一個非常佔IO的事情,如果你單執行緒執行,下載一個影片再下載另一個,這樣會很慢,我們可以給每一個影片創建一個執行緒來提高速度。

def create_thread(res): thread = myThread(res['id'],res['title'],res['id']) thread.start()創建執行緒的執行緒號是影片的id號,執行緒名是影片名。

class myThread(threading.Thread): # 繼承父類threading.Thread def __init__(self, threadID, name, counter): threading.Thread.__init__(self) self.threadID = threadID self.name = name self.counter = counter def run(self): download_video(self.threadID)執行緒類如上,裡面有兩個函數,__init__是默認的執行緒初始化函數,裡面就是我們創建執行緒時傳入的id和name。第二個函數是執行緒執行時的run方法,也就是我們定義執行緒的具體要做的事,裡面只有一個download_video方法。

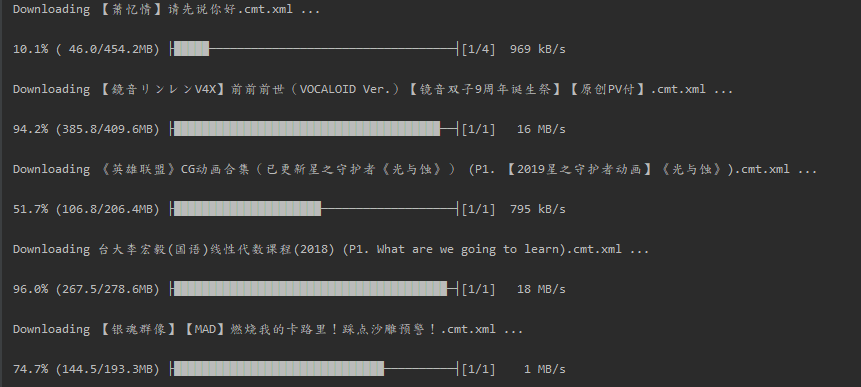

# 下載影片 def download_video(av_id): os.system('you-get -o d:/vedio/ https://www.bilibili.com/video/av'+str(av_id))在下載函數中,我們可以調用you-get來幫助我們解析下載影片(不要問為什麼調you-get,自己解析太麻煩了)。

這樣我們就完成了。

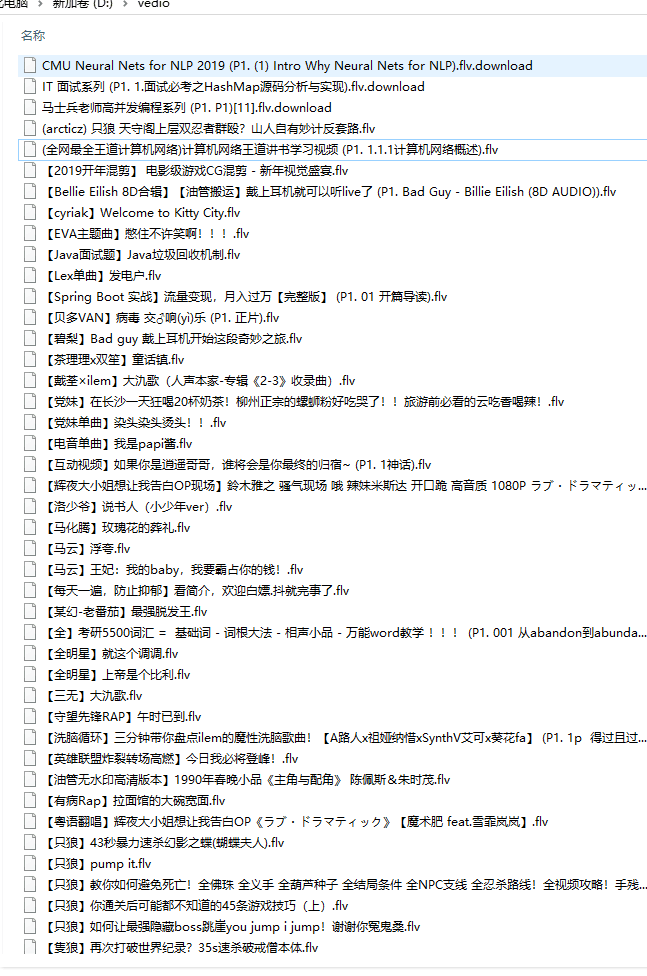

下載完成後: