周志華團隊:深度森林挑戰多標籤學習,9大數據集超越傳統方法

- 2019 年 11 月 22 日

- 筆記

本文授權轉載自:新智元 編輯:肖琴

【導讀】南京大學周志華團隊最新研究首次將深度森林引入到多標籤學習中,提出多標籤深度森林方法MLDF,在9個基準數據集上都實現了最佳的性能。

https://arxiv.org/abs/1911.06557

2017年,南京大學機器學習與數據挖掘研究所(簡稱LAMDA 團隊)的周志華教授與他的團隊,提出了「深度森林」(Deep forest):一種基於樹的方法,拓展了深度學習的體系。

在設置可類比的情況下,新方法 gcForest 取得了和深度神經網路相當甚至更好的結果,而且更容易訓練,小數據也能運行,更重要的是相比神經網路,基於樹的方法不會存在那麼困難的理論分析問題。

深度森林 gcForest 模型結構

周志華和馮霽在論文里寫道,「我們認為,要解決複雜的問題,學習模型也需要往深了去。然而,當前的深度模型全部都是神經網路。這篇論文展示了如何構建深度森林(deep forest),為在許多任務中使用深度神經網路之外的方法打開了一扇門」。

最近,周志華教授團隊再次拓展了深度森林的應用範圍,將深度森林方法用於多標籤學習(multi-label learning)。

在多標籤學習中,每個實例都與多個標籤相關聯,而關鍵的任務是如何在構建模型中利用標籤相關性(label correlation)。

深度神經網路方法通常將特徵資訊和標籤資訊一起嵌入到一個潛在空間中,以利用標籤的相關性。然而,這些方法的成功在很大程度上取決於對模型深度的精確選擇。

深度森林是一種基於樹模型集成的深度學習框架,它不依賴於反向傳播。周志華團隊認為,深度森林模型的優點非常適合解決多標籤問題。

因此,他們使用兩種機制設計了多標籤深度森林方法(Multi-Label Deep Forest MLDF):度量感知特性重用(measure-aware feature reuse)和度量感知層增長(measure-aware layer growth)。

MLDF同時處理兩個具有挑戰性的問題:一個是限制模型的複雜性以緩解過擬合問題;另一個是根據用戶需求優化性能指標,因為在多標籤評估任務中有許多不同的指標。

實驗結果表明,MLDF方法不僅在基準數據集上優於其他6種作為比較的方法,而且在多標記學習中具有標記相關性發現等特性。

周志華團隊首次將深度森林用於多標籤學習

在多標籤學習中,每個實例都同時與多個標籤相關聯,多標籤學習的任務是為未見過的實例預測一組相關標籤。多標籤學習被廣泛應用於文本分類、場景分類、功能基因組學、影片分類、化學品分類等多種問題。多標籤學習任務在現實問題中無所不在,吸引了越來越多的研究關注。

通過將多標籤學習問題轉化為每個標籤獨立的二元分類問題,即Binary Relevance 演算法[Tsoumakas and Katakis, 2007]是一種簡單的方法,已在實踐中得到廣泛應用。雖然它的目標是充分利用傳統的高性能單標籤分類器,但是當標籤空間較大時,會導致較高的計算成本。此外,這種方法忽略了一個標籤上的資訊可能有助於學習其他相關標籤的事實,從而限制了預測性能。研究標籤之間的相關性已被證明是提高多標籤學習性能的關鍵。因此,越來越多的多標籤學習方法旨在探索和利用標籤的相關性。在多標籤學習方法中,標籤相關性的探索和利用受到了相當多的關注。

與傳統的多標籤方法不同,深度神經網路模型通常嘗試學習一個新的特徵空間,並在頂部使用一個多標籤分類器。最早利用網路架構的是BP-MLL [Zhang and Zhou, 2006],它不僅將每個輸出節點視為一個二元分類任務,還利用了依賴於該架構本身的標籤相關性。隨後,在BP-MLL的基礎上, [Nam et al., 2014]提出一種比較簡單的神經網路方法,用熵損失代替 pairwise ranking損失,利用深度神經網路技術,在大規模文本分類中取得了良好的效果。然而,深度神經模型通常需要大量的訓練數據,因此通常不適合小規模的數據集。

南京大學周志華教授和馮霽認識到深度學習的本質在於逐層處理、模型內特徵轉換和足夠的模型複雜度,提出深度森林(Deep forest)[Zhou and Feng, 2018]。

深度森林是建立在決策樹之上的集成深度模型,在訓練過程中不使用反向傳播。具有級聯結構的深度森林集成系統能夠像深度神經模型一樣進行表示學習。深度森林更容易訓練,因為它的超參數更少。深度森林已經在大規模金融欺詐檢測、影像、文本重構等許多任務中取得了優異的性能。雖然深度森林在傳統的分類任務中已經被證明有用,但是在本工作之前,尚沒有人注意到將其應用於多標籤學習的潛力。

深度森林的成功主要來自於以集成方式進行的逐層特徵轉換。而另一方面,多標籤學習的關鍵是如何利用標籤相關性。受這兩個事實的啟發,我們提出了多標籤深度森林(MLDF)方法。

簡而言之,MLDF使用不同的多標籤樹方法作為深度森林的構建塊,並通過逐層表示學習來利用標籤相關性。

由於多標籤學習中的評估比傳統的分類任務更複雜,因此有多種性能度量方法[Schapire and Singer, 2000]。值得注意的是,不同的用戶有不同的需求,不同的演算法在不同的度量上的表現也不同。

為了在特定度量上獲得更好的性能,我們提出了兩種機制:度量感知特性重用(measure-aware feature reuse)和度量感知層增長(measure-aware layer growth)。

受置信度篩選啟發的度量感知特徵重用機制重用了前一層中的良好表示。度量感知層增長機制則旨在通過各種性能度量來控制模型的複雜性。

本文的主要貢獻總結如下:

- 我們首次將深度森林引入到多標籤學習中。由於提出了級聯結構和兩種measure-aware的機制,我們的MLDF方法可以處理兩個具有挑戰性的問題:根據用戶需求優化不同的性能指標,以及在利用大量層的特徵相關性時減少過擬合,過擬合常常在深度神經多標籤模型中發生。

- 我們的大量實驗表明,MLDF在9個基準數據集上都實現了最佳的性能,優於其他6種多標籤方法。此外,這兩種機制在MLDF中都是必要的。實驗結果表明,該演算法在應用各種基礎樹模型方面具有較高的靈活性和抗過擬合能力。

接下來,本文將介紹MLDF方法和兩種度量感知機制,並報告實驗的結果。

MLDF方法和框架:兩種機制,更好地利用標籤相關性

圖1展示了MLDF的框架。MLDF的每一層都集成了不同的多標籤森林(上方的黑色森林和下方的藍色森林)。由

,我們可以得到

表示。度量感知特徵重用部分將接收表示

,並在不同度量性能的指導下,通過重用

中學習到的表示

來更新

。然後,新的表示法

(藍色部分)將與原始的輸入特性(紅色部分)連接在一起,進入下一層。

圖1:多標籤深度深林(MLDF)的框架。每一層由兩組不同的森林組成(上方的黑色森林和下方的藍色森林)。

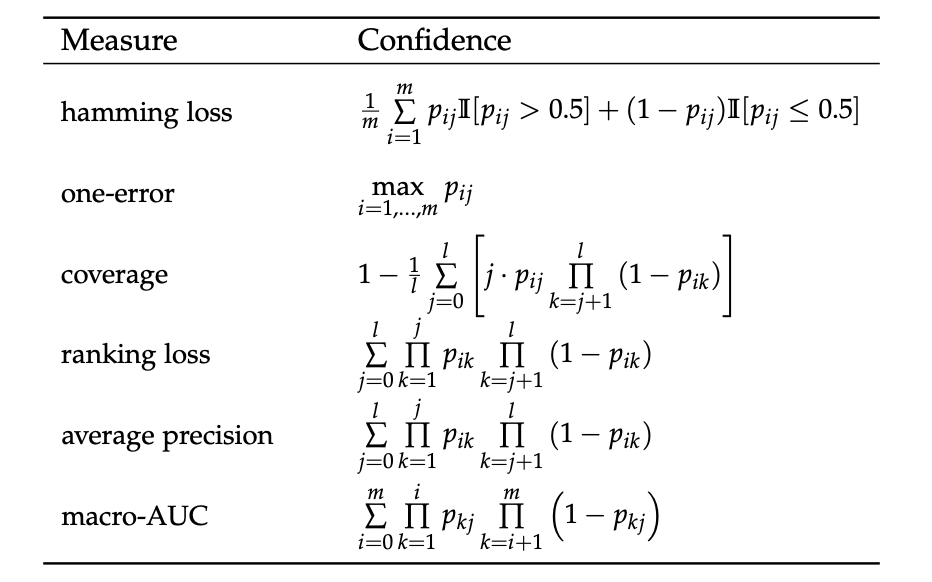

表2:六種多標籤度量的置信度計算方法。

在MLDF中,每一層都是森林的集合。為了提高集成的性能,我們考慮使用不同的樹生長方法來鼓勵多樣性,這是集成方法成功的關鍵[Zhou, 2012]。

在MLDF,我們採用RF-PCT [Kocev et al ., 2013)作為森林的block,以及兩種不同的方法在樹中生成節點以形成森林:一種方法考慮每個特性所有可能的分割點,即RF-PCT;另一種方法隨機考慮一個分割點,我們稱為ERF-PCT。

如前面所述,給定一個實例,森林將產生對標籤分布的估計值,可以將其視為屬於每個標籤的實例的置信度。在每一層中學習的表示將採用可度量的特性重用,並將原始輸入特性輸入到下一層。具有豐富標籤資訊的實值表示將被輸入到下一層,以便MLDF更好地利用標籤相關性。

預測過程可以總結如下。如圖1所示,假設森林已經很好地擬合了。首先,我們將實例預處理為標準矩陣X。其次,實例矩陣X通過第一層,得到表示H¹。通過度量感知特性的重用,我們可以得到G¹。然後我們將G¹與原始輸入特性X連接起來,並將它們放到下一層。在多層之後,我們得到了最終的預測。

演算法1總結了Measure-aware feature reuse的過程。

演算法1

演算法3總結了用於MLDF訓練的measure-aware layer growth的過程。

演算法3

實驗和結果:9大基準數據集實現最佳性能

本研究使用MLDF對不同的多標籤分類基準數據集進行了實驗。實驗的目標是驗證MLDF可以在不同的度量上獲得最佳的性能,並且兩種度量感知機制都是必要的。此外,我們還從各個方面通過更詳細的實驗展示了MLDF的優點。

數據集和配置

我們選擇了9個來自不同應用領域、不同規模的多標籤分類基準數據集。表3給出了這些數據集的基本統計資訊。

表3:數據集的域(Domain)、實例數量(m)、特徵數量(d)和標籤數量(l)

本文採用了在多標籤學習中廣泛使用的6種評估方法,分別是:hamming loss, one-error, coverage, ranking loss, average precision, 以及 macro-AUC [Wu and Zhou, 2017]。

表1:六種多標籤性能指標的定義:↓表示越低越好,↑表示越高越好。

性能比較

我們將MLDF與以下5種方法進行比較:

a) RF-PCT [Kocev et al., 2013],

b) DBPNN [Hinton and Salakhutdinov, 2006; Read et al., 2016],

c) MLFE [Zhang et al., 2018a],

d) RAKEL [Tsoumakas and Vlahavas, 2007]

e) ECC [Read et al., 2011].

我們對每個演算法進行了十次實驗。記錄10個訓練/測試試驗的平均值和標準偏差,以進行比較研究。表4給出了比較演算法的詳細實驗結果。

表4:9個數據集上每種比較方法的預測性能(均值±標準差)。•(◦)表明在95%顯著水平,MLDF明顯優於(差於)基於paired t-test 的比較方法。↓(↑)表示值越小(越大),性能越好。

實驗結果顯示,MLDF在每個評價指標上都達到了最佳(最低)的平均排名。在9個基準數據集中,所有評價指標中,MLDF在98.46%的案例中排名第一,在1.54%的案例中排名第二。

與這6項指標相比,MLDF分別在100.00%、96.29%、96.29%、100.00%、98.15%、100.00%的案例中排名第一。

總而言之,MLDF在各種評估方法的廣泛基準數據集上,與其他成熟的競爭方法相比,均取得了最佳的性能,這驗證了MLDF的有效性。

measure-aware feature reuse的影響

圖2顯示了在CAL500、yeast、corel16k-s1和corel16k-s2上使用該機制和不使用該機制的結果比較。

圖2:在CAL500、yeast、corel16k-s1和corel16k-s2上的性能比較。淺色的六邊形代表採用measure-aware feature reuse機制的MLDF的性能,深色的六邊形代表不採用該機制的MLDF的性能。面積越大,性能越好。

標籤相關性的利用

直觀地說,級聯結構使MLDF能夠利用標籤相關性。我們的分層方法通過在高層建模中使用低層標籤表示來逐步考慮更複雜的標籤相關性。

如圖4所示,標籤「Sunset」高度影響標籤「Leaf」,因為丟失一個標籤的資訊會嚴重影響另一個標籤的性能。此外,標籤「Beach」與標籤「Urban」高度相關,因為有時它們一起存在於場景數據集中。這表明,MLDF利用標籤之間的相關性來獲得更好的性能。

圖4:缺失的表示資訊對每個標籤的影響。場景數據集有6個標籤(從上到下,從左到右):「Beach", 「Leaf", 「Sunset", 「Field", 「Urban" 和 「Mountain」.