Dcoker-搭建日誌監控系統

項目中常用集中日誌收集工具

-

Logstash

Logstash是一個開源數據收集引擎,具有實時管道功能。Logstash可以動態地將來自不同數據源的數據統一起來,並將數據標準化到你所選擇的目的地。

-

優點

Logstash 主要的有點就是它的靈活性,主要因為它有很多插件,詳細的文檔以及直白的配置格式讓它可以在多種場景下應用。我們基本上可以在網上找到很多資源,幾乎可以處理任何問題。

-

缺點

Logstash 致命的問題是它的性能以及資源消耗(默認的堆大小是 1GB)。儘管它的性能在近幾年已經有很大提升,與它的替代者們相比還是要慢很多的。這裡有 Logstash 與 rsyslog 性能對比以及Logstash 與 filebeat 的性能對比。它在大數據量的情況下會是個問題。

-

Filebeat

作為 Beats 家族的一員,Filebeat 是一個輕量級的日誌傳輸工具,它的存在正彌補了 Logstash 的缺點:Filebeat 作為一個輕量級的日誌傳輸工具可以將日誌推送到中心 Logstash。

-

優點

Filebeat 只是一個二進制文件沒有任何依賴。它佔用資源極少,儘管它還十分年輕,正式因為它簡單,所以幾乎沒有什麼可以出錯的地方,所以它的可靠性還是很高的。它也為我們提供了很多可以調節的點,例如:它以何種方式搜索新的文件,以及當文件有一段時間沒有發生變化時,何時選擇關閉文件句柄。

-

缺點

Filebeat 的應用範圍十分有限,所以在某些場景下我們會碰到問題。例如,如果使用 Logstash 作為下游管道,我們同樣會遇到性能問題。正因為如此,Filebeat 的範圍在擴大。開始時,它只能將日誌發送到 Logstash 和 Elasticsearch,而現在它可以將日誌發送給 Kafka 和 Redis,在 5.x 版本中,它還具備過濾的能力。

-

Fluentd (Docker日誌驅動支持)

Fluentd 創建的初衷主要是儘可能的使用 JSON 作為日誌輸出,所以傳輸工具及其下游的傳輸線不需要猜測子字符串裏面各個字段的類型。這樣,它為幾乎所有的語言都提供庫,這也意味着,我們可以將它插入到我們自定義的程序中。

-

優點

和多數 Logstash 插件一樣,Fluentd 插件是用 Ruby 語言開發的非常易於編寫維護。所以它數量很多,幾乎所有的源和目標存儲都有插件(各個插件的成熟度也不太一樣)。這也意味這我們可以用 Fluentd 來串聯所有的東西。

-

缺點

因為在多數應用場景下,我們會通過 Fluentd 得到結構化的數據,它的靈活性並不好。但是我們仍然可以通過正則表達式,來解析非結構化的數據。儘管,性能在大多數場景下都很好,但它並不是***的,和 syslog-ng 一樣,它的緩衝只存在與輸出端,單線程核心以及 Ruby GIL 實現的插件意味着它大的節點下性能是受限的,不過,它的資源消耗在大多數場景下是可以接受的。對於小的或者嵌入式的設備,可能需要看看 Fluent Bit,它和 Fluentd 的關係與 Filebeat 和 Logstash 之間的關係類似。

使用Docker-Compose搭建EFK收集中心

-

創建docker-compose.yml

新建一個efk目錄,然後進入目錄下:

version: '3'

services:

web:

image: httpd

ports:

- "80:80"

links:

- fluentd

logging:

driver: "fluentd"

options:

fluentd-address: localhost:24224

tag: httpd.access

fluentd:

build: ./fluentd

volumes:

- ./fluentd/conf:/fluentd/etc

links:

- "elasticsearch"

ports:

- "24224:24224"

- "24224:24224/udp"

elasticsearch:

image: docker.elastic.co/elasticsearch/elasticsearch:7.10.2

environment:

- "discovery.type=single-node"

expose:

- "9200"

ports:

- "9200:9200"

kibana:

image: kibana:7.10.1

links:

- "elasticsearch"

ports:

- "5601:5601"

-

創建fluentd鏡像以及配置config與插件

新建 fluentd/Dockerfile

FROM fluent/fluentd:v1.12.0-debian-1.0

USER root

RUN ["gem", "install", "fluent-plugin-elasticsearch", "--no-document", "--version", "4.3.3"]

USER fluent

新建 fluentd/conf/fluent.conf

<source>

@type forward

port 24224

bind 0.0.0.0

</source>

<match *.**>

@type copy

<store>

@type elasticsearch

host elasticsearch

port 9200

logstash_format true

logstash_prefix fluentd

logstash_dateformat %Y%m%d

include_tag_key true

type_name access_log

tag_key @log_name

flush_interval 1s

</store>

<store>

@type stdout

</store>

</match>

-

啟動服務

docker-compose up

-

多次請求httpd服務生成日誌

$ curl localhost:80

- 驗證日誌收集

打開瀏覽器訪問//localhost:5601

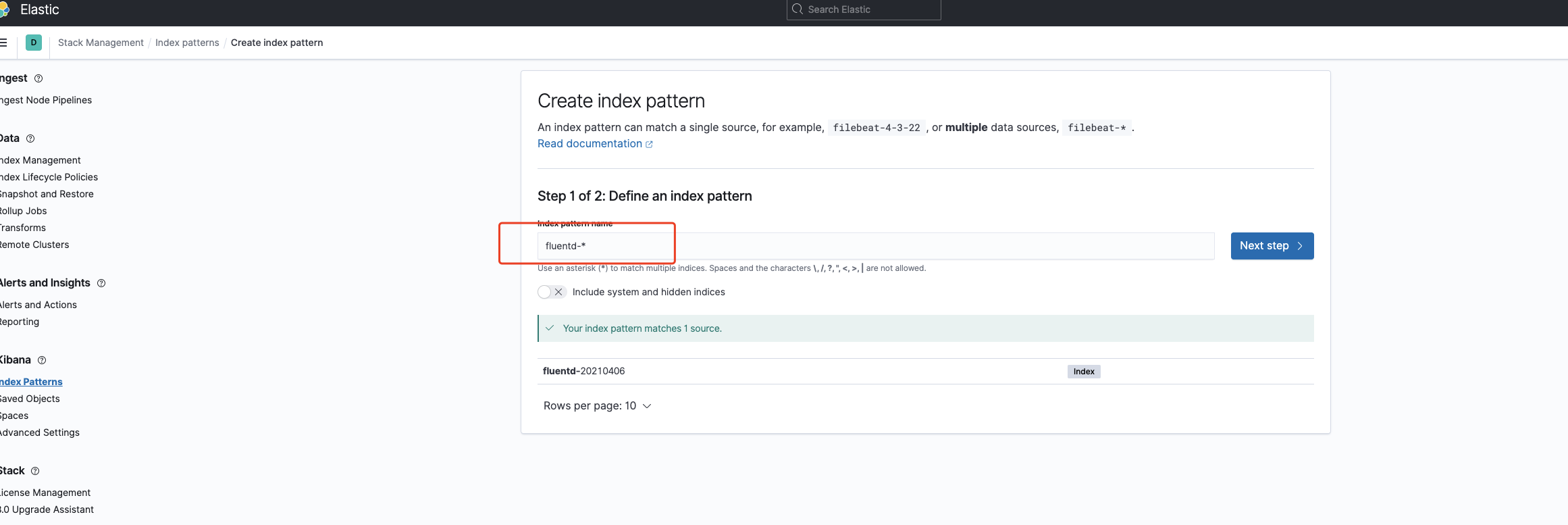

初始化創建fluentd-*索引

創建索引

創建索引

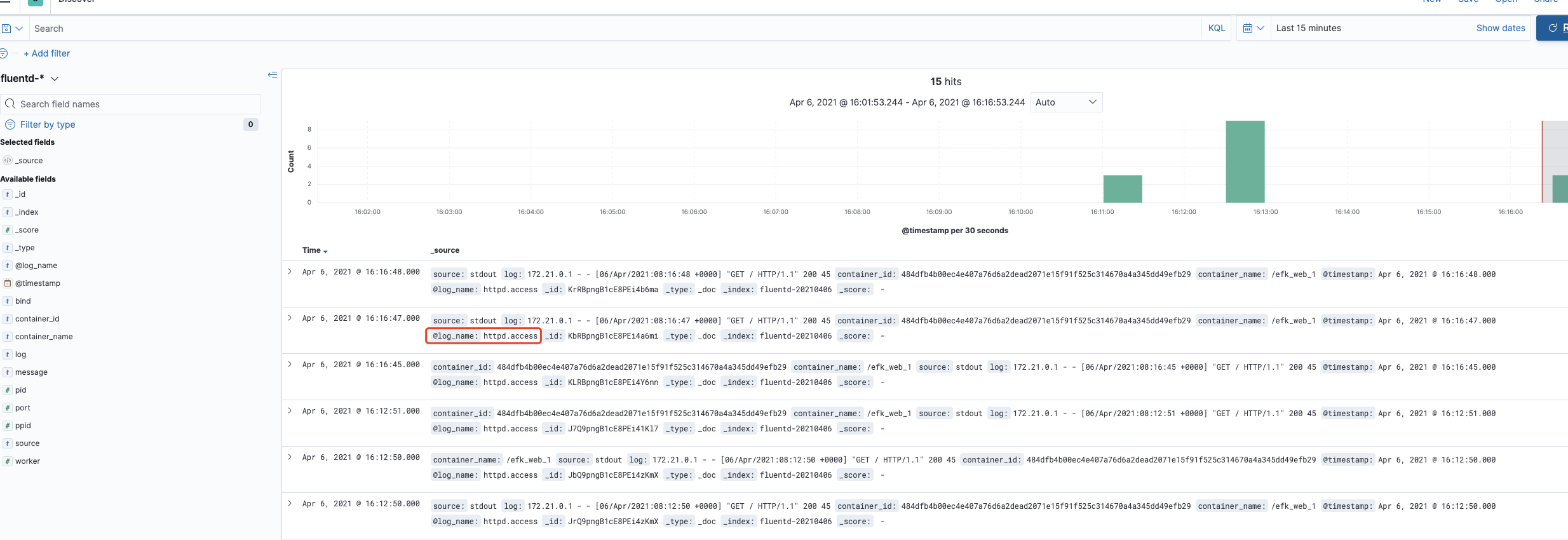

此時可以看到Httpd 生成的日誌已經被收集

log

log

使用fluentd收集關鍵點

- 如何指定fluentd驅動

-

修改daemon.json(全局)

"log-driver":"fluentd",

"log-opts":{

"fluentd-address":"192.168.0.133:24224"

}, -

單個容器

# 啟動增加

--fluentd-address=localhost:24224 --log-driver=fluentd

#注意:注意,此時如果fluentd服務掛了 服務啟動不起來的,可以在服務啟動時候 加上

--log-opt=fluentd-async-connect

結束

歡迎關注公眾號! 公眾號回復:

入群,掃碼加入我們交流群!