Improved Object Categorization and Detection Using Comparative Object Similarity

- 2019 年 11 月 3 日

- 筆記

版權聲明:本文為博主原創文章,遵循 CC 4.0 BY-SA 版權協議,轉載請附上原文出處鏈接和本聲明。

本文鏈接:https://blog.csdn.net/weixin_36670529/article/details/102813778

目錄

摘要

由於在現實世界中物體的固有長尾分佈,我們不太可能通過為每個類別提供許多視覺示例來訓練一個目標識別器/檢測器。我們必須在目標類別之間共享視覺知識,以便在很少或沒有訓練示例的情況下進行學習。在本文中,我們證明了局部目標相似信息(即類別對是相似的還是不同的)是一個非常有用的線索,可以將不同的類別聯繫在一起,從而實現有效的知識轉移。關鍵洞見:給定一組相似的目標類別和一組不同的類別,一個好的目標模型應該對來自相似類別的示例的響應比來自不同類別的示例的響應更強烈。為了利用這種依賴於類別的相似度正則化,我們開發了一個正則化的核機器算法來訓練訓練樣本很少或沒有訓練樣本的類別的核分類器。我們還採用了最先進的目標檢測器來編碼對象相似性約束。我們對來自Labelme數據集的數百個類別進行的實驗表明,我們的正則化內核分類器可以顯著改進目標分類。我們還在PASCAL VOC 2007基準數據集上評估了改進的目標檢測器。

1、簡介

警察視覺的例子。在某種程度上,我們能夠快速地學習經常能從一些新的目標類別中學習新目標的名稱,因為我們可以將它們與已知的相似目標聯繫起來。例如,很少有人知道「serval」是什麼,但當被告知它像美洲豹,但腿更長,身體更輕時,大多數人都能在圖片中認出它。「serval就像一隻美洲豹」是一種相似性語句,它根據現有的類別定義一個新的類別。在本文中,我們利用這種基於分類的相似度語句來學習目標模型,並且很少甚至沒有訓練實例。這是一個有趣的問題,因為在現實世界中,大多數目標類別只有很少的例子。在圖1中,我們顯示了Labelme數據集[30]的一部分中200個最頻繁的目標類別的實例數量,按遞減順序排列。我們可以看到分佈是很長尾的。對於大多數類別,我們找不到足夠的數據來訓練可靠的分類器。我們必須將信息從具有多個實例的對象類別轉移到具有較少實例的類別。要傳遞信息,我們必須首先知道應該使用什麼類別來傳遞信息。在這方面,相似性是一個很好的線索,正如人類所使用的。

為了在學習一個新類別的模型(例如「serval」)時利用對象相似性進行計算,我們首先從人類的標籤器中獲得一個類似類別的簡短列表;這將包含「豹」。我們可以用這些「豹」的圖像作為正面的例子來訓練模型。但這種策略並不吸引人,因為這兩種類型並不相同。更糟糕的是,對於許多類別來說,可能沒有任何東西是非常相似的:我們的標籤將「燈」和「花」標記為與「吊扇」相似的。「這些類別非常相似,很有幫助,但又如此不同,我們無法將它們混合在一起。由於目標目標類與其相似類別之間的不確定親密度,我們認為被標記為相似類別的類與目標目標的相似度要大於與其他類別的相似度。為簡單起見,從現在開始,我們將這些不太相似的類別稱為「不同的類別」。我們的方法在學習過程中使用相似約束作為正則化的一種形式。我們要求所學習的目標模型對相似類別的例子比不同類別的例子反應更強烈。例如,為了學習「serval」模型,我們獲得了一些類似的類別(如「leopard」)和一些不同的類別(如「grass」和「bird」)。然後我們要求模型對「豹」的例子比「草」和「鳥」的例子反應更強烈。這個過程作為一個依賴於分類的相似度調整器。

我們首先在內核機器框架中應用這種機制。我們強制內核機器分類器對來自相似類別的示例給出比來自不同類別的示例更高的響應。這個過程通常涉及成千上萬個「相似-不同」的例子。使用直方圖相交內核,我們可以使用之前開發的算法SIKMA的變體有效地學習內核機器。我們在數百個目標類別上評估我們的方法,其中許多甚至根本沒有訓練示例。我們證明,這樣做可以顯着地提高硬分類任務的性能。目標檢測是[36]、[5]、[10]等另一個重要的研究課題,其目的是利用雜亂圖像中的包圍盒對目標實例進行定位。由於目標模型的複雜性,訓練一個目標檢測系統需要大量的實例。為了在較少訓練樣本的情況下進行檢測,我們採用了最先進的目標檢測系統[10]來編碼目標相似性約束。類似地,我們強制目標檢測器對來自類似類別的實例的響應比來自不同類別的實例的響應更強烈。當訓練實例很少的時候,這個過程是有幫助的。我們在一個基準數據集(PASCAL VOC 2007數據集[7])上評估了我們的方法,該數據集被廣泛認為是一個具有挑戰性的目標檢測數據集。當有20個訓練實例時,我們的方法始終優於[10]。當有50個積極的實例時,我們仍然可以看到某些類別的改進。本文是已發表的會議論文[38]的較長版本,該論文僅應用比較目標相似性來訓練用於目標分類任務的內核分類器。在本文中,我們還採用了一種最先進的目標檢測器來檢測目標實例,並且使用了相同的機制,只有很少的訓練實例(參見第3.2節)。

2、相關工作

很少或沒有訓練實例的分類/檢測受到的關注比較少。Miller等人的開創性工作,[25]通過一個訓練實例,有效地將測試數據與其他類別定義的模型相對應,從而學習一個新的目標類別。Fei-Fei et al.[9]利用了目標模型之間具有強先驗相似性的趨勢。Bart和Ullman[3]通過使用已經學過的課程的經驗,從一個訓練示例中學習一個新的課程。我們的工作與這些論文的不同之處在於,我們使用對象相似性將不同的對象類別聯繫在一起,從而實現有效的知識遷移。

最近,有幾篇論文[8]、[20]提出使用屬性作為中間表示來跨目標類別共享信息。屬性是指目標的屬性,如「furry」、「has legs」等。我們可以從普通目標中學習屬性分類器,並將其應用於訓練實例較少的新目標識別中。屬性也可以用來描述新的目標,即使它們不能被成功識別。Kumar等人使用學習屬性分類器進行人臉驗證。這裡的屬性更具體地指與面孔相關的視覺屬性,如「鼻子大小」、「鼻子形狀」、「髮型」等。Wang和Forsyth[37]共同學習屬性和目標檢測器,不需要任何訓練實例就可以識別「屬性目標」對。Palatucci等人的[27]在神經活動解碼中應用了一個有趣的想法,其目標是通過觀察一個人的神經活動的圖像來確定一個人正在思考的單詞或物體。在這個應用場景中,很難收集英語中每個可能的單詞的神經訓練圖像,因此他們定義了一個語義輸出代碼分類器的概念,該分類器利用所有類別的語義屬性的知識庫。屬性與相似性平行,都是可以將不同類別聯繫起來的中間表示。兩者可以進一步集成,以更好地表示具有現有目標類別的新對象。更多的討論可以在第5節中找到。

相似度信息通常用於學習距離度量。在這裡,我們測量特徵空間中與一定距離的相似度,調整特徵權值,使目標更接近於同一類別的目標,而不同於不同類別的目標[12]、[42]、[41];類似的程序可以應用於度量不是[16]的相似性的度量。這些方法不能使用顯式的類間信息;他們只是要求同類的例子彼此相似。在沒有類別標籤的情況下,可以使用數據相關的平滑度度量來對特徵[11]進行加權。在每種情況下,結果都是一個全局相似度過程——調整度量以與所有可用的相似度信息一致。

另一種全局相似度過程使用多維標度(MDS)來獲得與所有相似度數據一致的嵌入。有令人信服的證據表明,這是人類相似性判斷[35]的一個糟糕模型(例如,人類的判斷是不對稱的)。相似度判斷可能彼此不一致或與新信息不一致(例如,「一輛車就像一輛麵包車」;「麵包車就像巴士」;「巴士像火車」並不意味着「汽車像火車」)。MDS通過尋找與所有語句一致的最佳全局嵌入來解決這個問題。該方法對於許多類別也不實用,因為我們不期望有非常詳細的兩兩相似的信息。與這些方法不同的是,我們的方法可以利用局部相似性語句。我們的工作也與[17]、[43]、[23]、[14]、[13]等主要由信息檢索社區開發的「學習排序」相關。目標是根據訓練數據自動構建一個排名模型,訓練數據通常由項目列表組成,每個列表中的項目之間指定了部分順序。本文根據知識轉移的目標相似性對不同的目標類別進行排序,而不是對單個文檔進行排序。從某種意義上說,我們學習的目標模型可以被看作是排序模型。

3、具有比較相似性的學習目標模型

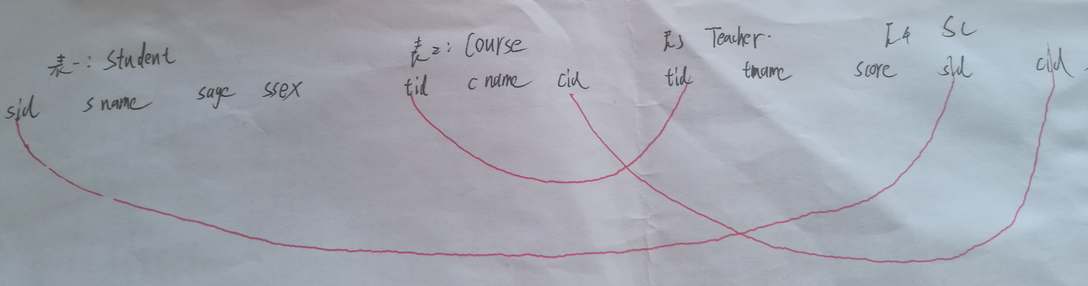

我們的目標是學習識別/檢測命名目標的模型。我們對目標目標的訓練很少或正樣本,但有很多負樣本。一些否定的範疇被人類的標籤識別為「相似的」或「不相似的」。相似注釋的例子如表1所示。核機和經過區別訓練的基於部件的目標模型[10]分別被廣泛地用於識別和檢測圖像中的目標實例。我們採用這兩種方法來編碼比較目標相似度約束,從一些例子中學習。

3.1、結合比較目標相似性來訓練內核機器進行分類

在本節中,我們將學習用於分類的每個名稱的目標模型F。使用一個內核機器分類器,遵循[44]、[22]。核模型分類器F可以寫為

,其中

是核的基函數。但其他一些內核,如RBF核也可以適用),xi是第i個支持向量,i是權值。在訓練過程中,我們從特徵表示的T訓練實例中學習F,同時學習ground truth類標籤

。

不包含目標相似度信息的通常方法是通過最小化來學習F

其中H是hinge loss

是一個正則化項。所有可能的假設是假定形成再生核希爾伯特空間,其中

。以這種方式準確地學習F需要大量的實例。當只有少數正樣本時,學習的分類器可能不是健壯的。那麼,如何在有限的正訓練實例的情況下,在給定相似和不相似的實例的情況下,實現魯棒的目標模型呢?我們認為,一個好的目標模型會對任何正樣本作出強烈的反應,但也會對相似的例子比不同的例子作出更強烈的反應。這使得該問題具有序數特徵——我們的方法應該把相似的例子排在比不相似的例子更高的位置,而不是像一個序數支持向量機。序數SVM試圖學習函數h(x)這樣

任何一雙例子

。但是,我們並沒有對所有的示例進行完整的排序,我們只想對類別進行排序。因此,我們不能使用傳統的序數支持向量機。

我們的模型F應該:對正樣本是正的,對負樣本是負的,對於相似的樣本比不相似的實例大。前兩個要求很容易用hinge loss來表示。第三,如果

是一個實例的相似類別和

是一個實例從一個不同的類別,

應該總是大於

,有一些優勢。我們通過準備一組N個相似-不相似的對來施加這個約束,並評分

,其中L是鉸鏈損耗,但其他一些損耗函數也可以適用。這是一個正則化術語。可能有很多對。如果有很多積極的例子,那麼相似度約束就不那麼重要了,但是如果例子很少,那麼它就是一個重要的約束。這意味着這個相似項的權重應該取決於Tp的正例子的數量。我們選擇F來最小化

第一項是目標類別的經驗損失,第二項是相似約束(也被認為是正則化項),第三項是常規正則化項。

表示體重相似的函數積極訓練實例的數量。一般來說,如果有一些正面例子,

應該大,如果有很多,應該是小的。因此,我們

設置為一個函數的輸出,在輸入Tp的情況下:

相似項權重參數設置的探討。通常,多重線索的權重是使用交叉驗證設置的。但是我們有很少的正面的例子和很多的分類,使得交叉驗證無效並且計算上很昂貴。相反,我們假設參數應該主要依賴於訓練示例的數量,並設置適用於各種類別的參數。在我們的實現中,A、B和C是通過對有足夠訓練示例的5個類別進行驗證來選擇的。然後,他們是固定的,並適用於所有其他類別的訓練例子很少。最後我們使用參數如下:A=0:5,B=0:1,和C=0.25。圖2顯示了

變化在不同數量的訓練例子Tp下的趨勢。

從(2)中學習F涉及到大量的相似和不同的例子對。使用傳統的基於批處理的算法[29]訓練可能非常慢。隨機梯度下降法是一種學習大規模數據集[32]、[18]、[40]和[21]的有效方法。與傳統的梯度下降算法不同的是,該方法在每次迭代中只使用數據點的子集來近似計算梯度,並採取步驟。大量的實驗結果表明,與基於批處理的算法相比,[32]、[18]、[40]和[21]可以獲得非常接近的性能,同時也要快得多。在我們的實現中,在每個迭代中,我們只選擇一個數據點(這裡,一個相似-不同的示例對被視為一個數據點)來計算梯度。算法為:在第i次迭代時,隨機選擇一個數據點:1。如果選擇帶標籤的示例xt,則按照[40]的步驟進行;新的目標函數是

次梯度是

其中

然後F更新為

如果選擇了一個類似-不同的配對

,則該配對的新目標函數

為

子梯度

是

其中

並且更新為

我們使用K的直方圖相交核,允許我們使用[40]的快速訓練算法而不犧牲準確性。

3.2、結合比較目標相似性來訓練基於部件的目標模型進行檢測

上一節介紹了一種採用內核機器進行對象分類的方法。目標檢測的目的是預測雜亂圖像中目標實例的邊界框,通常也需要大量的訓練數據。本節介紹一種結合目標相似信息來訓練基於部件的目標檢測器的方法。我們採用最先進的檢測系統[10]來編碼目標相似性約束。為了方便讀者,這裡簡要介紹了該方法。在Felzenszwalb等人的過程[10]中,將目標類別建模為具有模型參數

的星形結構的基於部件的模型。測試實例

的評分為

Z Z表示所有可能的對象配置,指定一個配置,

表示HOG的連接特性,從圖像中提取好子窗口定義的z和部分變形特性。通過最小化目標函數,訓練該潛結構模型:

其中

是第i個訓練例子的類標籤,L是Hinge Loss。這個公式不同於標準的支持向量機,因為它有一個潛在的結構。一個潛在的支持向量機導致一個非凸優化問題,成為凸一旦潛結構指定為積極的例子。在[10]中,採用「坐標下降」方法來學習模型參數。在每一輪中,首先在每幅正圖像中選擇對當前模型響應最強烈的最佳潛結構,然後利用指定的潛結構求解凸優化問題。由於複雜的模型結構和大量的模型參數,使用(11)學習目標模型通常需要許多訓練實例。許多目標類別只有一些可用的訓練示例。同樣,為了對相似約束進行編碼,我們需要一個目標模型對來自相似類別的示例的響應比來自不同類別的示例的響應更強烈。

假設我們也有來自相似和不同類別的例子,除了積極的和消極的訓練例子。寫

作為兩個例子,其中

來自一個類似的類別,而

來自一個不同的類別。然後,

應該大於

,並有一個邊界。我們得到如下優化函數:

第二項懲罰了模型對相似的例子的反應比不相似的例子更強烈的失敗;同樣,我們用鉸鏈損耗來表示這一項。如式(3)所示。當正例數量較大時,為小;當正面例子的數量很少的時候,就是很大的時候。

3.2.1、訓練

該方法的一個吸引人的特性是,將其合併到現有的Felzenswzalb等人的檢測器代碼中是非常簡單的。我們修改他們的「坐標下降」程序來優化(12),得到:

1. 為每一個積極的例子,找到得分最高的潛在結構:

。在相似度約束條件下,利用相同的思想,得到了

和

的最佳潛在結構。

2. 修正潛在結構z,通過求解凸優化問題優化

。在[10]中,我們採用了隨機梯度下降法,這樣我們就可以很容易地修改他們的代碼來訓練我們的探測器。這裡描述的過程也非常類似於3.1.1節中描述的過程。在第一步之後,我們有

在梯度下降法中,(12)的梯度計算為

在隨機梯度下降法中,梯度(13)是通過一個樣本子集(可以是正/負,也可以是相似/不相似對)來計算的,並且在每次迭代中向負方向邁出一步。我們按照[10]設置參數。[10]的所有其他重要實現組件,如特徵提取、數據挖掘示例和後處理,都可以在不做任何更改的情況下使用。對於每個類別,我們訓練一個包含兩個混合成分的混合模型。我們像在[10]中那樣翻轉每個積極的訓練示例,但是相似-不相似的對沒有被翻轉。

4、實驗

提出了兩種利用目標相似性進行分類和檢測的方法。在本節中,我們將評估它們在基準數據集上的性能,並將它們與兩種基線方法進行比較。注意,在每個實驗中,我們評估的是二元分類,而不是多類分類。

4.1、目標類的實驗

4.1.1、實驗設置

我們從Labelme[30]數據集中選擇了2,831張圖像作為分類實驗的試驗台。它們是真實的街道和室內圖像,它們的區域被充分注釋。我們正在進行分類而不是檢測,因此我們使用ground truth多邊形注釋來裁剪目標,並在這些乾淨的對象區域上執行實驗(用於訓練和測試)。目標檢測的實驗結果見4.2節。我們通過糾正拼錯的單詞、刪除非名詞單詞(如「a」)、傳遞給最常見的名詞(如用「person」代替「行人」)來手動重命名目標名稱。這樣總共剩下972個目標類別。如圖1所示,數據集中目標類別的分佈是重長尾的(這在現實世界中也被懷疑是正確的)。大約600個類別有不到6個實例。只有70個類別有超過100個實例。我們隨機選取1500張圖像作為訓練數據,另外1331張圖像作為測試數據。我們選擇90個目標類別作為原型類別,它們有60多個實例。帶有少量示例的類別不被視為原型類別。我們最後有225個測試類別,每個類別至少有一個測試實例。對於每個類別,一名人類志願者從原型類別中識別出多達5個相似的目標,而不需要查看數據集中的任何圖像。在此標記過程中,要求注釋器在視覺上標記相似和不同的目標。沒有額外的說明哪方面(如形狀或紋理)應該用來判斷相似性。第二名志願者檢查了相似度標註,將相似度判斷分為四種情況:同義(如「海灘岩石」和原型「岩石」)、近義(如「工作檯面」);「吧台」),不同的(例如,「鳥」;「旗子」——標籤上的字讓人覺得它在天空中飄動,但又非常不同(例如,「吊扇」;「花」)。表1顯示了更多關於相似性注釋的例子。當訓練一個目標模型時,所有其他類都是負的。在測試過程中,我們對每個測試圖像區域進行分類,並輸出一個分類分數。計算每個類的AUC值。在本實驗中,我們直接使用測試圖像的地面真值分割來提取目標區域。共有21,803個測試區域。

4.1.2、特徵選擇和參數

我們密集地從每個目標區域提取補丁,並將每個補丁表示為SIFT描述符。我們對描述符子集進行了抽樣,並形成一個包含800個可視單詞的可視詞彙表。我們使用這些可視化單詞的直方圖作為特徵表示。在訓練過程中,我們使用了大約20,000個負樣本和20,000對相似-不同的例子來學習每個目標模型。iþ1100 The 學習 速率 i 設置 , 並 將 0.00005.訓練一個對象模型通常需要50-120秒,非常快。學習率

設置為

,

設置為0.00005。訓練一個對象模型通常需要50-120秒,非常快。

4.1.3、Baseline

我們用兩個基線來比較我們的算法。基線1以通常的方式使用所有可用的正樣本和負樣本。如果沒有正樣本,則輸出一個隨機猜測。我們稱這個基線為「無相似信息」,縮寫為「無相似」。「基線2直接使用來自類似類別的實例作為積極的例子(用類似形式(3)定義的權重進行加權)來訓練目標模型。我們稱之為基線」類似的類別作為積極的類別,縮寫為

。對於這個基線,分類器是通過以下學習目標函數:

其中

表示第n個相似圖像的特徵表示。該基線使用相同的相似度信息,但其性能不如我們的比較相似度方法,如下面的實驗研究所示。

4.1.4、AUC類似的提升

如果我們給出一個正樣本和一個負樣本的方法,接收機工作曲線下的面積(AUC)給出了正例得分高於反例的概率。AUC是一種很好的性能度量方法,適用於命名這樣的任務。我們不使用標準的AUC,而是採用一個平衡的AUC,其中每個測試實例都被N1加權(N是來自相同類別的測試實例的總數)。這可以更好地衡量所學習的模型與所有其他類別的對比情況,而不是與一些非常常見的類別的對比情況。我們的相似度方法對所有測試類別的AUC都有很大的改進,尤其是在沒有陽性樣本的情況下(見圖3)。AP是一個不太有用的測量方法,因為正樣本很少,大約有20,000個負樣本,因此,所有的分數都非常小且不穩定。圖4也給出了一些定性結果。我們的方法獲得了更好的AUC值,並將更敏感的區域排列在頂部。我們的方法可以達到非常高的AUC分數在許多類別,即使他們沒有訓練的例子。圖5顯示了AUC值超過一組AUC閾值的類別數(來自110個沒有訓練樣本的類別)。超過40個類別的AUC值高於0.9。

這種效果並不完全是由標籤中的同義詞造成的。我們根據最強相似的原型(最強:與最弱同義:非常不同)來分類。總的來說,有53個類別至少有一個同義相似的原型,70個類別至少有一個近義相似的原型而沒有更強的,90個類別至少有一個不同的相似原型而沒有更強的,12個類別只有非常不同的相似原型。我們在圖6中顯示了每種類型的平均AUC分數。我們可以看到,即使相似的原型充其量是「不同的」或「非常不同的」,使用相似度也會產生更好的AUC。我們還展示了我們的方法在基線1之上的平均AUC改進,作為表2中訓練實例數量的函數。我們可以觀察到,當積極訓練的例子較少時,比較相似是最有幫助的。當正例數量增加時,使用比較相似度得到的結果很少。我們的示例中類似的類的數量從1到3個不等,只有很少的幾個類別擁有更多的類。我們研究了相似類數對AUC改善的影響,但未發現有影響。我們認為,重要的是標記相似的類別的質量,而不是相似類別的數量。

4.1.5、相似度可以提高通信

AUC的改進對於發現區域和弱標記對象名稱[1]之間的對應關係非常有幫助。我們從225個測試類別中選擇了197張包含至少三個區域的圖片。它們的標籤是弱標記的,這意味着我們不知道哪個標籤指向哪個區域。我們的任務是用所學的模型建立對應關係。我們使用最大權值二分匹配(使用匈牙利算法[28])解決對應問題,其中權值由校準的分類分數給出。匹配的結果是區域標籤。我們計算每個類的匹配精度。為了避免大類別的影響,取平均值進行比較(見表3),定性結果如圖7所示。在圖8中,我們通過訓練實例的數量來顯示類別的平均精度值。我們的方法在沒有或只有很少的訓練實例的情況下對類別進行了很大的改進。

4.2、檢測實驗

4.2.1、實驗設置

我們在一個目標檢測任務上評估了我們提出的檢測方法(參見3.2節),該任務的目標是預測圖像中對象實例的邊界框(如果有的話)。我們採用PASCAL VOC 2007 comp3 challenge protocol[7]:在測試中,我們預測邊界框及其置信值,並為每個類別繪製精確回憶曲線。AP(平均精度)值據此計算作為性能度量。只有當預測邊界框與地面真實邊界框重疊超過50%時,才認為它們是正確的。對於相似詞的重量,我們設置一個A=0.5,B=0.1,和C=25日一樣的用於分類。

我們使用相同的特性實現[10]和參數,如支持向量機成本參數。我們的方法最好應用於訓練不熟悉目標的目標檢測器,因為我們找不到足夠的訓練實例。但是,目前還沒有為此任務建立基準數據集。因此,我們在PASCAL VOC 2007數據集[7]上對我們的系統進行了評估。該數據集有20個類別,每個目標類別通常有幾百個訓練實例和幾百個測試實例。為了測試我們的方法在訓練過程中訓練實例很少的情況下如何提供幫助,我們只使用一個子集(例如,20個正例)來訓練檢測器,而不是使用所有的訓練集。注意,訓練集上的所有負面圖像都被使用了。為了獲得穩定的測試性能數據,我們使用了所有的測試數據。與評估分類性能的方法類似,我們將檢測算法與兩個基線進行比較:無相似信息和相似類別為正類別。在訓練子集選擇過程中,我們隨機選擇一定數量(如20個)的正訓練樣本,重複5次,計算平均值進行比較。當使用我們的方法訓練目標模型時,如果我們枚舉它們中的每一個,可能會有太多的相似對。相反,每次我們都為每個目標對隨機抽取500個示例對。這通常總共會產生大約5000個示例對(取決於使用了多少個類似-不同的目標對)。PASCAL VOC 2007數據集有20個類別,但其中有8個類別我們無法在同一數據集中找到類似的類別(如「人」和「瓶」)。一種解決方案是從其他更大的數據集(如Labelme[30])獲得類似的類別。在本文中,我們簡單地忽略了這八個類別,只測試了剩下的12個類別,它們有足夠的類別來評估我們的方法的性能。表4列出了這12個對象類別及其相似性注釋。

4.2.2、性能比較

我們首先使用20個積極的訓練實例,將我們的方法與表4中列出的12個目標類別中的兩個基線進行比較。訓練一個目標檢測器通常需要一天的時間,因為有成千上萬個相似-不同的樣本對。在測試過程中,我們選擇了一個較低的閾值,以確保為每個測試圖像保留足夠的邊界框(通常為100個)。使用20個正樣本中,比較表5中每個類別的結果(AP分數)。使用相似度可以持續提高AP分數。我們的方法比直接把類似的類別加到積極的類別上效果更好。我們還使用表6中的30個和50個積極的訓練示例將我們的方法與基線進行了比較。根據sigmoid函數,將相似項的權值分別設置為0.23和0.04。我們也嘗試了所有積極的訓練例子。通過更多積極的訓練例子,表現會更好。當有少量的正面訓練例子時,相似性更有幫助。

討論什麼時候比較相似是有幫助的:表2和表6都表明,當積極的例子很少時,比較目標相似性是有幫助的。但是,當正例數量增加時,比較目標相似度甚至會降低性能。這可以通過偏差-方差[4]理論來解釋:相似性約束做出了不完美的假設。它們會產生額外的約束,從而減少參數估計的方差,但是它們會引入偏差。當真正的訓練實例的數量增加時,減少方差的好處就減少了,而偏差仍然存在。這就是為什麼在足夠多的訓練實例中觀察到較低或沒有增益的原因。只有當減少方差的收益大於引入偏差的損失時,比較相似性才有幫助。臨界點依賴於特徵空間中數據點的分佈和特定的相似性約束。在圖9中,我們在右側顯示了由基線1(沒有相似性)和我們的方法生成的頂級區域。使用相似度將更多的真值為正的區域排列在頂部。圖10顯示了「馬」和「摩托車」的假陽性最嚴重區域。不足為奇的是,使用相似約束訓練的檢測器會從相似的類別中發現誤報區域。但是請注意,利用來自相似和不同類別的信息有助於檢測器對背景區域有更強的辨別能力(可以看到基線檢測器在背景中找到許多錯誤的區域)。在圖11中,我們使用與基線1相比的相似度(沒有相似度信息)來顯示真正的測試區域,這些區域的等級提升最為顯著。當使用基線檢測器測試時,這些區域的置信度較低,排名較低;當使用我們的方法訓練的檢測器時,它們獲得更高的信心分數,並且在所有預測的邊界框中都有很高的排名。使用相似度約束會有所幫助,因為會使用更多相關的信息。例如,一些公交區域看起來像火車。當使用火車作為類似目標類別來訓練總線檢測器時,使用我們的方法,它們的級別會更高。

5、結論和討論

在本文中,我們提出了一種使用比較目標相似度來幫助學習目標模型的方法。我們採用最先進的分類和檢測系統,以納入目標相似性約束。但是請注意,該模型是完全通用的,可以應用於各種各樣的問題。實驗結果表明,該方法在對數百個類別的識別上取得了顯著的改進,訓練樣本很少或沒有訓練樣本。對於目標檢測,我們提出的方法在使用少量正訓練示例(通常為20個)的情況下,對基準檢測數據集PASCAL VOC 2007進行了改進。將來可以做一些工作來更好地利用目標相似性進行可視化分類。目前,所有的相似度約束都被同等考慮。然而,一些約束應該包含更有價值的信息。例如,「a cat is like a dog」比「a cat is like a sheep」更有用。「我們將考慮從更高質量的相似度約束中為示例對分配更大的權重。

另一種可能的擴展是整合相似度和屬性[8]、[20]、[37],以實現更強大的知識轉移。在某種意義上,目標被認為是相似的,因為它們具有共同的視覺屬性。例如,貓和狗很相似,因為它們都有「腿」和「尾巴」,而且都「有毛」。「如果我們知道什麼屬性使兩個目標類別相似,那麼我們就可以構建一個機制,只傳輸與這些指定屬性相對應的視覺知識。這將減少知識轉移過程中的噪音,並導致更有效的共享。屬性的一個有趣屬性是它們可以用來描述一個新的目標類。例如,「serval是毛茸茸的,有腿。「然而,腿有很多種,比如貓腿、豹腿,甚至桌子腿。這些腿可能很不一樣。僅僅說「有腿」還不足以準確地描述它,而且也沒有可用的分類法以細粒度的方式定義不同的腿。當添加了相似度信息後,我們可以說一個動物的腿類似於美洲豹的腿。這樣,相似性可以極大地增強屬性的描述能力。當使用相似度時,學習的目標模型可能會將目標類別與相似類別混淆,因為來自相似類別的信息是共享的。如圖10所示,在檢測摩托車時,許多單車實例都排在前面。一種解決方案是如上所述指定共享屬性;然後我們可以使用其他屬性來消除歧義。另一個可能的解決方案是使用分類法[2]、[33]或使用場景來劃分類別:對象是在廚房還是在公園中找到的?對於每個目標類,我們只需要訓練一個與來自相同分區的類別相反的模型。然後我們可以從其他分區中選擇類似的類別,以避免混淆。