論文閱讀:Multi-task Learning for Multi-modal Emotion Recognition and Sentiment Analysis

- 2020 年 9 月 13 日

- 筆記

- Multi-Modal, Paper-Reading, 多模態

論文標題:Multi-task Learning for Multi-modal Emotion Recognition and Sentiment Analysis

論文鏈接://arxiv.org/abs/1905.05812

文章同時使用視覺、語音、和文本(語言)信息進行情感分析,通過增加視覺和語音信號,補足了一些無法通過文本來進行判斷的情況,例如下圖中,第一句話需要圖像才能判斷為負面情緒,第二句話同時語音和圖像才能判斷為負面情緒。

一、模型架構

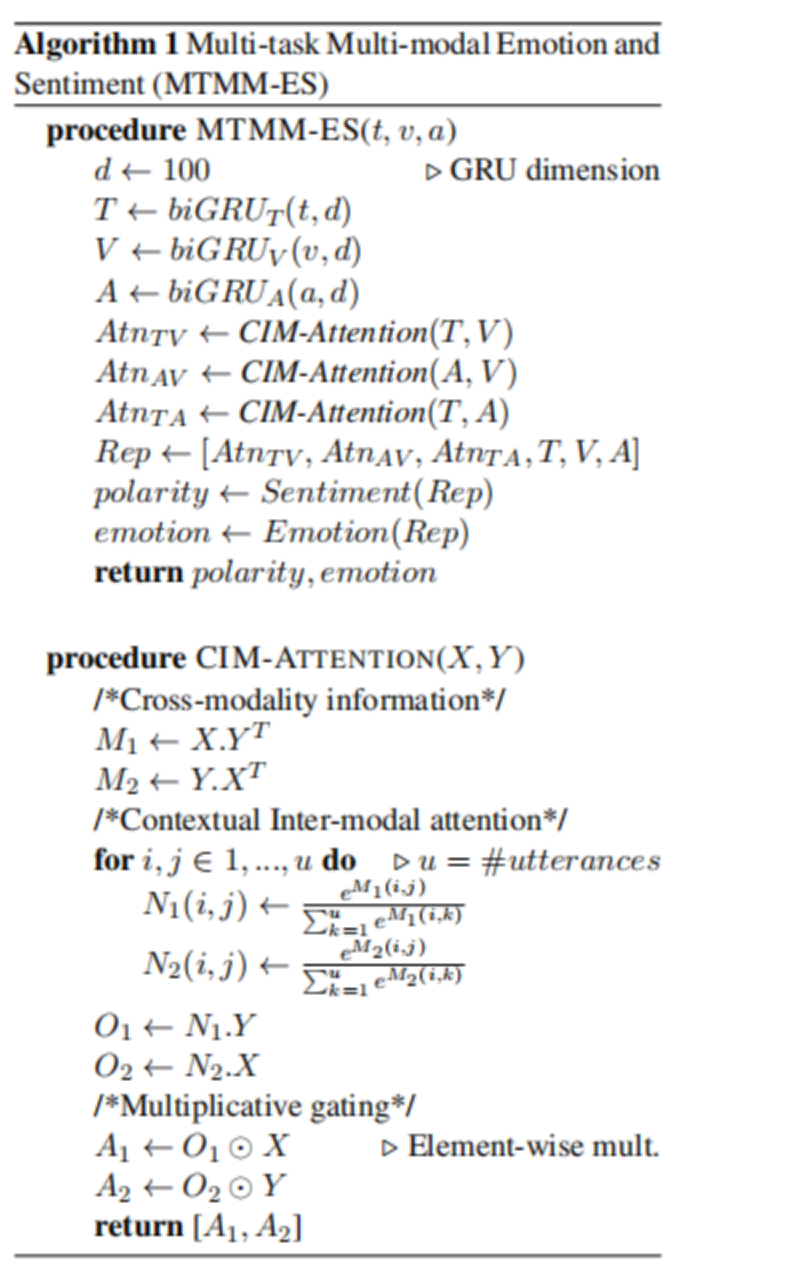

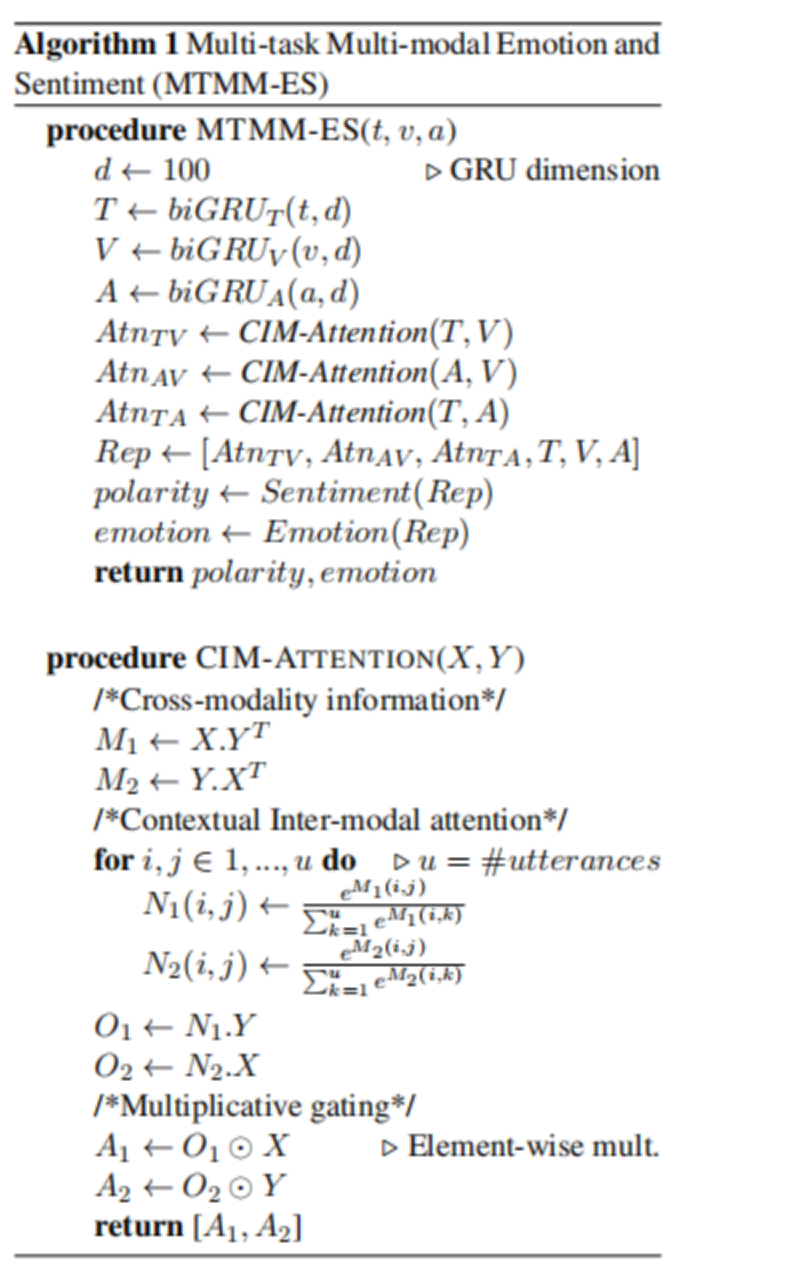

模型整體思路

- 1.首先,每一個模態的信息都會通過一個bi-directional GRU ,雙向GRU可以有效的表徵單一模態內部的相互關係。

- 2.得到的表徵 A V T 需要通過本文提出的CIM 注意力機制去獲得倆倆模態之間的互注意力( AV , AT, VT ),通過這個步驟可以獲取到對模型分類最重要的信息。

- 3.將獲得的注意力和 單模態特徵 A V T進行拼接,得到最終表徵。

- 4.將表徵鏈接最後的分類層,進行分類任務。

CIM注意力機制( Contextual Inter-modal (CIM) Attention

Framework )

本文主要的特色是提出了CIM注意力方法,來提取模態間的互注意力,篩選出關鍵的信息,思路如下:

- 1.通過兩個表徵矩陣互相乘積得到跨模態信息M1,M2(可以理解為,一個模態中,每一個維度的信息和另外一個模態的所有維度信息做點積操作,可以得到兩個模態之間的關係表徵,類似於通過外積進行模態融合的bilinear pooling 操作)

- 2.通過soft-attention得到注意力分佈N1,N2,在通過與特徵進行乘積得到最終的注意力表徵信息O1和O2。 這裡的N1[ i , j ] 表示的是第一個模態第 i 個特徵 與 第二個模態 第 j 個特徵相關性,值越大,說明這個特徵跟另外一個特徵的交互性越強,也就越重要,所以O1 和 O2 得到的就是對 互注意力 貢獻最大的特徵的維度信息

- 3.通過注意力表徵O1,O2與特徵相乘得到最終的注意力特徵A1,A2,這裡使用的是乘法過濾機制,用過注意力表徵和特徵相乘,得到最終的經過過濾的特徵。

二、數據集 CMU-MOSEI

全稱: CMU Multi-modal Opinion Sentiment and Emotion Intensity (CMU-MOSEI)

總共包含 3,229 個視頻片段,總共有23,000個句子,來自於1,000 個 youtueb視頻 。

其中Training Set:16216,Validation Set : 1835 Test Set : 4625

每個樣本對應六個標籤:anger, disgust, fear, happy, sad and surprise,具體統計如下圖Table2 所示

文章中還測試了多標籤分類任務,其中關於數據集多標籤的統計入下圖Table3 所示

三、結果

單模態下,語言模態效果最好,雙模態下,語言+視覺 效果最好,總體而言三個模態效果最好,但是不明顯。

多標籤分類的效果整體上都領先於單標籤分類

主要原因是多標籤可以捕獲更多的信息,來幫助模型進行判斷

與已有模型對比也取得了很好的效果