『王霸之路』从0.1到2.0一文看尽TensorFlow奋斗史

- 2019 年 10 月 3 日

- 筆記

0 序篇

2015年11月,Google正式发布了Tensorflow的白皮书并开源TensorFlow 0.1 版本。

2017年02月,Tensorflow正式发布了1.0.0版本,同时也标志着稳定版的诞生。

2019年10月,TensorFlow在经历七个多月(2019年3月1日-2019年10月1日)的 2.0 Alpha 版本的更新迭代后发布 2.0 正式版。

2.0 正式版官方介绍视频

https://v.qq.com/x/page/b3003v2g8dq.html

虽然 2.0 正式版才刚刚发布,就已经引起了学术界与科研界广泛关注与好评:

- Google深度学习科学家以及Keras的作者表示,TensorFlow 2.0 是一个新时代的机器学习平台,这将改变了一切。

- 深度学习研究和教育者、fast.ai创始人Jeremy Howard也称赞 2.0 版本的发布是”令人兴奋的一步,与TensorFlow一代相比是一个巨大的飞跃“。

- 目前GitHub上排名第一的NLP机器学习课程practicalAI的作者以及苹果公司AI研究员Goku Mohandas在推特上说,他们正在从PyTorch转向TensorFlow 2.0。

为什么TensorFlow 2.0 的发布能够引发了广泛的讨论和关注?下面笔者通过对于TensorFlow“奋斗史”介绍与解读来分析TensorFlow如何成就的王霸之路。

TensorFlow的“奋斗史”包括三个章节:锋芒初露(0.1),中原逐鹿(1.0),王者归来(2.0)。

1 锋芒初露·源起

在2011年,Google Brain内部孵化出一个项目叫做DistBelief,它是为深度神经网络构建的一个机器学习系统。虽然这个著名的系统并没有开源,但是Google研究者有大量关于它设计的论文被大家所熟知,它也被广泛应用于Google内部的科研和商业产品中。这个项目最早可以追溯到2009年,由Geoffery Hinton带领的团队开发的一个实现了广义反向传播算法的框架,基于这个框架,Google内部可以快速试验新的深度学习算法并提高算法精度。比如在使用这套框架后,Google内部语音识别的错误率降低了25%。

后来,Google决定将DistBelief打造成更加稳健、快速、通用的机器学习框架,调动了相当多的工程师和科学家投入到对DistBelief的改造,这其中就包括大名鼎鼎的Jeff Dean。有了这样的豪华开发阵容,DistBelief迅速成熟蜕变,成为一个高鲁棒和工业级的机器学习框架,这就是后来于2015年11月发布的TensorFlow 0.1 版。

虽然相较于较早开源的Caffe、MXNet等优秀的机器学习框架,TensorFlow还略显年轻,但是作为Google内部的第二代机器学习框架,TensorFlow有了更加有趣的灵魂。相较于侧重于卷积的Caffe与刚从校园走出来的MXNet,TensorFlow以更加成熟完备的姿态展露锋芒。它是基于DataFlow的计算模型,算子相组合形成一个计算图,计算的过程就是数据在这个计算图的节点进行计算并流动。同时,这个计算图可以被切成不同的子图,并分配到不同的Device上,包括CPU、GPU和其他的计算设备,这样天然地对分布式友好。此外,TensorFlow从一开始就被设计成运行在多个平台上,如inference可以运行在iOS和Android设备上,训练则可以运行在不同的硬件设备上。

2016年4月14日,Google发布了分布式TensorFlow,版本号为 0.8,这是TensorFlow发布之后的比较重大的版本更新。Google的博文介绍了TensorFlow在图像分类的任务中,在100个GPUs和不到65小时的训练时间下,达到了78%的正确率。在激烈的商业竞争中,更快的训练速度是人工企业的核心竞争力。而分布式TensorFlow意味着它能够真正大规模进入到人工智能产业中,产生实质性影响。

在2016年6月,TensorFlow发布了新版本的早期版本,版本号为 0.9,增加了对iOS的支持。随着谷歌增加了TensorFlow对iOS的支持,应用程序将能够在更聪明的功能集成到它们的应用程序,最终使它们更聪明和能干。

从 0.9 版本开始,TensorFlow 支持了多平台,并且进入高速发展时期,开始不断赶超并拉开与其他深度学习框架的距离。虽只是源起,却锋芒毕露,初现王霸之气。

2 中原逐鹿·盛极

时间到了,2017年1月初,谷歌公布了 TensorFlow 1.0.0-alpha ,即 TensorFlow 1.0 的第一个“草稿”版本。2017年2月,TensorFlow在发布了1.0.0版本,也标志着稳定版的诞生。

与已有版本相比,全新的 TensorFlow 1.0 主要有以下改进:

- 更快:TensorFlow 1.0超乎想象地快!TensorFlow 1.0 为未来更多的性能改进打下了基础,而tensorflow.org 现在可提供模型优化的提示和技巧,以达到最高速度。

- 更灵活:TensorFlow 1.0 为 TensorFlow 引进了带有 tf.layers,tf.metrics 和 tf.losses 模块的高级别应用程序界面。TensorFlow 团队引进能够与 Keras完全兼容的新 tf.keras 模块。

- 随时就绪:TensorFlow 1.0 可确保 Python 应用程序界面的稳定性Python能够在不打破现有代码的情况下,更容易地获取新功能。

1.0 版本不仅为 TensorFlow 机器学习函数库带来多重升级,而且为 Python 和 Java 用户使用TensorFlow 做开发降低了难度。另外,新版本的修补也得到了改善。更有意思的是,由于对TensorFlow 计算做优化的新编译器,在智能手机上运行基于 TensorFlow 的机器学习 APP 将成为可能。Tensorflow它已成为 GitHub 最受欢迎的开源项目。

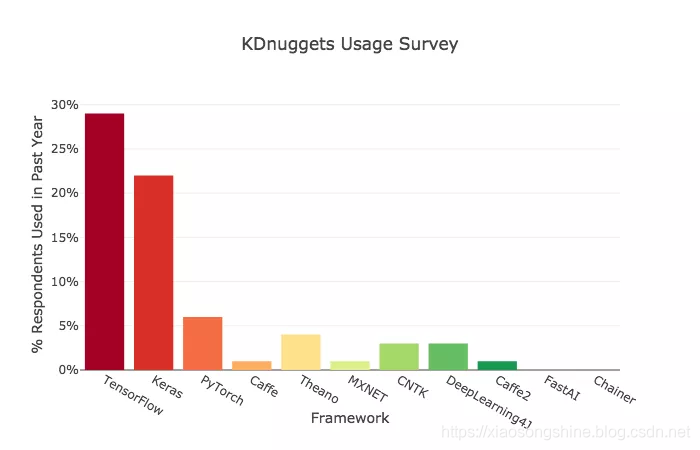

下图是KDnuggets网站对2018年的机器学习框架的使用做的一个调查统计,可以看出当时TensorFlow已经遥遥领先于其他竞争(Keras 是一个上层封装,底层调用的还是 TensorFlow),奠定了其深度学习霸主的地位。

中国有句古话:盛极必衰,否极泰来,这句话对于Google的 TensorFlow 也同样适用。1.x 版本在高速发展过程中,也为自己后来发展筑起一道山,TensorFlow也产生了很多被人诟病的地方,比如API的稳定性、效率和基于静态计算图的编程上的复杂性等。同时,坚持静态图模式也培养起来了足以撼动 TensorFlow 霸主地位的框架(上述图中默默无闻的第三名,后来强势崛起的PyTorch)。

1.x 版本后期,TensorFlow发展由于自身原因(1. 为自己后来发展筑起一道山 2.坚持静态图模式)遭遇到瓶颈。PyTorch以动态图开发模式,统一化的模块命名方式,更加人性化的编程的方式(Pythonic),强势出道。这些优势无一不击中 TensorFlow 的痛点,不断追赶、威胁TensorFlow霸主地位。

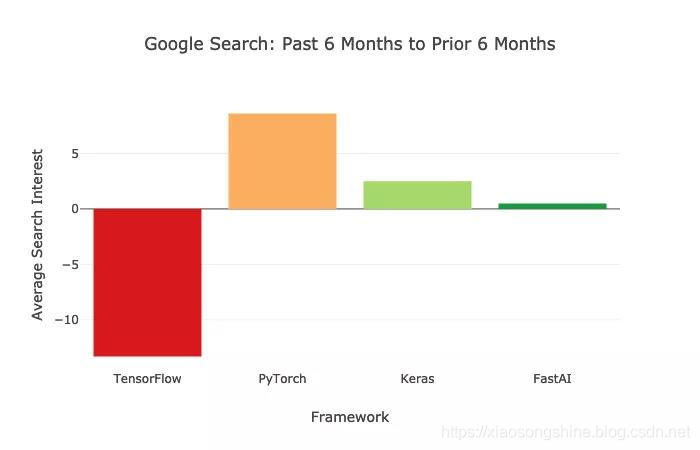

下图通过搜索全世界对机器学习和人工智能类别的兴趣(Google Interest),采用过去六个月的平均兴趣分数,并将其与前六个月的平均兴趣分数进行了比较。可以看出,TensorFlow 的平均兴趣分数处于下降状态,PyTorch却呈上升趋势。

下面谷歌的图表显示了过去一年的搜索兴趣。TensorFlow为蓝色,Keras为黄色,PyTorch为红色,fastai为绿色。可以看出TensorFlow总体呈现下降趋势,而PyTorch却呈现持续增长姿态,不断缩小与TensorFlow的距离。

按这样的趋势,PyTorch在用户搜索兴趣方面追赶上TensorFlow指日可待了,TensorFlow遭遇到出生以来最大的挑战(其实TensorFlow也就才三岁多)。TensorFlow会如何应对这个挑战呢?是按部就班,在1.x版本上进行小修小补,得过且过(这个词用得有些过了,之所以会用是刚好写到这里的时候听到这首歌,同时这个词语与表达笔者对上述方法的不苟同);还是推倒重来,重新设计新版TensorFlow,涅槃重生。这个选择会关乎到以后TensorFlow数年的发展和与PyTorch竞争的成败。笔者相信,Google 并不会做选择,小孩才会做选择,大人全都要。以谷歌的巨大体量,在内部执行两个方案,最后看市场反馈推出最合适的。Google是大公司,以稳为主的策略还是很容易让人理解的。

3 王者归来·槃涅

我们都知道Google推出了后者方案,选择涅槃重生,重塑自身。那么全新的TensorFlow 2.0 究竟新在哪里呢?TensorFlow官网给出了答复:

- Keras与TensorFlow紧密集成,默认eager execution,执行Pythonic函数。官方表示,对开发者来说,TensorFlow 2.0用起来跟Python差不多;对于研究者来说,新框架也在低级API方面进行了重点投入。

- 为了在各种平台上运行,SavedModel文件格式进行了标准化。

- 针对高性能训练场景,可以使用Distribution Strategy API进行分布训练,且只需进行少量代码修改就能获得出色的性能。支持Keras Model.fit、自定义训练循环、多GPU等等。

- TensorFlow 2.0提高了在GPU上的性能表现。以ResNet-50和BERT为例,只需要几行代码,混合精度使用Volta和Turing GPU,训练表现最高可以提升3倍。

- 新增TensorFlow Datasets,为包含大量数据类型的大型数据集提供了标准接口。

- 虽然保留了传统的基于Session的编程模型,但官方现在建议使用eager execution进行常规的Python开发。tf.function装饰器可以把代码转换成可以远程执行、序列化、性能优化的图。在Autograph的帮助下,能把常规的Python控制流直接转成TensorFlow控制流。

- 官方提供了TensorFlow 1.x升级2.0的迁移指南,TF2.0还有一个自动转换的脚本。

- TensorFlow 2.0提供了易用的API,能够灵活快速的实现新想法。模型的训练和serving也已经无缝集成在基础架构中。

- 更多关于TensorFlow 2.0的信息,可以访问官网:https://www.tensorflow.org/

几乎每一条都直击TensorFlow1.x用户的痛点,广大使用TensorFlow1.x转到PyTorch的用户表示TensorFlow 2.0 真香,纷纷倒戈。

Google深度学习科学家以及Keras的作者表示,TensorFlow 2.0 是一个新时代的机器学习平台,这将改变了一切。

深度学习研究和教育者、fast.ai创始人Jeremy Howard也称赞 2.0 版本的发布是”令人兴奋的一步,与TensorFlow一代相比是一个巨大的飞跃“。

目前GitHub上排名第一的NLP机器学习课程practicalAI的作者以及苹果公司AI研究员Goku Mohandas在推特上说,他们正在从PyTorch转向TensorFlow 2.0。

此后,PyTorch在与TensorFlow的争霸中将再难有胜算,TensorFlow 1.x 版本的失误给了PyTorch赶超的机会,PyTorch已尽力追赶了,但是还是没有实现赶超。Now,TensorFlow 2.0 已经补全缺点,同时具备比PyTorch更加完备的多平台支持、更成熟的部署方式与数量巨大的用户基数。如果PyTorch早出生一年,或者TensorFlow 2.0 晚发布一年,PyTorch还是有机会的,但是没有如果,Google依旧是最强大科技公司之一,很难反复给对手机会赶超。TensorFlow再次呈现对于其他框架压倒式优势,实现王者归来。

4 终章

TensorFlow从最开始 0.1 版本诞生时受到广泛关注,到 1.0 版本的全面爆发,再到今年 2.0 版本正式发布,它已趋于完美。TensorFlow的成长依托于Google的强大研发与号召力,但TensorFlow的成功更归功于设计的完备性、审时度势和适时革新。

经历四年时光,TensorFlow的发展与成功离不开先天的优秀天赋(Google Brain),更有赖于后天的努力拼搏(适时革新)。有天分又有努力,TensorFlow的成功理所应当。

附

想要体验正式版本TensorFlow 2.0 可以访问=>『TensorFlow2.0正式版教程』极简安装TF2.0正式版(CPU&GPU)教程:https://xiaosongshine.blog.csdn.net/article/details/101844926

喜欢我的文章欢迎访问

小宋是呢 CSDN=> https://xiaosongshine.blog.csdn.net/

小宋是呢 知乎=> https://www.zhihu.com/people/xiaosongshine/activities