Inter-sentence Relation Extraction with Document-level Graph Convolutional Neural Network 论文阅读 ACL

Background

论文动机

-

文档级的关系抽取涉及到多种信息 (non-local/local/syntactic/semantic dependencies), 现有的方法不能充分地利用(exploit)these dependencies.

-

Local dependency <=> within sentence 句内依赖

- Dependency parsing 依赖解析

- Adequate for intra-sentence relations

-

Non-Local dependencies<=>across sentences 句间依赖

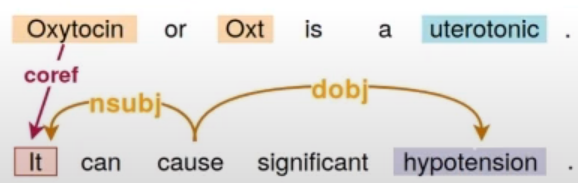

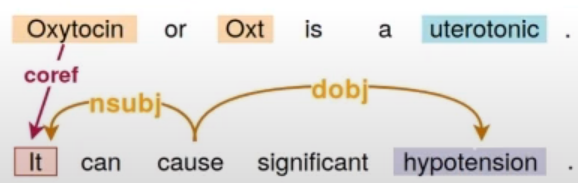

- Co-reference 共指

- Discourse dependencies

- Required for inter-sentence relations

-

-

不同的sentence有不同的 dependency tree.

论文贡献

- 构建==GCNN-based model 捕获 local 和 non-local dependencies。==

- GCNN : a labelled edge Graph CNN

- 贡献了一个新的数据集

- Effectiveness of local and non-local dependencies on inter-sentence pairs

Model

IDEA: Utilise local and non-local dependencies in combination.

-

Represent a textual snippet as a graph.

-

Words = nodes

Edges =local,non-local dependencies

-

Incorporate ==GCNN for graph encoding==

-

Multi-instance Learning for concept-level relation extraction.

引申一个重要的定义:==Entity mentions==: we name the multiple occurrences of these entities in the document

我们在文档 t 上应用多实例学习来combine 所有的mention-level pairs,之后预测最终的关系类别(concept-level relation extraction)。

Input layer

对于每一个word i , 我们合并the word and position representations(relative positions to the first and second target entities 相对于第一个和第二个目标实体的相对位置 ):

如果一个entity有多个mention的话,那么就选择与当前word最近的mention来计算相对位置。

Graph Construction

图的构建由五大类特征构成,所以构建的图一共有5种边。由于边的类型不同,所以==GCNN构建的图属于异质网络图 。==

local dependencies:

- Syntactic dependency edge: (clues for intra-sentence relations) 句子内的句法依赖边。使用句子内的依存语法树,每种依存关系作为一种类型的边;

- Adjacent word edge: 对于同一个sentence,为了保持句内单词间的序列信息,连接当前word相邻的单词;

combine the next word and the previous word to the current word in order to encode some kind of sequential information into the model.

- Self-node edge: 自节点边,为了学习到自身的信息。

在模型中包含有关单词的本身信息

non-local dependencies:

- Coreference edge:共指边,代表两个指称描述同一个实体

- Adjacent sentence edge:将相邻句子的依存语法树==根节点连接==构成一种类型的边(the root of sentence)

GCNN Layer

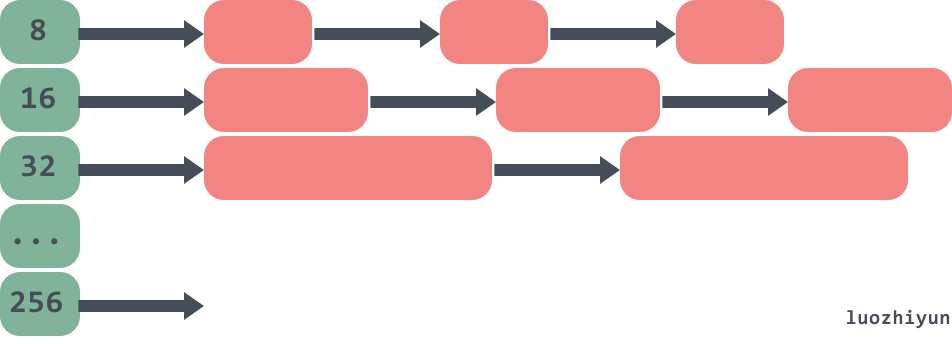

GCNN使用的GCN和普通的GCN有一些不同,它只交互一阶相邻节点的信息,并且有K个块,==每个块针对一种边进行卷积操作==,最后将各个块的结果累加。

GCNN的整个处理过程其实可以看作是基于==5种关联类型构建了5个图==,分别进行图卷积操作,然后将5个图的结果累加。**(怎么叠加呢)**这样做的原因是不同的关联类型代表的含义是不同的,必须加以区分。(异质图?)GCNN最大的亮点就在这里,==通过分层巧妙的使用了多种关联关系。==

这里使用的GCNN与普通的GCN不同,这里在aggregate node representation的时候,只使用了其邻域的信息,并且对于不同类型的edge,分别使用GCN(毕竟GCN只能用于同质图),最终的结果是所有类型的graph的结果的加和。

A labelled edge GCNN,keeping ==separate parameters for each edge type.==

\mathbf{W}_{l(i, u)}^{k}和\mathbf{b}_{l(i, u)}^{k},其中k表示k-th block for ==edge type l,== between nodes i and u .

Stack K GCNN blocks 目的:汇聚来自 distant neighbouring nodes的 information

In order to ==avoid over parameterization,==we tune the number of parameters and keep the top and keep most frequent edge types while merging all the remaining types as a single rare edge type.(有问题??作者的意思就是五个不同的W吗?那最后x的信息怎么汇聚呢?五个不同的x呢呀)

A:应该是直接叠加

Tune number of parameters keeping top-N most frequent type & merging rare

MIL-based Relation Classification

前提概要:Each target entity can have multiple mentions in a document,we employ a multi-instance learning (MIL)-based classification scheme to ==aggregate the predictions of all target mention pairs== using bi-affine pairwise scoring(为在一篇document中,每一个entity会有多个mention,我们希望能够去聚合target entity所有的mention,并通过bi-affine pairwise scoring对文章中出现的所以单词对进行打分,从而预测关系类别。bi-affine是一种self-attention编码器,可以一次计算出文档中所有mention之间的关系。。)

首先,==每个word都分别映射到两个独立的 latent 空间。==

\mathbf{W}^{(1)}和\mathbf{W}^{(0)}是分别是2-layer FFNNs的参数。\mathrm{x}_{i}^{\text {head}}, \mathrm{x}_{i}^{\text {tail}} \in \mathbb{R}^{d}

得到节点的表示后使用多示例学习,将上一步得到的结果映射为两个值,这一步的操作和下一步紧密相关,两个值分别用于计算节点是头实体和尾实体时节点间的关系概率。这里多示例学习的原理类似Transformer中的多头注意力,为了捕捉更多样的特征。以关系分类的角度这样做也很合理,==因为关系三元组是有向的,节点作为主体和客体时使用的特征也应该不同。==

Aggregate mention pairs (x) —>>>>concept pair (e),combine information form multiple mention level pairs into a single concept level pair

\mathbf{R} \in \mathbb{R}^{d \times r \times d} is a learned bi-affine tensor with r (r is the number of relation categories)

Experiment

数据集:CDR、CHR (这种两个biochemistry领域的document-level 关系抽取数据集)

CDR&CHR

Statistics of the CDR and CHR datasets.

Performance on the CDR and CHR test sets in comparison

What is the optimal number of edge types ?

思考:

GCNN 中规中矩,没有特别出色的地方:

确确实实构建了异质图,但是却没有考虑到不同类型edge的作用;

logical reasoning几乎没有单独拿来讨论处理,纯靠GCNN(邻域聚合能推理个毛线?);

所有类型edge在构建的时候需要其他工具,错误肯定存在的;

对于word representation的表示没考虑到上下文,表示不够;