Double Graph Based Reasoning for Document-level Relation Extraction 论文阅读 EMNLP 2020

Background

代码链接 //github.com/DreamInvoker/GAIN,其性能相较 ACL 2020中的文档级关系抽取模型LSR有一定的提升,其能够有提升的主要原因在于两点:

- 双图

- mention-level Graph: model complex interaction among mentions across sentences with heterogeneous mention-level graph (hMG) 异构图相较之前一些构建同质图做特征传播的模型,使用异质图可以融合更复杂的特征;

- Entity-level Graph: merge mentions that infer to the same entity;

- A novel path reasoning among entities.新颖的路径推理机制

Model

- Encoding Module

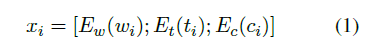

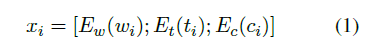

以句子为单位,使用LSTM/BERT对文本进行编码,以LSTM为例,将每个单词的词向量、实体类型编码(如果单词不属于实体提及就设为None)、共指编码拼接作为输入:

-

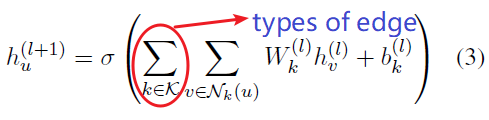

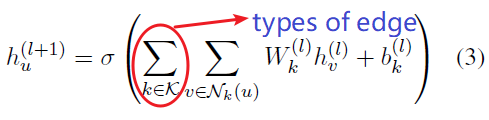

Mention-level graph 异构图-提及图特征聚合

两种节点:提及节点、文档节点

三种类型边:- Intra-Entity Edge: 连接同一实体提及;

- Inter-Entity Edge:同一句话下的不同实体提及;

- Document Edge:所有的提及都连接到文档节点(话说可以解决长距离的依赖问题?因为所有的提及节点都可以通过文档节点和其余的提及节点相连接。以文档节点为轴心,两个提及节点之间的距离最长为2)可以算做是小技巧/小创新?

Aggregate the features from neighbors:

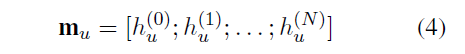

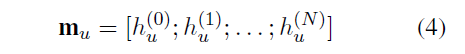

Concatenate hidden states of each layer:(可借鉴,加个注意力??)

-

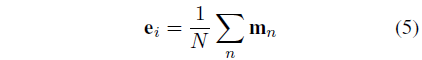

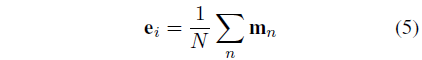

Entity-level graph 实体图关系推理

在Entity-level graph(EG)中忽略掉了hMG中的文档节点,同一实体的不同提及被归为实体节点:

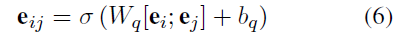

将有关系的两个实体相连(若两个实体的提及之间有关系<即有相连边>则这两个实体就有关系),从而得到EG中的边。

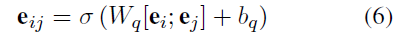

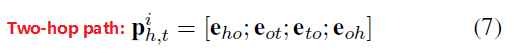

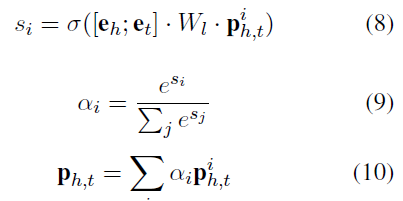

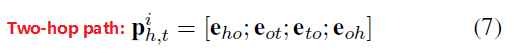

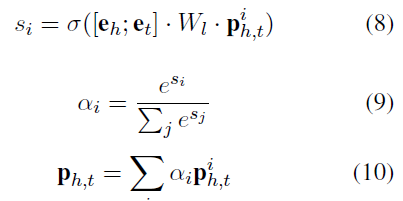

基于上述边的表示,以实体作为中介节点,从头实体到尾实体之间的第条路径表示为:

由于两个实体间的路径可能有多条,所以需要有对多条路径的融合机制,GAIN采用注意机制,利用作为query,融合和之间不同路径的信息。

在实体图关系推理模块中,一个实体通过融合其提及的信息来表示,这些提及信息通常在多个句子中,因此这种提及向量的融合方式实现了一定程度上的跨句信息传播。

此外,潜在的推理逻辑由实体间的不同路径来建模。然后将它们与注意机制相结合,这样就可以根据潜在的逻辑推理链来预测关系。(远距离建模实体关系,唉,应该是借鉴了2018的walk-based model) -

Classification Module

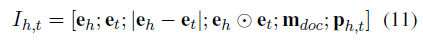

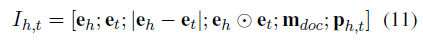

对于每个实体对,连接三种表示作为关系向量的表示:- 实体图中导出的头尾实体表示和,使用比较运算(comparing operation)增强特征,即两个实体表示之间差的绝对值。

- MG中的文档节点表示,有助于聚合跨句信息,提供文档感知表示;

- 在实体图(EG)中得到的综合推理路径向量

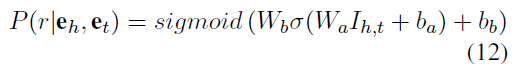

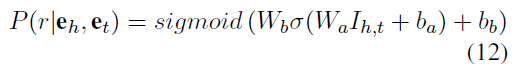

我们定义这个任务为一个多标签分类任务:

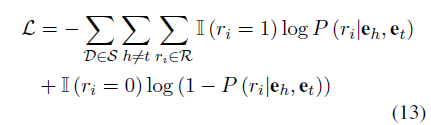

Classification loss:

Experiment

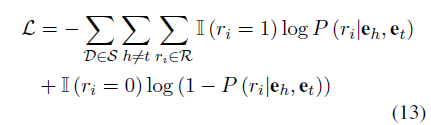

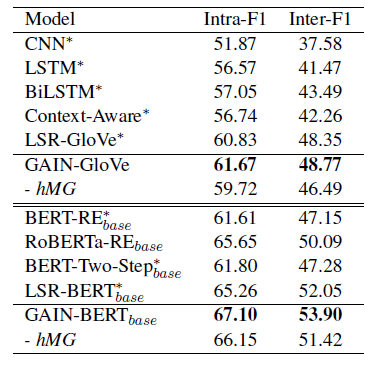

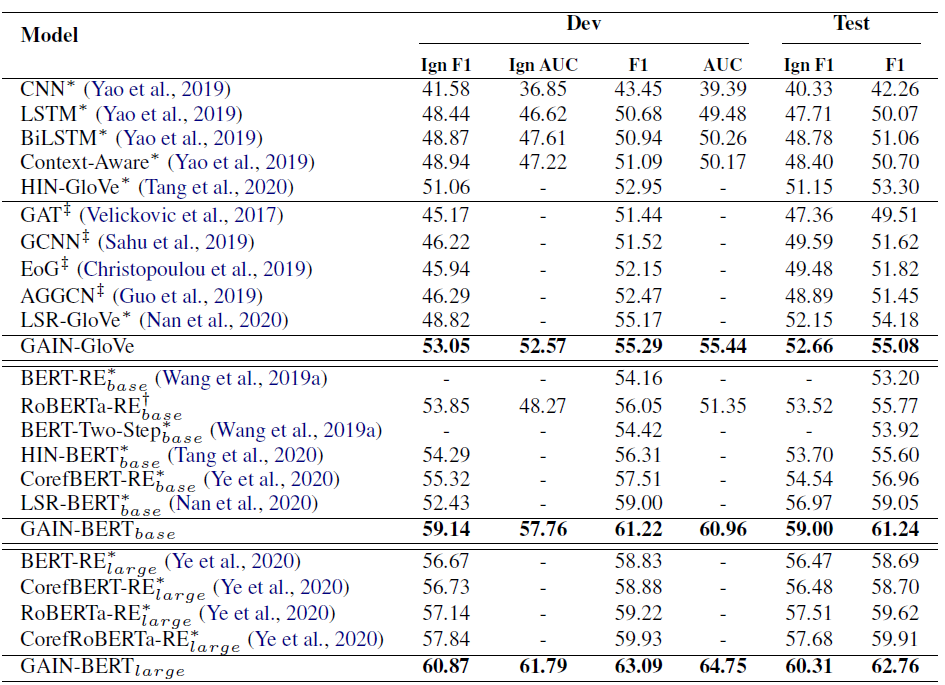

- 实验结果

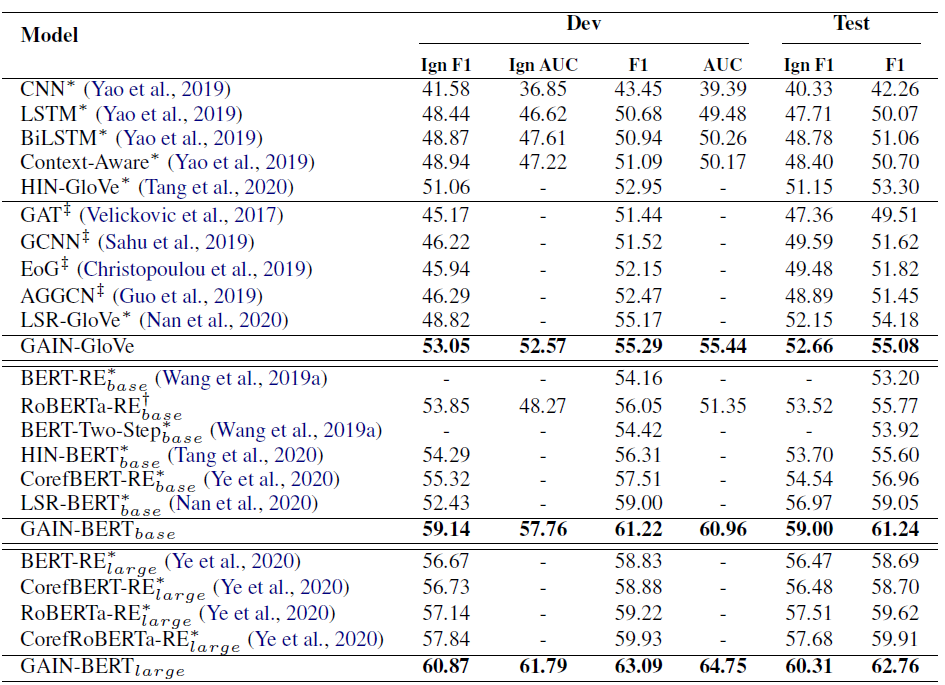

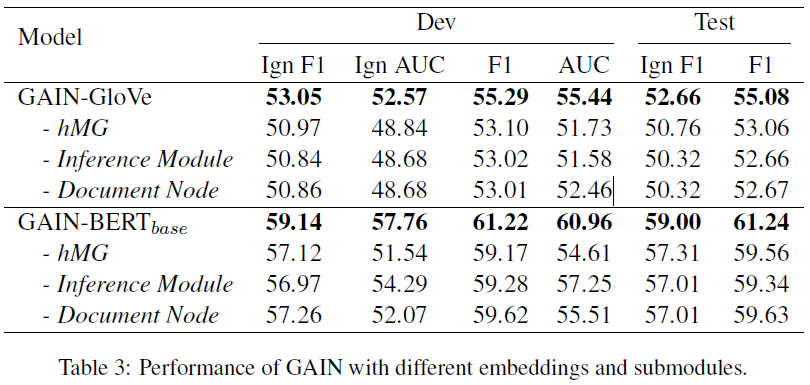

- 消融实验

也就是三个创新点:

1.异质图 2.路径推理机制 3. document node - 分析和讨论

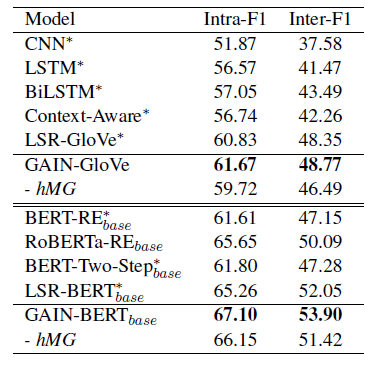

- 跨句关系性能表现

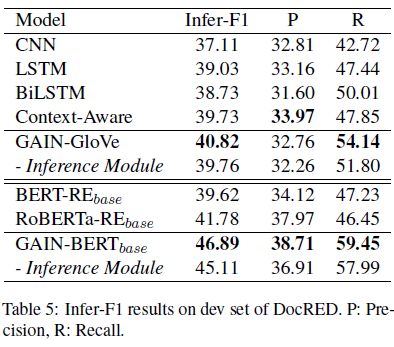

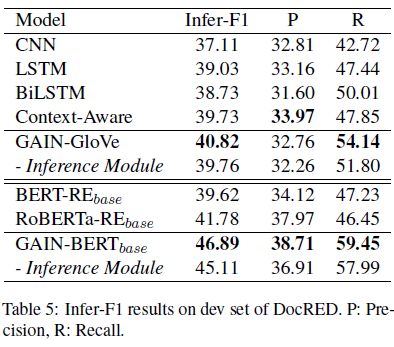

hMG对于跨句间的关系事实有重要作用。 - Infer-F1,which only consider relations that engaged in the relational reasoning process.

推理机制对于捕获潜在的推理链上实体关系事实有着重要作用。

- 跨句关系性能表现